前言

AnimateDiff 是一个实用框架,可以对文本生成图像模型进行动画处理,无需进行特定模型调整,即可为大多数现有的个性化文本转图像模型提供动画化能力。而Animatediff 已更新至 2.0 版本和3.0两个版本,相较于 1.0 版本,2.0和3.0版本主要新增了三个插件功能:Lora、ControlNet 和 Prompt travel。Lora,官方新增了 8 个运动模型,使我们能够自由控制动画画面的走向。Prompt travel,可以在提示词中指定第几帧以及指定何种动作或画面,可以通过提示词实现动态控制动画。

感兴趣可加入:566929147 企鹅群一起学习讨论

算法简介

AnimateDiff 提出了一种创新的方法来解决个性化 Text to Video 的挑战。其核心原理是将一个新初始化的运动建模模块附加到冻结的基于文本到图像的模型上,并在接下来的视频剪辑中对其进行训练,以提炼出合理的运动先验知识。一旦训练完成,通过简单地注入这个运动建模模块,所有从相同基础模型派生的个性化版本都可以立即成为以文本驱动的模型,从而能够生成多样化和个性化的动画图像。

这一方法的创新之处在于它摆脱了传统方法中对于敏感超参数调整、大量个性化视频数据集收集以及密集的计算资源的依赖,使得普通用户也能够参与到个性化 Text to Video 的工作中。通过将运动建模模块与基础模型结合,AnimateDiff 实现了一种更加简洁高效的个性化动画生成方式,为用户提供了更多选择和可能性。

通过实验证明,运动先验可以推广到 3D 动画片和 2D 动漫等领域,这意味着 AnimateDiff 能够为个性化动画提供一个简单而有效的基线。用户只需承担个性化图像模型的成本,就能够快速获得自然的个性化动画。以下是官方提供的一些优秀作品效果:

这些作品展示了 AnimateDiff 的强大功能和广泛适用性,为用户提供了一个简便而有效的个性化动画生成方案。

Stable Diffusion Webui安装

插件从网址安装:https://github.com/continue-revolution/sd-webui-animatediff ,击安装即可,等待安装完毕,重启一下SD UI界面。

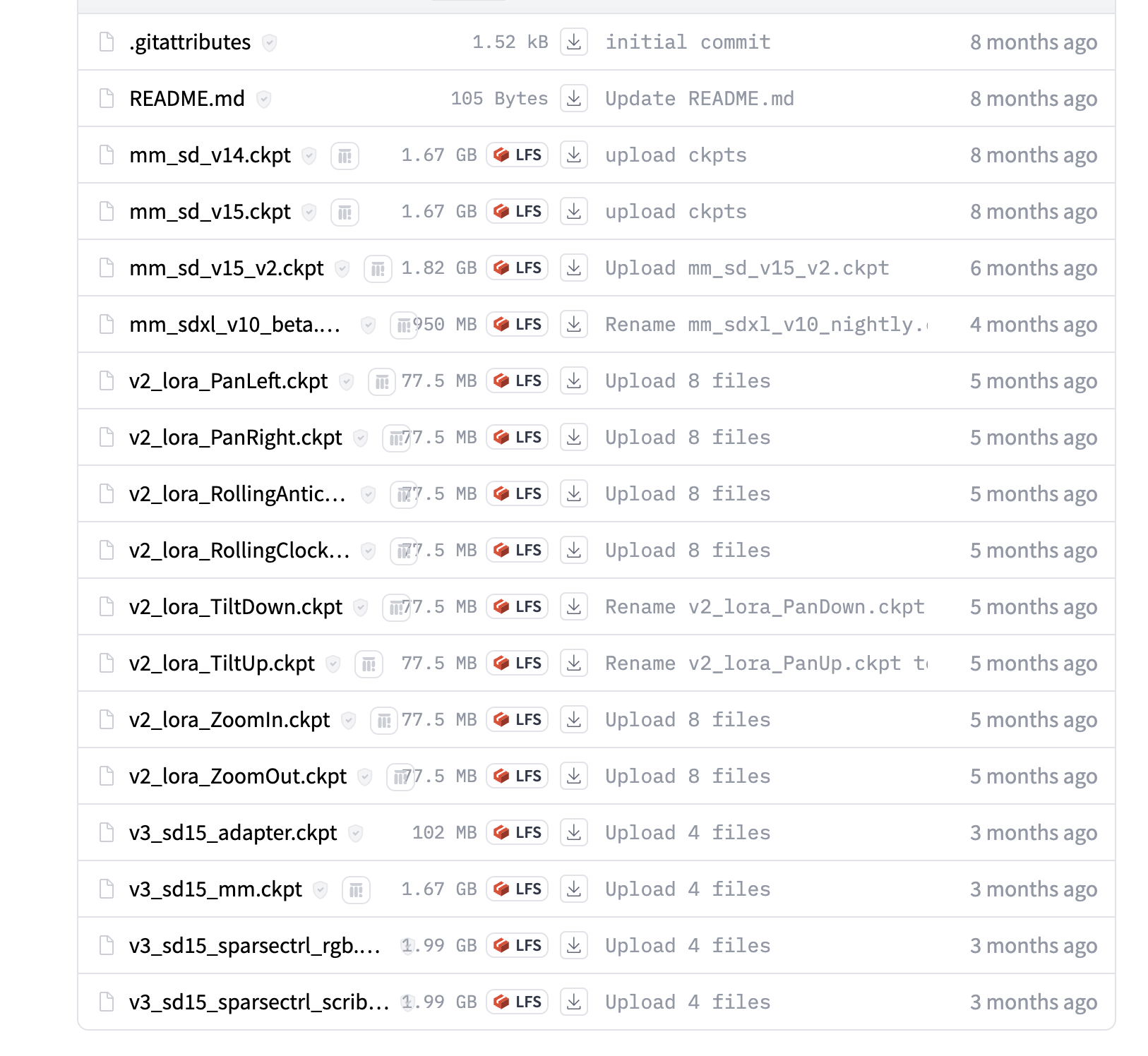

然后从:https://huggingface.co/guoyww/animatediff/tree/main 里下载专用的运动模型和Lora模型。下载之后需要放置在对应的位置。

运动模型放在stable-diffusion-webui\extensions\sd-webui-animatediff\model里面,运动lora放在stable-diffusion-webui\models\Lora里面。

根据 Lora 的命名可以大概看出它们的功能:

- 向上运动(Up)

- 向下运动(Down)

- 向左运动(Left)

- 向右运动(Right)

- 拉远运动(Zoom Out)

- 拉近运动(Zoom In)

- 顺时针旋转(Clockwise)

- 逆时针旋转(Counter Clockwise)

这些 Lora 可以通过添加对应的 Lora 来控制生成的动画在空间中的运动方向和旋转方向。

在 animatediff 插件页面的配置参数中:

- 动画模型:选择最新的 V2 版本。

- 总帧数:指定动画总共包含的画面数量。

- 帧率:指定每秒的帧数。例如,如果总帧数设置为 16,帧率设置为 8,则单个动画的播放时长为 2 秒。

- 显示循环数量:指定动画循环播放的次数,0 代表一直重复播放。

- 闭环:勾选此选项,使得动画的第一帧和最后一帧形成循环。

- 上下文单批数:与总帧数保持一致即可。

- 保存:选择输出动画的格式,可以多选。

插件使用

实现一个最基础的动画

1girl,night city,rain,coat,hands in pockets,best quality,masterpiece,HDR,UHD,8K,Highly detailed,simple background,

Negative prompt: (worst quality:1.6),(low quality:1.6),EasyNegative,

Steps: 20, Sampler: DPM++ 2M Karras, CFG scale: 7, Seed: 601405023, Size: 512x512, Model hash: 876b4c7ba5, Model: cetusMix_Whalefall2, VAE hash: 63aeecb90f, VAE: vae-ft-mse-840000-ema-pruned.safetensors, Clip skip: 2, Version: v1.6.0

使用Lora

对于添加一个镜头往左移动的 Lora “lora:v2_lora_PanLeft:0.8”,它的使用方式与普通的 Lora 是一样的。可以看到画面往左移动的幅度相当大。通过调整 Lora 的权重,可以实现不同幅度的移动。权重越高,移动的幅度越大。

在这个例子中,权重为 0.8,表示移动的幅度较大。如果希望移动的幅度更小,可以降低权重;如果希望移动的幅度更大,可以增加权重。这样就可以根据具体需求调整镜头移动的幅度。

1girl,night city,rain,coat,hands in pockets,best quality,masterpiece,HDR,UHD,8K,Highly detailed,simple background,lora:v2_lora_PanLeft:0.8,

Negative prompt: (worst quality:1.6),(low quality:1.6),EasyNegative,

Steps: 20, Sampler: DPM++ 2M Karras, CFG scale: 7, Seed: 601405027, Size: 512x512, Model hash: 876b4c7ba5, Model: cetusMix_Whalefall2, VAE hash: 63aeecb90f, VAE: vae-ft-mse-840000-ema-pruned.safetensors, Clip skip: 2, Lora hashes: “v2_lora_PanLeft: ed79025f8bea”, TI hashes: “EasyNegative: c74b4e810b03”, Version: v1.6.0

Prompt travel

“Prompt travel” 是一个需要安装 ControlNet 的功能。它允许用户在描述人物或场景的提示词中指定不同帧数对应的动作或画面。举例来说,如果总帧数只有 8 帧,那么在提示词中最大只能写到 7,因为索引从 0 开始,0 对应第一帧,7 对应第八帧,依此类推。如果不遵循这个规则,可能会导致错误。

提示词的格式应该为:在指定帧数后面加上冒号和空格,然后描述对应的动作或画面。例如:“0: 人物行走”,表示在第一帧人物行走。

如果发现功能没有生效,可能是由于插件之间发生了冲突。可以尝试禁用除 animatediff 和 ControlNet 之外的其他插件,然后逐个重新启用,查看是否恢复了功能。

1girl,best quality,masterpiece,realistic,close-up,simple background,

0: smile

2: open eyes

3: (closed eyes:1.2)

5: open eyes

版权归原作者 知来者逆 所有, 如有侵权,请联系我们删除。