xAI 发布 Grok-1 — 最大的开源LLM

图片由 Jim Clyde Monge 提供

埃隆·马斯克(Elon Musk)的人工智能公司xAI在Apache 2.0许可下发布了其3140亿参数的专家混合模型Grok-1的权重和架构。

在此之前,马斯克上周一承诺向公众免费提供格罗克。作为一个一直密切关注人工智能领域发展的人,我不得不说,这是在开放性和可访问性方面向前迈出的一大步。

什么是格罗克?

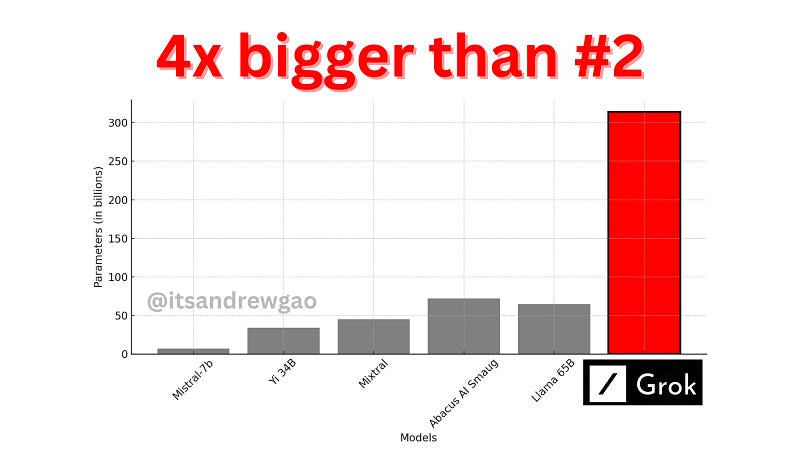

Grok 是一个拥有 3140 亿个参数的庞大语言模型,是目前最大的开源模型。就上下文而言,这是 OpenAI 的 GPT-3 的两倍多,后者在 2020 年发布时被认为是一项突破。

在 X 用户 Andrew Kean Gao 分享的图表中,您可以看到 Grok 的规模与其竞争对手相比有多大。

图片由 Andrew Gao 提供

但 Grok 不仅更大,它还利用了专家混合 (MoE) 架构,使其能够战略性地激活不同任务的参数子集。从理论上讲,与传统的密集模型相比,这使其更加高效和适应性更强。

以下是 Grok-1 版本的摘要

- 314B 参数 Mixture-of-Experts 模型,其中 25% 的权重在给定令牌上处于活动状态

- 基础模型是在大量文本数据上训练的,没有针对任何特定任务进行微调。

- 8 位专家(2 位在职)

- 860 亿个参数

- Apache 2.0 许可证

- 纸张:https://x.ai/blog/grok-os

- 产品代码: https://github.com/xai-org/grok-1

如何安装 Grok

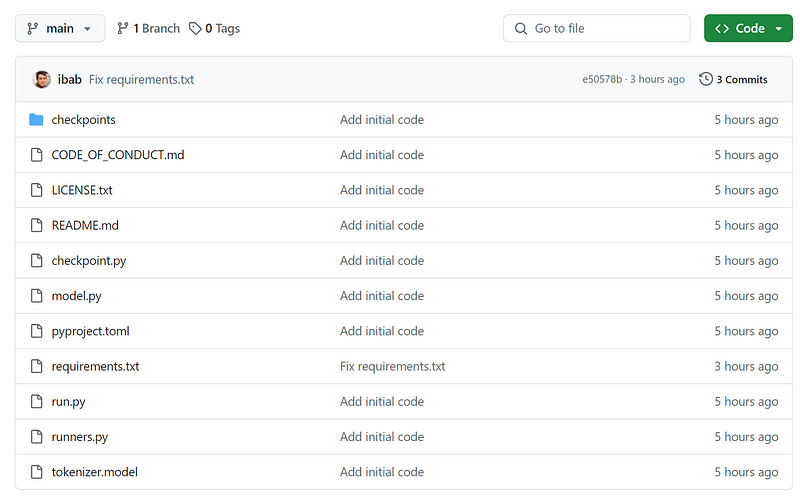

有关加载和运行 Grok-1 的说明,请参阅此 GitHub 存储库。将存储库克隆到本地。

图片由 Jim Clyde Monge 提供

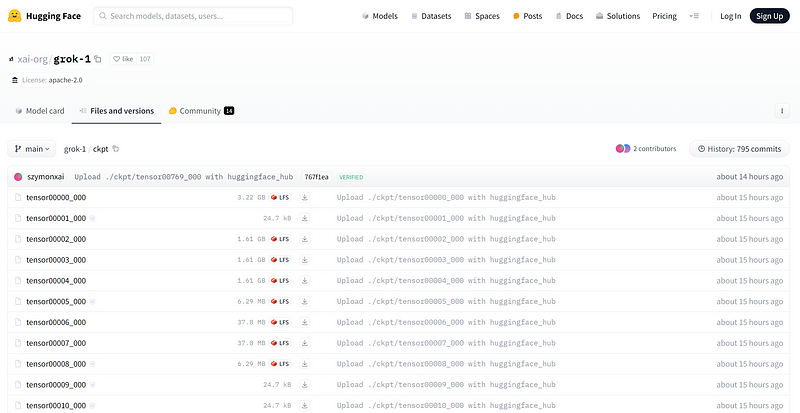

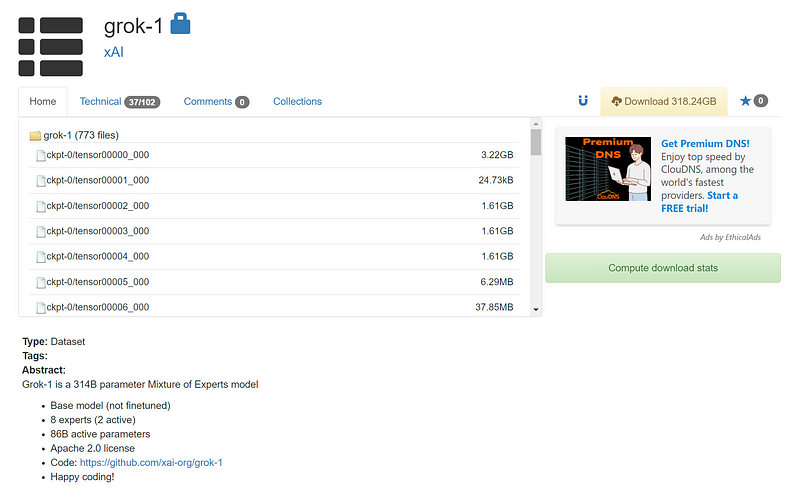

从 HuggingFace 或 Academic Torrents 下载权重并将它们放在“checkpoints”目录中。

图片由 Jim Clyde Monge 提供

顺便说一句,有些人质疑为什么通过 Bittorrent 磁力链接发布权重。随着模型变得越来越大,它可能会成为未来的常态。此外,通过 torrent 分发 300 GB 数据比直接分发便宜。

打开 CLI 并运行以下命令以测试代码:

pip install -r requirements.txt

python run.py

该脚本在测试输入上加载检查点和模型中的样本。

需要注意的是,由于 Grok-1 模型的庞大尺寸(包含 3140 亿个参数),因此需要具有足够 GPU 内存的机器才能使用提供的示例代码测试模型。

不幸的是,我目前无法访问能够在本地运行 Grok 的硬件,因此我无法提供该模型的第一手示例。

xAI 存储库中专家混合 (MoE) 层的当前实现未针对效率进行优化。特意选择此实现是为了优先考虑模型正确性验证,并避免开发自定义内核的需要。

如何尝试Grok

如果您只是对 Grok 的功能感到好奇,它目前可在 X 上使用,但仅供 Premium+ 用户访问,价格为每月 16 美元。

图片由 Jim Clyde Monge 提供

Grok-1 许可

此版本中的代码和关联的 Grok-1 权重在 Apache 2.0 许可证下获得许可。

Apache 2.0 许可证是一个宽松的自由软件许可证。该许可证允许将软件用于任何目的,用户可以分发、修改和分发软件的修改版本。

该许可证仅适用于此存储库中的源文件和 Grok-1 的模型权重。

最后的思考

Grok-1 的发布正值关于意识形态在人工智能开发中的作用的激烈辩论之际。埃隆·马斯克(Elon Musk)一直直言不讳地表达了他对“觉醒人工智能”的担忧,他引用了谷歌的双子座(Gemini)作为人工智能系统的一个例子,该系统将多样性计划置于潜在危险的程度。

版权归原作者 liferecords 所有, 如有侵权,请联系我们删除。