作者 | 王轶群

责编 | 唐小引

出品丨AI 科技大本营(ID:rgznai100)

昨夜凌晨,在告别OpenAI 首席科学家一个月后,Ilya Sutskever 在 X 账号官宣了自己的新动向——创办一家名为“安全超级智能”的公司(Safe SuperIntelligence,SSI)。

和很多离开 OpenAI 的员工一样,Ilya Sutskever 选择了创业,这没什么稀奇。

炸裂的是,这一次 Ilya Sutskever 脱离了 OpenAI 的管理束缚,开始甩开膀子干活了,并且直击安全的AGI。

以下是安全超级智能公司(SSI)公告全文:

超级智能已经触手可及。

构建安全的超级智能是我们这个时代最重要的技术问题。

我们已经启动了世界上第一个直击 SSI 实验室,其目标只有一个,产品只有一个:安全的超级智能。

它的名字是 Safe Superintelligence Inc.

SSI 是我们的使命、我们的名字和我们的整个产品路线图,因为这是我们唯一的重点。我们的团队、投资者和商业模式都致力于实现安全的超级智能。

我们将安全性和性能并重,将其视为需要通过革命性的工程和科学突破来解决的技术问题。我们计划尽快提高性能,同时确保我们的安全性始终处于领先地位。

这样,我们就可以安心地扩大规模。

我们的专注意味着我们不会受到管理费用或产品周期的干扰,而我们的商业模式意味着安全、保障和进步都不会受到短期商业压力的影响。

我们是一家美国公司,在帕洛阿尔托( Palo Alto)和特拉维夫(Tel Aviv)设有办事处,我们在那里拥有深厚的根基和招募顶尖技术人才的能力。

我们正在组建一支精干的团队,由世界上最优秀的工程师和研究人员组成,他们专注于 SSI,不关心其他任何事情。

如果您愿意,我们将为您提供一个机会,让您毕生致力于此,帮助解决我们这个时代最重要的技术挑战。

现在是时候了。加入我们。

伊利亚·苏茨克韦尔(Ilya Sutskever)、丹尼尔·格罗斯(Daniel Gross)、丹尼尔·利维(Daniel Levy)

2024 年 6 月 19 日

他在一个月前官宣从 OpenAI 离职时写道:“我对接下来要做的事情感到兴奋,这是一个对我个人非常有意义的项目,我会在适当的时候分享细节。”

如今,时机到了,SSI 正是那个“非常有意义的项目”。

目标只有一个:构建安全的超级智能

Ilya 在构建安全的 AGI,上具有从一而终的韧性。这是他加入 OpenAI 的理由,也是他离开 OpenAI 的理由,更是他创办新公司的唯一目标。

换句话说,他正试图继续他的工作,并摆脱了其他束缚,不会像 OpenAI、谷歌和Anthropic等 AI 公司那样受到太多其他因素的干扰。

“这家公司的特殊之处在于,它的第一款产品将是安全超级智能,在此之前它不会做任何其他事情,”Ilya 在一次采访中说。“它将完全免受外部压力,不必处理庞大而复杂的产品,也不必陷入激烈的竞争中。”

在彭博社的专访中,Ilya 透露了 SSI 的更多细节。

- 新公司将通过在AI系统中融入工程突破来实现安全,而不是依赖临时的保护措施。

- 两位联合创始人中,一个是投资者Daniel Gross,也是曾经的苹果 AI 负责人;另一位是 Ilya 在 OpenAI 一起合作训练模型的前同事 Daniel Levy。

- Ilya 表示自己已经花了多年时间思考安全问题,并且已经有了一些方法。可能很快会有一些成果出来。

- 目前新公司的目标可以比喻为一个能够自主开发技术的巨大数据中心,这个系统将比 LLM 更通用、扩展性更强。

- Ilya 拒绝透财务支持者的名字,也拒绝透露筹集了多少资金。

此前,OpenAI 就因为成本支出问题选择与微软合作,并把最初承诺的给超级对齐团队的算力和资源多次让位给明星产品的研发。只做安全的公司,是否会面临同样的资金问题?

这一点,作为投资者之一的 Gross 已经保证:“在我们面临的所有问题中,资金绝不是问题。”

呼声强烈的安全问题,以及 Ilya 的主动出击,让 SSI 大受欢迎,网友甚至愿意自掏腰包提供资金支持,直接表示“收下我的钱”。SSI 实在不济,还可以众筹。

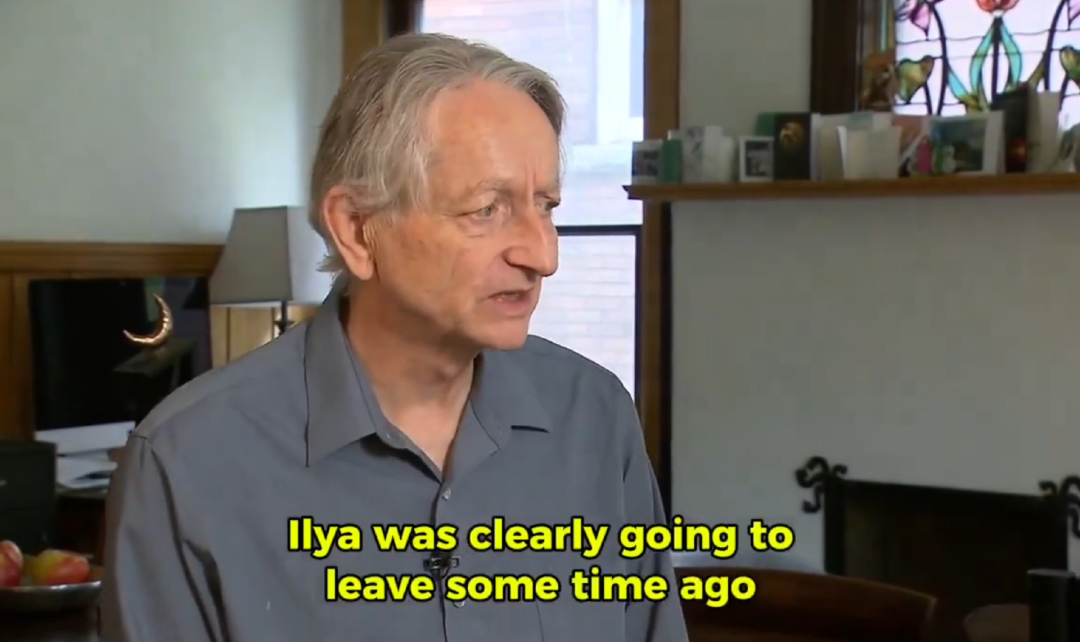

“AI 教父”Geoffrey Hinton 在最近接受媒体采访中,也透露了一些有关 OpenAI 与爱徒 Ilya 的细节。

他表示,Ilya很早以前就计划离开 OpenAI,Jan Leakey最近也离开了,因为他们没有投入足够的资源来保障安全。“我想他们只是想要投入10%,但Sam Altman并不愿意。

Hinton 认为一个 AI 公司对安全的投入不应该和开发投入一样多,但应该是一个相当大的比例,比如其资源的20%或30%需用在保障安全上。

而 Ilya 的 SSI,这个数值是 100%。

“我认为现在是开展这样一个项目的好时机,”SSI 联创之一 Levy 说。“我的愿景与 Ilya 的愿景完全相同:一个精干的小团队,每个人都专注于安全超级智能这一单一目标。”

不是消极哀怨,而是主动出击

“人们已经在自然语言处理上努力了50年,这会是一项巨大的进步。我们现在就在这里。在未来的10年里,我们可能会看到类似的进步,这就会带来超级智能。我猜测,有50%的可能,我们将在未来20年内实现这一目标。我认识的几乎所有优秀的研究人员都相信,从长期看,这些AI会变得比我们更聪明。它们的智能不会止步于我们的水平。”Hinton 在采访中表示。

对于“是否对我们能找到一条对人类有益的前进道路持乐观态度”的回答上,Hinton 持保留态度。

他表示:“我有朋友认为,我们有很大的可能性会找到一条前进的道路,因为人类非常有创造力。但是,超级智能也非常有创造力。因此,有人认为前进的可能性是五五开可能过于乐观,我认为可能性可能小于五五开。我认为,我们能够生存下来的可能性大于五五开,但这并不意味着被超级智能所控制的可能性只有1%,实际的危险可能性要大得多。”

剑指安全超级智能的后浪,正是师从 Hinton 的 Ilya。

不同于 Hinton 的是,Ilya 意识到了其中的危险,并未表现出太多的悲观,而是积极地投入实践,主动出击构建安全的 AGI。

他在离开 OpenAI 时写在 X 动态里的“这家公司的发展轨迹堪称奇迹,在Sam Altman、Greg Brockman、Mira Murati 现在再加上 Jakub Pachocki 的卓越研究领导下,OpenAI将打造出既安全又有益的AGI”,如今看来,或许有一些反讽意味。

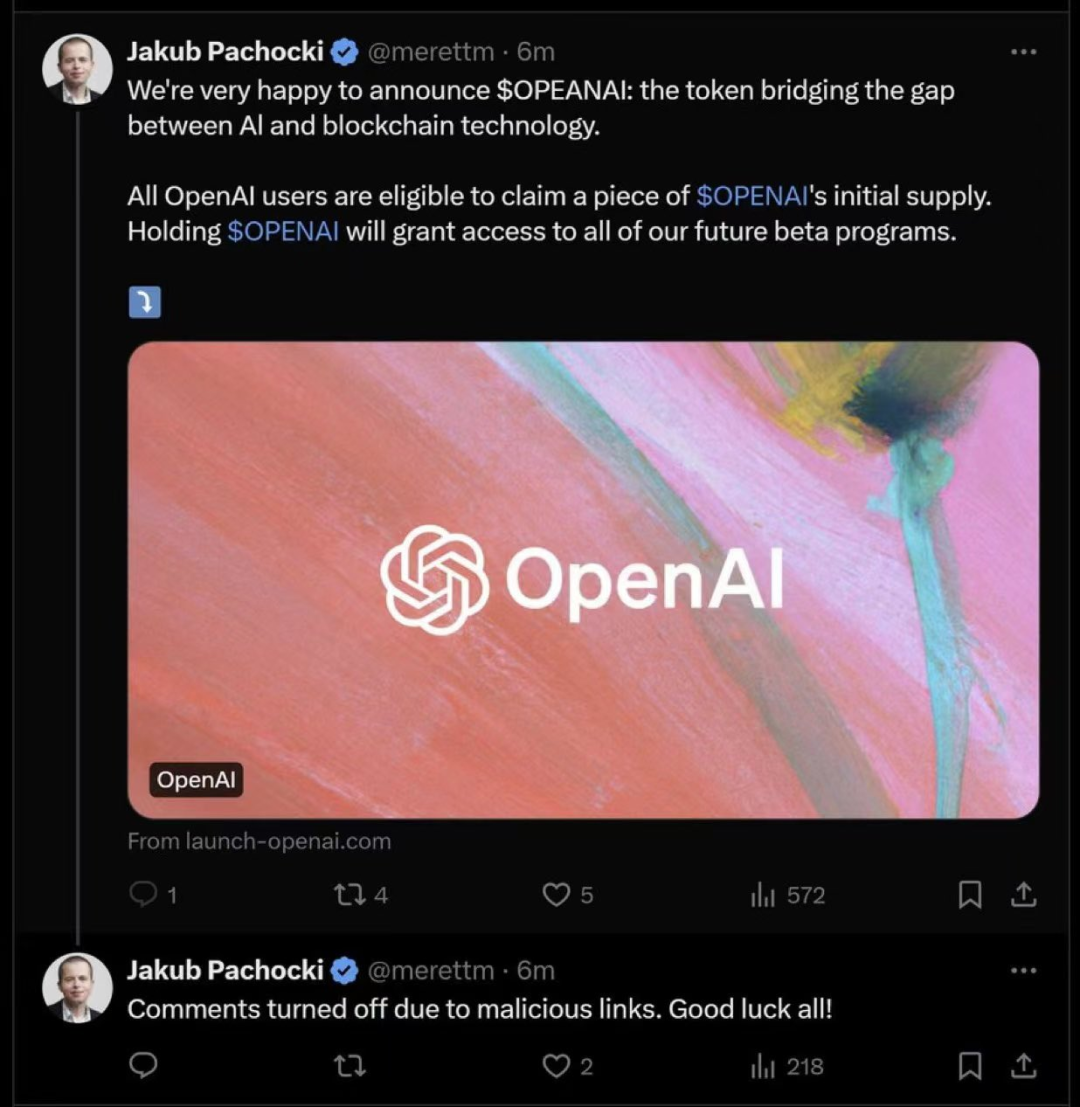

更具讽刺意味的是,在 Ilya 宣布成立新公司的当天,他在 OpenAI 的继任者 Jakub Pachocki 的 X 账号被盗了,发布了一些干扰视听的伪造的 OpenAI 官方发布的内容。去年,OpenAI 的 CTO Mira Murati 的账号也被盗过,手法如出一辙。

让人感叹 X 安全措施不到位的同时,又再一次加强了公众对安全的重视。

而这位后浪勇士,在 OpenAI 的超级对齐项目重重受阻后,并未放弃,而是自己组建团队、聚拢资源,开启了属于自己的专心做安全超级智能的公司。

为此,Ilya 他花了数年时间思考安全问题,而且已经想到了一些方法:

“在最基本的层面上,安全的超级智能应该具有不会大规模伤害人类的特性。在此之后,我们可以说我们希望它成为一股向善的力量。我们希望在一些关键价值观的基础上开展运营。我们正在思考的一些价值观,可能是过去几百年来支撑自由民主的成功价值观,比如自由、民主。”

与大众不同的是,AI 顶尖人才眼中的评判维度更高。

Ilya Sutskever透露,真正让OpenAI出圈的ChatGPT发布时,公司内部对此的期望值很低:“你问它一个事实性的问题时,它会给你一个错误的答案。我以为它会很平淡无奇,人们会说:你为什么要做这个?这太无聊了!”

同样,在构建安全的超级智能上,他想要的是通过在AI系统中融入工程突破来实现安全,而不是依赖临时的保护措施。他的目标是更大的东西,比起聊天机器人等日常工具,他想要的系统更加通用、功能更广泛。

目前, Ilya Sutskever 的 X 简介仅仅写了“SSI”,OpenAI 有关的头衔一概清空。删除过往羁绊的 Illya,虽然还深耕在安全工作,但无疑已开启了崭新的篇章。

参考链接:

由 CSDN 和 Boolan 联合主办的「2024 全球软件研发技术大会(SDCon)」将于 7 月 4 - 5 日在北京威斯汀酒店举行。

由世界著名软件架构大师、云原生和微服务领域技术先驱 Chris Richardson 和 MIT 计算机与 AI 实验室(CSAIL)副主任,ACM Fellow Daniel Jackson 领衔,BAT、微软、字节跳动、小米等技术专家将齐聚一堂,共同探讨软件开发的最前沿趋势与技术实践。

大会官网:http://sdcon.com.cn/(可点击**阅读原文**直达)

版权归原作者 AI科技大本营 所有, 如有侵权,请联系我们删除。