知识储备

- 确定时间分隔、开始时间、结束时间

- 在hive中创建该表

- 计算每段时间内申购和赎回的量

- 查询每段时间开始和结束时的万份收益,计算净收益率

时间序列平稳性检验

在面板数据和序列数据中,如果存在单位根,会产生伪回归等严重后果,所以必须对每个变量进行单位根检验,这样能够保证每个变量的平稳性,平稳变量回归才是有效的

- 伪回归:两因素间本不存在因果关系,却被误认为存在- 伪相关并不是说两个变量无相关关系,而是不清楚因果关系,即不知道是A导致B还是B导致A或是其他原因。- 三种可能:A导致B,B导致A,C导致A和B;- 如果是第三种可能,就说出现了伪回归

- 时间序列的平稳性:如果序列随时间具有恒定的统计特性(稳定的均值、方差和不依赖于时间的自协方差),我们可以假设序列是平稳的

- 平稳性检验方法介绍:绘图法、Dickey-Fuller test、ADF检验、KPSS 检验

- 用的比较多的是ADF单位根检验

ADF检验

- 增广迪基-福勒检验(Augmented Dickey-Fuller test),简称ADF检验。

- DF检验和迪基-福勒检验类似,但ADF检验的好处在于它排除了自相关的影响

- DF检验只能应用于一阶情况,当序列存在高阶的滞后相关时,可以使用ADF检验,所以说ADF是对DF检验的扩展

单位根

- 在一个自回归过程中: y t = b y t − 1 + a + ϵ t y_t=by_{t-1}+a+\epsilon_t yt=byt−1+a+ϵt若滞后项系数 b = 1 b=1 b=1,就称为单位根

- 当单位根存在时,自变量和因变量之间的关系具有欺骗性

- 因为残差序列的任何误差都不会随着样本量(即时期数)增大而衰减,也就是说模型中的残差的影响是永久的。(伪回归)

- 如果单位根存在,这个过程就是一个随机漫步(random walk) - 随机漫步/随机游走:基于过去的表现,无法预测将来的发展步骤和方向

ADF检验原理

- ADF检验就是判断序列是否存在单位根:如果序列平稳,就不存在单位根;否则,就会存在单位根。

- 我们希望得到的结论是:序列是平稳的,不存在单位根的

- 所以假设 H 0 : H_0: H0:序列存在单位根。

ADF检验的python实现

from statsmodels.tsa.stattools import adfuller

adfuller函数的参数意义分别是:

x:一维的数据序列。

maxlag:最大滞后数目。

regression:回归中的包含项(c:只有常数项,默认;ct:常数项和趋势项;ctt:常数项,线性二次项;nc:没有常数项和趋势项)

autolag:自动选择滞后数目(AIC:赤池信息准则,默认;BIC:贝叶斯信息准则;t-stat:基于maxlag,从maxlag开始并删除一个滞后直到最后一个滞后长度基于 t-statistic 显著性小于5%为止;None:使用maxlag指定的滞后)

store:True False,默认。

regresults:True 完整的回归结果将返回。False,默认。

返回值意义为:

adf:Test statistic,T检验,假设检验值。

pvalue:假设检验结果。

usedlag:使用的滞后阶数。

nobs:用于ADF回归和计算临界值用到的观测值数目。

icbest:如果autolag不是None的话,返回最大的信息准则值 (是在99%,95%,90%置信区间下的临界的ADF检验的值)。

resstore:将结果合并为一个dummy。

举个例子:代码

from statsmodels.tsa.stattools import adfuller

import numpy as np

array = np.random.standard_normal(size=100)

adf_result = adfuller(array)

adf_value = adf_result[0]

print("adf值:", adf_value)

p_value = adf_result[1]

print("p:", p_value)

t_value = adf_result[4]

print("临界值:", t_value)

打印结果:

adf值: -4.918907632344451

p: 3.203639985122076e-05

临界值: {'1%': -3.506944401824286, '5%': -2.894989819214876, '10%': -2.584614550619835}

如何分析结果:

若要证明序列平稳,即拒绝原假设,需要

- 1、p值要小于0.05,接近0最好,说明原假设是小概率事件

- 2、比较adf值和临界值大小,若adf值<1%对应的值,则说明在置信区间1%内平稳 - adf值一般是负的

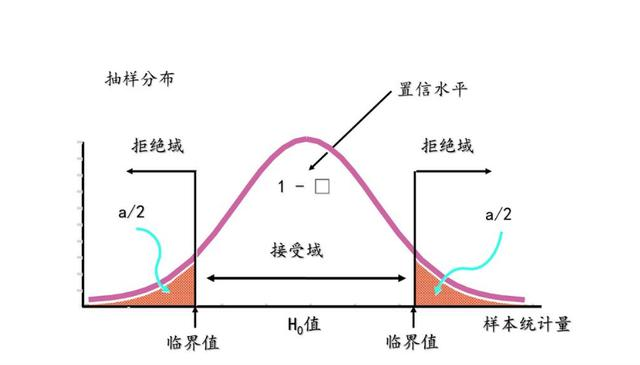

显著性检验(significance test)

统计显著性和置信度

- 任何理论(或认识)都没法保证其关于现实的推测是100%正确的,这归因于理论永远都只是对现实世界真相的大致概括和特征提取。

- 理论只能无限趋近于真实,但无法达到真实。人类用的仅仅是越来越接近真相的理论而已。

- 所以对于任何说法,都有一个可信度问题。

- 而通过对于现实的重复测试,我们将能够了解某说法究竟有多可信,不同的说法之间是存在着可信度的差异的。

- 这就像是盲人摸象之后,每个盲人说出的有关大象外形的可信度是有差别的,而且只要让盲人们多摸几次,他们对大象长相的描述会越来越接近真实。

- 了解不同观点的可信度,是统计的目的之一。

- 统计中所谓的’显著性’就是可信度的一种指标。

- 具有统计显著性的结果反映的是经过严格的测试得到的结果达到了一定可信度一专业术语叫’置信度’(又叫“置信水平”),它表明我们在多大程度上相信结论不会因随机因素而发生偏差。

- 更具体地说,置信度是我们所持理论预测出来的结果在指定区间出现的可能性。

- 显著性跟置信度的内涵异曲同工,但它们的表述方法刚好相反,且在应用中描述方式略有差异: - 对于置信度一般我们会说’…实验结果落在某个置信区间的可能性可以达到多高…'(这个可能性越大置信度就越高)- 而对于显著性我们会说’.…我们的理论假设被否定的可能性小于多少,我们的假设就可以被称为显著或者极显著…'(这个可能性越小显著性越高)- 显著性水平就是变量落在置信区间以外的可能性- 也就是说,置信度通常是正面描述(拒伪的),而目通常需要与一个置信区间关联起来。而显著性则是反面描述(拒真的),而且通常需要与一个预设的判断门槛值联系起来。- 如果显著性水平是 α \alpha α,那么置信度就是 1 − α 1-\alpha 1−α-

补充:第一类错误和第二类错误

- 第一类错误:原假设为真,却惨遭拒绝,记这一事件发生的概率为 α \alpha α

- 第二类错误:原假设为假,确被你接受了,这一事件发生概率为 β \beta β

p值是啥

- 说了那么多,所以p值是啥呢

- p值是假设 H 0 H_0 H0成立的概率

- 一般,想要证明什么,零假设就要设它的反面,基于反证法证明本来想证明的东西

- 只要证明 H 0 H_0 H0发生是一个小概率事件:若 p < α p<\alpha p<α,则这个测试具有统计学显著性

- 如果置信区间不包含零假设的值,则检验结果具有统计显著性

- 一般选取的 α = 0.05 \alpha=0.05 α=0.05

常用数据类型(金融)

- 主要分为三种:时间序列数据、截面数据和面板数据

- 以上主要是根据个体、时间来区分

- 1.时间序列数据:同一个体不同时间的状态构成的数据集 - 中国近30年的GDP水平

- 2.截面数据(Cross Sectional):不同个体同一时间的状态构成的数据集 - 各省份在2021年的GDP水平

- 3.面板数据(Panel):不同个体不同时间的状态构成的数据集 - 中国各省近30年的GDP水平

一些名词解释

- OLS(ordinary least squares)回归:就是普通最小二乘法 - 混合OLS:将样本中的所有数据一视同仁,进行OLS回归。- 线性回归面经总结 https://zhuanlan.zhihu.com/p/66519299/

固定效应,随机效应

- 简单的看固定效应和随机效应模型: 固定: Y i t = α + β x i t + γ i + ( ϵ i t ) 固定:Y_{it} = \alpha+\beta x_{it}+\gamma_i+(\epsilon_{it}) 固定:Yit=α+βxit+γi+(ϵit) 随机: Y i t = α + β x i t + ( γ + ϵ i t ) 随机: Y_{it} = \alpha+\beta x_{it}+(\gamma+\epsilon_{it}) 随机:Yit=α+βxit+(γ+ϵit)

- 其中, i i i是个体, t t t是时期

- 由以上公式发现,固定效应中个体特征变量( γ i \gamma_i γi )是一个随个体( i i i )改变但不随时间( t t t )改变的变量,算入解释变量中;而随机效应中的遗漏的个体变量( γ \gamma γ )是一个既不随个体( i i i )又不随时间( t t t )改变的变量,算入随机误差项中。

- 固定效应模型和随机效应模型的差别在于:遗漏的个体特征变量,究竟是算作解释变量,还是算作随机误差项? - 其中固定效应模型认为个体特征变量属于解释变量,随机效应模型则将个体特征变量考虑到随机误差项中。- 也正是如此,固定效应模型中的解释变量可以与个体特征变量相关,但是随机效应中不能。- 如果解释变量本来和随机误差项有关,是不能用随机效应模型的,也就是说,随机效应模要求的假设更强

例子

链接

- 固定效应模型中,每一个个体有一部分不随时间改变的不可观测的效应,如果这部分效应跟自变量相关,则是固定效应。 - 例如,比较3种药物的疗效,目的就是为了比较这三种药的差别。这三种药不是从很多种药中抽样出来的,不能推广到其他的药物,结论仅限于这三种药。- “固定”的含义正在于此,这三种药是固定的,不是随机选择的。- 此时这三种药的特征(自变量)与个体不可观测部分是相关的。

- 随机效应模型中,个体不可观测效应与自变量无关。 - 例如,想知道是否名牌大学的就业率高于普通大学,随机选择了北大、清华、北京工商大学、北京科技大学4所学校进行比较。- 目的是要推广到名牌和普通这样的一个更广泛的范围,而不仅限于这4所大学- “随机”的含义就在于此,这4所学校是从名牌和普通大学中随机挑选出来的。- 此时这四所大学不可观测的个体特征也是随机的,与自变量无关。

固定模型如何固定

- 既然个体特征是与个体( i i i )相关,且不随时间( t t t )改变的,那么可以通过一定的手段处理掉个体特征

- 主要有三种方法: - (1)差分处理 - Y i t − Y i t − 1 = ( α + β x i t + γ i + ε i t ) − ( α + β x i t − 1 + γ i + ε i t − 1 ) Y_{i t}-Y_{i t-1}=\left(\alpha+\beta x_{i t}+\gamma_i+\varepsilon_{i t}\right)-\left(\alpha+\beta x_{i t-1}+\gamma_i+\varepsilon_{i t-1}\right) Yit−Yit−1=(α+βxit+γi+εit)−(α+βxit−1+γi+εit−1) = β ( x i t − x i t − 1 ) + ( ε i t − ε i t ) =\beta\left(x_{i t}-x_{i t-1}\right)+\left(\varepsilon_{i t}-\varepsilon_{i t}\right) =β(xit−xit−1)+(εit−εit)- (2)去心处理 - Y i t − Y ˉ i t = ( α + β x i t + γ i + ε i t ) − ( α + β x ˉ i t + γ i + ε ˉ i t ) Y_{i t}-\bar{Y}{i t}=\left(\alpha+\beta x{i t}+\gamma_i+\varepsilon_{i t}\right)-\left(\alpha+\beta \bar{x}{i t}+\gamma_i+\bar{\varepsilon}{i t}\right) Yit−Yˉit=(α+βxit+γi+εit)−(α+βxˉit+γi+εˉit) = β ( x i t − x ˉ i t ) + ε i t =\beta\left(x_{i t}-\bar{x}{i t}\right)+\varepsilon{i t} =β(xit−xˉit)+εit- code:

areg $Y $X $X_CON, absorb(变量)- (3)虚拟变量处理 - Y i t = α + β x i t + γ i + ε i t Y_{i t}=\alpha+\beta x_{i t}+\gamma_i+\varepsilon_{i t} Yit=α+βxit+γi+εit- γ i \gamma_i γi为个体虚拟变量,在样本为个体 i i i时 γ i = 1 \gamma_i=1 γi=1,其余情况=0。- code:reg $Y $X $X_CON i.变量 - 三种不同的方法,都可以得到同样的回归系数 β \beta β

- 当需要固定某个变量(可能是个体、时间、行业、地区…等离散的变量)的时候,一般常用第2,3种方法

异方差检验:使用混合OLS回归还是变系数模型

- 混合OLS回归(POLS)不考虑面板数据中中的个体效应(即固定效应和随机效应)

- 随机和固定效应模型都属于变系数模型

reg $Y $X $X_CON // 混合OLS

xtreg $Y $X $X_CON, re // 随机效应

xttest0 // B-P检验 P <0.05 则选择变截距

- BP检验属于异方差检验的内容,来判断方程是否存在异方差

- B-P检验的基础原理就是经过辅助回归的R^2,来检验是否存在异方差的状况。stata实现BP检验

- 在回归的结果中,我们重点关注回归的P值(Prob > chibar2),由于此处的原假设是Var(u) = 0(也就是选择POLS),当Prob > chibar2小于0.05的时候,可以Var(u)不为0,认为选择变截距模型。

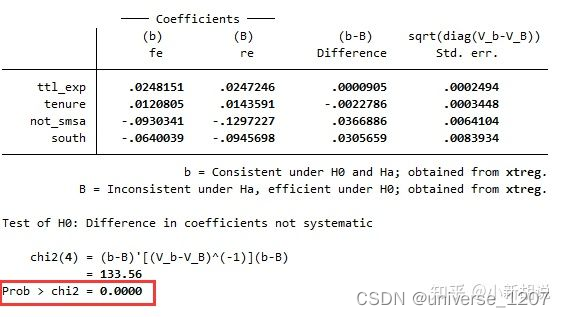

选择随机/固定效应模型

- 随机效应需要的假设比固定效应更强

- 相比之下,固定效应却有更多的自由度损失(因为待估参数更多)

- 因此需要对这二者进行取舍

- 如果两个模型的结果相差不大,就选择随机效应,如果两个模型的结果相差较大,就选择固定效应

- 这里的大或者不大需要构造一个统计量来判断两个模型之间的差异是否够大,这通常通过豪斯曼检验(hausman)实现

豪斯曼检验(hausman)

xtreg $Y $X $X_CON, re // 随机效应

est store re // 记录结果

xtreg $Y $X $X_CON, fe // 固定效应

est store fe // 记录结果

hausman fe re // hausman检验 P <0.05 则选择固定效应

- 重点关注这里的Prob > chi2,此处的原假设是接受随机效应,当Prob > chi2小于0.05的时候,认为应该选择固定效应模型。

信息整理

- 固定效应(fixed effect, FE),随机效应(random effect, RE) https://zhuanlan.zhihu.com/p/60528092

- 为什么现在经济类顶刊的杂志上,大家应用面板计量数据回归时,都只采用固定效应模型而不采用随机效应模型了? https://www.zhihu.com/question/282221100

Python实现面板数据回归

Python计量–linearmodels面板数据回归(一)

Python计量–linearmodels面板数据回归(二)

Python计量–linearmodels面板数据回归(三)

版权归原作者 universe_1207 所有, 如有侵权,请联系我们删除。