Ollama

Ollama轻量级、可扩展的框架,用于在本地机器上构建和运行大型语言模型(LLM)。提供了一个简单的API来创建、运行和管理模型,以及一个预构建模型库,可以轻松用于各种应用程序。

明显优势:易于使用、轻量级、可扩展、预构建模块库

人群价值:研究人员、开发人员、爱好者

应用场景:文本生成、翻译、问答、代码生成

项目优点:易用性、性能、功能、社区

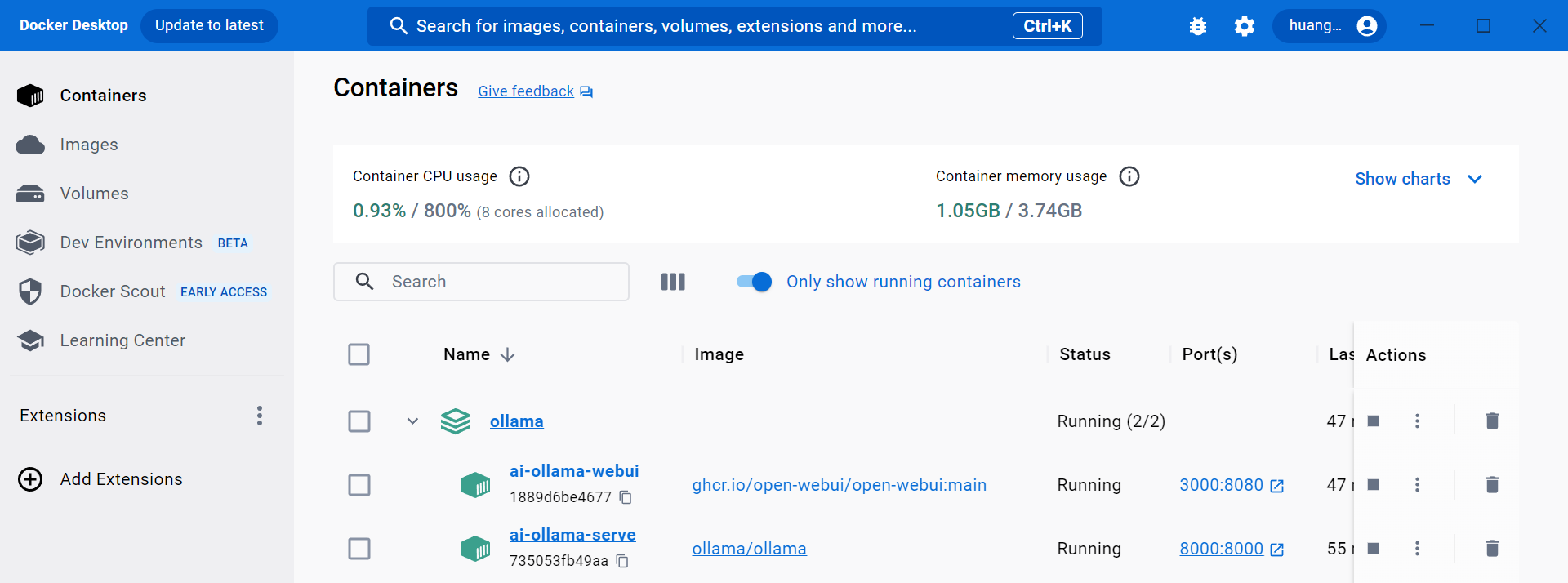

容器

文件

- docker-compose.ollama.yml

version:'3.5'services:ollama:#restart: alwayscontainer_name: ai-ollama-serve

image: ollama/ollama

ports:- 8000:8000environment:- OLLAMA_HOST=0.0.0.0:8000- OLLAMA_MODELS=/data/models

#volumes:# - ./ollama_serve/models:/data/models # 先注释# 命令启动 servecommand: serve

ollama-webui:#restart: alwayscontainer_name: ai-ollama-webui

image: ghcr.io/open-webui/open-webui:main

ports:- 3000:8080environment:- OLLAMA_BASE_URL=http://【地址】:8000#volumes:#- ./ollama-webui/backend/data:/app/backend/data # 先注释##################### 使用ollama部署大模型 ###################### docker-compose -f docker-compose.ollama.yml up -d# OLLAMA_HOST The host:port to bind to (default "127.0.0.1:11434")# OLLAMA_ORIGINS A comma separated list of allowed origins.# OLLAMA_MODELS The path to the models directory (default is "~/.ollama/models")# llama2 | qwen:0.5b-chat | llava | llama2-chinese# https://github.com/open-webui/open-webui#troubleshooting# 拷贝到本地存# docker cp ai-ollama-serve:/data/models/ ./ollama_serve/models/# docker cp ai-ollama-webui:/app/backend/data/ ./ollama-webui/backend/

运行

docker-compose -f docker-compose.ollama.yml up -d

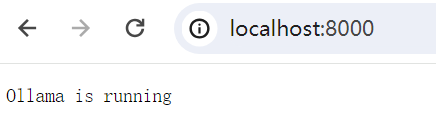

验证

服务端

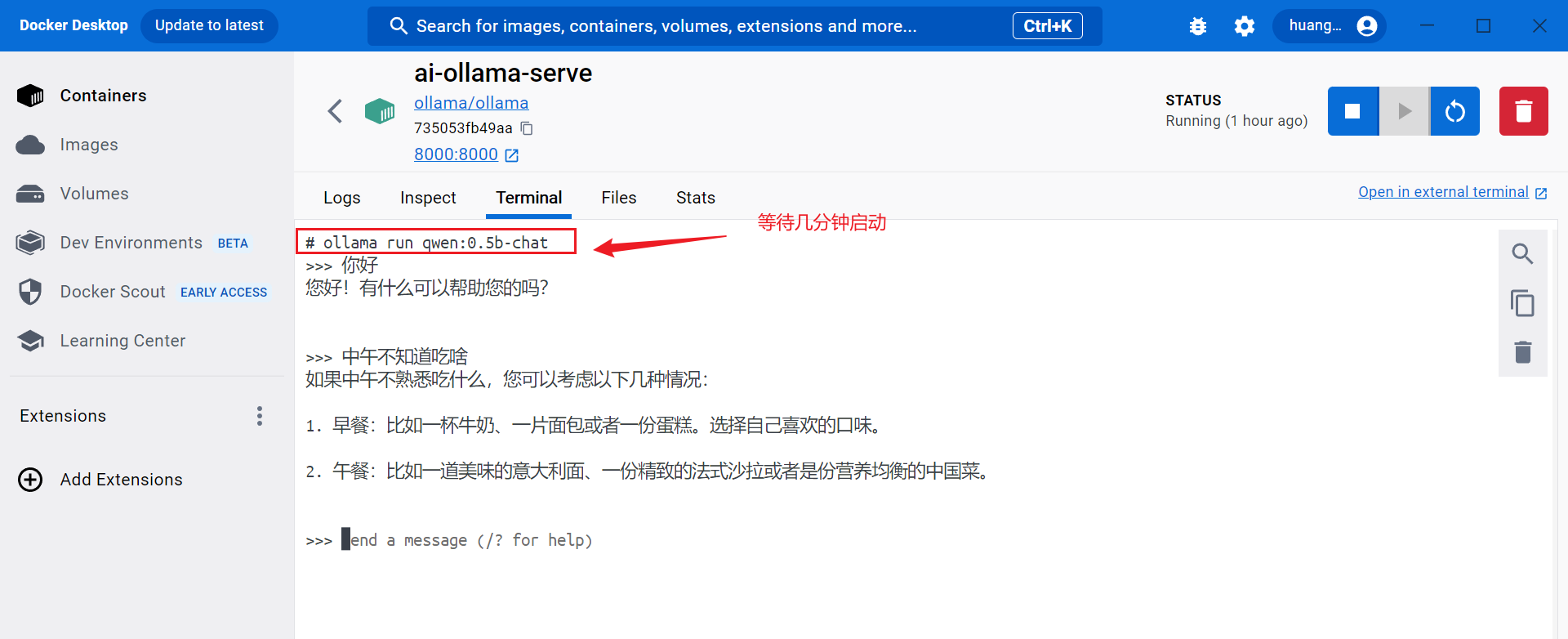

- 运行

ollama run qwen:0.5b-chat

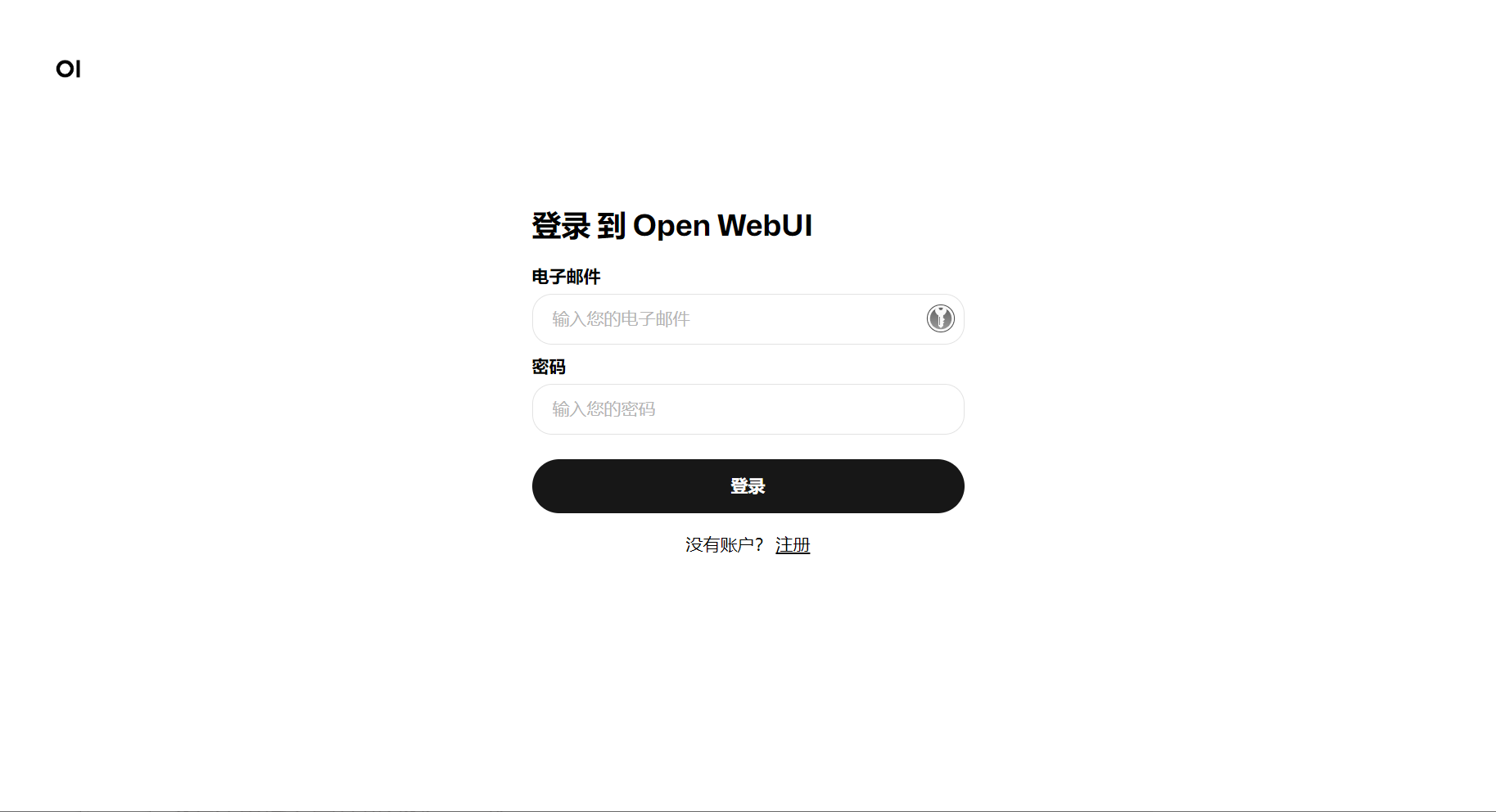

网页端

使用

快捷

https://ollama.com

https://ollama.com/library/qwen

https://github.com/open-webui/open-webui

版权归原作者 掘金者说 所有, 如有侵权,请联系我们删除。