大家好,我是微学AI,今天给大家介绍一下人工智能(pytorch)搭建模型23-pytorch搭建生成对抗网络(GAN):手写数字生成的项目应用。生成对抗网络(GAN)是一种强大的生成模型,在手写数字生成方面具有广泛的应用前景。通过生成逼真的手写数字图像,GAN可以用于数据增强、图像修复、风格迁移等任务,提高模型的性能和泛化能力。生成对抗网络在手写数字生成领域具有广泛的应用前景。主要应用场景包括数据增强、图像修复、风格迁移和跨领域生成。数据增强可以通过生成逼真的手写数字图像,为训练数据集提供更多的样本,提高模型的泛化能力。

一、项目背景

随着深度学习技术的不断发展,生成模型在计算机视觉、自然语言处理等领域取得了显著的成果。生成对抗网络(GAN)作为一种新兴的生成模型,近年来备受关注。在手写数字生成方面,GAN可以生成逼真的手写数字图像,为数据增强、图像修复等任务提供有力支持。

二、生成对抗网络原理

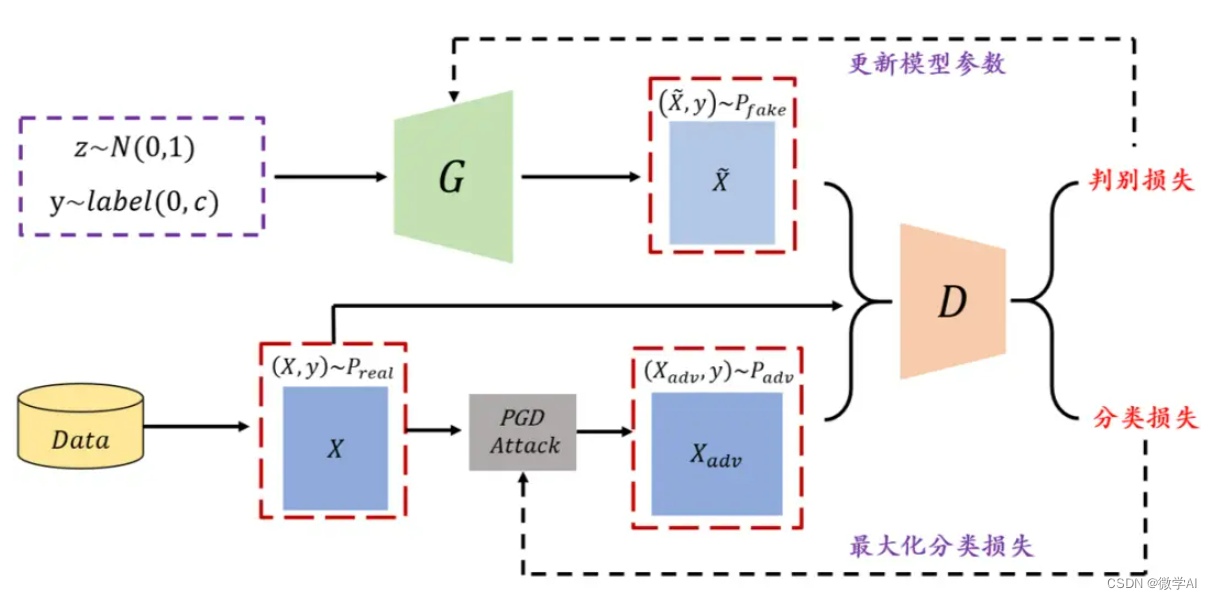

生成对抗网络(GAN)由Goodfellow等人于2014年提出,它由两个神经网络——生成器(Generator)和判别器(Discriminator)——组成。生成器的目标是生成逼真的假样本,而判别器的目标是区分真实样本和生成器生成的假样本。在训练过程中,生成器和判别器相互竞争,不断调整参数,以达到纳什均衡。

GAN的目标是最小化以下价值函数:

min

G

max

D

V

(

D

,

G

)

=

E

x

∼

p

data

(

x

)

[

log

D

(

x

)

]

+

E

z

∼

p

z

(

z

)

[

log

(

1

−

D

(

G

(

z

)

)

)

]

\min_G \max_D V(D, G) = \mathbb{E}_{x \sim p_{\text{data}}(x)}[\log D(x)] + \mathbb{E}_{z \sim p_z(z)}[\log (1 - D(G(z)))]

GminDmaxV(D,G)=Ex∼pdata(x)[logD(x)]+Ez∼pz(z)[log(1−D(G(z)))]

其中,

G

G

G表示生成器,

D

D

D表示判别器,

x

x

x表示真实样本,

z

z

z表示生成器的输入噪声,

p

data

p_{\text{data}}

pdata表示真实数据分布,

p

z

p_z

pz表示噪声分布。

三、生成对抗网络应用场景

生成对抗网络(GAN)在手写数字生成领域的应用具有广泛的前景。以下是几个主要的应用场景:

1.数据增强:通过生成逼真的手写数字图像,GAN可以为训练数据集提供更多的样本,提高模型的泛化能力。

2. 图像修复:GAN可以用于修复损坏或缺失的手写数字图像,提高图像的质量和可读性。

3. 风格迁移:GAN可以将一种手写风格转换为另一种风格,为个性化手写数字生成提供可能。

4. 跨领域生成:GAN可以实现不同手写数字数据集之间的转换,为多任务学习提供支持。

四、生成对抗网络实现手写数字生成

下面我将利用pytorch深度学习框架构建生成对抗网络的生成器模型Generator、判别器模型Discriminator。

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader

from torchvision import datasets, transforms

from torchvision.utils import save_image

# 超参数设置

batch_size =128

learning_rate =0.0002

num_epochs =80# 数据预处理

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,),(0.5,))])# 下载并加载训练数据

train_data = datasets.MNIST(root='./data', train=True, transform=transform, download=True)

train_loader = DataLoader(dataset=train_data, batch_size=batch_size, shuffle=True)# 定义生成器模型classGenerator(nn.Module):def__init__(self):super(Generator, self).__init__()

self.model = nn.Sequential(

nn.Linear(100,256),

nn.LeakyReLU(0.2),

nn.Linear(256,512),

nn.LeakyReLU(0.2),

nn.Linear(512,1024),

nn.LeakyReLU(0.2),

nn.Linear(1024,28*28),

nn.Tanh())defforward(self, x):return self.model(x).view(x.size(0),1,28,28)# 定义判别器模型classDiscriminator(nn.Module):def__init__(self):super(Discriminator, self).__init__()

self.model = nn.Sequential(

nn.Linear(28*28,1024),

nn.LeakyReLU(0.2),

nn.Dropout(0.3),

nn.Linear(1024,512),

nn.LeakyReLU(0.2),

nn.Dropout(0.3),

nn.Linear(512,256),

nn.LeakyReLU(0.2),

nn.Dropout(0.3),

nn.Linear(256,1),

nn.Sigmoid())defforward(self, x):

x = x.view(x.size(0),-1)return self.model(x)# 初始化模型

generator = Generator()

discriminator = Discriminator()# 损失函数和优化器

criterion = nn.BCELoss()

optimizerG = optim.Adam(generator.parameters(), lr=learning_rate)

optimizerD = optim.Adam(discriminator.parameters(), lr=learning_rate)# 训练模型for epoch inrange(num_epochs):for i,(images, _)inenumerate(train_loader):# 确保标签的大小与当前批次的数据大小一致

real_labels = torch.ones(images.size(0),1)

fake_labels = torch.zeros(images.size(0),1)# 训练判别器

optimizerD.zero_grad()

real_outputs = discriminator(images)

d_loss_real = criterion(real_outputs, real_labels)

z = torch.randn(images.size(0),100)

fake_images = generator(z)

fake_outputs = discriminator(fake_images.detach())

d_loss_fake = criterion(fake_outputs, fake_labels)

d_loss = d_loss_real + d_loss_fake

d_loss.backward()

optimizerD.step()# 训练生成器

optimizerG.zero_grad()

fake_images = generator(z)

fake_outputs = discriminator(fake_images)

g_loss = criterion(fake_outputs, real_labels)

g_loss.backward()

optimizerG.step()if(i+1)%100==0:print(f'Epoch [{epoch+1}/{num_epochs}], Step [{i+1}/{len(train_loader)}], d_loss: {d_loss.item()}, g_loss: {g_loss.item()}')# 保存生成器生成的图片

save_image(fake_images.data[:25],'./fake_images/fake_images-{}.png'.format(epoch+1), nrow=5, normalize=True)# 保存模型

torch.save(generator.state_dict(),'generator.pth')

torch.save(discriminator.state_dict(),'discriminator.pth')

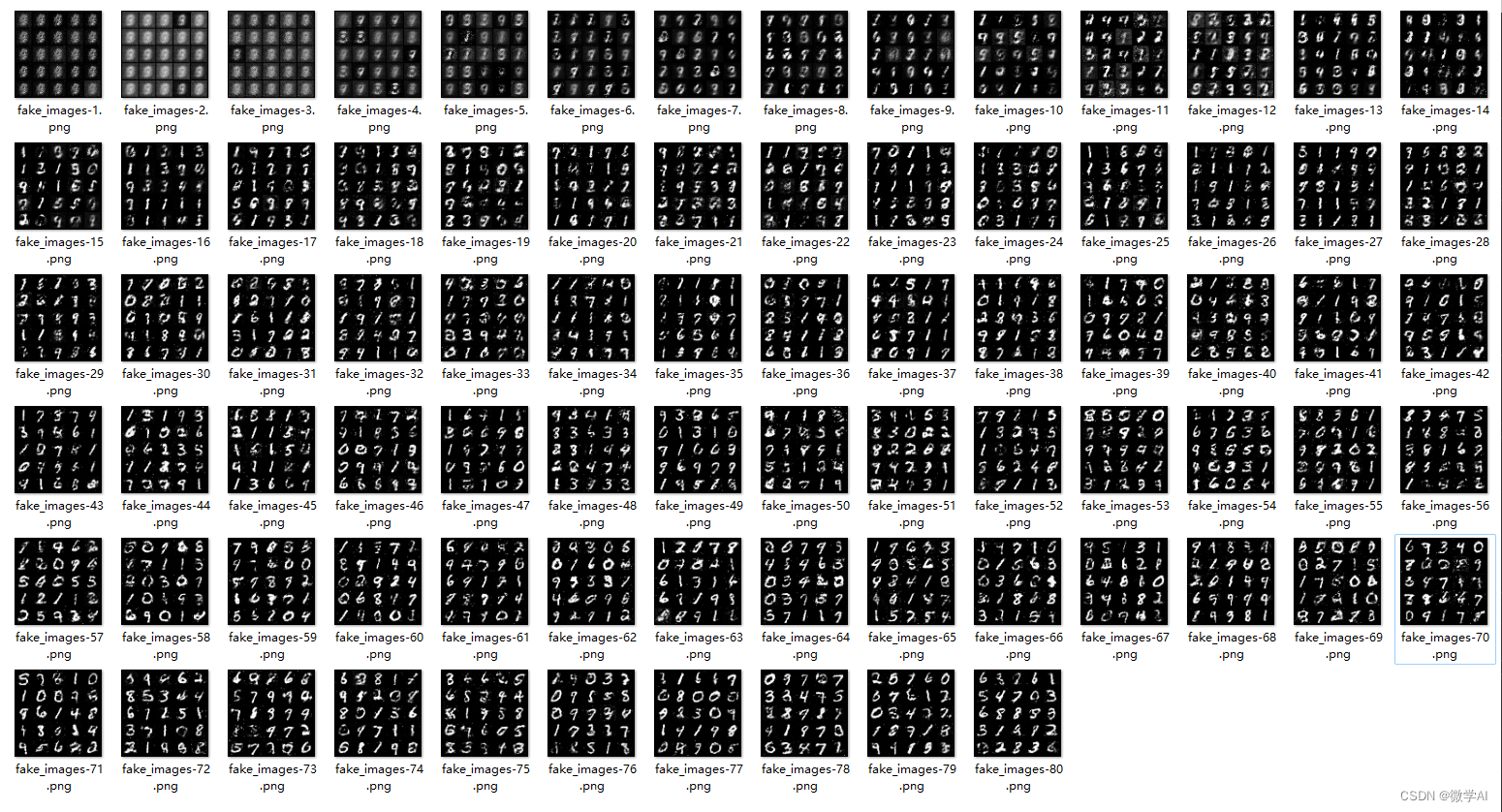

最后我们打开fake_images/文件夹,可以看到生成手写图片的过程:

五、总结

本项目利用生成对抗网络(GAN)实现了手写数字的生成。通过训练生成器和判别器,我们成功生成了逼真的手写数字图像。这些生成的图像可以应用于数据增强、图像修复、风格迁移等领域,为手写数字识别等相关任务提供有力支持。

版权归原作者 微学AI 所有, 如有侵权,请联系我们删除。