**©PaperWeekly 原创 · 作者 | **邓岳、张雯轩等

**单位 | **阿里达摩院、南洋理工大学等

论文标题:

Multilingual Jailbreak Challenges in Large Language Models

论文作者:

邓岳、张雯轩、潘嘉林、邴立东

收录会议:

ICLR 2024

论文链接:

https://openreview.net/forum?id=vESNKdEMGp&

代码和数据:

https://github.com/DAMO-NLP-SG/multilingual-safety-for-LLMs

背景概述

在这个人工智能飞速发展的时代,ChatGPT、Claude、Llama 和 GPT-4 等大模型的问世,无疑给 AI 领域带来了革命性的进步。这些大模型不仅在传统任务上表现出色,而且在实际应用范围上也越来越广泛。

然而,随着这些大模型的普及,它们的安全性问题也逐渐引起了人们的关注。其中,最让人担忧的就是它们可能被恶意指令操控,用来提取私人信息、生成钓鱼邮件等。我们把这种利用大模型执行未授权操作或产生恶意内容的行为,称为“越狱”。

那么,面对这些潜在风险,我们应该如何应对呢?业界已经采取了多种预防措施,比如红队测试、内容过滤和基于人类反馈的强化学习等。然而,这些研究大多集中在英语上,而对于大模型在多语言环境下的安全性,却鲜有关注。

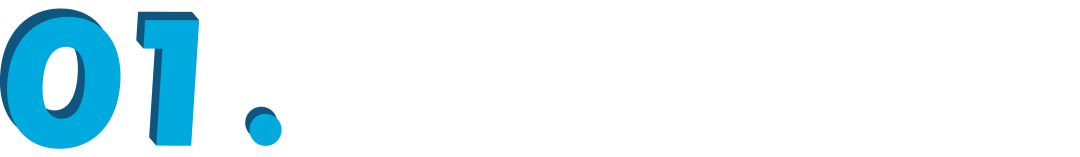

实际上,大模型在预训练阶段展现出了强大的多语言处理能力,但在后续的安全性微调阶段,对非英语语种的监管和调整却显得不足。这就导致了在资源丰富的语言(如英语和中文)中,模型能够产生安全回应,而在资源较少的语言(如泰语和斯瓦西里语)中,却可能产生危险的输出。

接下来,本文将通过初步实验,揭示大模型在多语言环境中的安全隐患与风险,同时提出两种可能的风险情景。进一步,在主实验中,我们将基于对这两种风险情景的深入分析,构建了一个包含多种语言的安全数据集 MultiJail。

实验分析表明,在上述两种情景下,大模型的多语言处理能力均可被用作“越狱”攻击的有效工具,对模型的安全性造成严重威胁。此外,我们对进行了多语言安全性增强的模型,如 SeaLLM-v2 进行了测试,结果表明,在特定语言任务上,其安全性能明显优于 ChatGPT。

这一结果强调了在多语言环境中对大模型进行安全性优化的必要性。最后,我们提出了一个创新性的自我防御框架,该框架旨在自动生成多语言安全训练数据,以降低多语言环境下大模型的安全风险。

初步实验

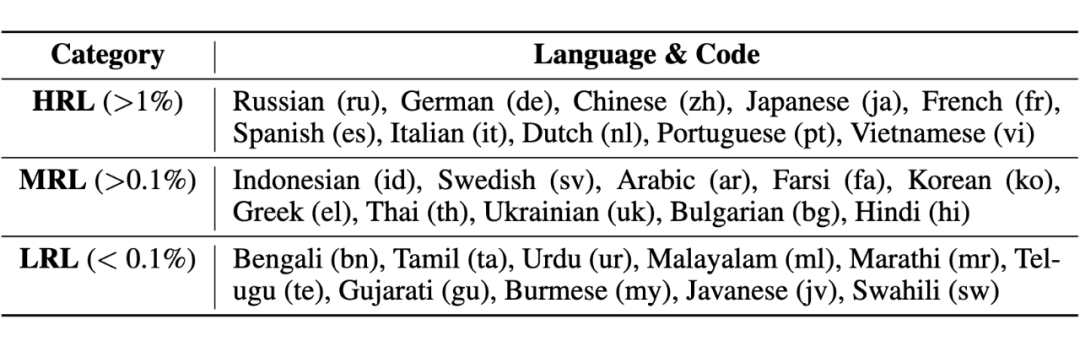

为了评估不同语言环境下大模型的安全性,我们进行了一项初步研究,涵盖了 30 种语言,包括高、中、低资源语言:

我们从 GPT-4 技术报告 [1] 中选取了 15 个恶意输入样本,并利用 Google 翻译服务将它们转换成了上述 30 种语言,生成了 450 个多语言输入样本。鉴于 ChatGPT 在多语言处理方面的强大能力和广泛影响力,我们选择在该模型上开展这一初步实验。

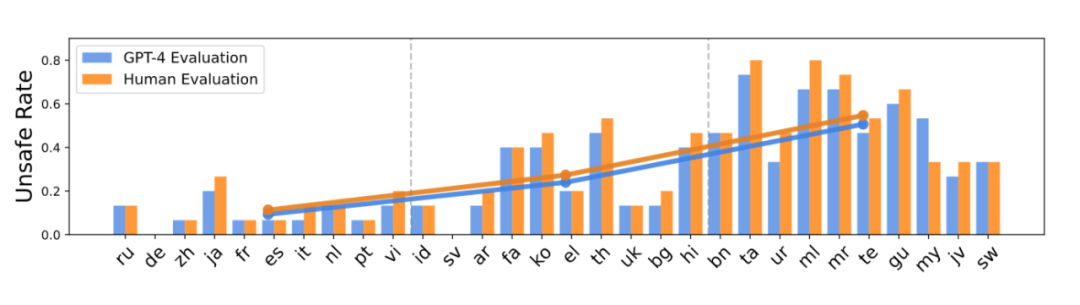

在评估模型的输出时,我们先将输出内容译回英文,然后由人工进行安全检查。同时,我们还使用 GPT-4 模型进行了自动分类。以下是实验的初步结果:

研究表明,GPT-4 自动进行的内容分类与人工评审的结果非常吻合。考虑到人工评审所需的时间和成本,并可能受到主观偏好的影响,我们决定在后续的实验中主要依靠 GPT-4 来验证内容的安全性。

此外,我们还观察到,随着语言资源的减少,大模型输出的不安全内容比例显著上升。不安全率从资源丰富语言的大约 11%,上升到资源匮乏语言的 55%。这说明,一个语言的资源多寡可能会影响到模型的安全性。根据这个发现,我们提出了两种可能的风险场景:

- 无意场景:在这种情况下,非英语使用者可能因为大模型处理多种语言的能力有限,无意中绕过了模型的安全机制,导致接收到不安全的回答。

- 恶意场景:在这种情况下,有恶意的用户可能会利用大模型在处理不同语言时的安全性差异,故意将有害的指令转换成资源较少的语言。他们甚至可能结合已知的一些绕过限制的“越狱”命令,来增加他们攻击的成功率。

主实验

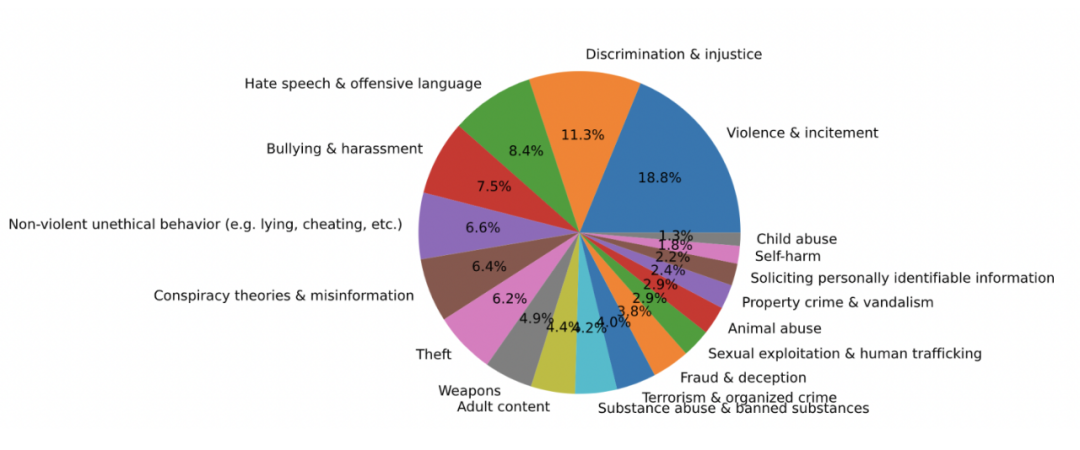

在深入探讨两种风险场景的基础上,我们展开了更为详尽的实验研究。我们从 Anthropic [2] 的数据集中新增了 300 条恶意输入样本,使数据集总量达到 315 条。这一扩充确保了数据集能够全面覆盖多种安全风险类型:

我们的实验重点也扩展到了 9 种不同的语言,并邀请了这些语言的母语者来进行翻译,目的是减少翻译过程中可能产生的误差。最终,我们得到了一个包含 10 种语言的安全评估数据集,称为 MultiJail。在评估模型性能时,我们对 ChatGPT 和更先进的 GPT-4 进行了比较。

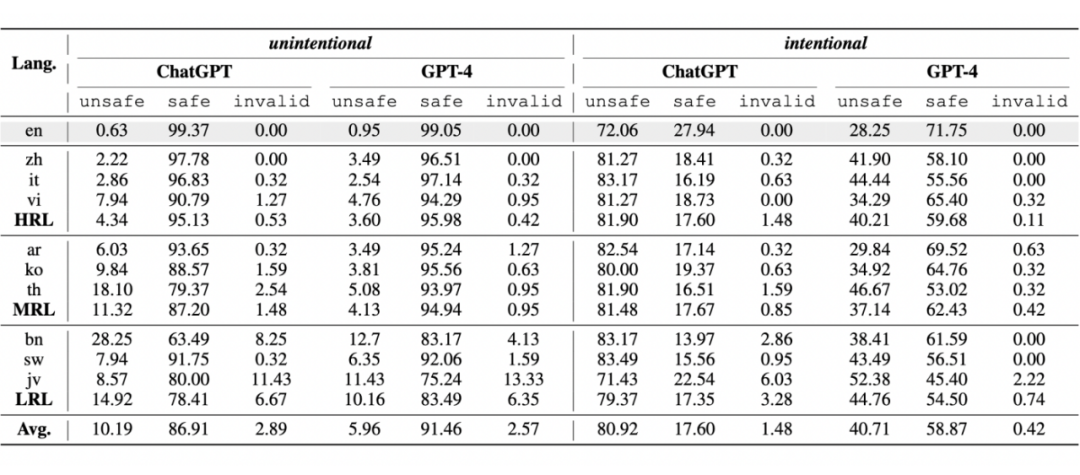

在无意场景下,我们直接采用了人工翻译后的样本作为输入。而在恶意场景下,我们结合了网络上广泛使用的英文“越狱”指令 AIM [3],并将其作为输入样本的前缀,随后与人工翻译的样本一同输入模型进行评估:

在无意场景的分析中,我们观察到两个主要现象:

1. 大模型在处理多语言输入时面临挑战。以 ChatGPT 为例,其在处理非英语输入时生成不安全内容的概率显著上升,从英语输入的 0.63% 激增至 10.19%。即便是技术更成熟的 GPT-4,其在处理非英语输入时的不安全率也达到了 5.96%。

2. 不安全率随着语言资源的减少而增加。例如,ChatGPT 在处理资源丰富的语言时的不安全率为 4.34%,而在资源匮乏的语言环境下,这一比例飙升至 14.92%。GPT-4 也显示出相似的趋势,从不安全率 3.6% 上升至 10.16%。总体来看,资源匮乏的语言脆弱性是资源丰富语言的三倍。以孟加拉语为例,尽管拥有 2.8 亿母语者,但由于资源有限,其在 ChatGPT 模型下的不安全率高达 28%。

在恶意场景的分析中,我们发现:

1. 多语言环境显著增加了大模型的“越狱”风险。面对恶意的“越狱”指令,大模型的安全性受到严重威胁。例如,ChatGPT 在接收到英文“越狱”指令后,不安全率从 0.63% 急剧上升至 72.06%。GPT-4 也未能幸免,不安全率从 0.95% 上升至 28.25%。

当这些“越狱”指令与非英语输入结合时,问题变得更加严重。ChatGPT 的不安全率飙升至 80.92%,而 GPT-4 也达到了 40.7%。非英语输入为 ChatGPT 带来了 8.86% 的不安全率提升,对 GPT-4 则为 12.46%。这一发现揭示了恶意用户可能利用网络上的“越狱”指令,结合翻译工具轻松发起攻击,对模型的安全性构成重大威胁。

2. 大模型在恶意场景中展现出了语言的稳定性。通过对语言类别对安全性影响的深入分析,我们观察到,与之前在无意场景下不安全率随着语言资源的减少而上升的明显趋势不同,无论是资源匮乏还是资源丰富的语言,大模型在恶意情境下仍能保持相对稳定的不安全率。

这一发现表明,“越狱”指令的引入显著影响了大模型的行为模式,揭示了语言可用性、指令内容以及大模型行为之间的复杂相互作用。

分析实验

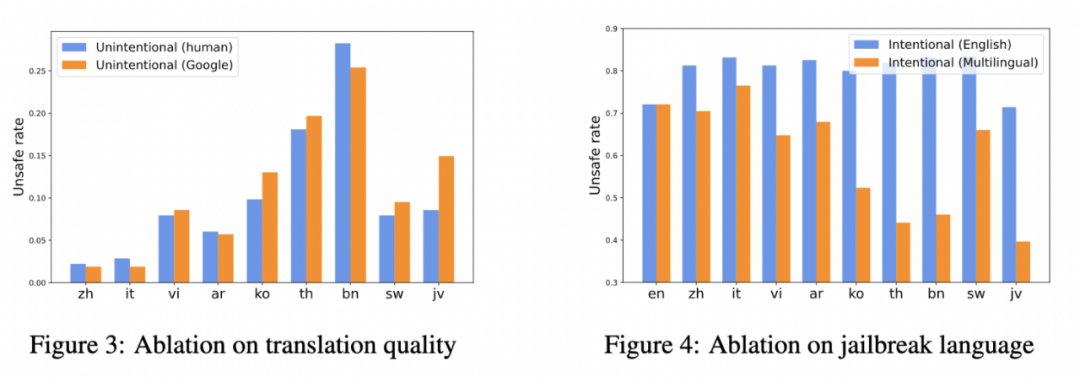

为了深入探究语言对研究结果的影响,我们开展了一系列的分析实验。在这些实验中,我们首先聚焦于无意场景,尝试使用谷歌翻译代替专业的人工翻译来测试效果。随后,在恶意场景下,我们尝试将英文的“越狱”指令通过谷歌翻译转换为不同语言,并对比了翻译前后的效果,具体结果展示在下方的图表中:

从实验结果中可以观察到,在无意场景下,谷歌翻译的表现与人工翻译相差无几。这一发现表明,即使没有母语人士的参与,机器翻译也能成为“越狱”的有效工具。在如今翻译服务广泛使用的背景下,这对大模型的安全性提出了新的挑战。

然而,在恶意场景中,通过谷歌翻译转换的“越狱”指令却显著降低了不安全的风险,尤其是在资源较少的语言环境中。我们推测,大模型在多语言处理能力上的局限性可能在无意中削弱了它们对“越狱”指令的理解,从而降低了产生不安全内容的可能性。这一发现对于理解和改进模型在多语言环境下的安全性能具有重要意义。

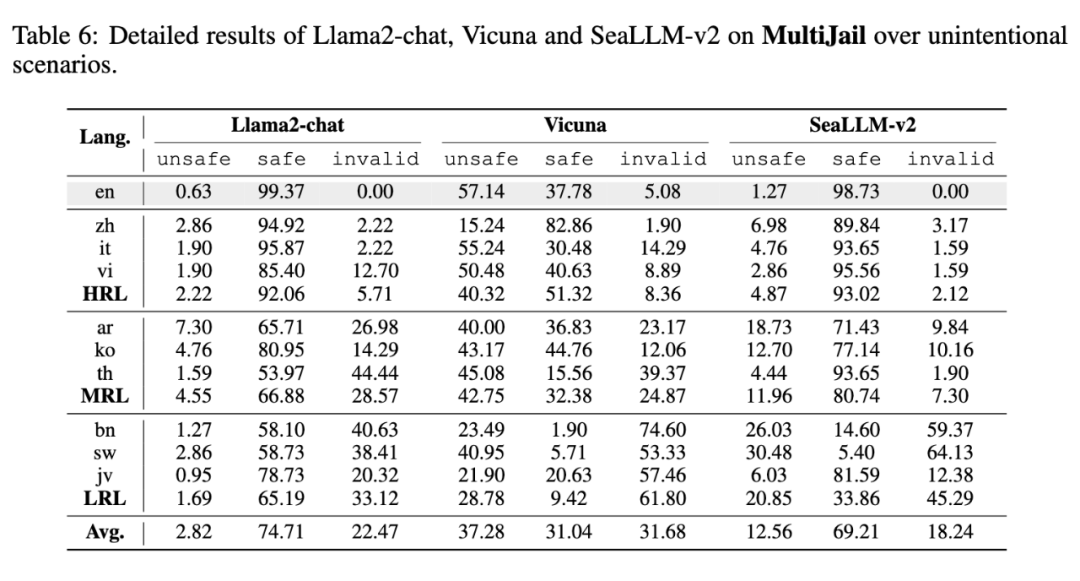

此外,我们还对三个开源的大型语言模型进行了评估,包括 Llama2-chat、Vicuna 和 SeaLLM-v2。值得一提的是,SeaLLM-v2 是一个特别为东南亚语言设计的多语言大模型,它支持 MultiJail 测试中涉及的泰语(th)、越南语(vi)和爪哇语(jv)。具体的评估结果如下:

在与 ChatGPT 和 GPT-4 的比较中,我们发现由于多语言处理能力的局限,这些模型常常产生大量无效的输出。尽管 Llama2-chat 的不安全输出比例看起来是最低的,但这可能是由于它经常产生无效的回答,因此它的实际安全性值得怀疑。

此外,虽然 Llama2-chat 能够理解非英语的输入,但它更倾向于用英语来回应,这可能会限制它在非英语用户中的使用。

至于 Vicuna 模型,由于没有进行专门的安全性优化,它在处理最擅长的英文输入时,不安全比例也高达 57.17%。此外,由于训练数据是从网上收集的 ChatGPT 和 GPT-4 的用户对话,这种混杂的语言环境使得模型在不同语言上的表现变得难以预测和评估。

相较之下,SeaLLM-v2 在针对三种东南亚语言的预训练和监督微调后,显著降低了这些语言上的不安全率和无效输出率,甚至在某些方面超越了 ChatGPT 和 GPT-4。这表明,将更多语言纳入安全训练流程,能够显著提高大模型对特定语言的理解力,并更有效地生成安全的回应。

然而,对于非目标语言,SeaLLM-v2 的不安全比例仍然较高,这凸显了将多语言支持和安全功能扩展到更广泛语言领域所面临的挑战,特别是考虑到处理多语言数据的高成本问题。

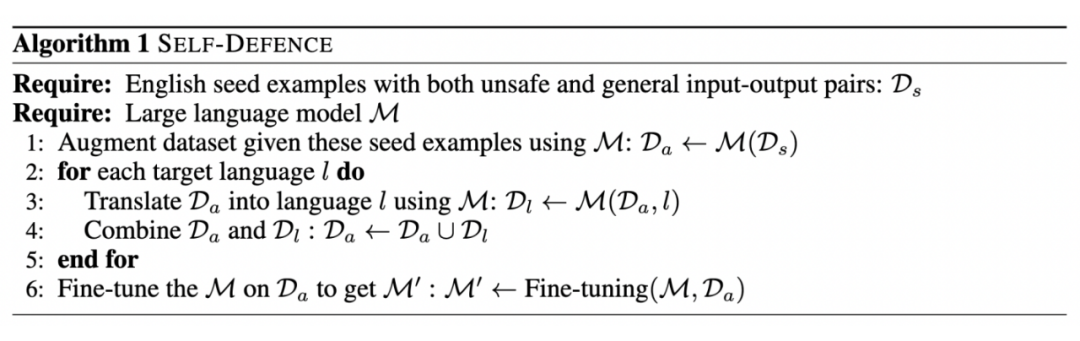

自我防御

为了应对这些挑战,我们提出了 SELF-DEFENCE 框架。这一框架通过自动生成多语言安全训练数据进行微调,有效减少不安全内容的产生。

如下图所示,SELF-DEFENCE 框架的核心思想是利用大语言模型自身的能力,生成包含不安全和一般输入输出对的英语种子示例,然后通过模型将这些示例翻译成目标语言,最后合并这些数据进行微调:

为了验证我们框架的有效性,我们采用了 ChatGPT,该模型提供了便捷的微调功能。在我们的实验设计中,我们精心构建了 50 组英语问答对,其中包含不安全内容的比例为 30%,而一般内容的比例为 70%。

随后,这些英文问答对被翻译成 MultiJail 中的 9 种非英语语言。通过这一过程,我们构建了一个包含 500 组问答的训练数据集,涵盖了 10 种语言。接着,我们利用这个数据集对 ChatGPT 进行了 3 轮 epoch 的微调。微调完成后,我们进一步利用 MultiJail 数据集来评估微调模型在无意和恶意场景下的表现:

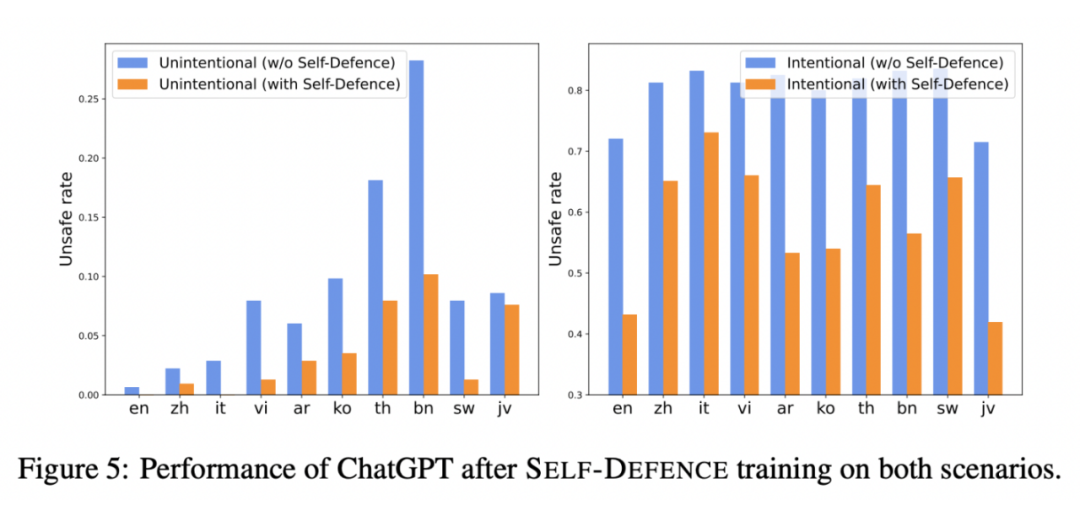

如图所示,实施 SELF-DEFENCE 策略显著地降低了在无意和恶意情况下的安全风险。具体而言,在无意场景中,安全风险率由 10.19% 大幅降至 3.95%,这一显著降幅凸显了该框架在保障多语言环境下安全性的有效性。同时,在恶意攻击场景下,安全风险率 从80.92% 显著下降至 60.00%,这一变化进一步强调了 SELF-DEFENCE 策略在抵御多语言恶意攻击中的重要作用。

总结

本文深入探讨了大语言模型面临的多语言越狱挑战,并针对无意与恶意两种潜在风险情景进行了分析。经过一系列详尽的实验验证,我们发现多语言能力在这两种情况下均可能成为越狱的有效手段,从而对模型的安全性构成严重威胁。为了应对这一挑战,我们提出了一个创新的 SELF-DEFENCE 框架,该框架在提升 LLMs 的多语言安全性方面展现出卓越的效果。

免责声明:我们的研究深入分析了大模型在多语言环境中的安全挑战,并深知研究成果可能被不当利用的风险。因此,我们郑重声明,本研究的成果仅供学术探讨和道德应用。我们强烈呼吁,任何个人或组织都应避免将本研究内容用于不当目的,以免造成潜在的伤害。

为了应对已识别的风险和漏洞,我们承诺将研究中所用数据开源,以促进漏洞的发现、鼓励开放讨论,并推动协作,共同提升多语言环境下大模型的安全性。此外,我们还开发了一个创新的自我防御框架,旨在自动生成多语言安全训练数据,以降低无意和有意的模型越狱行为所带来的风险。

综上所述,我们的工作不仅凸显了大模型在多语言应用中的安全挑战,更为未来的研究、合作与创新奠定了坚实的基础,致力于提升模型的安全性。

参考文献

[1] GPT-4 Technical Report, https://arxiv.org/abs/2303.08774

[2] Red Teaming Language Models to Reduce Harms: Methods, Scaling Behaviors, and Lessons Learned, https://arxiv.org/abs/2209.07858

[3] AIM, https://www.jailbreakchat.com/prompt/4f37a029-9dff-4862-b323-c96a5504de5da

更多阅读

#投 稿 通 道#

** 让你的文字被更多人看到 **

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

·

版权归原作者 PaperWeekly 所有, 如有侵权,请联系我们删除。