CLIP到底有多强,让我们来试试吧!

CLIP模型及代码地址:GitHub - openai/CLIP: Contrastive Language-Image Pretraining

一、准备环境

先创建一个anaconda虚拟环境,包含python=3.7版本,将该环境命名为clip。成功。

( pytorch=1.7.1 所需 python 版本 >=3.6,本博客决定安装 py3.7 )

conda create --name clip python=3.7

# 切换到虚拟环境clip中

conda activate clip

根据CLIP的github上指示,安装pytorch=1.7.1 及其他所需库。成功。

conda install --yes -c pytorch pytorch=1.7.1 torchvision cudatoolkit=11.0

pip install ftfy regex tqdm

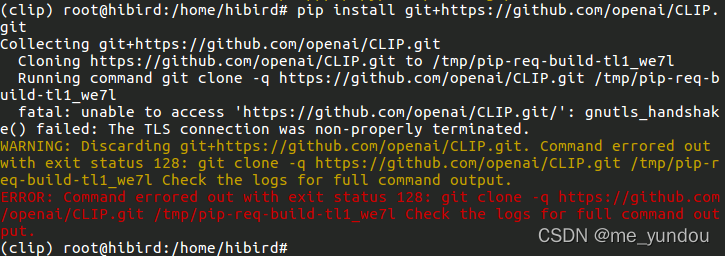

最后,从github上直接安装CLIP。这一步可能会失败。

pip install git+https://github.com/openai/CLIP.git

如果无法访问github网址,会出现如下错误:

解决方法是从github镜像网站上拉取CLIP项目的完整zip包,将下载到的CLIP-main.zip文件保存在本地路径中,然后从本地直接安装CLIP库。

具体代码如下:

# 进入CLIP-main.zip所在路径

# 解压.zip文件,然后进入解压后的文件夹

unzip CLIP-main.zip

cd CLIP-main

# 运行setup.py文件,完成本地安装clip

python setup.py install

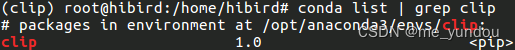

然后查看已安装的库,能找到clip就说明安装成功了,如下图所示:

二、测试CLIP

使用一个简单的图像分类代码测试clip是否能够正常运行,如下图是海贼王里面的人物艾斯,将该图片命名为Ace.jpeg。

运行下面的代码,希望模型能够识别出该图像是【一个人,一条狗,一只猫】中的哪一类:

import torch

import clip

from PIL import Image

device = "cuda" if torch.cuda.is_available() else "cpu"

# 加载预训练好的模型

model, preprocess = clip.load("ViT-B/32", device=device)

# 读取艾斯的图片和候选类别文字

image = preprocess(Image.open("Ace.jpeg")).unsqueeze(0).to(device)

text = clip.tokenize(["a man", "a dog", "a cat"]).to(device)

with torch.no_grad():

# 计算每一张图像和每一个文本的相似度值

logits_per_image, logits_per_text = model(image, text)

# 对该image与每一个text的相似度值进行softmax

probs = logits_per_image.softmax(dim=-1).cpu().numpy()

print("Label probs:", probs)

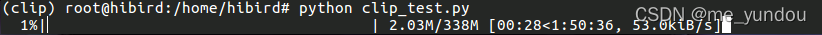

首次运行,代码会加载openai已经训练好的ViT-B/32模型,如下图所示:

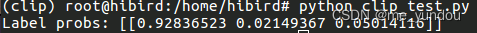

等模型加载完毕,就会执行图像分类了,从结果可以看出,CLIP以0.928的概率判定该图像是一个man,而不是dog或者cat。

等模型加载完毕,就会执行图像分类了,从结果可以看出,CLIP以0.928的概率判定该图像是一个man,而不是dog或者cat。

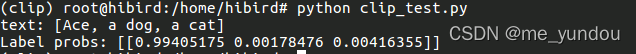

非常神奇的是,如果将代码的候选text选项中 “a man” 替换成艾斯的名字 “Ace”,让CLIP判断图像是否是Ace,结果甚至更好,CLIP以0.994的概率判定该图像是艾斯!

text = clip.tokenize(["Ace", "a dog", "a cat"]).to(device)

三、API介绍及使用

- clip.available_models()

import torch

import clip

print(clip.available_models())

该方法输出CLIP的预训练好的图像编码器名称:

['RN50', 'RN101', 'RN50x4', 'RN50x16', 'RN50x64', 'ViT-B/32', 'ViT-B/16', 'ViT-L/14']

- clip.load()

该方法接受4个输入参数,得到2个输出结果。

参数:

- name:字符串。用于指定CLIP使用的图像编码器模型。可以是模型名称,也就是clip.available_models()的输出结果;或者是这些模型所在的路径。

- device:字符串或者torch.device的输出结果。用于指定加载模型的设备,gpu或者cpu。

- jit:布尔值。是否加载优化的JIT模型。

- download_root:字符串。用于指定下载的模型的保存地址,默认值如下代码所示。

model, proprecess = clip.load(name="RN50", device="cpu", jit=False, download_root="~/.cache/clip")

版权归原作者 me_yundou 所有, 如有侵权,请联系我们删除。