✍️作者简介:小北编程(专注于HarmonyOS、Android、Java、Web、TCP/IP等技术方向)

🐳博客主页: 开源中国、稀土掘金、51cto博客、博客园、知乎、简书、慕课网、CSDN

🔔如果文章对您些帮助请👉关注✨、点赞👍、收藏📂、评论💬。

🔥如需转载请参考【转载须知】

作为世界模拟器的视频生成模型

我们探索在视频数据上进行大规模生成模型训练。具体而言,我们联合训练了文本条件扩散模型,用于处理持续时间、分辨率和宽高比各异的视频和图像。我们利用了一个在视频和图像潜在编码的时空补丁上操作的变压器架构。我们最大的模型,Sora,能够生成一分钟的高保真视频。我们的结果表明,扩展视频生成模型是建立通用物理世界模拟器的有前景的途径。

这份技术报告着重于以下两个方面:(1)我们将各种类型的视觉数据转化为统一表示的方法,从而实现大规模生成模型的训练,以及(2)对Sora的能力和局限性进行定性评估。报告中不包括模型和实现细节。

过去的研究主要关注使用各种方法进行视频数据的生成建模,包括循环网络、生成对抗网络、自回归变换器和扩散模型等。这些研究通常专注于特定类型的视觉数据、较短的视频或固定尺寸的视频。Sora是一种视觉数据的通用模型——它能够生成跨越不同持续时间、宽高比和分辨率的视频和图像,最长可达高清视频一分钟。

title_0

将视觉数据转化为补丁

我们受到大型语言模型的启发,它们通过在互联网规模的数据上进行训练而获得了通用能力。语言模型范式的成功部分得益于优雅地统一了文本的各种模态——代码、数学和各种自然语言的使用。在这项工作中,我们考虑了视觉数据的生成模型如何继承这些优势。而LLM(Large Language Models)拥有文本令牌,Sora拥有视觉补丁。补丁已被证明是视觉数据模型的有效表示。我们发现,补丁是一种高度可扩展且有效的表示方法,适用于对各种类型的视频和图像进行生成模型训练。

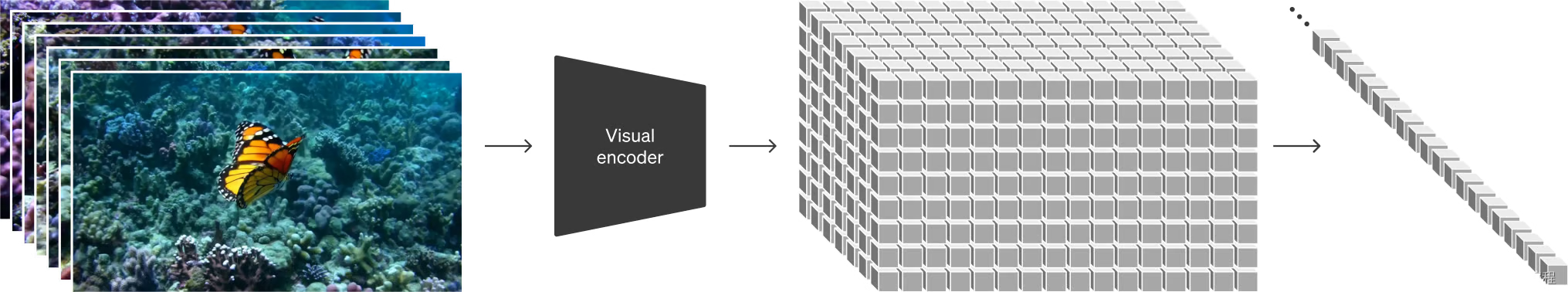

在高层次上,我们将视频转换为补丁的方法是首先将视频压缩成较低维度的潜在空间,然后将表示分解成时空补丁。

视频压缩网络

我们训练了一个网络,用于降低视觉数据的维度。这个网络以原始视频作为输入,并输出一个在时间和空间上都被压缩的潜在表示。Sora在这个压缩的潜在空间上进行训练,并随后生成视频。我们还训练了一个相应的解码器模型,将生成的潜在表示映射回像素空间。

时空潜在补丁

给定一个压缩的输入视频,我们提取一系列时空补丁,这些补丁充当变压器令牌。这个方案也适用于图像,因为图像只是具有单帧的视频。我们基于补丁的表示使得Sora能够在不同分辨率、持续时间和宽高比的视频和图像上进行训练。在推断时,我们可以通过将随机初始化的补丁以适当大小的网格排列来控制生成的视频的大小。

为视频生成扩展变压器

Sora是一个扩散模型;给定输入的噪声补丁(以及文本提示等条件信息),它被训练以预测原始的“干净”补丁。重要的是,Sora是一个扩散变压器。变压器已经在多个领域展示出了卓越的扩展性能,包括语言建模、计算机视觉和图像生成。

在这项工作中,我们发现扩散变压器在视频模型方面也具有有效的扩展性能。下面,我们展示了在训练过程中,具有固定种子和输入的视频样本的比较。随着训练计算量的增加,样本质量显著提高。

变化的持续时间、分辨率、宽高比

过去对图像和视频生成的方法通常是将视频调整大小、裁剪或修剪到标准大小,例如,256x256分辨率的4秒视频。我们发现,相反,使用数据的原始大小进行训练具有几个好处。

采样灵活性

Sora可以对宽屏1920x1080p视频、竖屏1080x1920视频以及两者之间的所有内容进行采样。这使得Sora可以直接以各种设备的原生宽高比创建内容。这还使我们可以在较低大小快速原型化内容,然后再以全分辨率生成,而这一切都是用同一个模型。

改进的构图和组合

我们经验性地发现,以原始宽高比训练视频可以改善构图和组合效果。我们将Sora与一个将所有训练视频裁剪为正方形的模型进行比较,这是训练生成模型时常见的做法。使用正方形裁剪训练的模型(左图)有时会生成主体只有部分可见的视频。相比之下,来自Sora的视频(右图)在构图上有所改进。

语言理解

训练文本到视频生成系统需要大量具有相应文本标题的视频。我们应用了DALL·E 3中引入的重新标题技术到视频中。我们首先训练一个高度描述性的标题模型,然后使用它为我们训练集中的所有视频生成文本标题。我们发现,使用高度描述性的视频标题进行训练不仅改善了文本的保真度,还提高了视频的整体质量。

与DALL·E 3类似,我们还利用GPT将短用户提示转换为更长、详细的标题,然后将其发送到视频模型。这使得Sora能够生成质量高且准确遵循用户提示的视频。

以上内容是官方翻译而来,下面做一个总结!

训练过程

在Sora的训练过程中,借鉴了大型语言模型(Large Language Model)的思想,通过在互联网规模的数据上进行训练来获取广泛的能力。

Sora是一种扩散型变换器模型(diffusion transformer)。训练过程首先将视频压缩到一个低维潜在空间中,然后将其分解成时空区块,将视频转换为区块形式。

为降低视觉数据的维度,我们训练了一个网络,该网络以原始视频为输入,输出在时间和空间上都被压缩的潜在表示。Sora在这个压缩的潜在空间上进行训练,并在此空间中生成视频。此外,我们还开发了一个对应的解码器模型,能够将生成的潜在表示映射回像素空间。

针对给定的压缩输入视频,我们提取了一系列时空区块,它们在变换器模型中充当标记(token)。这种方法同样适用于图像,因为图像本质上就是单帧的视频。基于区块的表示使得Sora能够训练在不同分辨率、持续时间和纵横比的视频和图像上。在推理过程中,我们可以通过在适当大小的网格中排列随机初始化的区块来控制生成视频的大小。

随着Sora训练计算量的增加,样本质量显著提高。

Sora的训练过程中没有对素材进行裁切,使得Sora能够直接为不同设备以其原生纵横比创造内容。

针对视频的原生纵横比进行训练,还可以提高构图和取景的质量。

训练文本到视频的生成系统需要大量配有相应文本提示的视频。我们应用了在DALL·E 3中引入的重新字幕技术到视频上。

与DALL·E 3相似,我们还利用了GPT技术,将用户的简短提示转换成更详细的提示,然后发送给视频模型。

论文关键点

OpenAI的研究论文《Video generation models as world simulators》探讨了在视频数据上进行大规模训练生成模型的方法。重点关注了文本条件扩散模型,这些模型能够同时在视频和图像上进行训练,处理不同时长、分辨率和宽高比的数据。以下是论文的关键点:

- 统一的视觉数据表示:研究者将所有类型的视觉数据转换为统一的表示,以便进行大规模的生成模型训练。Sora使用视觉补丁(patches)作为其表示方式,类似于大型语言模型(LLM)中的文本标记。

- 视频压缩网络:训练了一个网络,将原始视频压缩到一个低维潜在空间,并将其表示分解为时空补丁。Sora在这个压缩的潜在空间中进行训练,并生成视频。

- 扩散模型:Sora是一个扩散模型,通过预测原始“干净”的补丁来从输入的噪声补丁中生成视频。扩散模型在语言建模、计算机视觉和图像生成等领域已经显示出了显著的扩展性。

- 视频生成的可扩展性:Sora能够生成不同分辨率、时长和宽高比的视频,包括全高清视频。这种灵活性使得Sora能够直接为不同设备生成内容,或者在生成全分辨率视频之前快速原型化内容。

- 语言理解:为了训练文本到视频生成系统,需要大量的视频和相应的文本标题。研究者应用了在DALL·E 3中引入的重新描述技术,首先训练一个高度描述性的标题生成器,然后为训练集中的所有视频生成文本标题。

- 图像和视频编辑:Sora不仅能够基于文本提示生成视频,还可以基于现有图像或视频进行提示。这使得Sora能够执行广泛的图像和视频编辑任务,如创建完美循环的视频、动画静态图像、向前或向后扩展视频等。

- 模拟能力:视频模型在大规模训练时展现出了一些有趣的新兴能力,使得Sora能够模拟物理世界中的某些方面,如动态相机运动、长期一致性和对象持久性等。

- 讨论:尽管Sora展示了作为模拟器的潜力,但它仍然存在许多局限性,例如在模拟基本物理交互(如玻璃破碎)时的准确性不足。研究者认为,继续扩展视频模型是开发物理和数字世界模拟器的有前途的道路。

这篇论文提供了对Sora模型的深入分析,展示了其在视频生成领域的潜力和挑战。通过这种方式,OpenAI正在探索如何利用AI来更好地理解和模拟我们周围的世界。

👍 点赞,是我创作的动力!

⭐️ 收藏,是我努力的指引!

✏️ 评论,是我进步的宝藏!

💖 衷心感谢你的阅读以及支持!

、

、

版权归原作者 小北编程 所有, 如有侵权,请联系我们删除。