1、BP神经网络的核心问题是什么?其优缺点有哪些?

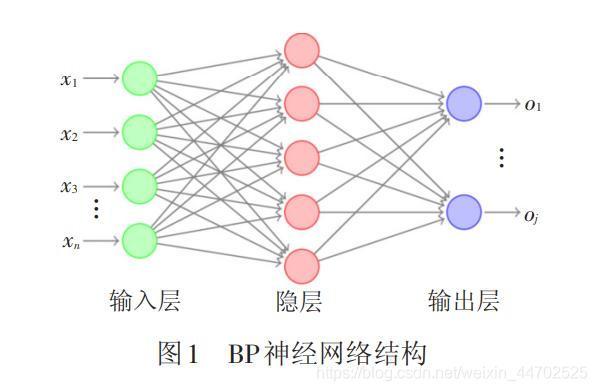

人工神经网络,是一种旨在模仿人脑结构及其功能的信息处理系统,就是使用人工神经网络方法实现模式识别.可处理一些环境信息十分复杂,背景知识不清楚,推理规则不明确的问题,神经网络方法允许样品有较大的缺损和畸变.神经网络的类型很多,建立神经网络模型时,根据研究对象的特点,可以考虑不同的神经网络模型. 前馈型BP网络,即误差逆传播神经网络是最常用,最流行的神经网络.BP网络的输入和输出关系可以看成是一种映射关系,即每一组输入对应一组输出.BP算法是最著名的多层前向网络训练算法,尽管存在收敛速度慢,局部极值等缺点,但可通过各种改进措施来提高它的收敛速度,克服局部极值现象,而且具有简单,易行,计算量小,并行性强等特点,目前仍是多层前向网络的首选算法.

- 多层前向BP网络的优点:

- 网络实质上实现了一个从输入到输出的映射功能,而数学理论已证明它具有实现任何复杂非线性映射的功能。这使得它特别适合于求解内部机制复杂的问题;

- 网络能通过学习带正确答案的实例集自动提取“合理的”求解规则,即具有自学习能力;

- 网络具有一定的推广、概括能力。

- 多层前向BP网络的问题:

- 从数学角度看,BP算法为一种局部搜索的优化方法,但它要解决的问题为求解复杂非线性函数的全局极值,因此,算法很有可能陷入局部极值,使训练失败;

- 网络的逼近、推广能力同学习样本的典型性密切相关,而从问题中选取典型样本实例组成训练集是一个很困难的问题。

- 难以解决应用问题的实例规模和网络规模间的矛盾。这涉及到网络容量的可能性与可行性的关系问题,即学习复杂性问题;

- 网络结构的选择尚无一种统一而完整的理论指导,一般只能由经验选定。为此,有人称神经网络的结构选择为一种艺术。而网络的结构直接影响网络的逼近能力及推广性质。因此,应用中如何选择合适的网络结构是一个重要的问题;

- 新加入的样本要影响已学习成功的网络,而且刻画每个输入样本的特征的数目也必须相同;

- 网络的预测能力(也称泛化能力、推广能力)与训练能力(也称逼近能力、学习能力)的矛盾。一般情况下,训练能力差时,预测能力也差,并且一定程度上,随训练能力地提高,预测能力也提高。但这种趋势有一个极限,当达到此极限时,随训练能力的提高,预测能力反而下降,即出现所谓“过拟合”现象。此时,网络学习了过多的样本细节,而不能反映样本内含的规律

- 由于BP算法本质上为梯度下降法,而它所要优化的目标函数又非常复杂,因此,必然会出现“锯齿形现象”,这使得BP算法低效;

- 存在麻痹现象,由于优化的目标函数很复杂,它必然会在神经元输出接近0或1的情况下,出现一些平坦区,在这些区域内,权值误差改变很小,使训练过程几乎停顿;

- 为了使网络执行BP算法,不能用传统的一维搜索法求每次迭代的步长,而必须把步长的更新规则预先赋予网络,这种方法将引起算法低效。

谷歌人工智能写作项目:小发猫

2、bp神经网络的缺点

1)局部极小化问题:从数学角度看,传统的BP神经网络为一种局部搜索的优化方法,它要解决的是一个复杂非线性化问题,网络的权值是通过沿局部改善的方向逐渐进行调整的,这样会使算法陷入局部极值,权值收敛到局部极小点,从而导致网络训练失败怎么改进bp神经网络。加上BP神经网络对初始网络权重非常敏感,以不同的权重初始化网络,其往往会收敛于不同的局部极小,这也是很多学者每次训练得到不同结果的根本原因。

2)BP神经网络算法的收敛速度慢:由于BP神经网络算法本质上为梯度下降法,它所要优化的目标函数是非常复杂的,因此,必然会出现“锯齿形现象”,这使得BP算法低效;又由于优化的目标函数很复杂,它必然会在神经元输出接近0或1的情况下,出现一些平坦区,在这些区域内,权值误差改变很小,使训练过程几乎停顿。

3)BP神经网络结构选择不一:BP神经网络结构的选择至今尚无一种统一而完整的理论指导,一般只能由经验选定。网络结构选择过大,训练中效率不高,可能出现过拟合现象,造成网络性能低,容错性下降,若选择过小,则又会造成网络可能不收敛。而网络的结构直接影响网络的逼近能力及推广性质。因此,应用中如何选择合适的网络结构是一个重要的问题。

4)应用实例与网络规模的矛盾问题:BP神经网络难以解决应用问题的实例规模和网络规模间的矛盾问题,其涉及到网络容量的可能性与可行性的关系问题,即学习复杂性问题。

5)BP神经网络预测能力和训练能力的矛盾问题:预测能力也称泛化能力或者推广能力,而训练能力也称逼近能力或者学习能力。一般情况下,训练能力差时,预测能力也差。

3、bp神经网络提高泛化能力?有几种方法?

常规的几种增强泛化能力的方法,罗列如下:1、较多的输入样本可以提高泛化能力;

但不是太多,过多的样本导致过度拟合,泛化能力不佳;样本包括至少一次的转折点数据。

2、隐含层神经元数量的选择,不影响性能的前提下,尽量选择小一点的神经元数量。隐含层节点太多,造成泛化能力下降,造火箭也只要几十个到几百个神经元,拟合几百几千个数据何必要那么多神经元?

3、误差小,则泛化能力好;误差太小,则会过度拟合,泛化能力反而不佳。

4、学习率的选择,特别是权值学习率,对网络性能有很大影响,太小则收敛速度很慢,且容易陷入局部极小化;太大则,收敛速度快,但易出现摆动,误差难以缩小;一般权值学习率比要求误差稍微稍大一点点;另外可以使用变动的学习率,在误差大的时候增大学习率,等误差小了再减小学习率,这样可以收敛更快,学习效果更好,不易陷入局部极小化。

5、训练时可以采用随时终止法,即是误差达到要求即终止训练,以免过度拟合;可以调整局部权值,使局部未收敛的加快收敛。

4、bp神经网络的算法改进一共有多少种啊!麻烦举例一下!

改进点主要在以下几个方面

1激励函数的坡度

———————误差曲面的平台和不收敛现象

————————————————激励函数中引入陡度因子,分段函数做激励函数

2误差曲面

——————误差平方做目标函数,逼近速度慢,过拟合

————————————————标准误差函数中加入惩罚项

————————————————信息距离和泛化能力之间的关系,构建新的神经网络学习函数

3网络初始权值的选取

—————————通常在【0,1】间选取,易陷入局部最小

—————————————————复合算法优化初始权值

—————————————————Cauchy不等式和线性代数方法得最优初始权值

4改进优化算法

————————标准BP采用梯度下降法,局部最小收敛慢

——————————————————共扼梯度法、Newton法、Gauss一Ncwton法、Lvenber_Marquardt法、快速传播算法

——————————————————前馈网络学习算法,二阶学习算法,三项BP算法,最优学习参数的BP算法。

5.优化网络结构

————————拓扑结构中网络层数、各层节点数、节点连接方式的不确定性

——————————————构造法和剪枝法(权衰减法、灵敏度计算方法等)

——————————————网络结构随样本空间进行变换,简化网络结构

6混合智能算法

————————与遗传算法、进化计算、人工免疫算法、蚁群算法、微粒群算法、

————————模糊数学、小波理论、混沌理论。细胞神经网络

5、基于改进的BP人工神经网络算法的软土地基沉降预测

改进的BP神经网络预测需要等间隔数据,利用Spline插值点进行建模。为了和前述方法的预测效果对比,仍选取550~665d(共24个样本数据)的沉降量作为训练样本,预留 670~745d(共16个样本数据)的沉降量作为对训练好的BP人工神经网络的检验样本。以每相邻的连续4个沉降量(时间间隔Δt=5 d)作为一个输入样本(S1,S2,S3,S4),紧邻的第5个沉降量作为目标样本(S5),这样,利用 2 4个原始数据点,构建了 21组训练样本输入向量。每组训练样本的输入层单元数为n=4,输出层单元数为q=1,又隐层单元数p的确定公式为

温州浅滩软土工程特性及固结沉降规律研究

式中:a为1~10之间的常数。

由式(5.57)确定隐层神经元数为p=3~12。其具体值将通过BP人工神经网络训练误差来判断,取网络误差最小时对应的隐层神经元数。

本书基于MATLAB 7.1 编制了改进的BP神经网络程序,对标准的BP人工神经网络算法采取了增加动量项法和自适应调节学习速率法两点改进,此外,对输入输出数据进行了尺度变换(归一化处理),变换后可防止因净输入的绝对值过大而使神经元输出饱和,继而使权值调整进入误差曲面的平坦区。输入输出数据变换为[0,1]区间内的值的归一化预处理变换式为

温州浅滩软土工程特性及固结沉降规律研究

式中:xi为输入或输出数据;xmin、xmax为最值;

为输入或输出数据的归一化值。

B P神经网络模型的训练曲线如图5.1 7所示。

本书所建立的改进的B P神经网络模型之拟合/预测值与实测值列于表5.13,拟合/预测曲线与实测曲线对比如图5.1 8所示,其残差图如图5.19所示。

由表5.13 和图5.1 8、5.19可知,改进的 B P 神经网络模型预测结果的平均残差为0.1 cm,平均相对误差为0.0 6%,拟合及预测效果很好。但是与前面几种预测方法不同的是,改进的BP人工神经网络模型的预测值略小于实测值,随着预测时间远离训练样本,这将使结果偏于不安全,所以,建议该法用于短、中期预测。同时,为了使后期预测精度更高,应不断更新训练样本向量集。

图5.17 N5+850断面 BP 神经网络训练曲线

图5.18 N5+850断面改进的 BP人工神经网络模型预测曲线与实测曲线对比

图5.19 N5+850断面改进的 BP人工神经网络模型预测残差图

表5.13 改进的BP神经网络预测值与实测值对比

6、c语言实现*/遗传算法改进BP神经网络原理和算法实现怎么弄

遗传算法有相当大的引用。遗传算法在游戏中应用的现状在遗传编码时, 一般将瓦片的坐标作为基因进行实数编码, 染色体的第一个基因为起点坐标, 最后一个基因为终点坐标, 中间的基因为路径经过的每一个瓦片的坐标。在生成染色体时, 由起点出发, 随机选择当前结点的邻居节点中的可通过节点, 将其坐标加入染色体, 依此循环, 直到找到目标点为止, 生成了一条染色体。重复上述操作, 直到达到指定的种群规模。遗传算法的优点:1、遗传算法是以决策变量的编码作为运算对象,可以直接对集合、序列、矩阵、树、图等结构对象进行操作。这样的方式一方面有助于模拟生物的基因、染色体和遗传进化的过程,方便遗传操作算子的运用。另一方面也使得遗传算法具有广泛的应用领域,如函数优化、生产调度、自动控制、图像处理、机器学习、数据挖掘等领域。2、遗传算法直接以目标函数值作为搜索信息。它仅仅使用适应度函数值来度量个体的优良程度,不涉及目标函数值求导求微分的过程。因为在现实中很多目标函数是很难求导的,甚至是不存在导数的,所以这一点也使得遗传算法显示出高度的优越性。3、遗传算法具有群体搜索的特性。它的搜索过程是从一个具有多个个体的初始群体P(0)开始的,一方面可以有效地避免搜索一些不必搜索的点。另一方面由于传统的单点搜索方法在对多峰分布的搜索空间进行搜索时很容易陷入局部某个单峰的极值点,而遗传算法的群体搜索特性却可以避免这样的问题,因而可以体现出遗传算法的并行化和较好的全局搜索性。4、遗传算法基于概率规则,而不是确定性规则。这使得搜索更为灵活,参数对其搜索效果的影响也尽可能的小。5、遗传算法具有可扩展性,易于与其他技术混合使用。以上几点便是遗传算法作为优化算法所具备的优点。遗传算法的缺点:遗传算法在进行编码时容易出现不规范不准确的问题。

7、matlab遗传算法改进bp神经网络

你提供的代码是一个基本的BP神经网络训练过程。一般都是用GA训练,之后再用改进动量法继续训练,直至最后达到目标。

遗传算法(Genetic Algorithm)是模拟达尔文生物进化论的自然选择和遗传学机理的生物进化过程的计算模型,是一种通过模拟自然进化过程搜索最优解的方法。遗传算法是从代表问题可能潜在的解集的一个种群(population)开始的,而一个种群则由经过基因(gene)编码的一定数目的个体(individual)组成。每个个体实际上是染色体(chromosome)带有特征的实体。染色体作为遗传物质的主要载体,即多个基因的集合,其内部表现(即基因型)是某种基因组合,它决定了个体的形状的外部表现,如黑头发的特征是由染色体中控制这一特征的某种基因组合决定的。

8、BP神经网络的应用不足

神经网络可以用作分类、聚类、预测等。神经网络需要有一定量的历史数据,通过历史数据的训练,网络可以学习到数据中隐含的知识。在你的问题中,首先要找到某些问题的一些特征,以及对应的评价数据,用这些数据来训练神经网络。

虽然BP网络得到了广泛的应用,但自身也存在一些缺陷和不足,主要包括以下几个方面的问题。

首先,由于学习速率是固定的,因此网络的收敛速度慢,需要较长的训练时间。对于一些复杂问题,BP算法需要的训练时间可能非常长,这主要是由于学习速率太小造成的,可采用变化的学习速率或自适应的学习速率加以改进。

其次,BP算法可以使权值收敛到某个值,但并不保证其为误差平面的全局最小值,这是因为采用梯度下降法可能产生一个局部最小值。对于这个问题,可以采用附加动量法来解决。

再次,网络隐含层的层数和单元数的选择尚无理论上的指导,一般是根据经验或者通过反复实验确定。因此,网络往往存在很大的冗余性,在一定程度上也增加了网络学习的负担。

最后,网络的学习和记忆具有不稳定性。也就是说,如果增加了学习样本,训练好的网络就需要从头开始训练,对于以前的权值和阈值是没有记忆的。但是可以将预测、分类或聚类做的比较好的权值保存。

版权归原作者 wenangou 所有, 如有侵权,请联系我们删除。