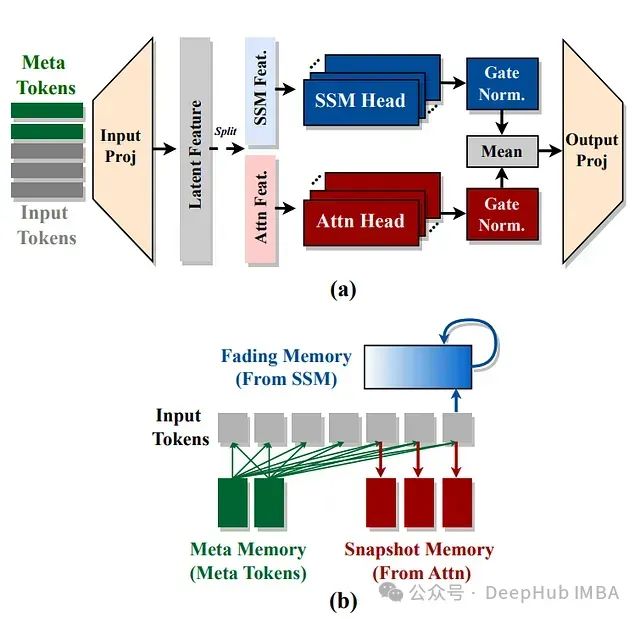

Hymba: 结合注意力头和SSM头的创新型语言模型方案

NVIDIA提出了Hymba架构,通过在同一层中结合注意力头和SSM头,以实现两种架构优势的互补。

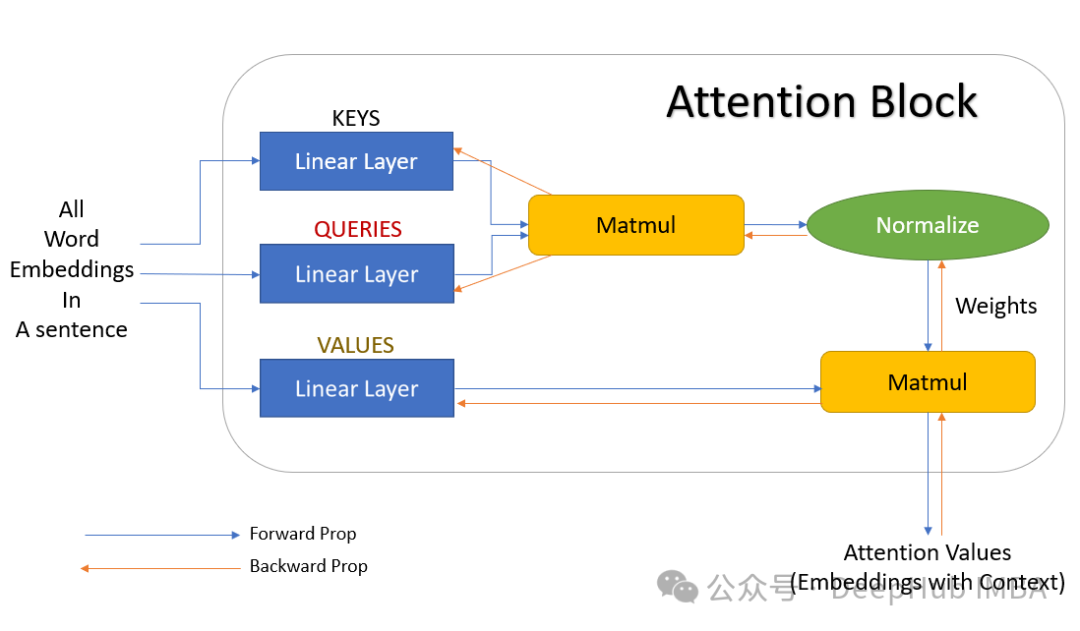

优化注意力层提升 Transformer 模型效率:通过改进注意力机制降低机器学习成本

本文将深入探讨在 PyTorch 生态系统中优化注意力层的多种技术路径,并将重点聚焦于那些在降低计算成本的同时能够保持注意力层精度的创新方法。

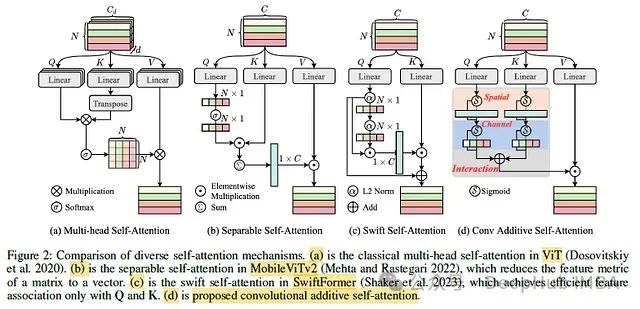

CAS-ViT:用于高效移动应用的卷积加法自注意力视觉Transformer

这是8月份再arxiv上发布的新论文,我们下面一起来介绍这篇论文的重要贡献

用于Transformer的6种注意力的数学原理和代码实现

Transformer 的出色表现让注意力机制出现在深度学习的各处。本文整理了深度学习中最常用的6种注意力机制的数学原理和代码实现。