TensorRT 和 ONNX Runtime 推理优化实战:10 个降低延迟的工程技巧

低延迟不靠黑科技就是一堆小优化叠起来:形状固定、减少拷贝、更好的 kernel、graph capture、运行时零意外。每个单拎出来可能只省几毫秒,但加起来用户就能感受到"快"。

jetson Orin nano部署 yolov8代码一(github)

jetson Orin nano部署yolov8 代码一

CUDA-BEVFusion环境部署与推理运行(Lidar_AI_Solution)

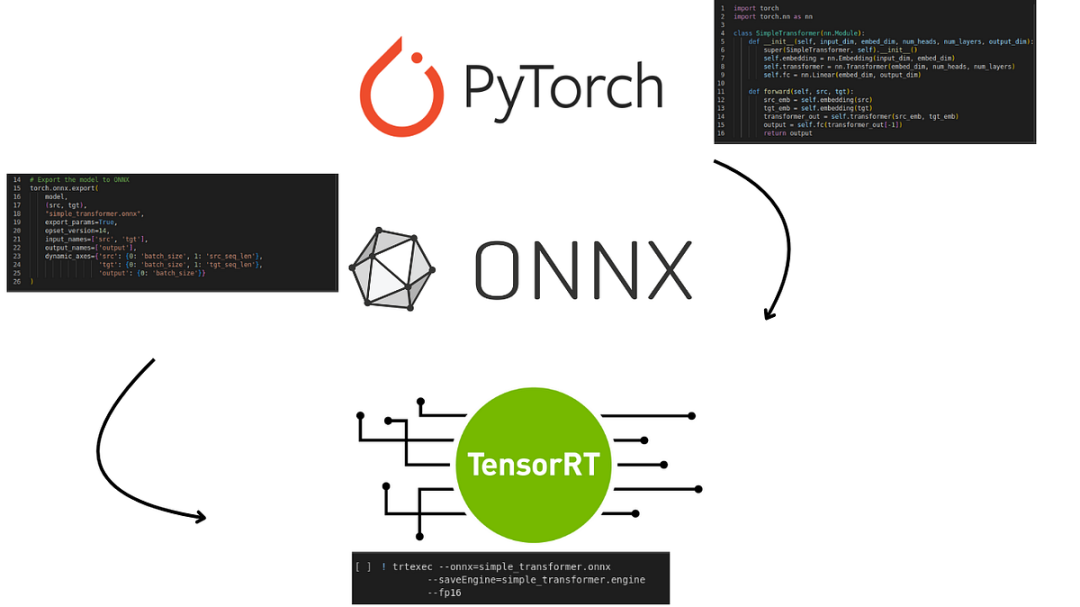

TensorRT可以在NVIDIA各种GPU硬件平台下运行的模型推理框架,将pytorch等框架训练好的模型转化为TensorRT的格式,利用推理引擎去运行该模型,提升模型运行速度。

使用TensorRT-LLM进行生产环境的部署指南

TensorRT-LLM是一个由Nvidia设计的开源框架,用于在生产环境中提高大型语言模型的性能。

TensorRt(1)安装和命令行测试

根据机器硬件配置,选择TensorRt版本,安装对应的cuda、cudnn版本,命令行trtexec进行简单测试。

基于Win10+TensorRT+C++部署Siamese图像相似度网络实战篇

博文中会给出本项目全套源码+运行文档+讲解文件的网盘链接,开发SDK接口,可同步迁移至其他C++项目或基于自定义训练网络进行部署。此教程可大幅度减少试错成本,一步一步跟着本文教学,若不成功,博主永不更文。首先给出实测性能指标:文末源码相关配置:开始教学第一步:将pth权重(自己训练好的或官方训练好的