提升长序列建模效率:Mamba+交叉注意力架构完整指南

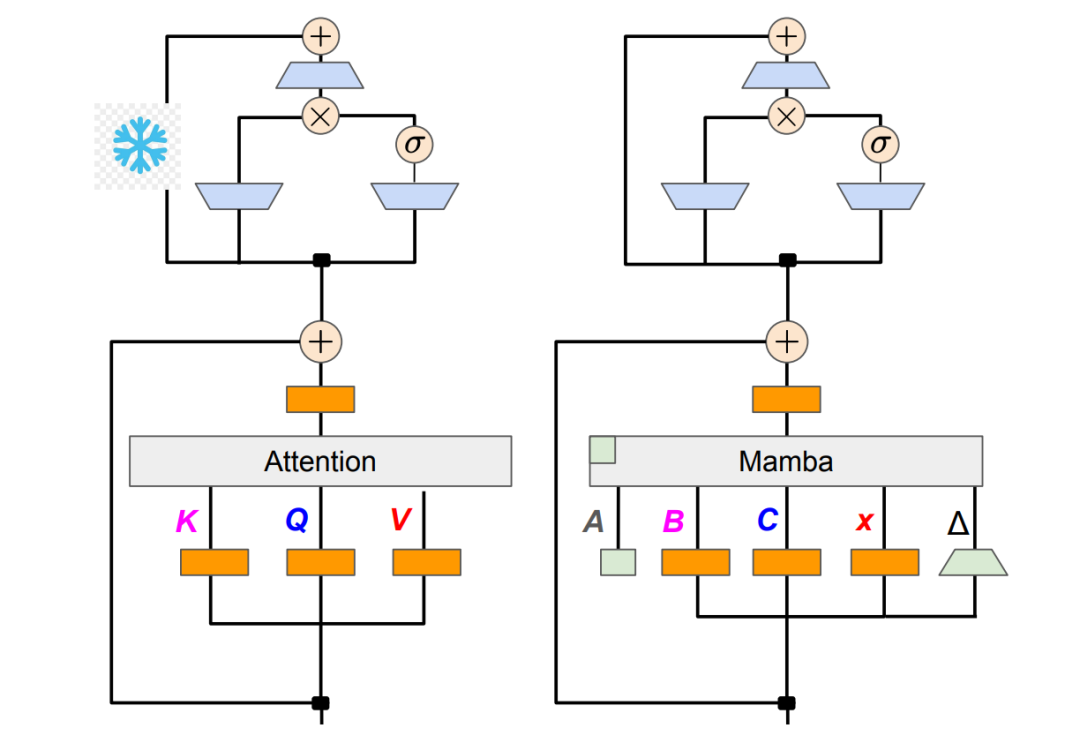

本文将深入分析Mamba架构中交叉注意力机制的集成方法与技术实现。

Window 下 Vim 环境安装踩坑问题汇总及解决方法

基础上,不绕过selective_scan_cuda进行 Vim 环境安装,这样可以获得和 Linux 一样的速度。注意,Vim (Vision Mamba)和 Vmamba (官方没有编译好的适用于Windows版本的 whl,因此需要用上述步骤来手动编译。由于此时没有绕过selective_sc

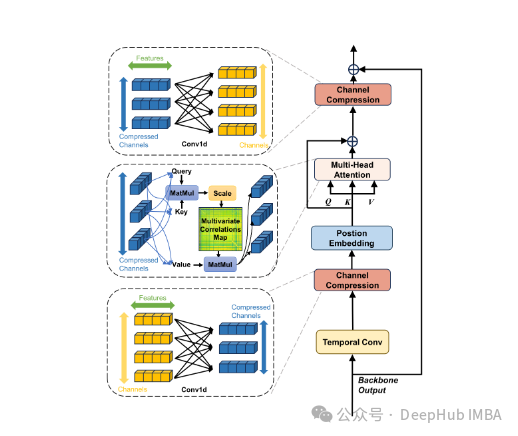

TSMamba:基于Mamba架构的高效时间序列预测基础模型

TSMamba通过其创新的架构设计和训练策略,成功解决了传统时间序列预测模型面临的多个关键问题。

《A Survey of Mamba》Mamba 最新综述!!(2024-08-05)

Transformers作为最具代表性之一架构,赋予了许多先进模型以力量,特别是那些包含数十亿参数的大型语言模型,在深度学习中扮演着基础角色。因此,在本综述中对最近与 Mamba 相关联 的研究进行深入调查,主要涵盖三个方向:基于 Mambas 的模式进步、使 Mambas 适应各类数据技巧和 Ma

VMamba 安装教程(无需更改base环境中的cuda版本)

下面分别是 CUDA 12.1 和 CUDA 11.8 两种环境的安装,由于此时 CUDA 的内核以及相关文件均安装在虚拟环境中,可以不考虑base环境里 CUDA 的版本。),但是有些问题无法解决,特此汇总。注意,即使base环境中安装的 CUDA 版本过低,也不影响 Mamba,Vim 以及 V

Window 下Mamba 环境安装踩坑问题汇总及解决方法 (无需绕过selective_scan_cuda)

将 anaconda环境下的 lib/python3.6/site-packages/torch/utils/cpp_extension.py文件里的[‘ninja’,‘-v’]改成[‘ninja’,‘–v’] 或者[‘ninja’,‘–version’] 是错误的做法,治标不治本。这是最基本的报

深入浅出一文图解Vision Mamba(ViM)

问题总结:遇见的问题可以参考这个链接,总结的比较全面。Mamba 环境安装踩坑问题汇总及解决方法关键就是下载和mamba_ssm,最好是下载离线的whl文件,然后再用pip进行安装。值得注意的一点就是要用官方项目里的mamba_ssm替换安装在conda环境里的mamba_ssm。2024年04月2

MambaOut:状态空间模型并不适合图像的分类任务

该论文探讨了Mamba架构(包含状态空间模型SSM)是否有必要用于视觉任务,如图像分类、目标检测和语义分割。通过实验证实了了Mamba在视觉识别任务中的效果,认为其不如传统的卷积和注意力模型。

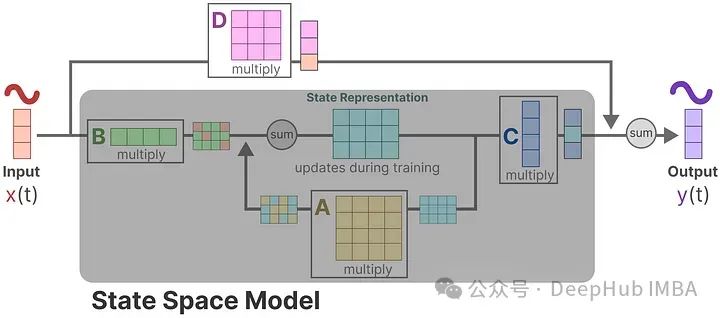

Mamba详细介绍和RNN、Transformer的架构可视化对比

在本篇文章中,通过将绘制RNN,transformer,和Mamba的架构图,并进行详细的对比,这样我们可以更详细的了解它们之间的区别。

极智AI | 解读Mamba对LLM基础架构的冲击 作者一定是科密吧

大家好,我是极智视界,本文分享一下 解读Mamba对LLM基础架构的冲击 作者一定是科密吧。希望我的分享能对你的学习有一点帮助。

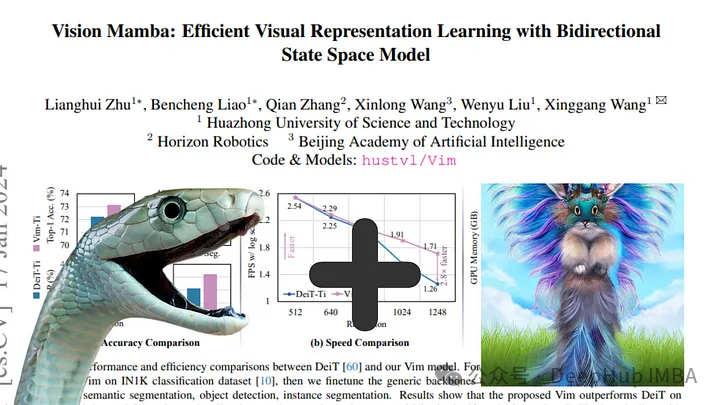

Vision Mamba:将Mamba应用于计算机视觉任务的新模型

Mamba是LLM的一种新架构,与Transformers等传统模型相比,它能够更有效地处理长序列。就像VIT一样现在已经有人将他应用到了计算机视觉领域