前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

** 🚀对毕设有任何疑问都可以问学长哦!**

** 大家好,这里是海浪学长计算机毕设专题,本次分享的课题是**

🎯基于深度学习的图像分类识别系统

项目背景

在信息化和数字化高速发展的时代,图像作为信息传递的重要载体,其分类识别技术正逐渐成为众多领域的研究热点。从安全监控到医疗影像分析,从自动驾驶到智能零售,图像分类识别系统均扮演着关键角色。然而,传统的图像分类识别方法受限于手工特征提取的不完备性和鲁棒性不足等问题。为此,本研究旨在开发一种基于深度学习的图像分类识别系统,利用深度神经网络自动学习图像中的层次化特征,提升分类识别的准确率和鲁棒性。这不仅能推动图像分类识别技术的进步,还为多个实际应用场景提供有力的技术支撑,具有重要的现实意义和应用价值。

数据集

针对图像分类识别系统的研究需求,我们发现现有的公开数据集往往难以覆盖所有需要识别的图像类别,或者其标注精度和数量不足以支撑深度模型的训练。因此,我们决定自制一个更贴合实际应用场景的数据集。首先,我们确定了图像分类的类别,如动物、植物、物品等,并在网络和现实生活中收集了大量的相关图像。随后,我们邀请专家团队对收集到的图像进行细致的标注工作,确保每张图像都有准确的类别标签。

在图像分类识别系统中,数据扩充尤为重要,因为它可以模拟真实世界中的图像变化,如光照、角度、尺度等。常见的数据扩充方法包括旋转、平移、缩放、裁剪、亮度调整等几何和颜色变换。这些变换可以应用于训练集图像,以生成更多不同形态和风格的新图像,从而增强模型的鲁棒性。

设计思路

自注意力

自注意力机制(Self-Attention)是一种用于处理序列数据的机制,它能够建立序列内部元素之间的关联性。自注意力机制通过计算每个元素与序列中其他元素之间的注意力权重来获得表示。这种注意力权重是根据元素之间的相似性计算得出的,相似性较高的元素会分配更高的注意力权重。

自注意力机制的计算过程可以分为三个步骤:查询(Query)、键(Key)和值(Value)。对于每个元素,通过将其与序列中所有其他元素进行比较,计算出一个注意力权重向量。这个注意力权重向量可以用来加权求和序列中所有元素的值,从而得到该元素的表示。通过对序列中所有元素进行类似的计算,可以得到整个序列的表示。

非重叠窗口中的自注意力机制是在自注意力机制的基础上引入了窗口的概念。在处理长序列时,为了减少计算复杂度和内存消耗,可以将序列划分为多个非重叠的窗口。每个窗口内部的元素之间进行自注意力计算,而窗口之间的元素则不进行注意力计算。这样可以有效地减少计算量,同时保持序列内部元素的关联性。通过引入非重叠窗口中的自注意力机制,可以在处理长序列数据时平衡计算效率和建模能力。窗口的大小可以根据具体任务和数据的特点进行调整,以达到最佳的性能和效果。

网络模型

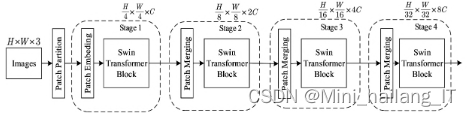

SwinTransformer是一种网络结构用于图像处理,它通过将图像划分为补丁并对其进行特征提取,最终输出高质量的特征表示。随着网络的深入,通过Patch Merging层减少补丁数量,同时进行特征图的下采样,以提高处理效率和特征表达能力。最终,SwinTransformer可以处理各种大小的图像,并生成具有高度区分性的特征表示。

SwinTransformerBlock是SwinTransformer网络结构中的一个模块,它包含了窗口内的多头注意力模块(W-MSA)和基于Shifted Window的多头自注意力模块(SW-MSA)。这两个模块经过层归一化后,通过多层感知机(MLP)输出结果。为了降低密集像素的自注意力计算复杂度,采用将其分割为小块并分别计算自注意力的方式。Shifted Window机制能够促进不同补丁之间的信息交流,增强特征的全局感知。而掩码机制则通过对移位后的补丁进行块标号并屏蔽补丁之外的信息,实现局部的自注意力,从而节省计算资源并提高模型的运行效率。

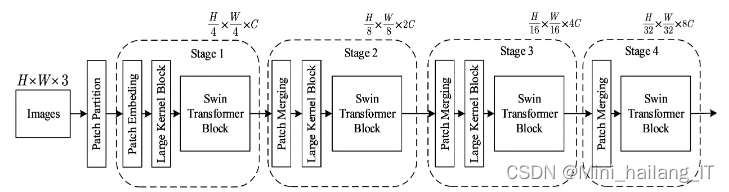

改进后的SwinTransformer网络结构引入了LargeKernelBlock模块,以在全局范围内增强信息交流。在图像处理后,经过LargeKernelBlock进行全局信息交流,然后进入SwinTransformerBlock进行补丁之间的信息交换。LargeKernelBlock位于stage1、stage2和stage3的SwinTransformerBlock之前,通过小幅扩大感受野,提高模型对输出特征的感知能力。该模块使用大核卷积在Shifted Window自注意力之前进行多轮的大核13×13卷积,以增加SwinTransformer中基于补丁自注意力的感受野。这样的设计不增加计算复杂度的同时,提升了模型的收敛速度和分类准确率。

实验环境

在本实验中,使用了PyTorch深度学习框架来实现SwinTransformer网络结构。Python版本为3.8,并且使用了NVIDIA RTX 3080显卡,具有10GB的显存。这样的硬件配置可以提供较高的计算性能和显存容量,以支持网络模型的训练和推理任务。PyTorch是一个广泛使用的深度学习框架,它提供了丰富的工具和函数,方便进行模型构建、训练和评估等任务。NVIDIA RTX 3080显卡是一款高性能的显卡,具备强大的计算能力和显存容量,可以加速深度学习任务的执行。这些硬件和软件环境的选择有助于保证SwinTransformer模型在训练和推理过程中的效率和准确性。

实验结果分析

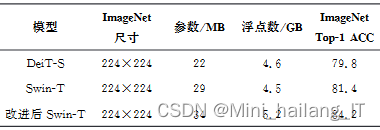

在实验中,针对小规模数据集,进行了400个epoch的训练,并采用了余弦退火学习率(CosineAnnealingLR)策略,初始学习率设置为0.000005,并使用AdamW优化器。每批数据的大小(Batch Size)设置为16,权重衰减(Weight Decay)设置为0.05。在相同的实验环境下,固定了随机种子,以确保对比实验中产生的随机数值相同。Swin-T模型和改进后的模型的损失曲线都呈现相似的平滑下降趋势。改进后的Swin-T模型与Swin-T模型的损失曲线下降幅度大致相同,但最终保持在较低的水平。改进后的Swin-T模型能够从图片中学习到更多的特征图信息,使得模型的预测值更接近真实值,从而提升了模型的性能。

相关代码示例:

import tensorflow as tf

# 定义模型

model = tf.keras.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(image_height, image_width, image_channels)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(num_classes, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True), metrics=['accuracy'])

# 加载数据集

train_images, train_labels = load_dataset('train')

test_images, test_labels = load_dataset('test')

# 训练模型

model.fit(train_images, train_labels, epochs=epochs, validation_data=(test_images, test_labels))

# 进行预测

predictions = model.predict(test_images)

# 打印预测结果

print("Predictions:", predictions)

print("True Labels:", test_labels)

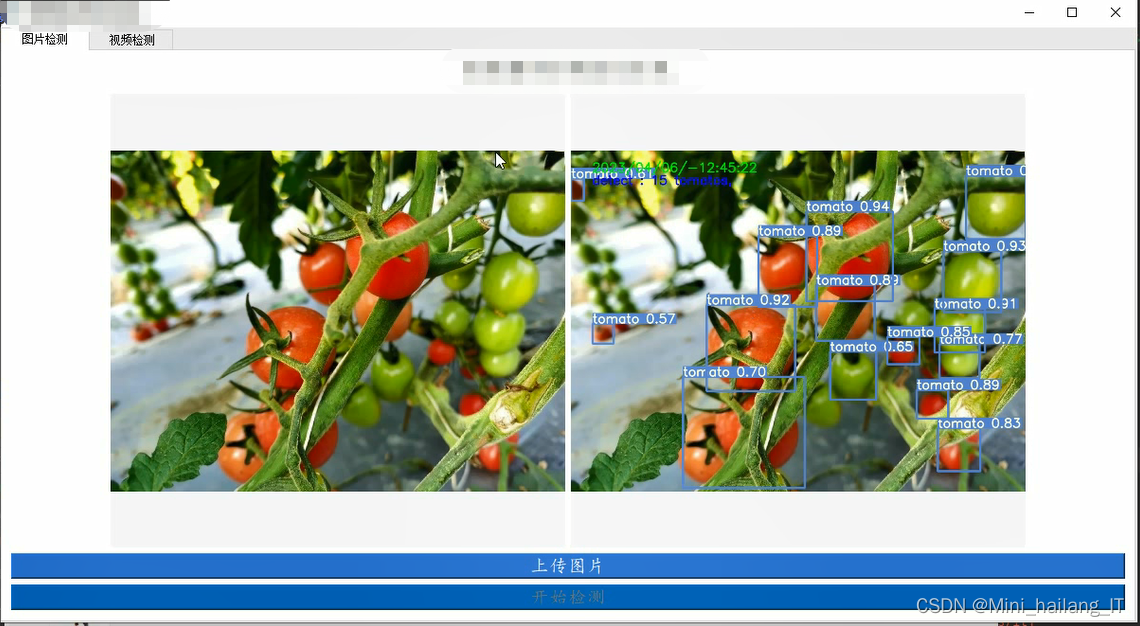

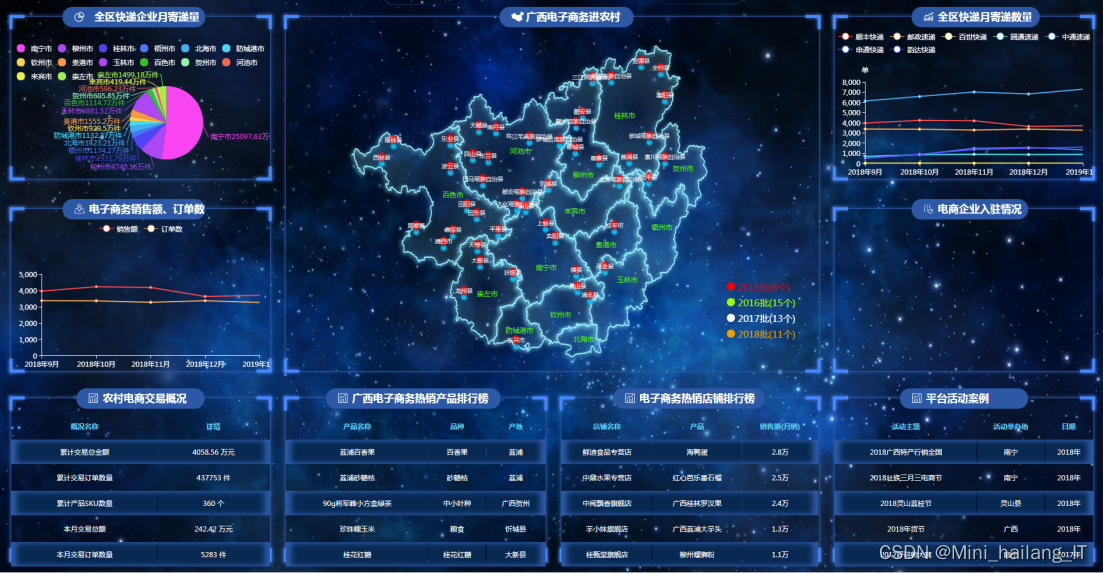

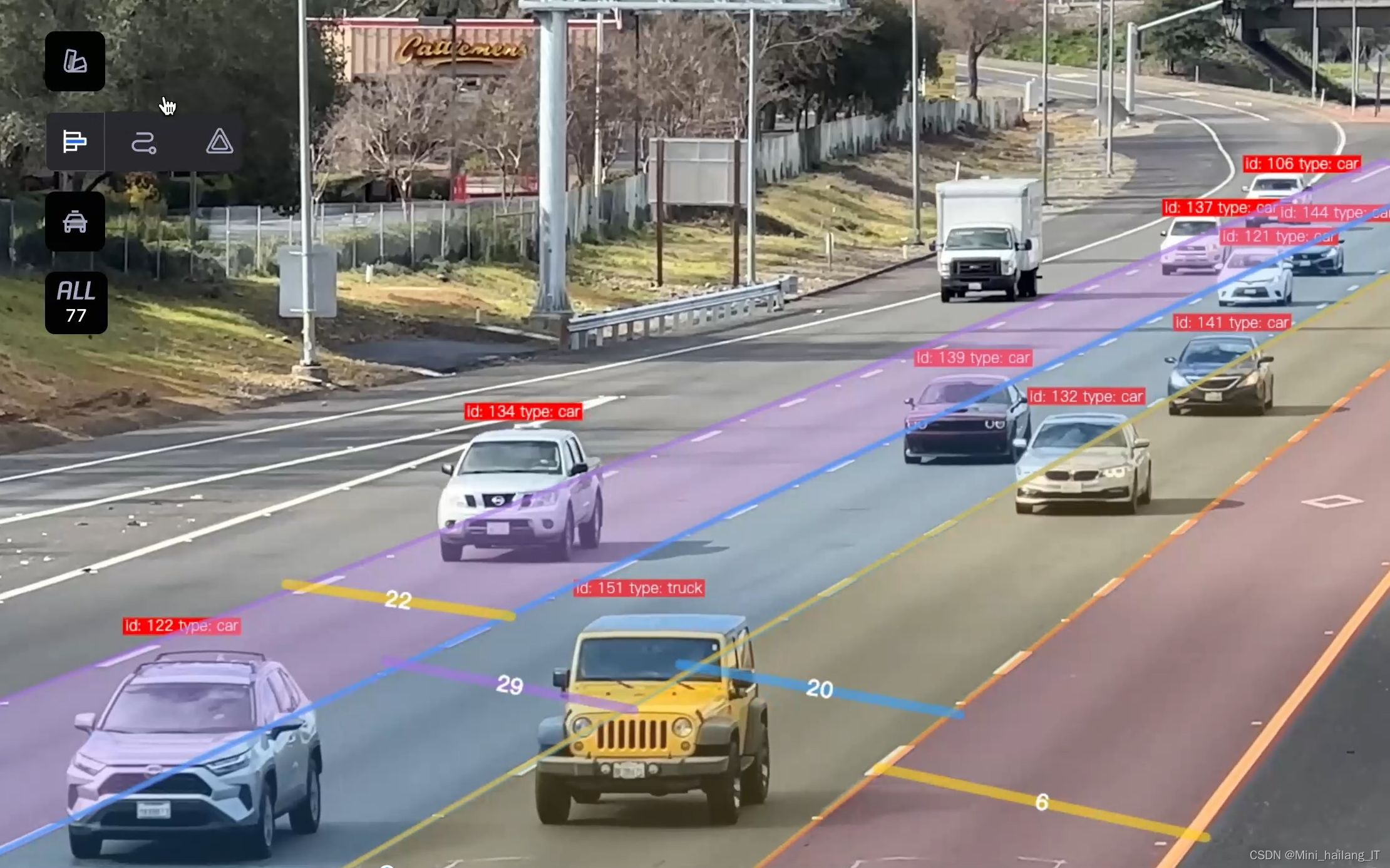

海浪学长项目示例:

更多帮助

本文转载自: https://blog.csdn.net/ASASASASASASAB/article/details/136265607

版权归原作者 Mini_hailang_IT 所有, 如有侵权,请联系我们删除。

版权归原作者 Mini_hailang_IT 所有, 如有侵权,请联系我们删除。