ctrl+alt切换定位到物理机/虚拟机

可以用物理机截图

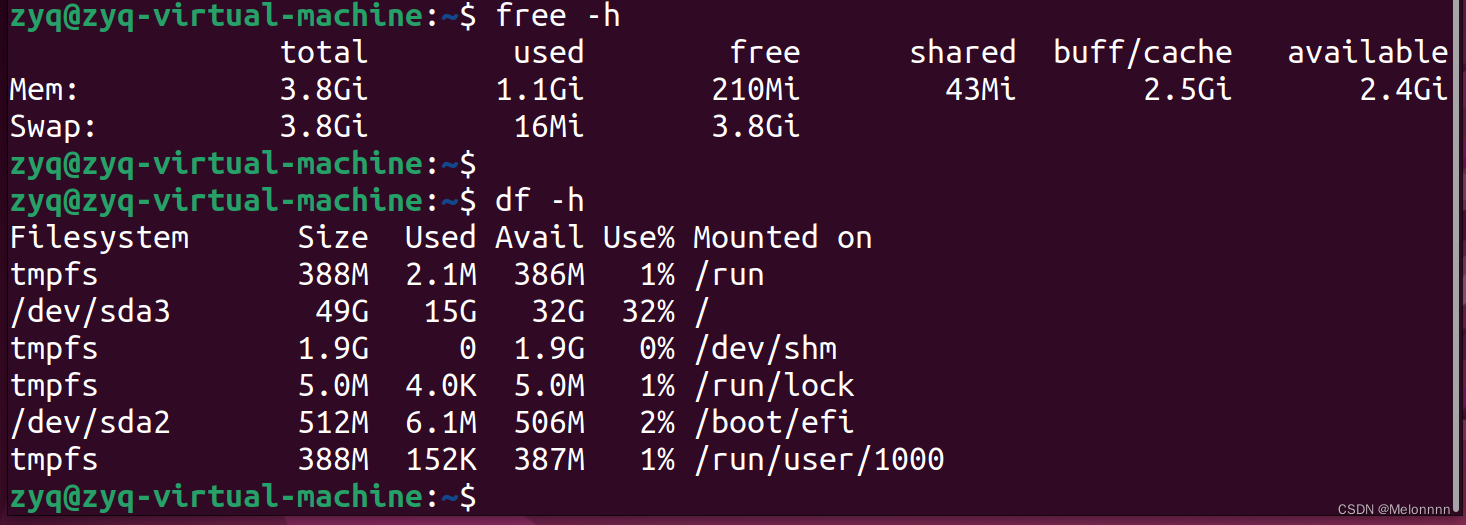

检查内存 free -h

检查磁盘空间 df -h

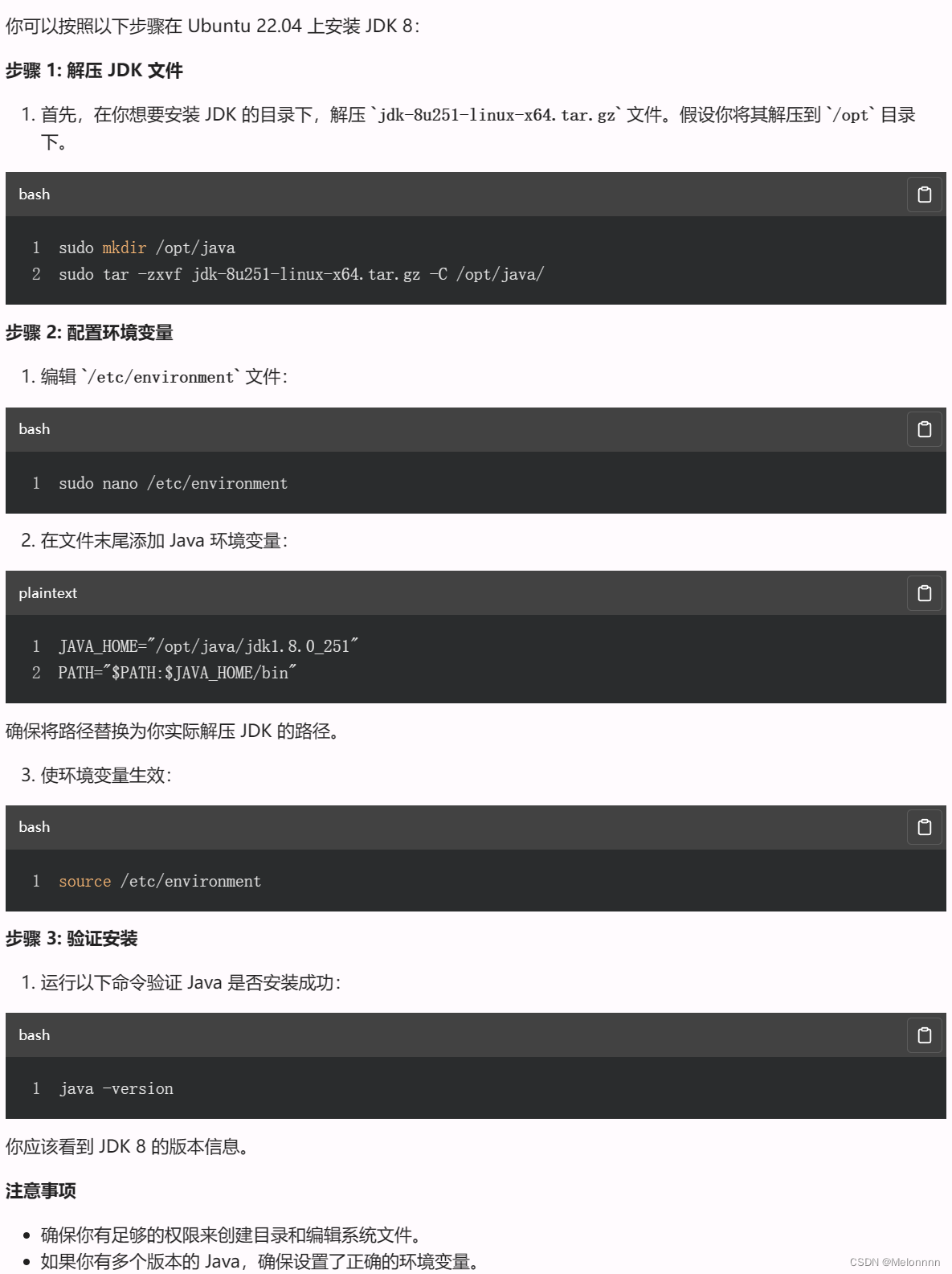

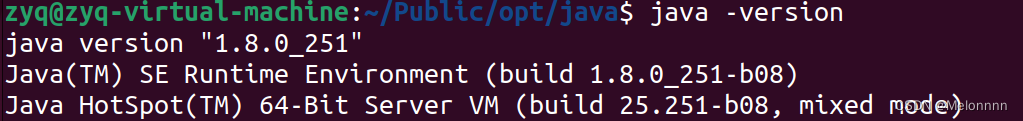

检查 Java 版本 java -version

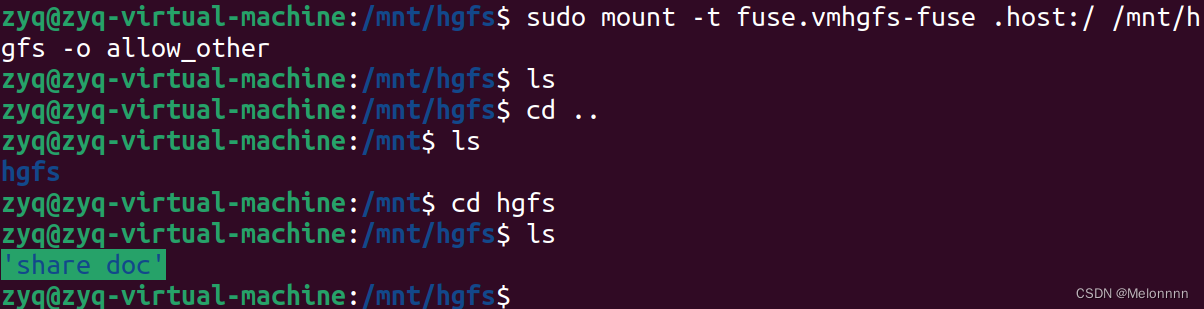

需要传输jdk文件,就需要共享文件夹:挂载操作,然后,再次进入 /mnt/hgfs 查看 (注意:挂载后必须要再次进入/mnt/hgfs才能查看到共享的文件夹)

验证安装成功

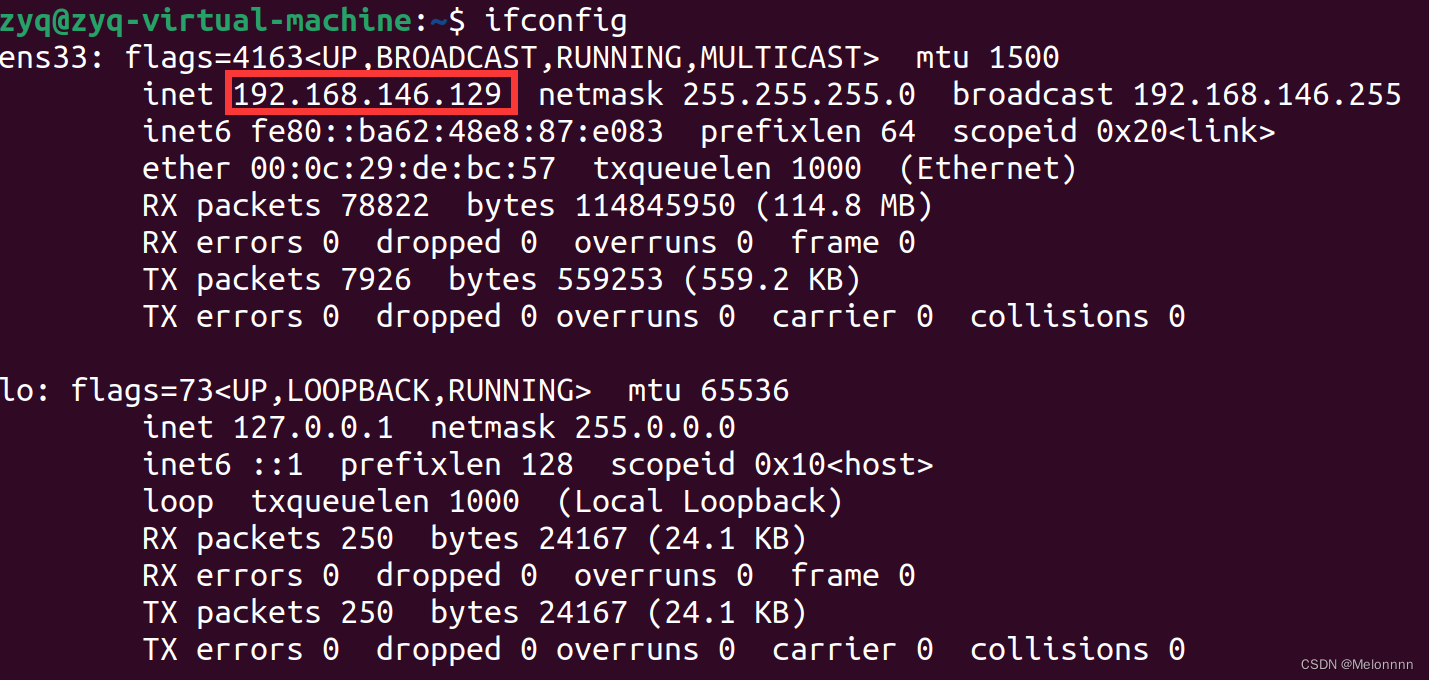

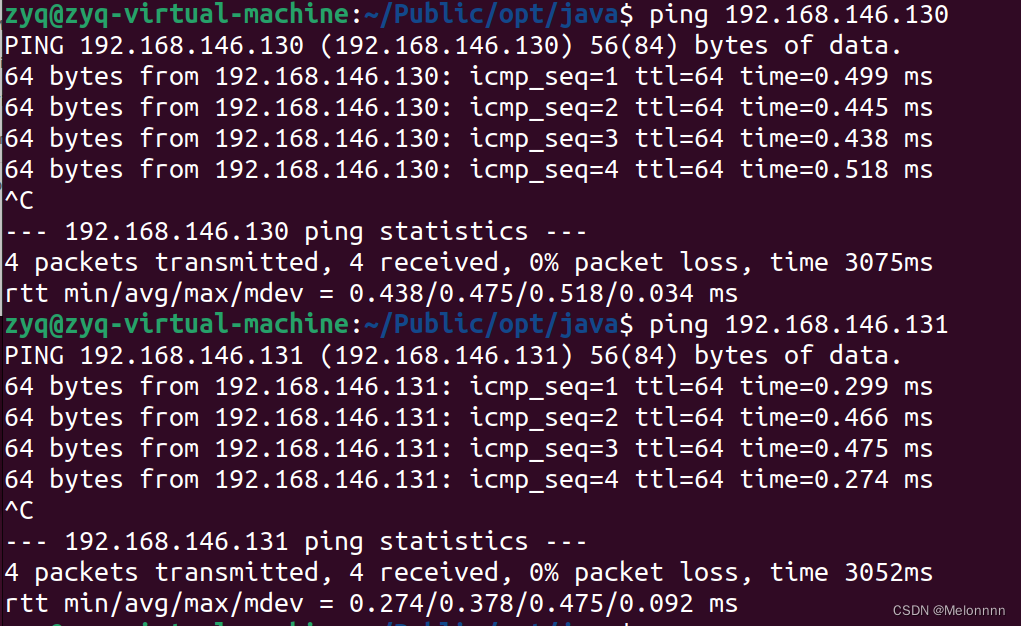

使用ip addr和hostname指令获得ip地址和主机名

192.168.146.129 zyq-virtual-machine

192.168.146.130 slave1-virtual-machine

192.168.146.131 slave2-virtual-machine

ip地址ping的通

nano ~/.bashrc

export JAVA_HOME=/Public/opt/java/jdk1.8.0_251/Public/opt/hadoop/hadoop-3.3.6

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=

export PATH=$PATH:$HADOOP_HOME/bin

source ~/.bashrc

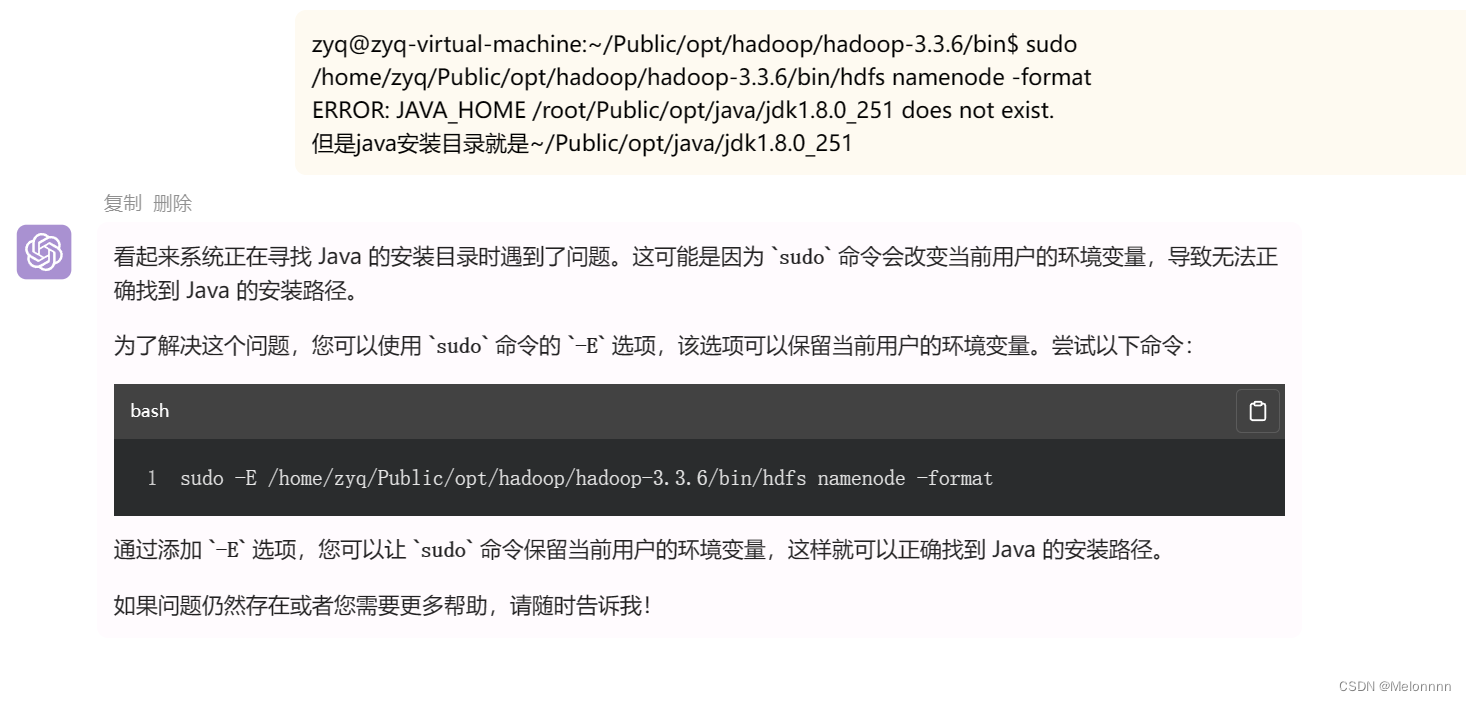

问题:

解压安装了jdk1.8.0_251这个版本的Java,但是查看版本

~/Public/opt/java$ java -version

openjdk version “11.0.21” 2023-10-17

解决:

首先,使用以下命令添加一个新的 Java 可选项:

sudo update-alternatives --install /usr/bin/java java /path/to/your/jdk1.8.0_251/bin/java 1

将 **`

/path/to/your/jdk1.8.0_251

`** 替换为你实际安装 Oracle JDK 1.8.0_251 的路径。

选择新的 Java 版本

然后,运行以下命令选择你刚刚添加的 Java 版本:

sudo update-alternatives --config java

sudo -i进入root模式

exit退出

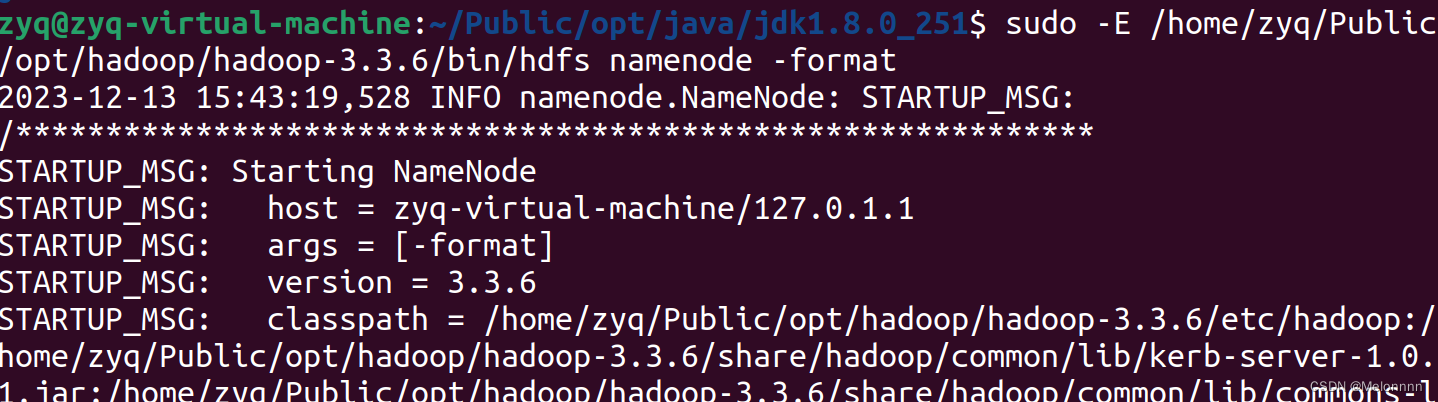

sudo -E /home/zyq/Public/opt/hadoop/hadoop-3.3.6/bin/hdfs namenode -format

格式化成功

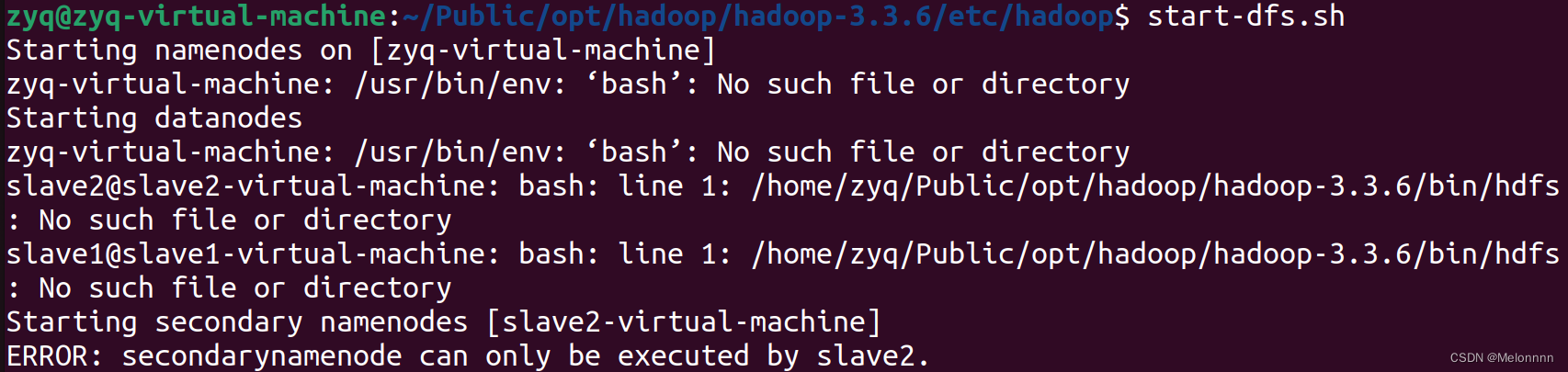

sudo -E /home/zyq/Public/opt/hadoop/hadoop-3.3.6/sbin/start-dfs.sh

、、、、、、、、、、、、、、、、、、、分割、、、、、、、、、、、、、、、、、、

、、、、、、、、、、、、、、、、、、、分割、、、、、、、、、、、、、、、、、、

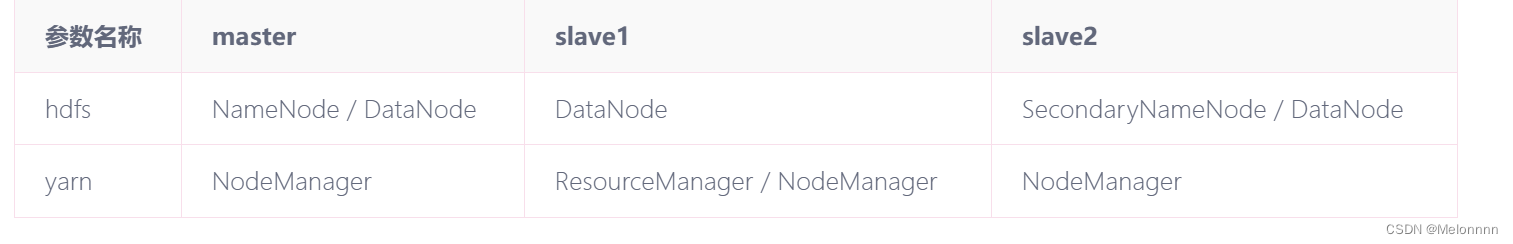

参考:Ubuntu搭建全分布式Hadoop - huhy - 博客园 (cnblogs.com)

按照这篇使用root不太容易出用户名的问题,但是如果第一次做真的有些迷惑迷茫。

重做

192.168.146.134 master

192.168.146.133 slave1

192.168.146.135 slave2

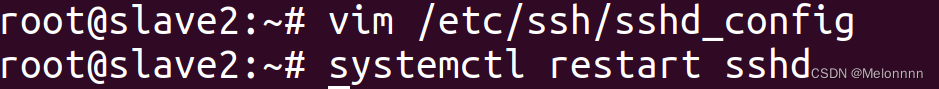

问题:ssh设置免密登录出现permission denied问题

解决:用root身份就要额外设置root密码,而不是用用户身份的密码,无语。网上怎么没人说。

并且要查看 /etc/ssh/sshd_config 中配置: PermitRootLogin,设为yes

问题:

master ping slave2不通;ssh slave2报错ssh: Could not resolve hostname slave2: Temporary failure in name resolution

解决:

重启systemd-resolved服务:有时重启服务可以解决临时的解析问题,

systemctl restart systemd-resolved

ps:copy 公钥私钥的时候别忘了ssh-copy-id 自己。

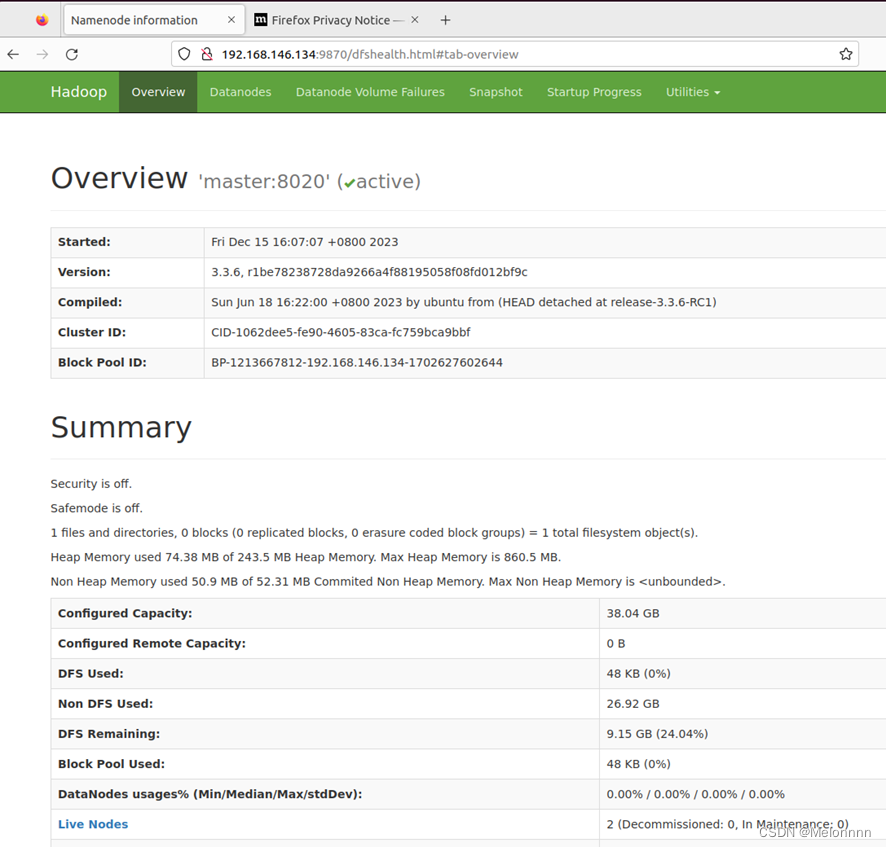

运行start_dfs.sh之后进入网址master ip:9870

可以通过stop_dfs.sh关闭

版权归原作者 Melonnnn 所有, 如有侵权,请联系我们删除。