以上为毕业设计最终成品,项目源代码已发布在gitee上,地址:https://gitee.com/hongbaoliu/dachuang_2022。

5.1 运行环境

5.1.1 爬虫脚本运行环境

python 3.10.1,使用python库 requests,os,re,time,json。跨平台的系统设计,测试环境为windows10,centos7。

5.1.2 大数据框架运行环境

Flume-1.7.0,hadoop-2.7.2,hive-1.2.1,sqoop-1.4.6,tez-0.9.1,mysql-5.5.47。系统安装运行在服务器上,服务器版本为centos7。

5.1.3 web平台运行环境

后端技术选型:Java8,springboot-2.2.2,mybatis-1.3.0,mysql-5.5.47。

前端技术选型:html,css,javascript,jquery-3.6.0,ajax,echarts。

5.2 运行过程

5.2.1 爬虫脚本运行测试

脚本使用python运行get_yq_info_txt.py,运行时创建数据结果保存的目录,定时每天下午六点执行该脚本,并将结果数据保存至此目录下。定时执行爬虫脚本结果如图5-1所示。

图5-1 定时执行脚本结果展示

图5-2 爬虫结果展示

数据爬取到windows系统本地文件后,服务器上使用lrzsz命令下载到dachuang_2022/data目录下,结果目录如图5-3所示。

图5-3 服务器数据存储目录

5.2.2 大数据框架运行测试

本框架首先启动hadoop,使用hadoop安装目录下的/sbin目录下的start-all.sh命令,hadoop启动命令截图如图5-4所示。

图5-4 hadoop启动截图

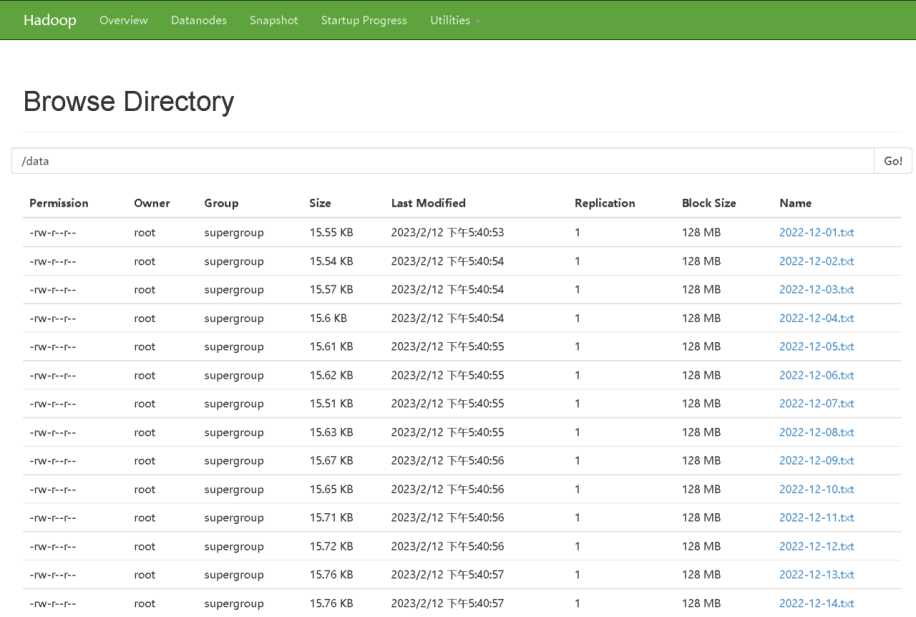

hadoop启动后执行flume配置文件file-flume-hdfs.conf收集并清洗数据文件到hdfs分布式文件存储系统上。flume运行结果如图5-5所示。

图5-5 flume运行结果

启动hive提取hdfs上的数据映射成ods层原始数据表,ods数据表如图5-6所示。

图5-6 hive原始数据表

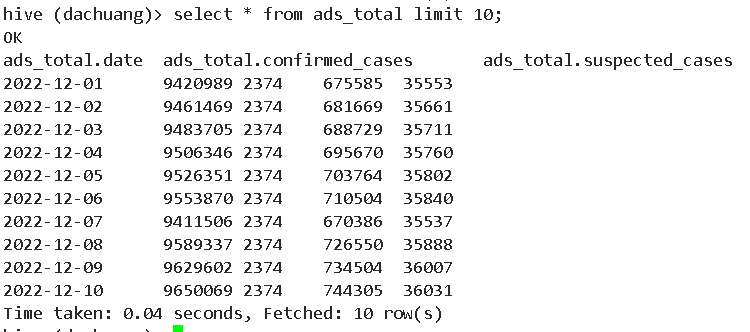

用户 hive再通过编写hql语句对原始数据表进行处理分析,得到结果数据表,结果数据表如图5-7所示。

图5-7 hive结果数据表

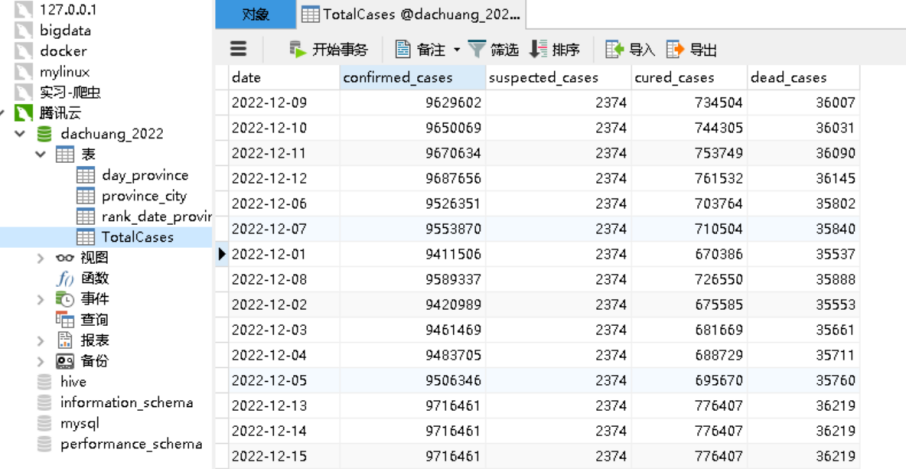

hive最终处理完成的结果数据表再通过sqoop迁移数据到mysql,如图5-8所示。

图5-8 mysql存储结果数据表

5.2.3 web平台运行测试

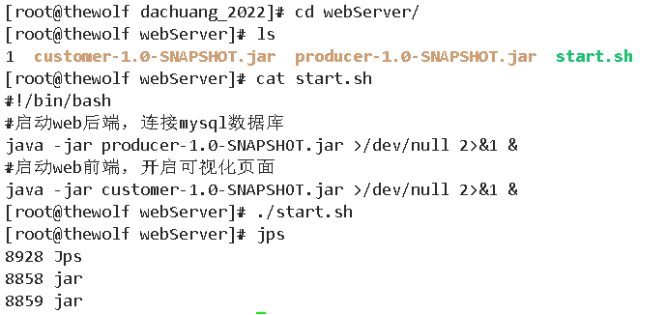

数据迁移到mysql数据库后,进入web平台设计模块。web启动命令如图5-9所示。

图5-9 web平台启动命令截图

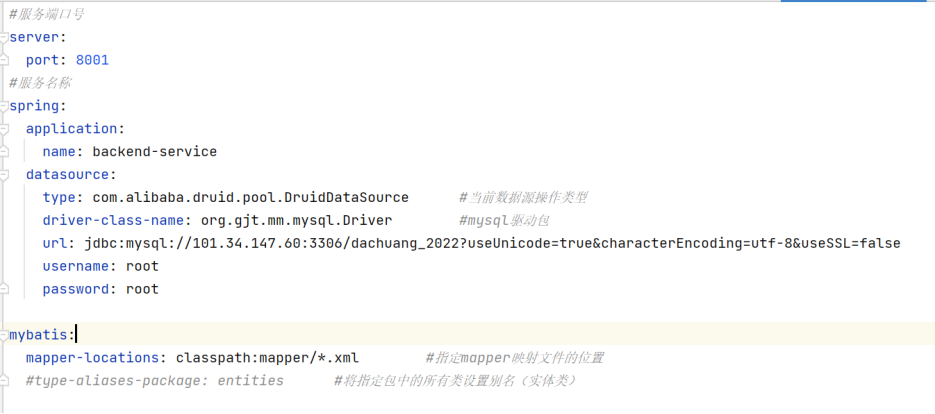

首先配置springboot的pom.xml导入mybatis,springboot相关依赖,其次配置application.yml,如图5-10所示。

图5-10 springboot application.yml配置文件

dao层创建持久化接口,编写mapper映射文件指定接口路径并访问数据库。

service层创建业务接口,编写实现类调用dao接口方法并编写业务逻辑。

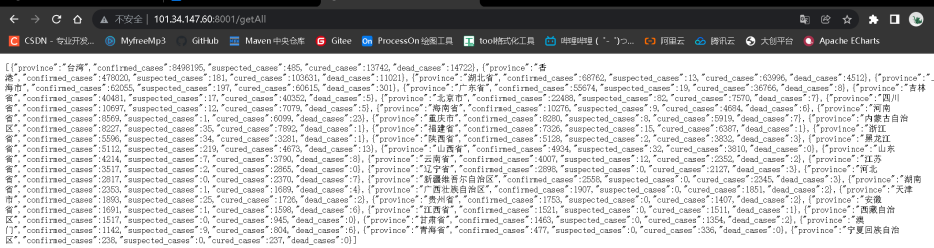

controller层创建控制接口,编写方法指定映射地址并调用service接口方法获取数据,将数据以json格式传递。如图5-11所示即web后端模块提供的api接口数据。

图5-11 web后端api接口访问结果截图

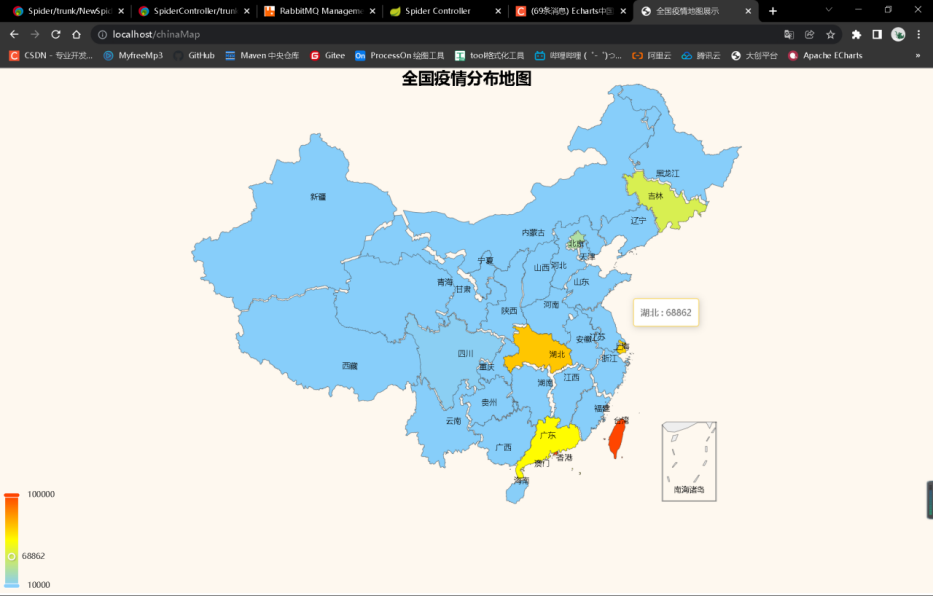

接下来进入web前端模块,首先配置前端技术所需的js文件,然后创建html文件渲染设计ui界面,使用ajax调用后端controller接口获取数据,并由echarts实现图表展示。如图5-12所示即为最终web可视化平台界面。

版权归原作者 The Wolfぅ 所有, 如有侵权,请联系我们删除。