基于 GPT2-Chinese 模型的中文文本生成项目,可用于中文生成任务。

当下市面上很多文本自动生成业务都是基于该模型二次开发的,可以很少有那种特定垂直领域的模型用于该领域的创作,也就导致大家在使用类似产品的时候会发现很多的问题,这种问题多数会导致写出来的文章前后逻辑不对,这个自己体会就知道了,真的能拿出来直接发么?答案肯定是不能。

真的,有买会员的那个钱都可以购买GPU资源自己训练自己的模型了。

因此也还是需要基于原有的算法二次开发自己的的垂直领域的内容,这就要用到开源的代码用自己的数据训练,当然了这个门槛也比较高,一方面是环境配置搭建就能劝退很多人,另一方面是这种业务比较吃硬件资源即GPU。

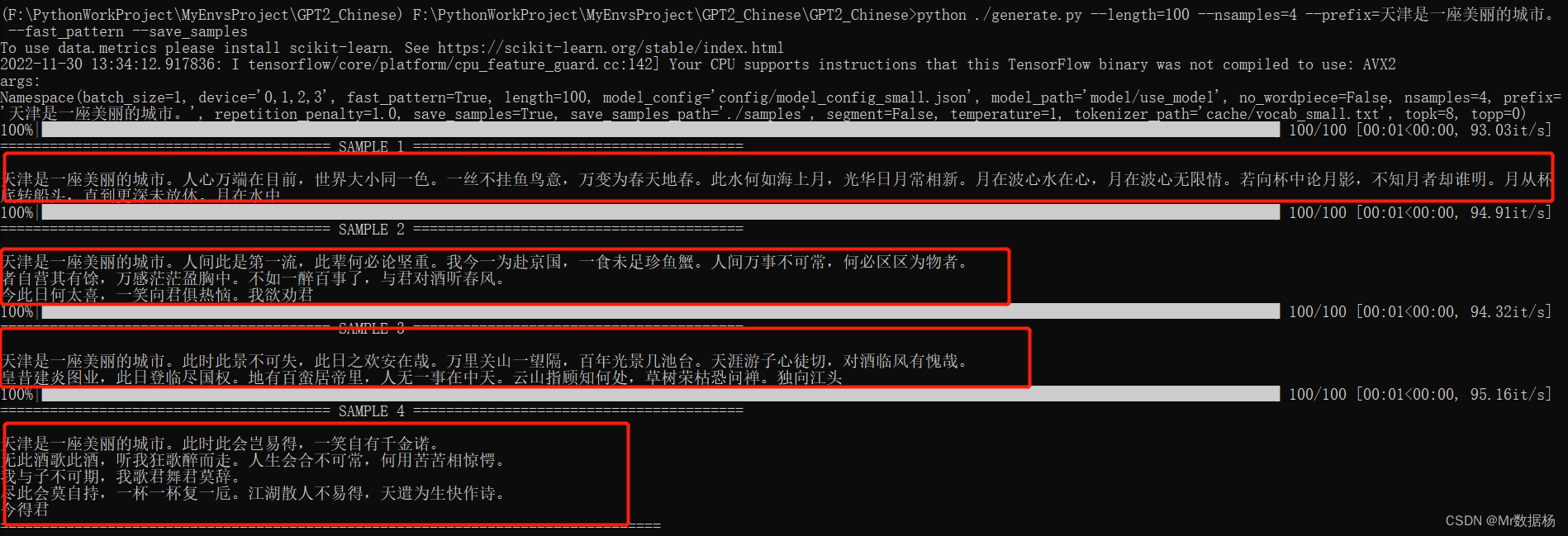

如果有不了解的小伙伴先来看一下实验结果,模型是一个通用的实例。

模型用的是开源预训练的模型,所以并没有那么强的垂直型,娱乐一下还是可以的,如果商用的话还是要自己抓取数据进行训练。

文章目录

版权归原作者 Mr数据杨 所有, 如有侵权,请联系我们删除。