Hadoop平台安装

- 实验一:Linux操作系统环境设置

实验环境 本实验所需之主要资源环境:资源环境 服务器集群 单节点,机器最低配置:双核 CPU、8GB 内存、100G 硬盘 运行环境 CentOS 7.4 服务和组件 服务和组件根据实验需求安装

实验过程

实验任务一:配置 Linux 系统基础环境

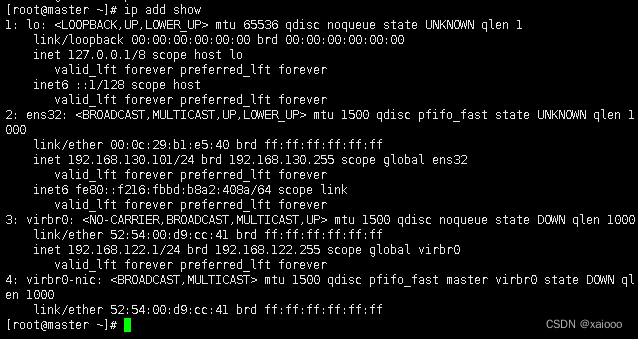

步骤一:查看服务器的 IP 地址 查看服务器的 IP 地址

[root@localhost ~]# ip add show

步骤二:设置服务器的主机名称

[root@localhost ~]# hostnamectl set-hostname master

[root@localhost ~]# bash

[root@master ~]# hostname master

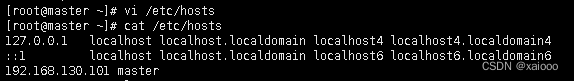

步骤三:绑定主机名与 IP 地址

[root@master ~]# vi /etc/hosts

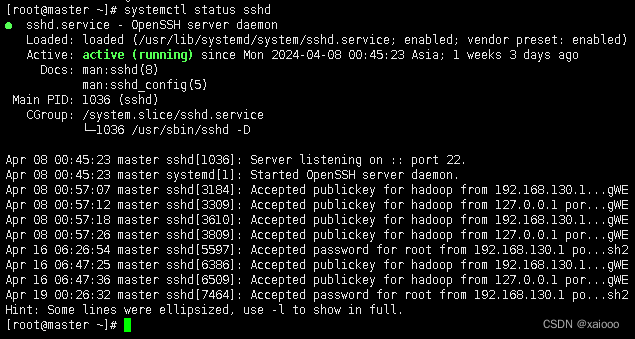

步骤四:查看 SSH 服务状态。

[root@master ~]# systemctl status sshd

步骤五:关闭防火墙 Hadoop

可以使用 Web 页面进行管理,但需要关闭防火墙,否则打不开 Web 页面。 同时不关闭防火墙也会造成 Hadoop 后台运行脚本出现莫名其妙的错误。 [root@master ~]# systemctl stop firewalld

[root@master ~]# systemctl status firewalld

[root@master ~]# systemctl disable firewalld

步骤六:创建 hadoop 用户

[root@master ~]# useradd hadoop

实验任务二:安装 JAVA 环境 .

步骤一:下载 JDK 安装包 JDK 安 装 包 需 要 在 Oracle 官 网 下 载

步骤二:卸载自带 OpenJDK

[root@master ~]# rpm -qa | grep java

[root@master ~]# rpm -e --nodeps javapackages-tools-3.4.1-11.el7.noarch

[root@master ~]# rpm -e --nodeps java-1.8.0-openjdk-1.8.0.352.b08- 2.el7_9.x86_64

[root@master ~]# rpm -qa | grep java 查看删除结果再次键入命令

java -version 出现以下结果表示删除功

[root@master ~]# java --version bash: java: 未找到命令

步骤三:安装 JDK Hadoop 2.7.1

安装命令如下,将安装包解压到/usr/local/src 目录下 ,注意/opt/software目录 下的软件包事先准备好。

[root@master ~]# tar -zxvf /opt/software/jdk-8u152-linux-x64.tar.gz -C /usr/local/src/

[root@master ~]# ls /usr/local/src/ jdk1.8.0_152

步骤四:设置 JAVA 环境变量

[root@master ~]# vi /etc/profile

在文件的最后增加如下两行: export JAVA_HOME=/usr/local/src/jdk1.8.0_152 export PATH=$PATH:$JAVA_HOME/bin

执行 source 使设置生效:

[root@master ~]# source /etc/profile

检查 JAVA 是否可用。

[root@master ~]# echo $JAVA_HOME /usr/local/src/jdk1.8.0_152

[root@master ~]# java -version

够正常显示 Java 版本则说明 JDK 安装并配置成功。

安装 Hadoop 软件

步骤一:安装 Hadoop 软件 安装命令如下,将安装包解压到/usr/local/src/目录下

[root@master ~]# tar -zxvf /opt/software/hadoop-2.7.1.tar.gz -C /usr/local/src/

[root@master ~]# ll /usr/local/src/

查看 Hadoop 目录,得知 Hadoop 目录内容如下:

[root@master ~]# ll /usr/local/src/hadoop-2.7.1/

share 解析: bin:此目录中存放 Hadoop、HDFS、YARN 和 MapReduce 运行程序和管理 软件。 23 etc:存放 Hadoop 配置文件。 include: 类似 C 语言的头文件 lib:本地库文件,支持对数据进行压缩和解压。 libexe:同 lib sbin:Hadoop 集群启动、停止命令 share:说明文档、案例和依赖 jar 包。 .

步骤二:配置 Hadoop 环境变量 和设置 JAVA 环境变量类似,修改/etc/profile 文件。

[root@master ~]# vi /etc/profile 在文件的最后增加如下两行: export HADOOP_HOME=/usr/local/src/hadoop-2.7.1 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin 执行 source 使用设置生效: [root@master ~]# source /etc/profile

检查设置是否生效: [root@master~]# hadoop

[root@master ~]# 出现上述 Hadoop 帮助信息就说明 Hadoop 已经安装好了。

步骤三:修改目录所有者和所有者组 上述安装完成的 Hadoop 软件只能让 root 用户使用,要让 hadoop 用户能够 运行 Hadoop 软件,需要将目录/usr/local/src 的所有者改为 hadoop 用户。

[root@master ~]# chown -R hadoop:hadoop /usr/local/src/

[root@master ~]# ll /usr/local/src/

实验三 安装单机版 Hadoop

实验任务一:配置 Hadoop 配置文件

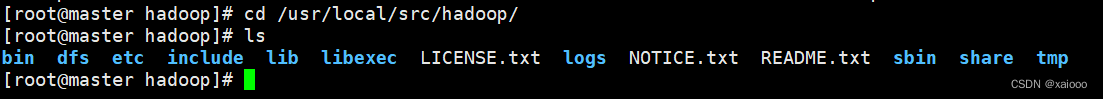

[root@master ~]# cd /usr/local/src/hadoop-2.7.1/

[root@master hadoop-2.7.1]# ls

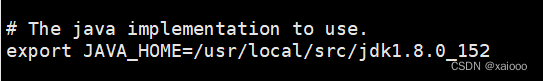

[root@master hadoop-2.7.1]# vi etc/hadoop/hadoop-env.sh

在文件中查找 export JAVA_HOME 这行,将其改为如下所示内容: export JAVA_HOME=/usr/local/src/jdk1.8.0_152 这样就设置好 Hadoop 的本地模式

实验任务二:测试 Hadoop 本地模式的运行 3.4.2.

步骤一: 切换到 hadoop 用户 使用 hadoop 这个用户来运行 Hadoop 软件。

[root@master hadoop-2.7.1]# su - hadoop

步骤二: 创建输入数据存放目录 将输入数据存放在~/input 目录(hadoop 用户主目录下的 input 目录中)。

[hadoop@master ~]$ mkdir ~/input

[hadoop@master ~]$ ls Input 3.4.2.3. 步骤三: 创建数据输入文件 创建数据文件 data.txt,将要测试的数据内容输入到 data.txt 文件中。

[hadoop@master ~]$ vi input/data.txt 输入如下内容,保存退出。

Hello World Hello Hadoop Hello Husan

Hadoop平台环境配置

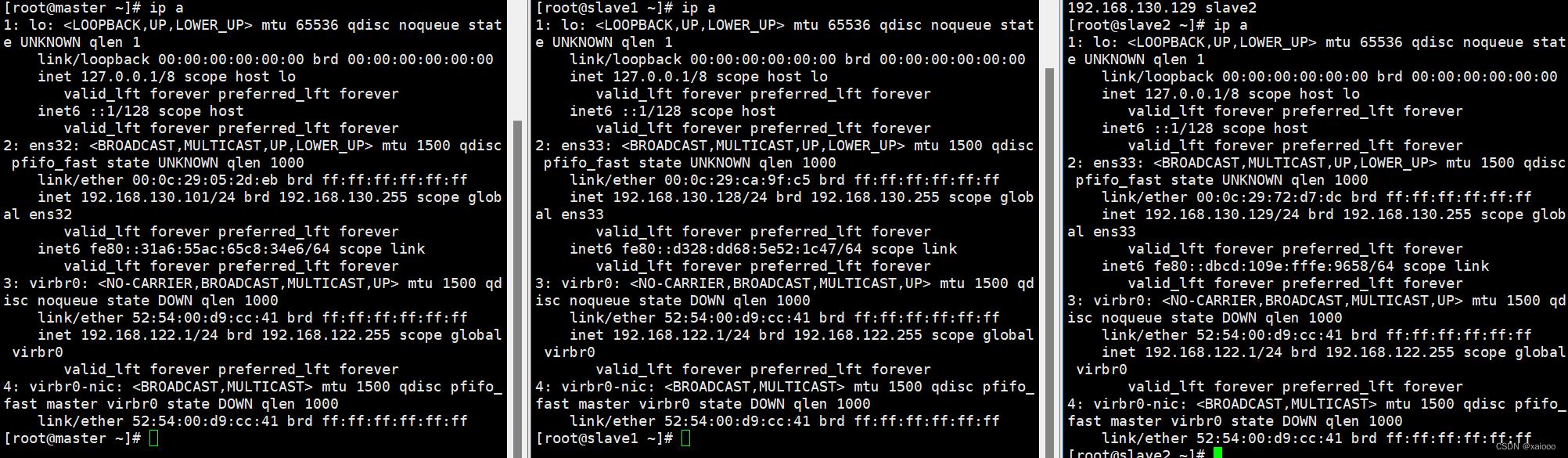

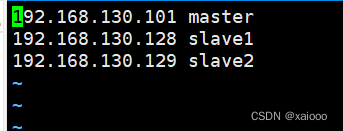

实验环境下集群网络配置 修改 slave1 机器主机名

[root@localhost ~]# hostnamectl set-hostname slave1

[root@localhost ~]# bash

[root@slave1 ~]# 修改 slave2 机器主机名

[root@localhost ~]# hostnamectl set-hostname slave2

[root@localhost ~]# bash

分别修改主机配置文件“/etc/hosts”, 在命令终端输入如下命令:

实验二 SSH 无密码验证配置生成 SSH 密钥

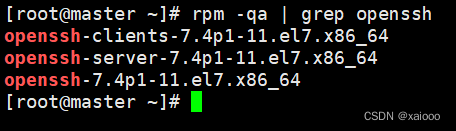

步骤一:每个节点安装和启动 SSH 协议 实现 SSH 登录需要 openssh 和 rsync 两个服务,一般情况下默认已经安装(如没有自行安 装),可以通过下面命令查看结果。

[root@master ~]# rpm -qa | grep openssh

[root@master ~]# rpm -qa | grep rsync

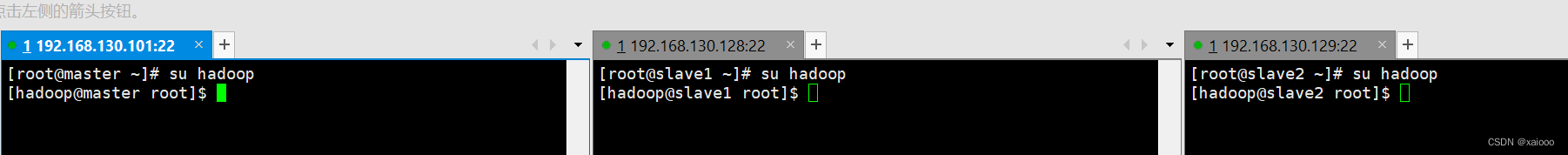

步骤二:切换到 hadoop 用户

步骤三:每个节点生成秘钥对

#在 master 上生成密钥

[hadoop@master ~]$ ssh-keygen -t rsa

#slave1 生成密钥

[hadoop@slave1 ~]$ ssh-keygen -t rsa

#slave2 生成密钥

[hadoop@slave2 ~]$ ssh-keygen -t rsa

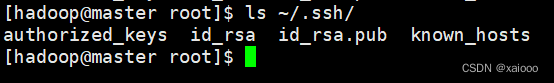

步骤四:查看"/home/hadoop/"下是否有".ssh"文件夹,且".ssh"文件下是否有两个刚 生产的无密码密钥对。

[hadoop@master ~]$ ls ~/.ssh/

步骤五:将 id_rsa.pub 追加到授权 key 文件中

#master

[hadoop@master ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@master ~]$ ls ~/.ssh/

#slave1 [hadoop@slave1 ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@slave1 ~]$ ls ~/.ssh/ authorized_keys id_rsa id_rsa.pub

#slave2 [hadoop@slave2 ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ ls ~/.ssh/ authorized_keys id_rsa id_rsa.pub

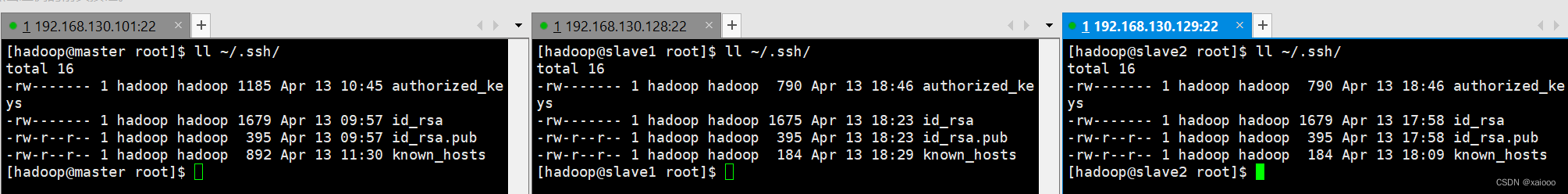

步骤六:修改文件"authorized_keys"权限 通过 ll 命令查看,可以看到修改后 authorized_keys 文件的权限为“rw-------”,表示所有者 可读写,其他用户没有访问权限。如果该文件权限太大,ssh 服务会拒绝工作,出现无法 通过密钥文件进行登录认证的情况。

#master [hadoop@master ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@master ~]$ ll ~/.ssh/

#slave1

[hadoop@slave1 ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@slave1 ~]$ ll ~/.ssh/

#slave2

[hadoop@slave2 ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ ll ~/.ssh/

步骤七:配置 SSH 服务 32 使用 root 用户登录,修改 SSH 配置文件"/etc/ssh/sshd_config"的下列内容,需要将该配 置字段前面的#号删除,启用公钥私钥配对认证方式。

#master [hadoop@master ~]$ su - root

[root@master ~]# vi /etc/ssh/sshd_config PubkeyAuthentication yes #找到此行,并把#号注释删除。

#slave1 [hadoop@ slave1 ~]$ su - root

[root@ slave1 ~]# vi /etc/ssh/sshd_config PubkeyAuthentication yes #找到此行,并把#号注释删除。

#slave2 [hadoop@ slave2 ~]$ su - root

[root@ slave2 ~]# vi /etc/ssh/sshd_config PubkeyAuthentication yes #找到此行,并把#号注释删除。

步骤八:重启 SSH 服务 设置完后需要重启 SSH 服务,才能使配置生效。

[root@master ~]# systemctl restart sshd

步骤九:切换到 hadoop 用户

[root@master ~]# su - hadoop

[hadoop@master ~]$

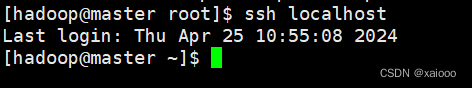

步骤十:验证 SSH 登录本机 在 hadoop 用户下验证能否嵌套登录本机,若可以不输入密码登录,则本机通过密钥登录 认证成功。

[hadoop@master ~]$ ssh localhost

[hadoop@master ~]$ 首次登录时会提示系统无法确认 host 主机的真实性,只知道它的公钥指纹,询问用户是 否还想继续连接。需要输入“yes”,表示继续登录。第二次再登录同一个主机,则不会再 出现该提示,可以直接进行登录。 读者需要关注是否在登录过程中是否需要输入密码,不需要输入密码才表示通过密钥认 证成功。

交换 SSH 密钥

步骤一:将 Master 节点的公钥 id_rsa.pub 复制到每个 Slave 点 hadoop 用户登录,通过 scp 命令实现密钥拷贝。

[hadoop@master ]$ scp ~/.ssh/id_rsa.pub hadoop@slave1:/

[hadoop@master ]$ scp ~/.ssh/id_rsa.pub hadoop@slave2:/

首次远程连接时系统会询问用户是否要继续连接。需要输入“yes”,表示继续。因为目 前尚未完成密钥认证的配置,所以使用 scp 命令拷贝文件需要输入slave1 节点 hadoop 用户的密码。

步骤二:在每个 Slave 节点把 Master 节点复制的公钥复制到authorized_keys 文件 hadoop 用户登录 slave1 和 slave2 节点,执行命令。

[hadoop@slave1 ]$ cat ~/id_rsa.pub >>/.ssh/authorized_keys

[hadoop@slave2 ]$ cat ~/id_rsa.pub >>/.ssh/authorized_keys

步骤三:在每个 Slave 节点删除 id_rsa.pub 文件

[hadoop@slave1 ~]$ rm -rf ~/id_rsa.pub

[hadoop@slave2 ~]$ rm -rf ~/id_rsa.pub

步骤四:将每个 Slave 节点的公钥保存到 Master

(1)将 Slave1 节点的公钥复制到 Master

[hadoop@slave1 ]$ scp ~/.ssh/id_rsa.pub hadoop@master:/

[hadoop@slave1 ~]$

(2)在 Master 节点把从 Slave 节点复制的公钥复制到 authorized_keys 文件

[hadoop@master ]$ cat ~/id_rsa.pub >>/.ssh/authorized_keys

(3)在 Master 节点删除 id_rsa.pub 文件 [hadoop@master ~]$ rm -rf ~/id_rsa.pub

(4)将 Slave2 节点的公钥复制到 Master

[hadoop@slave2 ]$ scp ~/.ssh/id_rsa.pub hadoop@master:/

[hadoop@slave2 ~]$

(5)在 Master 节点把从 Slave 节点复制的公钥复制到 authorized_keys 文件

[hadoop@master ]$ cat ~/id_rsa.pub >>/.ssh/authorized_keys

(6)在 Master 节点删除 id_rsa.pub 文件

[hadoop@master ~]$ rm -rf ~/id_rsa.pub

验证 SSH 无密码登录

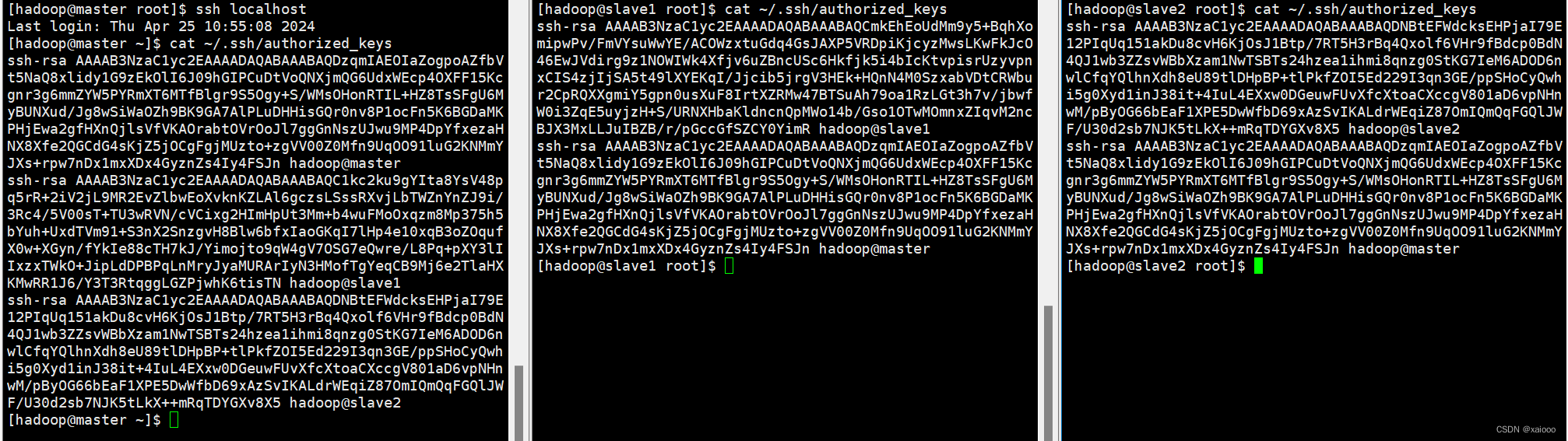

步骤一:查看 Master 节点 authorized_keys 文件

[hadoop@master ~]$ cat ~/.ssh/authorized_keys

[hadoop@slave1 ~]$ cat ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ cat ~/.ssh/authorized_keys

步骤二:验证 Master 到每个 Slave 节点无密码登录 hadoop 用户登录 master 节点,执行 SSH 命令登录 slave1 和 slave2 节点。可以观察 到不需要输入密码即可实现 SSH 登录。

[hadoop@master ~]$ ssh slave1

[hadoop@slave1 ~]$

[hadoop@master ~]$ ssh slave2

[hadoop@slave2 ~]$

步骤三:验证两个 Slave 节点到 Master 节点无密码登录

[hadoop@slave1 ~]$ ssh master

[hadoop@master ~]$

[hadoop@slave2 ~]$ ssh master

[hadoop@master ~]$

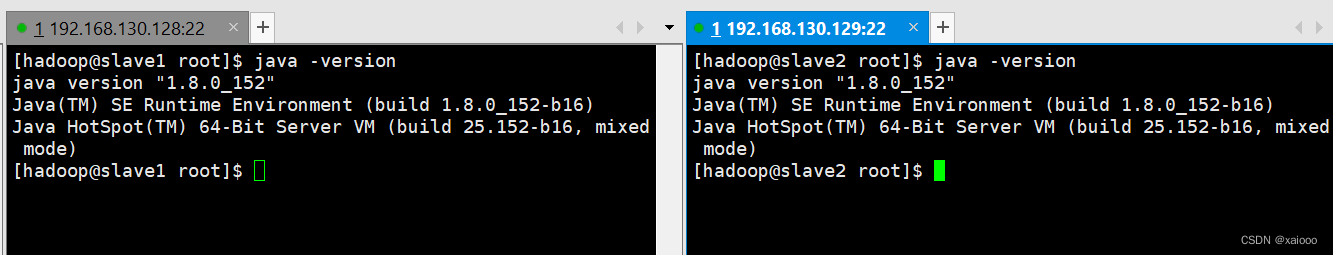

步骤四:配置两个子节点slave1、slave2的JDK环境。

[root@master ~]# cd /usr/local/src/

[root@master src]# ls hadoop-2.7.1 jdk1.8.0_152

[root@master src]# scp -r jdk1.8.0_152 root@slave1:/usr/local/src/

[root@master src]# scp -r jdk1.8.0_152 root@slave2:/usr/local/src/

#slave1 [root@slave1 ~]# ls /usr/local/src/ jdk1.8.0_152

#slave2 [root@slave2 ~]# ls /usr/local/src/ jdk1.8.0_152

[root@slave1 ~]# vi /etc/profile

#此文件最后添加下面两行 export JAVA_HOME=/usr/local/src/jdk1.8.0_152 37 export PATH=$PATH:$JAVA_HOME/bin

[root@slave2 ~]# vi /etc/profile

#此文件最后添加下面两行 export JAVA_HOME=/usr/local/src/jdk1.8.0_152 export PATH=$PATH:$JAVA_HOME/bin

[root@slave1 ~]# source /etc/profile

[root@slave1 ~]# java -version

[root@slave2 ~]# source /etc/profile

[root@slave2 ~]# java -version

二、Hadoop集群运行

1、Hadoop文件参数配置

实验一:hadoop 全分布配置

实验任务一:在 Master 节点上安装 Hadoop

- 将 hadoop-2.7.1 文件夹重命名为 Hadoop

[root@master ~]# cd /usr/local/src/

[root@master src]# mv hadoop-2.7.1 hadoop

[root@master src]# ls

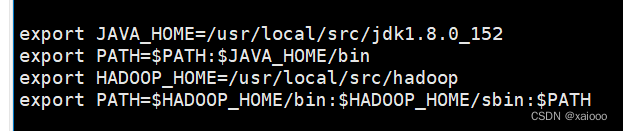

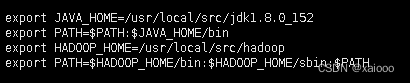

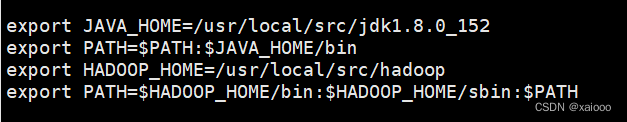

配置 Hadoop 环境变量

[root@master src]# vim /etc/profile

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

3.使配置的 Hadoop 的环境变量生效

[root@master src]# su - hadoop

[hadoop@master ~]$ source /etc/profile

[hadoop@master ~]$ exit 登出

- 执行以下命令修改 hadoop-env.sh 配置文件

[root@master src]# cd /usr/local/src/hadoop/etc/hadoop/

[root@master hadoop]# vim hadoop-env.sh

#修改以下配置

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

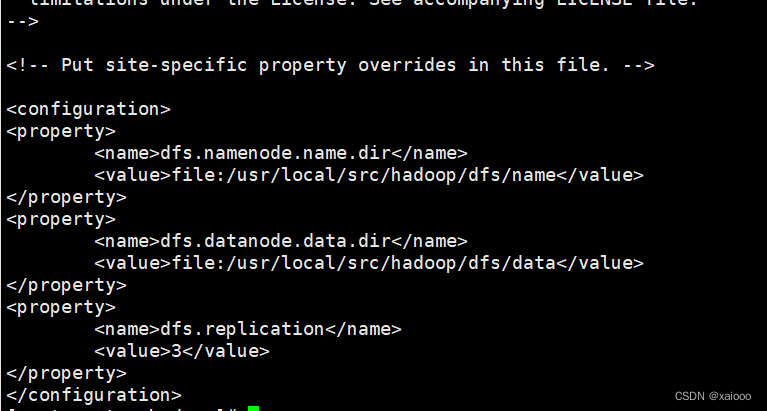

任务二:配置 hdfs-site.xml 文件参数

[root@master hadoop]# vim hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/src/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/src/hadoop/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

[root@master hadoop]# tail -n 14 hdfs-site.xml

配置文件主要参数 序号 参数名 默认值 参数解释

1 dfs.namenode.secondary .httpaddress 0.0.0.0:50090 定义 HDFS 对应的 HTTP 服务器 地址 和端口

2 dfs.namenode.name.dir file://${hadoop.tmp.dir} /dfs/name 定义 DFS 的名称节点在本地文 件系 统的位置

3 dfs.datanode.data.dir file://${hadoop.tmp.dir} /dfs/data 定义 DFS 数据节点存储数据块 时存 储在本地文件系统的位置

4 dfs.replication 3 缺省的块复制数量

5 dfs.webhdfs.enabled true 是否通过 http 协议读取 hdfs 文 件, 如果选是,则集群安全性 较差

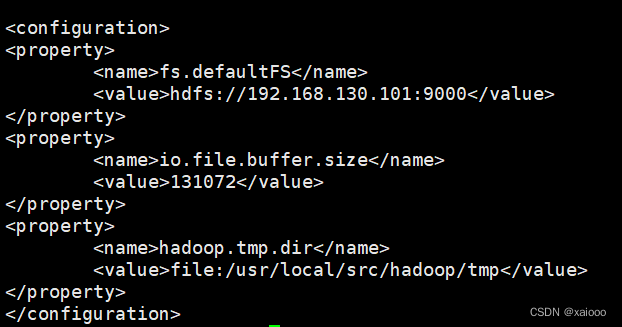

任务三:配置 core-site.xml 文件参数

[root@master hadoop]# vim core-site.xml

#编辑以下内容

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.130.101:9000</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/src/hadoop/tmp</value>

</property>

</configuration>

[root@master hadoop]# tail -n 14 core-site.xml

任务四:配置 mapred-site.xml

[root@master hadoop]# pwd

/usr/local/src/hadoop/etc/hadoop

[root@master hadoop]# cp mapred-site.xml.template mapred-site.xml

[root@master hadoop]# vim mapred-site.xml

#添加以下配置

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

</configuration>

[root@master hadoop]# tail -n 14 mapred-site.xml

mapred-site.xml 配置文件主要参数 序号 参数名 默认值 参数解释

1 mapreduce.framework.name local 取值 local、classic 或 yarn 其中之 一,如果不是 yarn,则不会使用 YARN 集 群来实现资源的分配

2 mapreduce.jobhistory.address 0.0.0.0:10020 定义历史服务器的地址和 端口, 通过历史服务器查 看已经运行完 的 Mapreduce 作业记录

3 mapreduce.jobhistory.webapp.addres 0.0.0.0:19888 定义历史服务器 web 应用 访问的 地址和端口

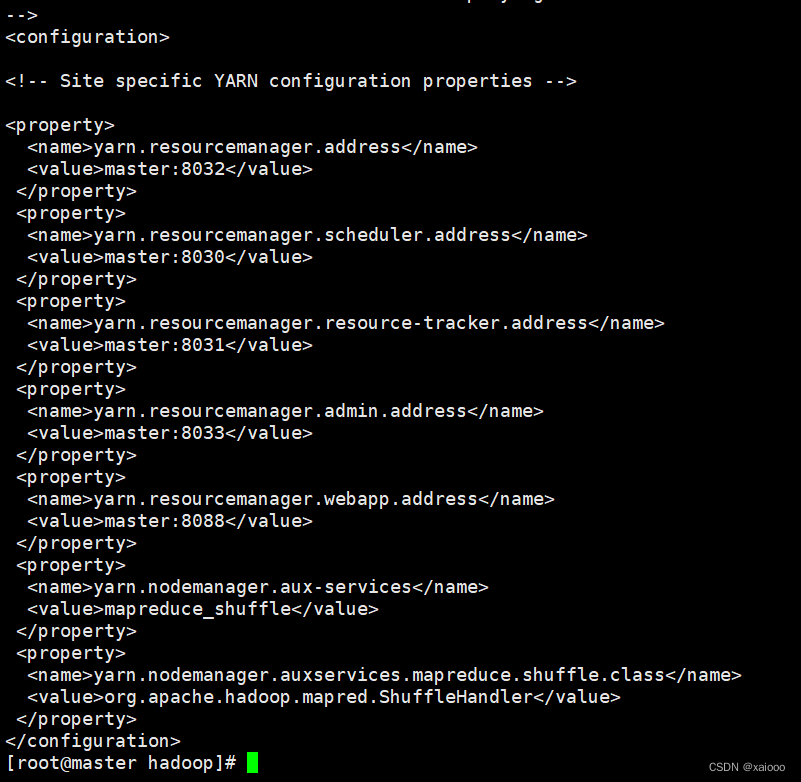

任务五:配置 yarn-site.xml

[root@master hadoop]# vim yarn-site.xml #添加以下配置

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.address</name>

<value>master:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:8088</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

[root@master hadoop]# tail -n 32 yarn-site.xml

参数解释

1 yarn.resourcemanager.addre ss 0.0.0.0:8032 ResourceManager 提供给客户端访 问 的地址。客户端通过该地址向 RM 提交 应用程序,杀死应用程序 等

2 yarn.resourcemanager.sched uler.address 0.0.0.0:8030 定义历史服务器的地址和端口,通 过 历史服务器查看已经运行完的 Mapreduce 作业记录

3 yarn.resourcemanager.resou rcetracker.address 0.0.0.0:8031 ResourceManager 提供给 NodeManager 的地址。 NodeManager 通过该地址向 RM 汇报心跳,领取任务等

4 yarn.resourcemanager.admin .address 0.0.0.0:8033 ResourceManager 提供给管理员的 访 问地址。管理员通过该地址向 RM 发送 管理命令等

5 yarn.resourcemanager.webap p.address 0.0.0.0:8088 ResourceManager 对 web 服务提 供地 址。用户可通过该地址在浏 览器中查 看集群各类信息

6 yarn.nodemanager.auxservices org.apache.hadoop. mapred.ShuffleHand ler 通过该配置项,用户可以自定义一 些 服务,例如 Map-Reduce 的 shuffle 功 能就是采用这种方式实 现的,这样就 可以在 NodeManager 上扩展自己的服 务。

任务六:Hadoop 其他相关配置

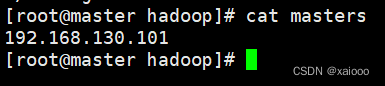

- 配置 masters 文件

[root@master hadoop]# vim masters

[root@master hadoop]# cat masters

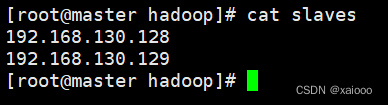

- 配置 slaves 文件

[root@master hadoop]# vim slaves

[root@master hadoop]# cat slaves

新建目录

[root@master hadoop]# mkdir /usr/local/src/hadoop/tmp

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/name -p

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/data -p

- 修改目录权限

[root@master hadoop]# chown -R hadoop:hadoop /usr/local/src/hadoop/

- 同步配置文件到 Slave 节点

[root@master ~]# scp -r /usr/local/src/hadoop/ root@slave1:/usr/local/src/

[root@master ~]# scp -r /usr/local/src/hadoop/ root@slave2:/usr/local/src/

[root@slave1 ~]# chown -R hadoop:hadoop /usr/local/src/hadoop/

[root@slave1 ~]# su - hadoop

[root@slave1~]# vim /etc/profile

[hadoop@slave1 ~]$ source /etc/profile

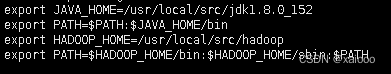

#slave2 配置

[root@slave2 ~]# yum install -y vim

[root@slave2 ~]# vim /etc/profile

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

[root@slave2 ~]# chown -R hadoop:hadoop /usr/local/src/hadoop/

[root@slave2 ~]# su - hadoop

[hadoop@slave2 ~]$ source /etc/profile

2、大数据平台集群运行

1. 实验一:hadoop 集群运行

步骤一:NameNode 格式化 将 NameNode 上的数据清零,第一次启动 HDFS 时要进行格式化,以后启动无 需再格式化,否则会缺失 DataNode 进程。另外,只要运行过 HDFS,Hadoop 的 工作目录(本书设置为/usr/local/src/hadoop/tmp)就会有数据,如果需要重 新格式化,则在格式化之前一定要先删除工作目录下的数据,否则格式化时会 出问题。 执行如下命令,格式化 NameNode

[root@master ~]# su – hadoop

[hadoop@master ~]# cd /usr/local/src/hadoop/

[hadoop@master hadoop]$ bin/hdfs namenode –format

步骤二:启动 NameNode 执行如下命令,启动 NameNode:

[hadoop@master hadoop]$ hadoop-daemon.sh start namenode

实验任务二:查看 Java 进程 启动完成后,可以使用 JPS 命令查看是否成功。JPS 命令是 Java 提供的一个显示当前所有 Java 进程 pid 的命令。

[hadoop@master hadoop]$ jps

3557 NameNode 3624 Jps

步骤一:slave节点 启动 DataNode 执行如下命令,启动 DataNode:

[hadoop@slave1 hadoop]$ hadoop-daemon.sh start datanode

[hadoop@slave2 hadoop]$ hadoop-daemon.sh start datanode

[hadoop@slave1 hadoop]$ jps

3557 DataNode 3725 Jps

[hadoop@slave2 hadoop]$ jps

3557 DataNode 3725 Jps

步骤二:启动 SecondaryNameNode 执行如下命令,启动 SecondaryNameNode:

[hadoop@master hadoop]$ hadoop-daemon.sh start secondarynamenode

[hadoop@master hadoop]$ jps

Jps 查看到有 NameNode 和 SecondaryNameNode 两个进程,就表明 HDFS 启动成 功。

步骤三:查看 HDFS 数据存放位置: 执行如下命令,查看 Hadoop 工作目录:

[hadoop@master hadoop]$ ll dfs

[hadoop@master hadoop]$ ll ./tmp/dfs

可以看出 HDFS 的数据保存在/usr/local/src/hadoop/dfs 目录下,NameNode、 DataNode和/usr/local/src/hadoop/tmp/目录下,SecondaryNameNode 各有一个目录存放数据。

实验任务三:查看 HDFS 的报告

[hadoop@master sbin]$ hdfs dfsadmin -report

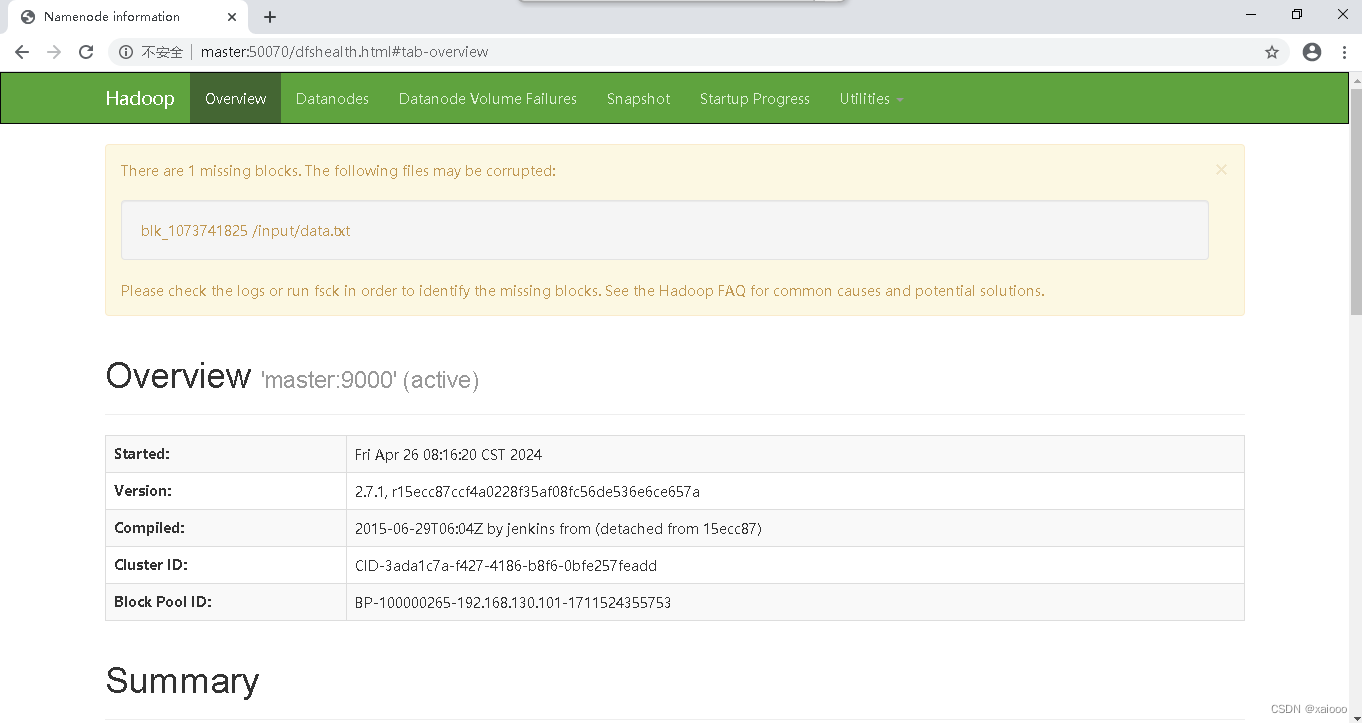

实验任务四:使用浏览器查看节点状态

在浏览器的地址栏输入http://master:50070,进入页面可以查看NameNode和DataNode 信息

通过 Web 查看 HDFS 在浏览器的地址栏输入 http://master:50090,进入页面可以查看 SecondaryNameNode信息

这时需要配置 SSH 免密码登录,否则在 启动过程中系统将多次要求确认连接和输入 Hadoop 用户密码。

[hadoop@master hadoop]$ stop-dfs.sh

[hadoop@master hadoop]$ start-dfs.sh

运行测试: 下面运行 WordCount 官方案例,统计 data.txt 文件中单词的出现频度。这个案例可 以用来统计年度十大热销产品、年度风云人物、年度最热名词等。

步骤一:在 HDFS 文件系统中创建数据输入目录 确保 dfs 和 yarn 都启动成功

[hadoop@master hadoop]$ start-yarn.sh

[hadoop@master hadoop]$ jps

34257 NameNode 34449 SecondaryNameNode 34494 Jps 32847 ResourceManager 如果是第一次运行 MapReduce 程序,需要先在 HDFS 文件系统中创建数据输入目 录,存放输入数据。这里指定/input 目录为输入数据的存放目录。

在 HDFS 文件系统中创建/input 目录:

[hadoop@master hadoop]$ hdfs dfs -mkdir /input

[hadoop@master hadoop]$ hdfs dfs -ls 此处创建的/input 目录是在 HDFS 文件系统中,只能用 HDFS 命令查看和操作。

步骤二:将输入数据文件复制到 HDFS 的/input 目录中 测试用数据文件仍然是上一节所用的测试数据文件~/input/data.txt,内容如下所示。

[hadoop@master hadoop]$ cat ~/input/data.txt

Hello World

Hello Hadoop

Hello Huasan

执行如下命令,将输入数据文件复制到 HDFS 的/input 目录中:

[hadoop@master hadoop]$ hdfs dfs -put ~/input/data.txt /input

确认文件已复制到 HDFS 的/input 目录:

[hadoop@master hadoop]$ hdfs dfs -ls /input

步骤四:查看 JAVA 进程,确认 HDFS 进程已全部关闭

[hadoop@master hadoop]$ jps

报错解决:没有jps查看没有namenode,或者没有datanode

1.查看防火墙是否关闭 systemctl status firewalld

2.查看配置文件 core.site.xml

3.查看/etc/profile 路径是否正确

4.查看主机域名解析 vi /etc/hosts

删除上面两行的域名解析

5.格式化太多次,第一次启动 HDFS 时要进行格式化,以后启动无需再格式化,否则会缺失DataNode 进程。

先停止 stop-dfs.sh

先删除tmp

rm -rf /usr/locar/src/hadoop/tmp

ls查看是否删完

创建tmp文件夹

mkdir /usr/local/src/hadoop/tmp

重新格式化hadoop

[hadoop@master hadoop]$ bin/hdfs namenode –format

开启start-dfs.sh

6.重新停止开启一次试试

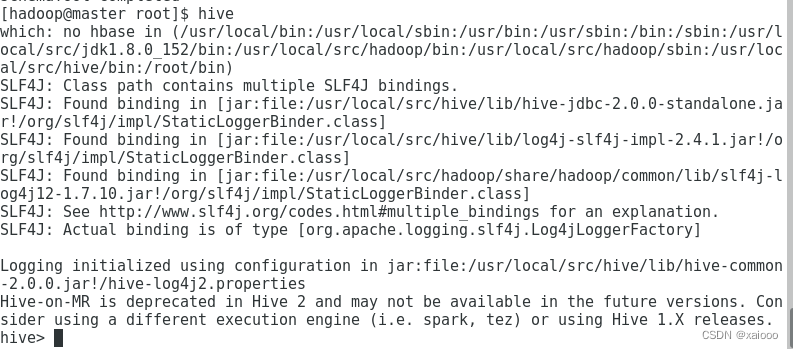

Hive数据仓库组件

Hive 组件安装配置-CSDN博客

三、大数据生态组件 1、Zookeeper组件

下载和安装 ZooKeeper ZooKeeper 最新的版本可以通过官网 http://hadoop.apache.org/zookeeper/来获取,安 装 ZooKeeper 组件需要与 Hadoop 环境适配。 注意,各节点的防火墙需要关闭,否则会出现连接问题。

1.ZooKeeper 的安装包 zookeeper-3.4.8.tar.gz 已放置在 Linux 系统 /opt/software目录下。

2.解压安装包到指定目标,在 Master 节点执行如下命令。

[root@master ~]# tar -zxvf /opt/software/zookeeper3.4.8.tar.gz -C /usr/local/src

[root@master ~]# mv /usr/local/src/zookeeper-3.4.8 /usr/local/src/zookeeper

实验任务二:ZooKeeper 的配置选项

步骤一:Master 节点配置

(1)在 ZooKeeper 的安装目录下创建 data 和 logs 文件夹。

[root@master ~]# cd /usr/local/src/zookeeper

[root@master zookeeper]# mkdir data && mkdir logs

(2)在每个节点写入该节点的标识编号,每个节点编号不同,master 节点写 入 1,slave1 节点写入 2,slave2 节点写入 3。

[root@master zookeeper]# echo 1 > /usr/local/src/zookeeper/data/myid

(3)修改配置文件 zoo.cfg

[root@master zookeeper]# cp /usr/local/src/zookeeper/conf/zoo_sample.cfg /usr/local/src/zookeeper/conf/zoo.cfg

[root@master zookeeper]# vi /usr/local/src/zookeeper/conf/zoo.cfg

修改 dataDir 参数内容如下:

dataDir=/usr/local/src/zookeeper/data

(4)在 zoo.cfg 文件末尾追加以下参数配置,表示三个 ZooKeeper 节点的访 问端口号。 server.1=master:2888:3888

server.2=slave1:2888:3888

server.3=slave2:2888:3888

(5)修改 ZooKeeper 安装目录的归属用户为 hadoop 用户。

[root@master zookeeper]# chown -R hadoop:hadoop /usr/local/src/zookeeper

步骤二:Slave 节点配置

(1)从 Master 节点复制 ZooKeeper 安装目录到两个 Slave 节点。

[root@master ~] # cd ~

[root@master ~] # scp -r /usr/local/src/zookeeper slave1:/usr/local/src/

[root@master ~] # scp -r /usr/local/src/zookeeper slave2:/usr/local/src/

(2)在 slave1 节点上修改 zookeeper 目录的归属用户为 hadoop 用户。

[root@slave1 ~] # chown -R hadoop:hadoop /usr/local/src/zookeeper

(3)在 slave1 节点上配置该节点的 myid 为 2。

[root@slave1 ~] # echo 2 > /usr/local/src/zookeeper/data/myid

(4)在 slave2 节点上修改 zookeeper 目录的归属用户为 hadoop 用户。

[root@slave2 ~] # chown -R hadoop:hadoop /usr/local/src/zookeeper

(5)在 slave2 节点上配置该节点的 myid 为 3。

[root@slave2 ~] # echo 3 > /usr/local/src/zookeeper/data/myid

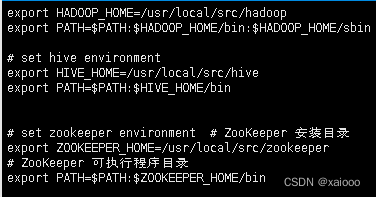

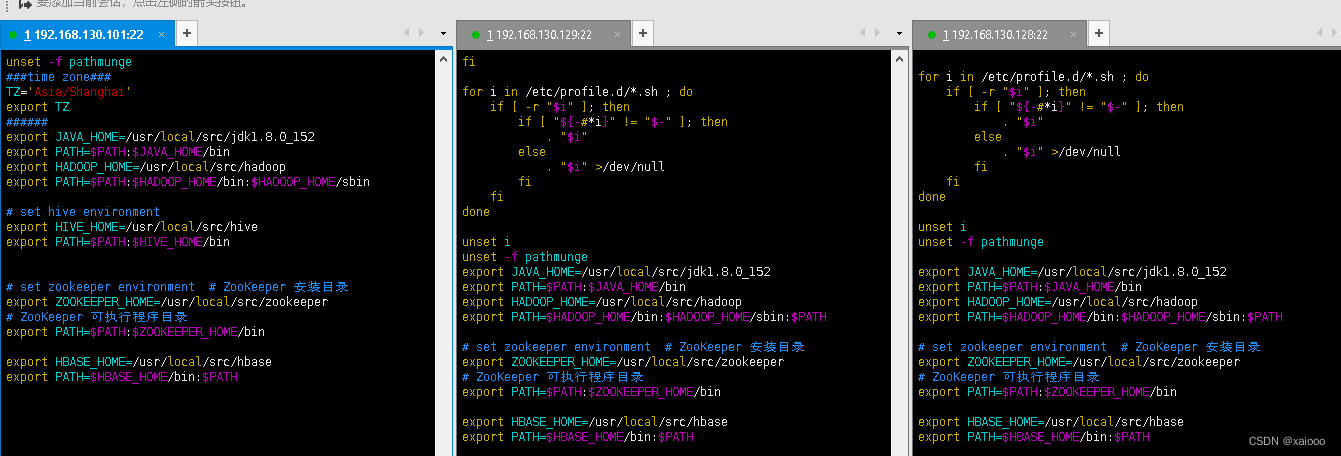

步骤三:系统环境变量配置 在 master、slave1、slave2 三个节点增加环境变量配置。

vi /etc/profile

在文件末尾追加

# set zookeeper environment # ZooKeeper 安装目录

export ZOOKEEPER_HOME=/usr/local/src/zookeeper # ZooKeeper 可执行程序目录

export PATH=$PATH:$ZOOKEEPER_HOME/bin

启动 ZooKeeper 启动 ZooKeeper 需要使用 Hadoop 用户进行操作。

(1)分别在 master、slave1、slave2 三个节点使用 zkServer.sh start 命令启 动ZooKeeper。 [hadoop@master ~]su – hadoop

[hadoop@master ~]source /etc/profile

ZooKeeper 启动

[hadoop@master ~] zkServer.sh start

[hadoop@slave1 ~] su – hadoop

[hadoop@slave1 ~] source /etc/profile

ZooKeeper 启动

[hadoop@slave1 ~] zkServer.sh start

[hadoop@slave2 ~] su – hadoop

[hadoop@slave2 ~] source /etc/profile

ZooKeeper 启动

[hadoop@slave2 ~] zkServer.sh start

(2)三个节点都启动完成后,再统一查看 ZooKeeper 运行状态。

分别在 master、slave1、slave2 三个节点使用 zkServer.sh status 命令查看 ZooKeeper 状态。

可以看到三个节点的状态分别为 follower、leader、 follower。三个节点会包括一个 leader 和两个 follower,每个节点地位均等, leader 是根据 ZooKeeper 内部算法进行选举,每个节点的具体状态不固定。

#master 节点状态

[hadoop@master ~]$ zkServer.sh status

follower 状态

#slave1 节点状态 [hadoop@s1ave1 ~]$ zkServer.sh status

leader 状态

#slave2 节点状态 [hadoop@s1ave2 ~]$ zkServer.sh status

2、Hbase数据库组件任务一:

Hbase 安装与配置

- 解压缩 HBase 安装包

[root@master ~]# tar zxf tools/hbase-1.2.1-bin.tar.gz -C /usr/local/src/

- 重命名 HBase 安装文件夹

[root@master ~]# cd /usr/local/src/

[root@master src]# mv hbase-1.2.1/ hbase

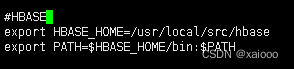

- 在所有节点添加环境变量

[root@master src]# vim /etc/profile

[root@master src]# tail -n 2 /etc/profile

export HBASE_HOME=/usr/local/src/hbase

export PATH=$HBASE_HOME/bin:$PATH

[root@slave1 ~]# vim /etc/profile

export HBASE_HOME=/usr/local/src/hbase

export PATH=$HBASE_HOME/bin:$PATH

[root@slave2 ~]# vim /etc/profile

[root@slave2 ~]# tail -n 2 /etc/profile

export HBASE_HOME=/usr/local/src/hbase

export PATH=$HBASE_HOME/bin:$PATH

- 在所有节点使环境变量生效

[root@master ~]# source /etc/profile

[root@slave1 ~]# source /etc/profile

[root@slave2 ~]# source /etc/profile

- 在 master 节点进入配置文件目录

[root@master ~]# cd /usr/local/src/hbase/conf/

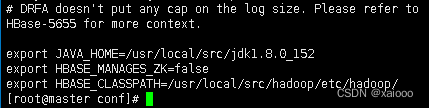

- 在 master 节点配置 hbase-env.sh 文件

[root@master conf]# vim hbase-env.sh

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export HBASE_MANAGES_ZK=false

export HBASE_CLASSPATH=/usr/local/src/hadoop/etc/hadoop/

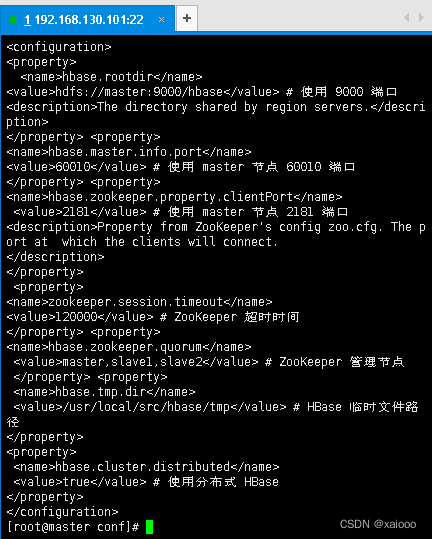

- 在 master 节点配置 hbase-site.xml 如下

[root@master conf]# vi hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://master:9000/hbase</value> # 使用 9000 端口

<description>The directory shared by region servers.</description>

</property>

<property>

<name>hbase.master.info.port</name>

<value>60010</value> # 使用 master 节点 60010 端口

</property>

<property>

<name>hbase.zookeeper.property.clientPort</name>

<value>2181</value> # 使用 master 节点 2181 端口

<description>Property from ZooKeeper's config zoo.cfg. The port at

which the clients will connect.

</description>

</property>

<property>

<name>zookeeper.session.timeout</name>

<value>120000</value> # ZooKeeper 超时时间

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>master,slave1,slave2</value> # ZooKeeper 管理节点

</property>

<property>

<name>hbase.tmp.dir</name>

<value>/usr/local/src/hbase/tmp</value> # HBase 临时文件路径

</property>

63

<property>

<name>hbase.cluster.distributed</name>

<value>true</value> # 使用分布式 HBase

</property>

</configuration>

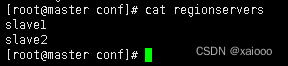

- 在 master 节点修改 regionservers 文件

[root@master conf]# vim regionservers

9.在 master 节点创建 hbase.tmp.dir 目录

[root@master conf]# mkdir /usr/local/src/hbase/tmp

- 将 master 上的 hbase 安装文件同步到 slave1 slave2

[root@master conf]# scp -r /usr/local/src/hbase/ root@slave1:/usr/local/src/

[root@master conf]# scp -r /usr/local/src/hbase/ root@slave2:/usr/local/src/

- 在所有节点修改 hbase 目录权限

[root@master conf]# chown -R hadoop:hadoop /usr/local/src/hbase/

[root@slave1 ~]# chown -R hadoop:hadoop /usr/local/src/hbase/

[root@slave2 ~]# chown -R hadoop:hadoop /usr/local/src/hbase/

- 在所有节点切换到 hadoop 用户

[root@master conf]# su - hadoop

[hadoop@master ~]$ source /etc/profile

[root@slave1 ~]# su - hadoop

[hadoop@slave1 ~]$ source /etc/profile

[root@slave2 ~]# su - hadoop

[hadoop@slave2 ~]$ source /etc/profile

- 启动 HBase [hadoop@master ~]$ start-all.sh

[hadoop@master ~]$ jps

[hadoop@slave1 ~]$ jps

- 在所有节点启动 ZooKeeper

[hadoop@master ~]$ zkServer.sh start

[hadoop@master ~]$ jps

[hadoop@slave1 ~]$ zkServer.sh start

[hadoop@slave1 ~]$ jps

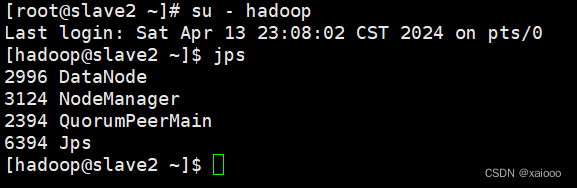

[hadoop@slave2 ~]$ zkServer.sh start

[hadoop@slave2 ~]$ jps

- 在 master 节点启动 HBase

[hadoop@master ~]$ start-hbase.sh

[hadoop@master ~]$ jps

[hadoop@slave1 ~]$ jps

[hadoop@slave2 ~]$ jps

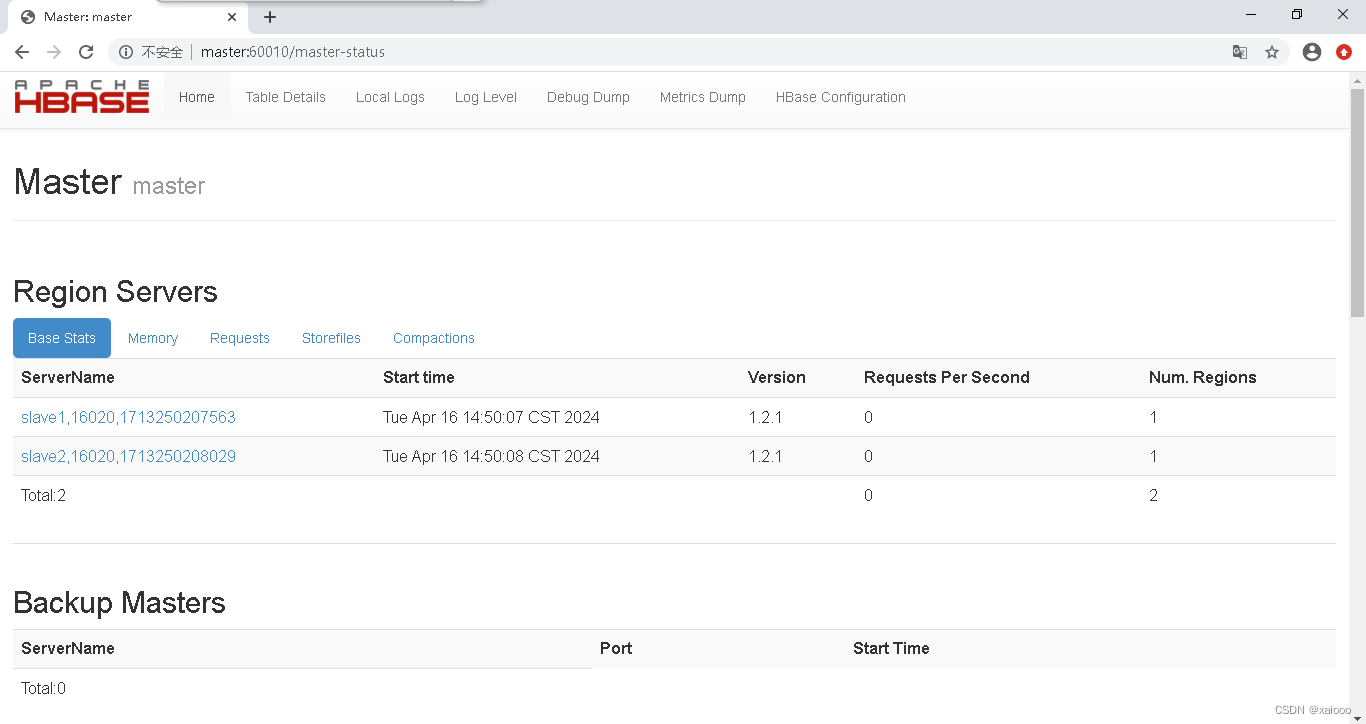

在浏览器输入 master:60010 出现如下图

版权归原作者 xaiooo 所有, 如有侵权,请联系我们删除。