VMware中Linux系统下(Ubuntu)Hadoop的安装和使用步骤

此篇文章中安装的是:jdk1.8.0_202、hadoop-3.2.4

目录

安装过程中可能会用到的复制粘贴方法:

Windows下复制内容到虚拟机下的linux系统(Ubuntu)

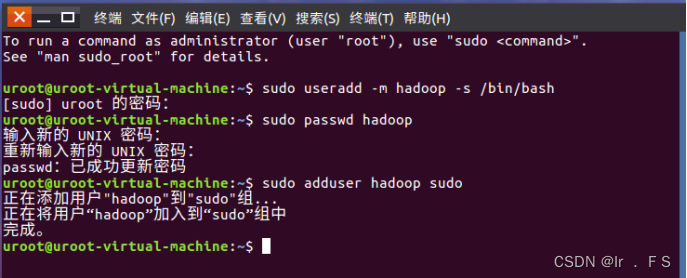

创建Hadoop用户

1、创建Hadoop用户

sudo useradd -m hadoop -s /bin/bash

sudo passwd hadoop

sudo adduser hadoop sudo

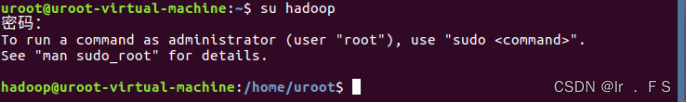

2、切换到hadoop账户

su hadoop

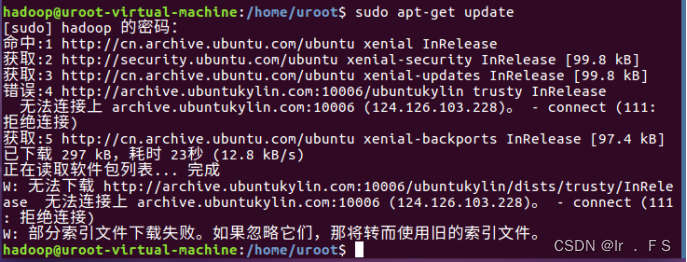

更新apt和安装Vim编辑器

1、更新apt

sudo apt-get update

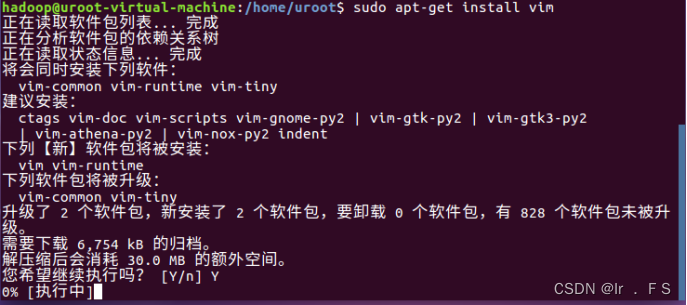

2、安装vim编辑器

sudo apt-get install vim

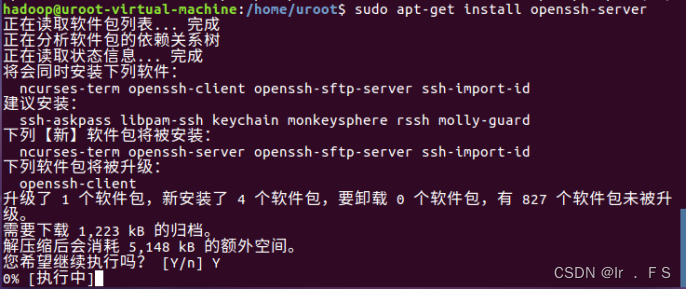

安装SSH和配置SSH无密码登录

1、安装SSH服务端

sudo apt-get install openssh-server

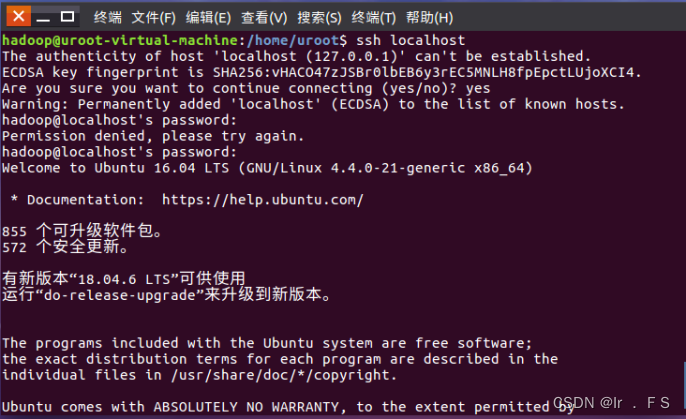

2、登录本机

ssh localhost

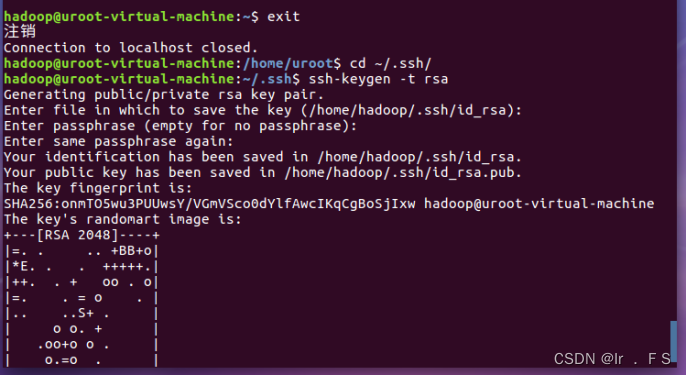

3、退出SSH登录,利用ssh-keygen生成密钥,并将密钥加入授权。

exit

cd ~/.ssh/

ssh-keygen -t rsa # 会有提示,都按回车就可以cat./id_rsa.pub >> ./authorized_keys

安装java环境

1、wget下载JDK镜像(可以选择其他方式,此方式直接下载后文件保存在当前目录)

wget --no-check-certificate https://repo.huaweicloud.com/java/jdk/8u202-b08/jdk-8u202-linux-x64.tar.gz

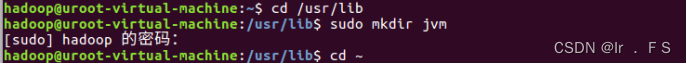

2、创建/user/lib/jvm目录来存放JDK文件

cd /usr/lib

sudo mkdir jvm

cd ~

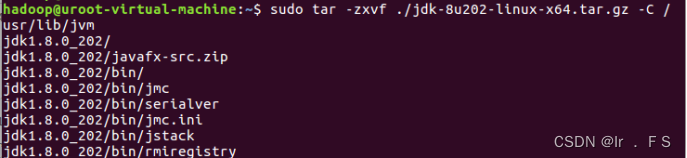

3、解压缩文件

sudo tar -zxvf ./jdk-8u202-linux-x64.tar.gz -C /usr/lib/jvm

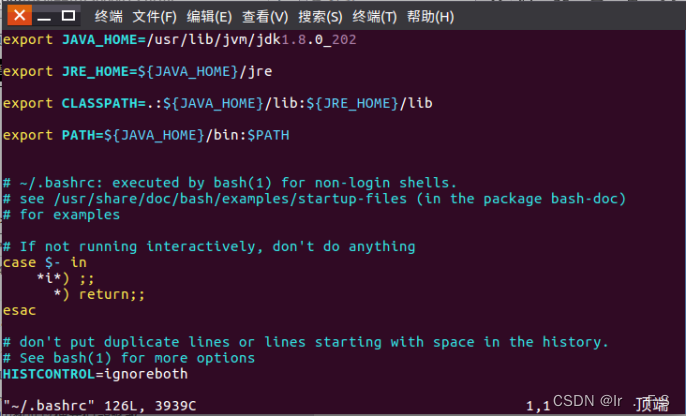

4、设置环境变量

vim ~/.bashrc

需要键盘敲击输入一个英文字母i,进入编辑状态以后才能修改内容。

修改后,需要按键盘上的Esc键退出vim的编辑状态。

从键盘输入“:wq”三个英文字母,然后回车,表示保存文件并退出。

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_202

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

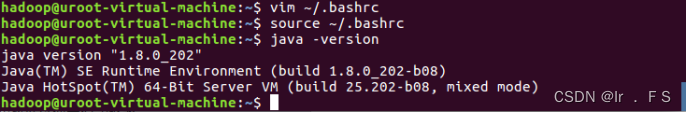

5、保存.bashrc文件,让.bashrc文件生效

查看是否安装成功

source ~/.bashrc

java -version

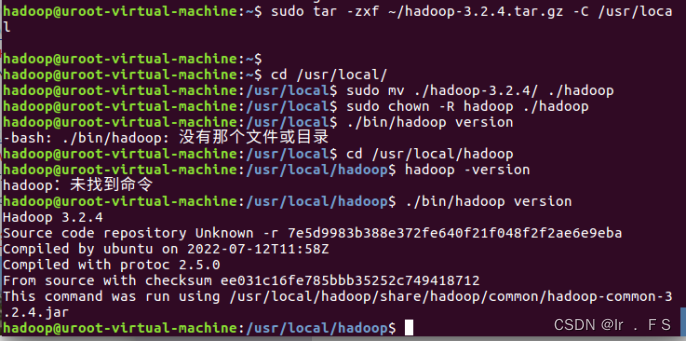

安装单机Hadoop

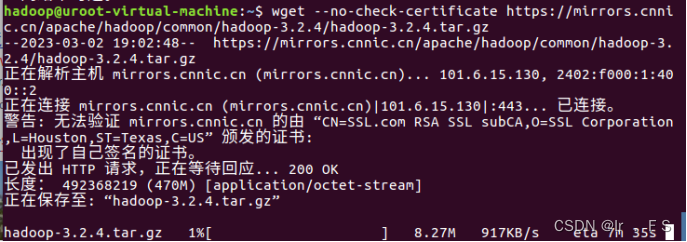

1、wegt下载hadoop镜像

wget --no-check-certificate https://mirrors.cnnic.cn/apache/hadoop/common/hadoop-3.2.4/hadoop-3.2.4.tar.gz

2、解压缩

3、重命名目录名为hadoop

4、修改目录权限为读权限

5、查看hadoop版本信息

sudo tar -zxvf ./hadoop-3.2.4/hadoop-3.2.4.tar.gz -C /usr/local

cd /usr/local

sudo mv./hadoop-3.2.4/ ./hadoop

sudo chown -R hadoop ./hadoop

cd /usr/local/hadoop

./bin/hadoop version

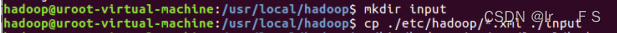

6、在hadoop安装目录下新建input目录,用来存放输入数据

7、将/user/local/hadoop/etc/hadoop目录下的配置文件复制到input目录下

mkdir input

cp./etc/hadoop/ .xml ./input

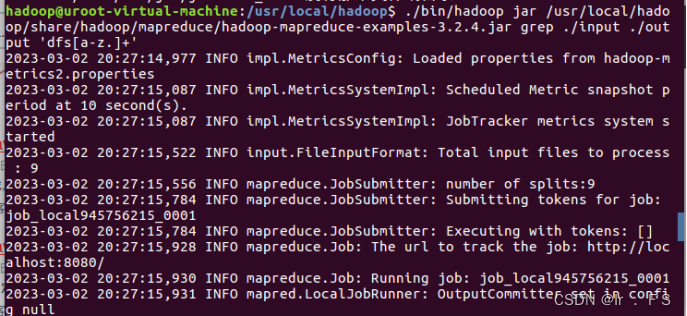

8、运行Grep实例,统计.xml文件中以dfs开头的文件

./bin/hadoop jar /usr/local/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar grep ./input ./output 'dfs[a-z.]+'

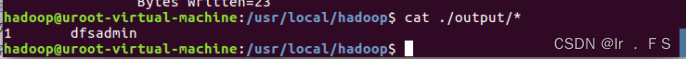

9、查看输出数据

cat./output/*

Hadoop伪分布式安装

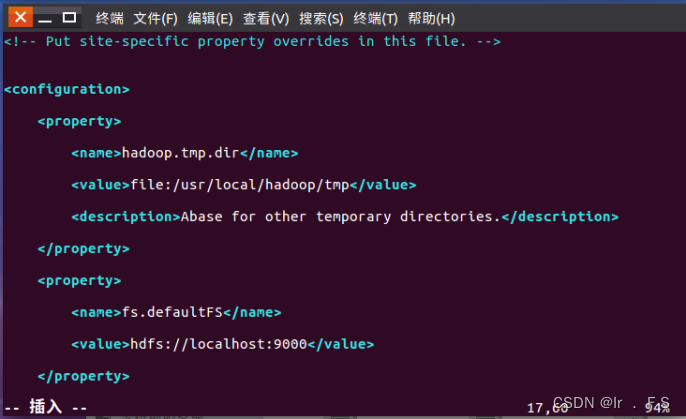

1、修改core-site.xml

vim ./etc/hadoop/core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

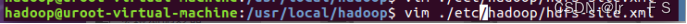

2、修改hdfs-site.xml文件

vim ./etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

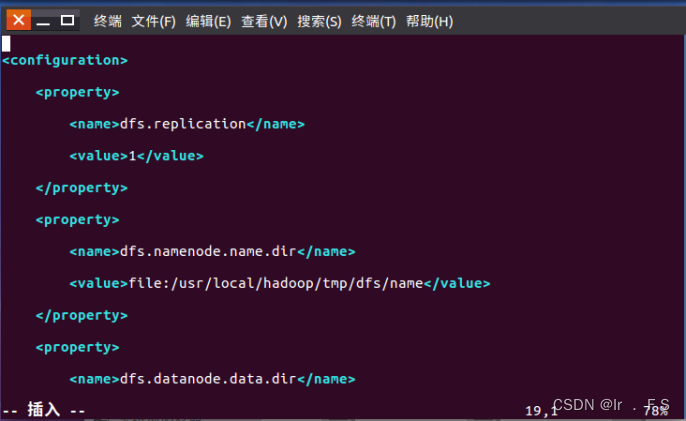

3、文件系统格式化

cd /usr/local/hadoop

./bin/hdfs namenode -format

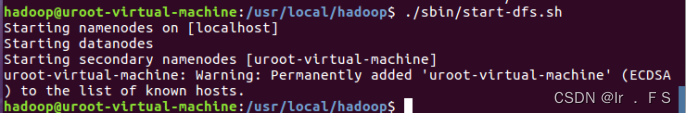

4、启动HDFS

cd /usr/local/hadoop

./sbin/start-dfs.sh

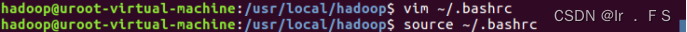

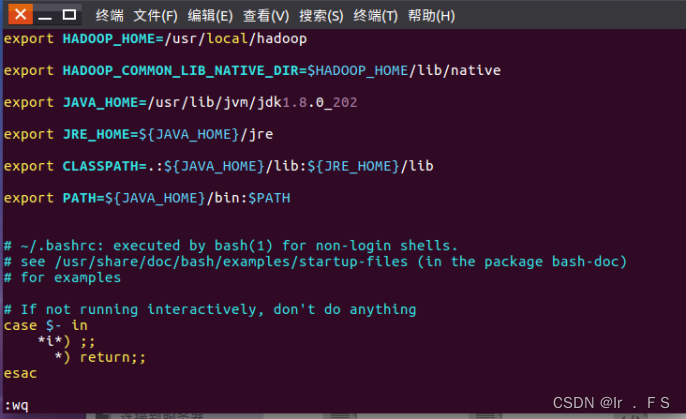

5、如果如上图一样启动失败,通过添加hadoop环境变量解决

vim ~/.bashrc

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

source ~/.bashrc

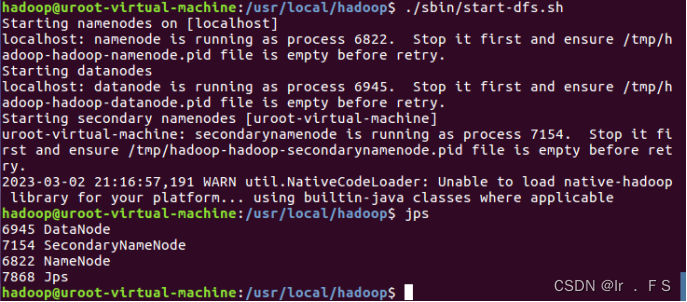

./sbin/start-dfs.sh

jps

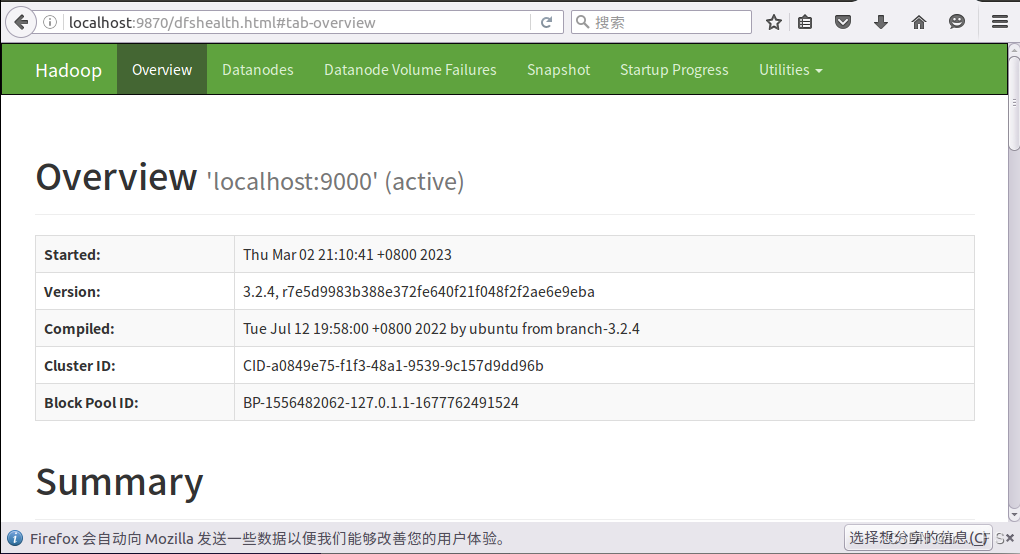

6、在Ubuntu的浏览器中访问 http://localhost:9870

版权归原作者 Buffer- 所有, 如有侵权,请联系我们删除。