同学知道什么是防火墙吗?

防火墙是保证网络安全的一道墙。

用docker创建redis容器并关联8080端口,不关闭防火墙在本机可视化工具可以直接连接使用,为什么使用远程机的Mysql,就需要关闭防火墙才能在本机连接使用?

当使用 Docker 创建 Redis 容器并映射到宿主机的 8080 端口时,能够在本机可视化工具连接并使用,这是因为 Docker 自动处理了宿主机上的端口映射,即容器内的 Redis 服务监听的端口通过

-p

参数映射到了宿主机的指定端口上。这样,即便防火墙开启,只要你在防火墙规则中放行了 8080 端口的 TCP 连接,本机或其他机器就能通过这个端口与 Redis 容器通信。

而对于远程 MySQL 数据库的情况,之所以需要配置防火墙,是因为默认情况下,大多数操作系统(如 Linux 或 Windows)的防火墙会阻止外部对 MySQL 默认端口 3306 的未授权访问。如果要从本机或者其他外部设备连接到远程 MySQL 服务器,必须在远程 MySQL 服务器上的防火墙中打开相应的端口(通常是 3306 端口),允许来自所需 IP 地址范围的入站连接。

所以,关键区别在于:

- Docker 中的 Redis 容器通过端口映射使得外部可以直接访问宿主机映射后的端口,只要宿主机防火墙允许相应端口的访问即可。

- 而远程 MySQL 服务器需要单独配置防火墙规则以允许来自特定 IP 或网络段的外部连接请求到达其监听的 3306 端口。

正确的做法是针对 MySQL 服务,在远程服务器的防火墙上添加一条入站规则,允许从特定 IP 或者所有 IP(如果适用)对 3306 端口的访问,而不是简单地关闭防火墙。这样既保证了服务的安全性,也满足了远程连接的需求。

使用Docker,防火墙为什么不会阻止外部对端口 8080 的访问?

在Docker环境中,当您使用

-p

或

--publish

参数启动一个容器时,实际上是告诉Docker将容器内暴露的服务端口映射到宿主机的一个端口上。例如,如果您运行以下命令:

docker run -d -p 8080:80 nginx

这意味着您将容器内的80端口映射到了宿主机的8080端口。这样做之后,外部对宿主机8080端口的访问实际上会被转发到Docker容器内的80端口上。

Docker在做端口映射的同时,也会自动更新宿主机上的防火墙规则(对于Linux系统,通常是iptables或firewalld,取决于系统的防火墙配置),以便允许通过映射的端口进行通信。因此,当您正确设置了端口映射,即使防火墙是开启状态,理论上外部也应该能够访问到宿主机的8080端口,进而连接到容器内的服务。

然而,需要注意的是,这仅限于宿主机层面的防火墙设置。如果宿主机上有其他的防火墙软件或云服务商提供的网络安全组设置,它们可能需要手动配置以放行相应的端口。此外,某些情况下,如公司内部网络或ISP可能还有更上层的防火墙限制,这也需要相应配置才能允许外部访问。

如何配置防火墙规则,来打开3306端口?知道防火墙是做什么的?

防火墙是一种网络安全系统,它的主要任务是监控并过滤进出计算机网络的数据包,根据预设的安全规则决定是否允许这些数据包通过。防火墙的存在是为了保护网络免受未经授权的访问、恶意攻击和其他潜在的安全威胁。它可以根据源IP地址、目的IP地址、端口号以及协议类型等特征来制定策略,允许合法流量通行,同时阻止非法或非预期的流量。

在Linux系统中,尤其是较早版本的CentOS 6.x系列,可以通过配置

iptables

防火墙规则来打开3306端口,以便允许外部或本地网络访问MySQL服务(默认监听3306端口)。以下是使用iptables打开3306端口的基本步骤:

# 编辑防火墙规则配置文件

vi /etc/sysconfig/iptables

# 添加以下规则到INPUT链,允许新的TCP连接通过3306端口

-A INPUT -m state --state NEW -m tcp -p tcp --dport 3306 -j ACCEPT

# 保存并退出编辑器

:wq

# 重新加载防火墙规则使更改生效

service iptables reload # 对于旧版CentOS系统

systemctl restart iptables.service # 若系统支持systemd,也可以使用这种方式

# 或者在支持firewalld防火墙管理工具的系统中,如CentOS 7及更高版本

firewall-cmd --permanent --add-port=3306/tcp

firewall-cmd --reload

请注意,

--permanent

标志意味着规则会在系统重启后仍然有效。

以上步骤简述了如何在Linux的iptables防火墙中永久性地打开3306端口。如果你使用的系统采用的是其他类型的防火墙管理工具,如ufw(Uncomplicated Firewall)或firewalld,请参照对应工具的文档来进行相应配置。

为什么不直接关闭防火墙呢?

关闭防火墙意味着暂时停止了系统的网络防护机制,所有的网络数据包都将无阻碍地进出系统,包括可能存在的恶意流量。在Linux系统中,您可以临时或永久关闭防火墙,但这不是一个推荐的做法,因为它会显著增加系统遭受攻击的风险。

以下是关闭Linux中两种常见防火墙(iptables和firewalld)的方法:

- 关闭iptables防火墙(临时关闭):

service iptables stop # 对于旧版CentOS系统systemctl stop iptables # 对于支持systemd的系统永久关闭iptables(不推荐):chkconfig iptables off # 对于旧版CentOS系统systemctl disable iptables # 对于支持systemd的系统 - 关闭firewalld防火墙(临时关闭):

systemctl stop firewalld永久关闭firewalld(不推荐):systemctl disable firewalld

关闭防火墙后,您的MySQL服务将不再受到防火墙规则的限制,任何网络客户端理论上都可以尝试连接到MySQL服务的3306端口。

再次强调,除非您有非常明确的理由需要关闭防火墙,否则一般不建议这样做。

在实际应用中,应尽量通过配置防火墙规则来开放必要的端口,而非简单粗暴地关闭防火墙。对于MySQL来说,应当只开放来自可信来源的3306端口访问,以此达到既能提供服务又保持安全的目的。

阿里云安全组和Linux的防火墙有什么区别?为什么打开了安全组,还需要设置Linux防火墙的规则?

阿里云安全组和Linux操作系统的防火墙(如iptables或firewalld)是两个不同层次的网络访问控制机制,它们分别作用于不同的应用场景,共同协作来提升服务器的安全性。

- 阿里云安全组:- 位置:阿里云安全组是阿里云平台提供的虚拟防火墙服务,它位于云平台层面,处于云服务器实例之前,充当整个云环境的第一道防线。- 功能:安全组通过控制实例的入站和出站流量,实现基于IP地址、端口和协议的网络访问策略配置。它具有状态检测和数据包过滤的能力,可以灵活设定允许哪些流量进入或离开ECS实例。- 特点:安全组策略与具体的云服务器实例绑定,它是集中化管理和分布式实施的,可以在不影响操作系统本身的情况下对所有属于同一安全组的ECS实例进行统一的网络访问控制。

- Linux防火墙(iptables或firewalld):- 位置:Linux防火墙是操作系统级别的,安装在每个Linux实例内部,负责对到达实例本身的网络流量进行更细致、更深入的过滤和控制。- 功能:它可以对进入和离开实例的所有流量进行细粒度的筛选和管理,不仅限于外部访问,还涉及实例内部进程之间的网络通信。例如,可以进一步细化到特定的应用程序级别,或者设置更为复杂的规则集。- 特点:Linux防火墙规则独立于云平台,更加贴近操作系统内部服务,能够为系统管理员提供更全面和个性化的网络策略定制。

为什么同时需要设置两者:

- 分层防御:安全组和Linux防火墙各自提供了一层防御,两者的结合可以形成纵深防御体系。即使云平台的安全组已经允许了某种流量,但在操作系统层面还可以进一步加强控制,防止潜在的内部安全风险。

- 灵活性和控制力:云安全组适用于批量控制和快速响应全局安全策略变更,而操作系统防火墙则能提供更细致的控制,例如针对单个实例的特殊需求,或者应对更复杂多变的网络环境。

- 冗余安全:即使由于某种原因云安全组配置出现问题,操作系统防火墙还能提供一定程度的保护,防止意外情况下的网络攻击。

总的来说,阿里云安全组和Linux防火墙相辅相成,共同保障了服务器实例在网络层面的安全性。在实践中,应根据业务需求和安全策略,合理配置这两个层面的规则,以确保服务器对外服务的可用性和安全性。

如果关闭操作系统防火墙,只靠阿里云的安全组,安不安全?

关闭操作系统防火墙,仅仅依赖阿里云安全组来保护云服务器的安全是有一定风险的,虽然阿里云安全组提供了一定程度的网络访问控制,但它并不替代操作系统的内核级防火墙所提供的全方位安全防护功能。

阿里云安全组的作用主要是对流入和流出云服务器实例的流量进行基础的访问控制,通过安全组规则可以有效阻止或允许特定来源、目标、端口和协议的流量。但是,操作系统防火墙(如iptables、firewalld等)在内核层面提供了更细致的流量控制和更深度的安全策略,可以处理更多复杂的网络场景,比如防止内部服务间的异常访问、针对特定应用程序的详细规则设定等。

以下是一些考量点:

- 内网安全:阿里云安全组主要关注的是公网入口和出口的安全,对于云服务器内部网络间通信的安全控制相对较弱。操作系统防火墙可以帮助防止内部服务被恶意进程利用或者阻止不必要的内部通信。

- 精细化控制:操作系统防火墙可以实现更精细的规则设定,包括但不限于基于进程、用户、标记等多种条件的规则,这些在云安全组中可能无法实现。

- 漏洞防护:若操作系统存在未知漏洞,而黑客通过某种方式绕过了阿里云安全组的控制,这时操作系统防火墙可能是最后一道防线,能够阻挡对系统核心服务的恶意访问。

- 紧急响应:在操作系统层面发生安全事件时,及时修改防火墙规则可以迅速阻断恶意流量,这是云安全组难以立即实现的。

因此,建议在阿里云环境下,同时启用并合理配置阿里云安全组和操作系统防火墙,形成内外兼修的安全策略,从而最大程度上提高云服务器的安全性。

Linux防火墙规则怎么看呢?

在Linux系统中,您可以使用

iptables

命令来查看防火墙规则。以下是一些常用命令来查看Linux防火墙(netfilter)的规则:

- 查看所有表(filter、nat、mangle 和 raw)的默认策略以及各链中的所有规则(不带统计信息):

sudo iptables -L - 显示详细信息,包括每条规则的命中次数、字节数和包数,并带有行号(便于后续修改或删除规则):

sudo iptables -nvL --line-numbers若要查看特定表的规则,例如过滤表(filter),可以指定表名:sudo iptables -t filter -nvL --line-numbers - 如果您的系统使用的是

nftables(在一些较新版本的Linux发行版中取代了iptables),查看防火墙规则的方式略有不同:sudo nft list ruleset

如果您想查看的是Firewalld防火墙规则(在某些现代Linux发行版如Fedora、RHEL/CentOS 7及以上版本中默认使用),可以使用如下命令:

sudo firewall-cmd --list-all-zones

或者查看某个特定区域的规则:

sudo firewall-cmd --zone=public --list-all

记得使用

sudo

或以root身份运行这些命令,因为防火墙规则的查看和修改通常需要管理员权限。

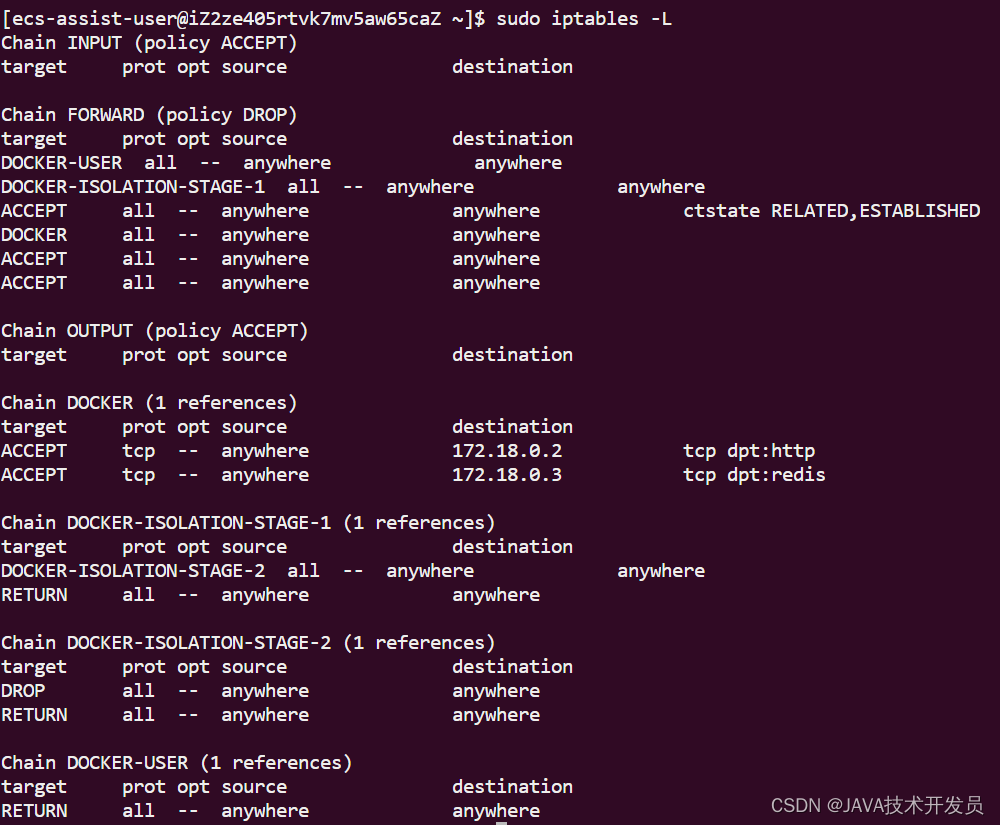

试一下,查看服务器的防火墙规则,知道都是什么意思吗?

这是Linux系统中iptables防火墙规则的当前配置情况。让我们逐链解析:

这是Linux系统中iptables防火墙规则的当前配置情况。让我们逐链解析:

- Chain INPUT (policy ACCEPT):- INPUT链是处理进入系统的数据包的链,这里的默认策略是ACCEPT,表示所有进入的数据包都会被接受,除非有特定的规则阻止它。

- Chain FORWARD (policy DROP):- FORWARD链处理那些既不是发往本机也不是源自本机的数据包,即网络转发的数据包。在这个例子中, FORWARD链的默认策略是DROP,意味着如果不匹配到任何规则,则所有试图转发的数据包都会被丢弃。

- Chain OUTPUT (policy ACCEPT):- OUTPUT链处理的是由本机发起并离开系统的数据包,这里默认策略也是ACCEPT,即所有外出的数据包都被接受。

接下来是几个专门针对Docker容器的自定义链:

- Chain DOCKER:- 这个链包含了针对Docker容器的具体规则。例如,有两个规则允许外部任何地方(anywhere)访问容器内部的特定服务: - 第一条规则允许任意IP通过TCP协议访问Docker网络172.18.0.2上的HTTP服务(tcp dpt:http)。- 第二条规则允许任意IP通过TCP协议访问Docker网络172.18.0.3上的Redis服务(tcp dpt:redis)。

- Chain DOCKER-ISOLATION-STAGE-1 和 DOCKER-ISOLATION-STAGE-2:- 这两个链是Docker为实现容器隔离而创建的,用来阻止不必要的网络通信。STAGE-1链通常包含初步筛选规则,然后将符合条件的数据包传递给STAGE-2链。在这个例子中,STAGE-2链有一个DROP规则和一个RETURN规则,旨在对不符合条件的流量进行丢弃,符合的流量则返回至上级链继续处理。

- Chain DOCKER-USER:- 这个链通常用来放置用户自定义的Docker相关的规则。在这里,只有一个RETURN规则,表示所有经过DOCKER-USER链的数据包都返回到上级链继续处理,不做额外的动作。

综上所述,这个iptables规则配置主要侧重于对Docker容器的网络流量进行控制,同时采用了较为严格的转发策略(DROP),并且确保了Docker容器内部服务对外的HTTP和Redis服务可以被外部访问。

Chain DOCKER里,这两个网络地址是什么呢?怎么没看到开放的端口号?

在这两条规则中,我们看到了两个网络地址:

172.18.0.2

和

172.18.0.3

。这两个地址都是Docker为容器分配的内部网络IP地址。当您在Docker中运行容器时,Docker会为每个容器分配一个或多个虚拟IP地址,使其能在Docker网络中与其他容器或宿主机进行通信。

- 第一条规则

ACCEPT tcp -- anywhere 172.18.0.2 tcp dpt:http表示允许任何IP地址(anywhere)通过TCP协议访问IP地址为172.18.0.2的容器提供的HTTP服务,这里的dpt:http指定了端口号为80(因为HTTP服务的标准端口号是80)。 - 第二条规则

ACCEPT tcp -- anywhere 172.18.0.3 tcp dpt:redis类似地,表示允许任何IP地址通过TCP协议访问IP地址为172.18.0.3的容器提供的Redis服务,这里的dpt:redis指定了端口号为6379(因为Redis服务的标准端口号是6379)。

虽然没有明确写出端口号,但

dpt:

后面跟着的是服务名称,实际上隐含了标准端口号。如果想要查看具体的端口号,可以用命令行工具查询服务的标准端口映射,或者直接在规则中写明端口号,例如:

tcp dpt:80

或

tcp dpt:6379

。在本例中,由于使用的是服务名称,iptables已经知道这些服务所对应的端口号。

什么是Chain?为什么要有三个默认的Chain?

在iptables中,“Chain”是规则处理过程中的一个逻辑阶段,它是规则集合中的一个有序列表,iptables会按顺序检查每条规则来决定如何处理网络数据包。iptables中有多个内置的Chain(链),以及用户可以自定义的Chain。

为何会有三个默认的Chain(INPUT, FORWARD, OUTPUT):

- INPUT Chain:- 处理所有流向本机的网络数据包,即目标地址是本机的数据包。这个Chain中的规则决定了哪些数据包可以进入系统,例如允许或拒绝来自互联网的请求访问本地服务。

- FORWARD Chain:- 处理那些通过本机转发的数据包,即数据包既不是本机发出也不是目的地为本机,而是通过本机作为一个路由器从一个网络接口转发到另一个网络接口的数据包。这个Chain中的规则决定了哪些数据包可以被转发。

- OUTPUT Chain:- 处理从本机发出的所有网络数据包。这个Chain中的规则控制着本机产生的流量,如本地服务对外的请求或响应。

除了这三个基本Chain外,还有一些与特定功能相关的内置Chain,比如与NAT(网络地址转换)相关的PREROUTING和POSTROUTING Chain,以及用于特殊目的的Chain,如DOCKER Chain等。这些Chain一起构成了一个完整的数据包过滤和处理流程,根据不同的网络需求和策略来配置规则,实现对进出系统的网络流量的有效管理。

Linux防火墙是如何实现的?

Linux防火墙主要通过Netfilter框架实现,这是一个内置于Linux内核中的数据包过滤框架,它提供了中间件,让iptables、nftables以及其他防火墙软件可以在内核级别上对网络数据包进行操作。

Netfilter框架在整个网络栈的五个钩子点(hook points)上提供了一系列的挂载点,分别是:PREROUTING、INPUT、FORWARD、OUTPUT和POSTROUTING。这些挂载点对应数据包在网络传输过程中的不同阶段:

- PREROUTING: 在数据包到达目标主机之前进行路由决策前处理。

- INPUT: 数据包到达主机并准备交付给上层协议栈(如TCP/IP协议)之前处理。

- FORWARD: 数据包在主机之间转发时处理,应用于路由器或具有NAT功能的设备。

- OUTPUT: 主机生成的数据包准备发送到网络之前处理。

- POSTROUTING: 数据包在发送到网络之前进行最终的路由和NAT转换。

iptables或nftables等工具通过编写规则集,将规则插入到这些链(chain)中,规则集包含了对数据包的匹配条件和处理动作,例如接受(ACCEPT)、拒绝(DROP)、重定向(REDIRECT)、MASQUERADE、SNAT、DNAT等。

当数据包在网络栈中流动时,Netfilter会遍历各个挂载点处的规则链,根据规则决定数据包的命运。通过这种方式,Linux防火墙能够实现对网络流量的过滤、NAT转换、状态跟踪等功能,从而达到安全防护的目的。

什么是NAT转换?

NAT(Network Address Translation,网络地址转换)是一种网络技术,它在不同的网络层面上实现私有(非全局唯一)IP地址与公网(全局唯一)IP地址之间的相互转换。NAT的主要目的是为了缓解IPv4地址空间有限的问题,并为内部网络提供一定程度的安全性和隐私性。

工作原理简述如下:

- 地址转换:- 在一个组织或家庭网络中,内部网络设备通常使用私有IP地址(如192.168.x.x、10.x.x.x或172.16.x.x至172.31.x.x范围内的地址),这些地址在公网上不是唯一的。- 当内部网络中的设备想要与公网上的设备通信时,其源IP地址会被NAT设备(通常是路由器或防火墙)替换为该组织在公网上的合法、全局唯一的IP地址。- 同理,对于公网返回的响应,NAT设备会根据先前创建的映射关系,将目的IP地址从公网IP转换回相应的私有IP地址,确保数据包能送达正确的内部设备。

- 端口转换:- 由于多个内部设备可能同时请求与同一公网IP地址的不同服务通信,NAT还会转换端口号,以区分不同设备间的连接。- NAT设备维护一张转换表,记录每个内部IP地址及其使用的端口与对应的公网IP地址及端口之间的映射关系。

- 类型和应用场景:- 静态NAT:一对一映射,每个内部IP都有固定的公网IP。- 动态NAT:临时分配公网IP,仅在需要时转换。- PAT(Port Address Translation,端口地址转换)或NAPT:最常见的形式,多个内部IP共享单个公网IP,通过端口区别不同连接。

- 安全优势:- NAT技术隐匿了内部网络的实际结构和设备细节,增加了网络安全性,因为外部网络无法直接看到或访问内部网络的私有IP地址。

通过上述机制,NAT使得大量内部设备可以共享少量的公网IP地址,同时在一定程度上实现了网络隔离和对外隐藏的效果。随着IPv6的普及,虽然理论上地址空间足够大,不再需要大规模的地址转换,但在实际过渡期间,NAT仍在许多场景中得到广泛应用。

路由器已经有NAT了,防火墙上的NAT还有什么用?

路由器上的NAT(Network Address Translation)通常指的是源NAT(Source NAT,SNAT),主要用于解决IP地址短缺问题,允许内部私有网络中的设备通过一个或少数公网IP地址访问外部网络。路由器上的NAT实现的功能主要包括:

- 地址隐藏:将内部私有IP地址转换为公网IP地址,从而对外隐藏内部网络的结构和资源。

- 地址复用:多个内部主机共享一个公网IP地址,通过端口号进行区分,节约公网IP地址资源。

防火墙上的NAT功能则更加丰富和深入,除了包含路由器的SNAT功能外,还可能包括以下功能:

- 目的NAT(Destination NAT,DNAT):将目标地址转换为内部私有IP地址,用于将外部请求指向内部服务器,例如公开Web服务器、邮件服务器等。

- 端口转发: DNAT的一种形式,允许外部用户通过公网IP和特定端口访问内部网络中的特定服务。

- 端口地址转换(PAT,Port Address Translation):类似于SNAT,但通过端口号复用一个公网IP地址,以支持更多的内部主机连接外部网络。

- NAT池:防火墙可以配置多个公网IP地址组成的池,动态分配给内部主机以平衡负载或提供更大的连接容量。

- NAT策略:结合安全策略,防火墙可以根据多种条件如源IP、目标IP、端口、协议、时间等灵活制定NAT转换规则,提供更细粒度的访问控制。

- 状态型NAT:防火墙NAT通常基于会话状态管理,只转换初始化连接的IP地址,后续会话基于初始转换进行,提高了效率和安全性。

- 企业级特性:在企业级防火墙中,NAT功能还可能与高级安全特性结合,如深度包检测(Deep Packet Inspection,DPI)、应用识别、用户认证、内容过滤等,以实现更严格的安全控制。

因此,防火墙上的NAT不仅仅是地址转换那么简单,它更多的是结合了网络安全策略,增强了网络边界的安全性和可控性。在高要求的网络环境中,防火墙NAT扮演着更加复杂和重要的角色。

详细说说如何进行端口地址转换?

端口地址转换(PAT,也称为NAPT,Network Address Port Translation)是一种网络地址转换技术,它在传统的网络地址转换(NAT)基础上增加了端口号的转换,允许多个内部主机通过同一个公网IP地址同时访问外部网络。下面是PAT工作过程的一个详细描述:

- 内部主机发起连接:- 内部网络中的某台主机(例如,IP地址为192.168.1.100)希望与外部网络中的服务器(例如,公网IP地址为203.0.113.100)建立连接,例如使用HTTP协议(端口80)。

- NAT设备接收数据包:- 数据包首先到达具有公网IP地址(例如,100.100.100.100)的NAT设备(通常是路由器或防火墙)。

- 源地址和端口转换:- NAT设备将内部主机的源IP地址(192.168.1.100)替换为NAT设备自身的公网IP地址(100.100.100.100)。- 同时,NAT设备会选择一个未使用的端口号(例如,假设选择的是5000),并将内部主机原来使用的源端口(例如,80)替换为这个新端口(5000)。- 这样,原始数据包就被转换成了一个新的数据包,源地址和端口分别为(100.100.100.100:5000)。

- 发送转换后的数据包:- NAT设备将转换后的数据包发送到外部网络。

- 外部服务器响应:- 当外部服务器收到数据包并做出响应时,它会将响应的目标地址和端口设置为转换后的值(100.100.100.100:5000)。

- NAT设备进行反向转换:- 当响应数据包回到NAT设备时,设备根据其内部维护的NAT转换表(即之前的映射记录)识别到这个响应应该被转发给内部网络的哪个主机。- NAT设备将目标地址还原为内部主机的私有IP地址(192.168.1.100),并将目标端口号恢复为原来的端口号(80)。

- 数据包送达内部主机:- 最终,经过转换后的响应数据包被正确地送达到了内部主机。

通过这种方式,PAT使得多个内部主机可以共用一个公网IP地址访问互联网,同时还能通过端口号的转换来区分不同主机的网络连接,大大节省了公网IP地址资源。需要注意的是,NAT设备必须维护一份转换表来跟踪每一个连接的状态,确保数据包在来回转换过程中能正确送达和响应。

如果遇到DDos攻击,应该怎么配置防火墙?

面对DDoS(分布式拒绝服务)攻击,防火墙配置是防御策略的一部分,但并不是全部。DDoS攻击的特点是短时间内产生大量看似合法的请求,占用网络带宽、服务器资源,导致正常服务不可用。防火墙在防御DDoS攻击时,主要通过以下几种方式进行配置:当遇到DDOS攻击的几种应对措施 - 知乎 (zhihu.com)

- 限制连接速率与并发连接数:- 设置防火墙规则限制单个IP地址在一定时间内建立的新连接数,超出阈值则丢弃连接请求。- 可以通过防火墙限制入站 SYN 请求的速度,防止SYN洪水攻击。示例(在iptables中):

# 限制单个IP每秒新建的SYN连接不超过10个iptables -A INPUT -p tcp --syn -m limit --limit 10/s --limit-burst 20 -j ACCEPT - 端口禁用或启用:- 关闭不必要的服务端口,只开放必要的服务端口。- 对于易受攻击的服务,比如HTTP(S),可以使用随机高阶端口代替标准端口。

- 使用状态检测防火墙:- 利用iptables的

conntrack模块来跟踪和管理连接状态,允许已建立的连接通过,丢弃无效的或未初始化的连接请求。 - 设置黑名单与白名单:- 将已知攻击源IP列入黑名单,拒绝其所有连接请求。- 只允许白名单中的IP地址访问。

- 使用专业的DDoS防护设备或服务:- 在网络边缘部署DDoS防护设备,如硬件防火墙或专业DDoS防护解决方案,它们通常具备智能流量清洗功能,能识别并过滤异常流量。- 使用云服务提供商的DDoS防护服务,如AWS Shield、阿里云DDoS防护、Cloudflare等,这类服务能够提供大规模的带宽和先进的算法来对抗DDoS攻击。

- 负载均衡与CDN服务:- 使用负载均衡器可以分散攻击流量,避免单一服务器过载。- 配置内容分发网络(CDN),通过分布在全球的节点缓存静态内容,减少源站压力。

- 配置日志记录与警报:- 设置防火墙规则以记录可疑活动,并配置告警系统,在出现异常流量时通知管理员。

- 应急响应计划:- 在遭遇DDoS攻击时,提前准备好应急预案,如联系ISP、调整路由策略、切换到备份系统等。

请注意,防火墙只是DDoS防御体系的一部分,真正的防御通常需要多层次、综合性的解决方案。对于大规模、复杂的DDoS攻击,还需要结合流量分析、行为检测、自动防御策略等技术手段。

什么是SYN 请求?SYN洪水攻击是什么?如果是正常的高并发场景下,如何防止误判?

SYN 请求: 在TCP/IP协议中,SYN(Synchronize Sequence Numbers)请求是TCP连接建立过程中的第一步。当一个客户端想要与服务器建立连接时,它会发送一个SYN(同步)数据包,其中包含了客户端的初始序列号(ISN)。这个数据包表明客户端希望建立连接,并等待服务器的确认。

SYN洪水攻击: SYN洪水攻击是一种常见的分布式拒绝服务(DDoS)攻击,攻击者通过伪造大量的SYN请求,向目标服务器发送大量的TCP连接请求。在TCP的三次握手过程中,服务器接收到SYN请求后,会回应一个SYN+ACK数据包,并等待客户端的ACK确认。然而,由于攻击者的请求是伪造的,客户端不会发送ACK确认,导致服务器上积累了大量的半开连接(即处于SYN_RCVD状态的连接)。这些半开连接会消耗服务器的内存、CPU和端口资源,最终可能导致服务器无法处理正常的请求,服务中断。

防止误判高并发场景下的SYN洪水攻击: 在正常高并发场景下,防止误判SYN洪水攻击的关键是区分正常流量和恶意流量。以下是一些方法:

- 连接速率限制: 限制单位时间内来自同一IP地址的SYN请求的数量,超过一定阈值则拒绝新的连接请求。这种方法可以防止某一IP地址突然发起大量连接请求。

- SYN Cookie: 使用SYN cookie技术,服务器在收到SYN请求时,不立即分配资源,而是发送带有计算出来的“cookie”的SYN+ACK响应。客户端在下次ACK响应中需携带这个cookie,只有当服务器验证cookie有效时才分配资源建立连接。这种方法可以减轻服务器资源的消耗。

- 状态检测防火墙: 配置防火墙使用状态检测机制,允许已建立连接的数据包通过,对新的连接请求根据连接速率和并发连接数进行合理控制。

- 流量整形与清洗: 使用专业的DDoS防护设备或服务,对进来的流量进行实时监测和清洗,区分正常访问和攻击流量。

- 资源监控与自动化响应: 实时监控服务器资源利用率,当CPU、内存或端口资源接近饱和时,触发预先设置的自动化响应机制,例如暂时封禁异常IP、调整路由策略等。

- 使用云服务提供商的DDoS防护服务: 许多云服务提供商提供了DDoS防护服务,能有效抵御大规模SYN洪水攻击,并具备智能识别和自我学习能力,降低误判正常高并发连接的可能性。

- 合理的TCP连接超时设置: 适当地调整TCP连接的超时时间,确保半开连接在合理的时间内清除,减少资源浪费。同时,设置合适的SYN队列长度,防止过多的半开连接堆积。

通过上述措施,可以在保证正常高并发访问不受影响的前提下,更好地防范和应对SYN洪水攻击。

如何配置防火墙使用状态检测机制?什么是状态检测机制?

状态检测机制是防火墙的核心功能之一,它通过追踪和维护网络连接的状态信息来判断数据包是否合法。不同于简单的包过滤防火墙(只基于数据包的源IP、目标IP、端口号和协议类型等静态信息进行决策),状态检测防火墙会记录和管理网络连接的状态,理解数据包在通信会话中的上下文,从而允许或拒绝数据包的通过。

在Linux中,iptables工具可以通过使用

conntrack

模块实现状态检测机制。以下是配置状态检测防火墙的基本步骤:

- 启用 conntrack 支持: 确保Linux内核启用了conntrack模块,大多数现代Linux发行版默认已经启用。

- 创建状态检测规则: 通常在iptables中,

-m state或--match state选项用于匹配连接状态。下面是一个基本的示例,创建一个允许已建立或相关(ESTABLISHED或RELATED)连接的数据包通过INPUT链的例子:sudo iptables -A INPUT -m state --state ESTABLISHED,RELATED -j ACCEPT上述命令表示允许所有已经建立了连接(即双向通信已经开始)或与已建立连接有关联的数据包通过防火墙。 - 定义默认策略: 为了充分利用状态检测,通常先定义默认策略为拒绝所有未经明确允许的流量。例如:

sudo iptables -P INPUT DROPsudo iptables -P FORWARD DROPsudo iptables -P OUTPUT ACCEPT上述命令将INPUT和FORWARD链的默认策略设置为DROP,仅允许已建立或相关连接的数据包通过INPUT链,OUTPUT链默认允许所有外出流量。 - 添加特定服务的允许规则: 接下来,为需要提供服务的端口添加允许规则,确保新连接可以通过防火墙。例如,允许外部访问本机的HTTP服务(端口80):

sudo iptables -A INPUT -p tcp --dport 80 -m state --state NEW -j ACCEPT这条规则允许新的HTTP连接请求通过防火墙。

通过以上的配置,防火墙会跟踪每个连接的状态,并依据这些状态信息来过滤数据包。只有当数据包属于已知的合法连接或新连接请求被允许时,才会通过防火墙,从而有效防止非法入侵和未经授权的访问。同时,状态检测防火墙可以大大减少误判,因为它可以根据连接状态区分正常流量和潜在攻击流量。

如果有大量的未连接的用户涌入网站,如何区分是潜在攻击流量还是正常访问?

区分大量未连接的用户涌入网站是正常访问还是潜在攻击流量,需要综合运用多种技术和策略:

- 流量分析:- 统计分析:监控实时流量指标,包括但不限于总体流量、并发连接数、新连接速率、数据包大小和频率等。如果这些指标短时间内急剧增长且远超正常业务峰值水平,则可能是攻击迹象。- 地理分布分析:检查流量来源的地理位置分布。正常访问通常有一定规律,而攻击流量可能来自全球各地,特别是在短期内出现大量异常IP地址。

- 行为分析:- 用户行为模式:观察用户的行为模式,正常访问通常表现出相对稳定的行为,而攻击流量可能表现为重复、相似或机械式的请求。- HTTP头部分析:检查HTTP头部信息,如User-Agent、Referer等,攻击流量可能具有高度一致或不寻常的特征。

- 连接状态检测:- TCP状态检测:正如前面提到的,状态检测防火墙可以追踪连接状态,对于大量未能完成三次握手的半开连接(SYN Flood攻击)或其他非正常状态的连接,可以判定为潜在攻击。

- 应用层分析:- 使用防火墙或WAF(Web应用防火墙):分析HTTP请求的内容、URL、请求参数等,WAF通常具有更智能的策略,可以识别SQL注入、XSS攻击等恶意行为。

- IP信誉与黑名单:- IP信誉服务:接入第三方IP信誉服务,通过查询IP信誉数据库判断流量来源是否为已知的攻击源或机器人网络。- 动态黑名单:对疑似攻击IP地址进行临时或永久封锁,阻止其继续发起连接请求。

- 负载均衡与CDN:- 负载均衡器:通过负载均衡器来分散流量,同时可以设置阈值,当某个IP地址的连接数超过阈值时,可以将其转移到专门的缓冲区或隔离区。- CDN服务:内容分发网络可以吸收大量请求,同时具有防护机制,可以过滤异常流量。

- DDoS防护服务:- 使用专业的DDoS防护服务,如阿里云、AWS等提供的服务,这些服务通常具有智能检测和流量清洗功能,可以准确区分正常流量和攻击流量。

综合运用上述方法,可以更有效地鉴别大量未连接用户涌入是正常访问还是潜在攻击。同时,持续监控和更新安全策略至关重要,因为攻击手法和技术也在不断演变。

什么是负载均衡?如何实现负载均衡?

负载均衡(Load Balancing)是一种计算机网络技术,旨在将工作负载分散到多个计算资源(如服务器、网络链接、CPU核心等)上,以提高服务的可用性、响应速度和整体系统性能。当多个服务器共同提供相同的服务时,负载均衡技术可以平均分配客户端请求,确保没有单一服务器过载,同时充分利用所有服务器的处理能力。

实现负载均衡主要有以下几种方式:

- 硬件负载均衡器:- 使用专用的硬件设备,如F5 BIG-IP、Citrix ADC(以前的NetScaler)等,它们能够高速、精准地分发网络流量。

- 软件负载均衡器:- 使用软件解决方案实现负载均衡,如Nginx、HAProxy、Apache HTTP Server的mod_proxy_balancer模块等。这些软件可以安装在普通的服务器上,通过配置实现负载均衡功能。

- 云服务负载均衡:- 公有云服务如阿里云SLB、AWS ELB、Azure Load Balancer等,提供了现成的负载均衡服务,用户只需在云平台上进行简单配置,即可实现对多个云服务器实例的流量分发。

- DNS负载均衡:- DNS负载均衡是通过DNS服务器根据预设策略将同一域名解析到不同的IP地址,将用户请求分散到多个服务器上。例如,根据地理位置、服务器负载或响应时间选择最佳服务器。

- IP负载均衡:- 使用网络层的负载均衡技术,如LVS(Linux Virtual Server),通过网络层的路由选择算法,将请求导向到不同的服务器。

- 应用层负载均衡(Layer 7 Load Balancing):- 应用层负载均衡器会根据应用层协议(如HTTP、HTTPS、SMTP等)的内容来分配请求,例如根据URL、会话状态、用户cookie等信息。

实现负载均衡的典型策略包括:

- 轮询(Round Robin):按照顺序依次将请求分配给不同的服务器。

- 加权轮询(Weighted Round Robin):根据服务器性能差异分配请求,性能好的服务器获取更多请求。

- 最少连接(Least Connections):将新请求分配给当前连接数最少的服务器。

- IP哈希(IP Hash):根据客户端IP地址的哈希值选择服务器,保证同一客户端的请求始终发送到同一服务器。

- 会话持久化(Session Persistence):确保来自同一客户端的连续请求被分配到相同的服务器,以保持会话状态的一致性。

根据实际业务需求和网络架构,可以选择合适的技术和策略实现负载均衡。

这些策略的适用场景知道吗?举几个例子。

不同负载均衡策略适用于不同的场景,以下是各种负载均衡策略及其适用场景的概述:

- 轮询(Round Robin):- 适用场景:所有服务器性能相近、处理请求耗时大致相同的情况下,均匀地分配请求到每个服务器。- 特点:公平分配流量,无需对服务器性能进行评估。

- 加权轮询(Weighted Round Robin):- 适用场景:服务器性能有差异,某些服务器处理能力更强。根据服务器权重分配请求,权重高的服务器获得更多的流量。- 特点:适应性强,可以灵活调整服务器负载比例。

- 最少连接(Least Connections):- 适用场景:服务器处理请求速度不完全一致,任务处理时间长短不固定,希望新到来的请求优先分配给当前活跃连接数最少的服务器。- 特点:有助于避免个别服务器过载,特别适合处理长连接或者请求处理时间不均匀的服务。

- IP哈希(IP Hash)- 适用场景:需要进行会话保持(Session Persistence),确保同一客户端的所有请求都被路由到同一服务器,以维持会话状态的一致性。例如,当应用程序依赖于客户端的Cookie或Session ID时。- 特点:确保客户端会话的一致性,避免在多个服务器间迁移会话导致的问题。

- 源IP地址哈希(Source IP Hash)- 类似于IP哈希,但根据的是客户端的源IP地址进行哈希运算来选择服务器,而非会话标识符。同样适用于需要会话一致性的情景,但不适合客户端IP地址变动频繁的情况。

- 最少时间(Least Time)- 适用场景:服务器性能随时间变化较大,可以根据服务器响应时间和健康检查结果动态调整分配策略,将请求发送到最快响应的服务器。- 特点:注重响应速度,实时动态调整负载均衡策略。

- 会话持久化(Session Persistence)- 除了IP哈希外,还有其他实现方式,如基于Cookie的粘性会话等。适用于Web应用服务器集群,确保用户在多次请求中始终访问同一服务器,保留会话状态。

综合考虑业务需求、服务器性能、网络状况、会话状态要求等因素,选择合适的负载均衡策略,可以有效提升服务质量和可用性。

你知道ChatGPT类似平台的IM系统是如何实现负载均衡的吗?

尽管我不能直接获知特定公司的内部实现细节,但我可以基于常见的技术和行业实践推测和建议一种高并发IM系统如何实现负载均衡。

在构建一个高并发即时通讯(IM)系统时,如类似ChatGPT这样的对话式AI平台,实现负载均衡可以采取以下策略:

- 水平扩展:- 使用分布式服务器集群,部署多个聊天服务实例,每个实例都能够处理用户的聊天请求。- 对于聊天消息的存储,可以使用分布式数据库或者NoSQL数据库,如MongoDB、Cassandra等,实现数据的水平扩展。

- 负载均衡器:- 在服务器集群前端部署负载均衡器,如Nginx、HAProxy、AWS的ELB、阿里云的SLB等,根据负载均衡算法(如轮询、最少连接数、IP哈希等)将用户请求均匀地分发到各个聊天服务实例上。- 对于WebSocket或长连接场景,负载均衡器也需要支持长连接的转发和保持。

- 服务注册与发现:- 使用服务注册与发现机制(如Consul、Etcd、Zookeeper、Kubernetes Service等),使得聊天服务实例能够动态注册自身并在上线或下线时自动更新负载均衡器中的服务列表。

- 消息队列与异步处理:- 采用消息队列(如RabbitMQ、Kafka、RocketMQ等)进行消息的异步处理,减轻聊天服务实例的压力,同时也实现请求的负载均衡。- 对于高并发场景,可以将聊天消息的生产和消费分离,通过消息队列来削峰填谷,实现更高效的资源利用。

- 实时通信协议的选择与优化:- 使用适合高并发低延迟的实时通信协议,如WebSocket、MQTT、gRPC等,并对其协议层进行优化,如使用HTTP/2、QUIC等更快更有效的传输层协议。

- CDN与边缘计算:- 对于前端静态资源和可能的预处理,可以借助CDN加速内容分发,减少服务器负载;同时,通过边缘计算节点处理部分简单的对话逻辑,降低中心服务器压力。

- 数据分区与缓存:- 对于用户会话数据、对话历史等,可以采取数据分区和缓存策略,将热点数据存储在内存数据库(如Redis、Memcached)中,减少对后端数据库的访问压力。

通过上述策略的组合使用,ChatGPT等相关平台的IM系统能够实现高并发情况下的负载均衡,确保服务的稳定性和响应速度。同时,定期进行压测和性能调优也是必不可少的环节。

发起提问的用户过多怎么办?该如何解决?

针对线上服务(如即时通讯系统、在线客服系统、API接口服务、网页应用等)中可能出现的用户过多导致并发访问压力大的问题,可以采取以下策略来解决:

- 负载均衡:- 在服务器端部署负载均衡器,如Nginx、HAProxy、AWS Elastic Load Balancer等,将用户请求均匀地分发到多个服务器节点上,确保资源合理分配和利用。

- 水平扩展:- 根据负载情况动态增加服务器数量,横向扩展服务能力。可以通过云计算平台快速扩容服务器资源,或是使用容器技术(如Docker)和编排工具(如Kubernetes)实现弹性伸缩。

- 分布式系统设计:- 将系统拆分成微服务架构,每个服务都可以独立扩展,这样可以针对性地对高负载的服务进行扩容。

- 数据库读写分离和分库分表: 面试必备:聊聊MySQL的主从 (qq.com) 分库分表经典15连问 (qq.com)- 对于数据库访问瓶颈,可以采用主从复制进行读写分离,将读取请求分散到多个从库上。同时,根据业务需求进行数据分片和分区,降低单个数据库的负载。

- 缓存策略:使用Redis,你必须知道的21个注意要点 (qq.com)- 对于热点数据,使用缓存系统(如Redis、Memcached)存放,减少对数据库的访问压力。

- 限流与排队:面试必备:4种经典限流算法讲解 (qq.com)- 设计合理的限流策略,如令牌桶算法或漏桶算法,对瞬时大量涌入的请求进行控制,防止系统过载。对于超出处理能力的请求,可以放入队列进行异步处理。

- 优化资源分配:- 优化代码逻辑,减少不必要的计算和I/O操作,提升服务器性能。- 动态调整服务器资源分配,如CPU、内存和磁盘I/O,确保高负载时资源合理分配。

- 提前规划和预测:- 根据业务特点和历史数据分析,提前预测高峰时段,并在这些时段前进行资源扩容,以应对高并发访问。

- 用户行为引导:- 通过UI设计或运营策略,例如提示用户在高峰时段错峰访问,或引导部分非紧急需求的用户稍后访问,减轻瞬间压力。

总之,解决并发用户过多的问题需要结合多种技术手段和策略,通过优化架构、合理分配资源、引入负载均衡机制等方式,确保系统的稳定性和用户体验。同时,对系统的监控和性能分析也是至关重要的,以便及时发现问题并作出调整。

还知道哪些常见的限流算法?会写吗?

常见的限流算法包括但不限于以下几种:

- 固定窗口限流算法(Fixed Window Algorithm)- 在一个固定的时间窗口内(如1分钟),统计请求次数,当请求次数超过预设的阈值时,开始拒绝请求。

- 滑动窗口限流算法(Sliding Window Algorithm)- 滑动窗口算法是在一段时间窗口内进行动态统计,窗口随着时间滑动,实时计算单位时间内的请求次数,相比固定窗口算法更为精确,解决了窗口临界问题。

- 计数器算法(Counter-based Algorithm)- 通过一个计数器记录单位时间内的请求次数,当达到预设阈值时开始限流。

- 漏桶算法(Leaky Bucket Algorithm)- 模拟一个装满水的桶,水以恒定速率流出,新来的请求如同水滴,如果桶满了,新来的请求就会被丢弃。此算法可以平滑突发流量,但不能应对突增的流量尖峰。

- 令牌桶算法(Token Bucket Algorithm)- 系统以恒定速率生成令牌放入桶中,每次请求需要从桶中取出一个令牌,如果桶为空,则拒绝请求。令牌桶可以允许突发流量,只要令牌充足。

由于这里无法直接运行代码,但我可以为你提供更加详细的伪代码和解释,帮助你理解如何在真实的编程环境中实现这些限流算法。

固定窗口限流算法(Fixed Window Counter)

import java.util.concurrent.atomic.AtomicInteger;

import java.util.concurrent.TimeUnit;

public class FixedWindowLimiter {

private final int limit;

private final long windowDurationMillis;

private final AtomicInteger requestCounter;

private volatile long currentWindowEndTimestamp;

public FixedWindowLimiter(int limit, int windowDurationSeconds) {

this.limit = limit;

this.windowDurationMillis = TimeUnit.SECONDS.toMillis(windowDurationSeconds);

this.requestCounter = new AtomicInteger(0);

this.currentWindowEndTimestamp = calculateNextWindowEnd();

}

public boolean tryAcquire() {

long now = System.currentTimeMillis();

if (now < currentWindowEndTimestamp) {

// 当前仍在窗口期内

if (requestCounter.incrementAndGet() <= limit) {

return true;

} else {

// 超过限制,回滚计数并拒绝

requestCounter.decrementAndGet();

return false;

}

} else {

// 窗口切换,重置计数器

resetWindow(now);

// 继续尝试获取,因为现在处于新的窗口期

return tryAcquire();

}

}

private void resetWindow(long now) {

requestCounter.set(0);

currentWindowEndTimestamp = calculateNextWindowEnd(now);

}

private long calculateNextWindowEnd(long currentTimeMillis) {

return currentTimeMillis / windowDurationMillis * windowDurationMillis + windowDurationMillis;

}

}

// 使用:

FixedWindowLimiter limiter = new FixedWindowLimiter(100, 60); // 每分钟限制100个请求

while (...) { // 假设这是请求到来的地方

if (limiter.tryAcquire()) {

// 处理请求

} else {

// 请求被限流,执行相应的限流逻辑(如返回错误信息等)

}

}

优点:

- 实现简单,易于理解。

- 能够较为均匀地在整个窗口周期内分配请求。

缺点:

- 存在窗口边界问题,即在窗口切换时可能发生突刺效应,即在窗口结束的瞬间,所有剩余的请求额度可能会一次性释放,导致下一窗口开始时瞬间流量激增。

- 对于周期内的流量波动反应不够灵敏,可能造成资源浪费或过度限流。

应用场景:

- 对于请求均匀分布且对突发流量不太敏感的服务,例如定时任务执行或稳定的后台服务。

滑动窗口限流算法(Sliding Window Counter)

import java.util.LinkedList;

import java.util.List;

import java.util.concurrent.locks.Lock;

import java.util.concurrent.locks.ReentrantLock;

public class SlidingWindowLimiter {

private final int limit;

private final long windowSizeMillis;

private final LinkedList<Long> timestamps;

private final Lock lock;

private long currentTimestamp;

public SlidingWindowLimiter(int limit, int windowSizeSeconds) {

this.limit = limit;

this.windowSizeMillis = TimeUnit.SECONDS.toMillis(windowSizeSeconds);

this.timestamps = new LinkedList<>();

this.lock = new ReentrantLock();

this.currentTimestamp = System.currentTimeMillis();

}

public boolean tryAcquire() {

lock.lock();

try {

currentTimestamp = System.currentTimeMillis();

while (!timestamps.isEmpty() && timestamps.peekFirst() <= currentTimestamp - windowSizeMillis) {

timestamps.removeFirst(); // 移除过期窗口内的请求记录

}

if (timestamps.size() < limit) {

timestamps.addLast(currentTimestamp);

return true;

} else {

return false;

}

} finally {

lock.unlock();

}

}

}

// 使用:

SlidingWindowLimiter limiter = new SlidingWindowLimiter(100, 60); // 每分钟限制100个请求,滑动窗口

while (...) {

if (limiter.tryAcquire()) {

// 处理请求

} else {

// 请求被限流

}

}

优点:

- 解决了固定窗口算法的窗口边界问题,能够更平滑地控制流量。

- 更加准确地控制单位时间内的请求总数。

缺点:

- 实现比固定窗口算法复杂,需要维护窗口内请求的时间戳列表。

- 对于非常短的窗口,性能开销可能会增大。

应用场景:

- 对流量控制要求更严格,不允许窗口边界突刺效应的服务,例如金融交易、支付系统等高并发场景。

漏桶算法(Leaky Bucket):

下面是一个简化的内存漏桶实现,实际应用中可能需要队列和定时任务配合:

import java.util.Queue;

import java.util.concurrent.ConcurrentLinkedQueue;

import java.util.concurrent.Executors;

import java.util.concurrent.ScheduledExecutorService;

import java.util.concurrent.TimeUnit;

public class LeakyBucketLimiter {

private final Queue<Request> queue = new ConcurrentLinkedQueue<>();

private final int bucketCapacity;

private final ScheduledExecutorService scheduler;

private final Runnable leakTask;

public LeakyBucketLimiter(int capacity, int leakRatePerSecond) {

this.bucketCapacity = capacity;

this.leakTask = () -> {

while (!queue.isEmpty() && !Thread.currentThread().isInterrupted()) {

Request req = queue.poll();

// 这里假设处理请求(例如释放资源)

}

};

// 创建定时任务模拟漏水效果

scheduler = Executors.newSingleThreadScheduledExecutor();

scheduler.scheduleAtFixedRate(leakTask, 0, 1, TimeUnit.SECONDS);

}

public boolean tryAcquire(Request request) {

if (queue.size() < bucketCapacity) {

queue.offer(request);

return true;

} else {

// 桶满则直接拒绝

return false;

}

}

public void shutdown() {

scheduler.shutdownNow();

}

}

// Request 类型代表请求,可以根据实际情况设计

class Request {}

// 使用:

LeakyBucketLimiter limiter = new LeakyBucketLimiter(100, 50); // 容量为100,每秒泄漏(处理)50个请求

while (...) {

if (limiter.tryAcquire(new Request())) {

// 将请求放入漏桶

} else {

// 请求被限流

}

}

// 不再使用时关闭调度器

limiter.shutdown();

优点:

- 无论请求何时到达,都能按照设定速率处理,能很好地平滑突发流量。

- 可以精确地控制输出速率。

缺点:

- 对于突发的大批请求,可能会丢失部分请求,无法充分利用系统的处理能力。

- 不太适合处理波动较大的流量。

应用场景:

- 对于需要严格控制输出速率,对外部请求响应速度有稳定要求的服务,如网络传输速率控制、消息队列处理等。

令牌桶算法(Token Bucket)

对于令牌桶算法,Guava库中的

RateLimiter

已经提供了很好的实现,但为了展示基本思路,也可以自己简单实现:

import java.util.concurrent.Executors;

import java.util.concurrent.ScheduledExecutorService;

import java.util.concurrent.TimeUnit;

import java.util.concurrent.atomic.AtomicInteger;

public class TokenBucketLimiter {

private final int bucketCapacity;

private final int refillRateTokensPerSecond;

private final AtomicInteger tokenCount;

private final ScheduledExecutorService scheduler;

public TokenBucketLimiter(int capacity, int refillRate) {

this.bucketCapacity = capacity;

this.refillRateTokensPerSecond = refillRate;

this.tokenCount = new AtomicInteger(capacity);

// 定时补充令牌

scheduler = Executors.newSingleThreadScheduledExecutor();

scheduler.scheduleAtFixedRate(() -> {

int currentTokens = tokenCount.getAndAdd(-refillRateTokensPerSecond);

if (currentTokens + refillRateTokensPerSecond <= bucketCapacity) {

// 如果没有溢出,直接补充令牌

tokenCount.set(Math.min(bucketCapacity, currentTokens + refillRateTokensPerSecond));

}

}, 0, 1, TimeUnit.SECONDS);

}

public boolean tryAcquire() {

while (true) {

int currentTokens = tokenCount.get();

if (currentTokens > 0) {

// 有足够的令牌

if (tokenCount.compareAndSet(currentTokens, currentTokens - 1)) {

return true;

}

} else {

// 无令牌可取,限流

return false;

}

}

}

public void shutdown() {

scheduler.shutdownNow();

}

}

// 使用:

TokenBucketLimiter limiter = new TokenBucketLimiter(100, 50); // 初始令牌100,每秒补充50个令牌

while (...) {

if (limiter.tryAcquire()) {

// 处理请求

} else {

// 请求被限流

}

}

// 不再使用时关闭调度器

limiter.shutdown();

优点:

- 和漏桶算法一样,可以平滑突发流量。

- 允许一定程度的突发请求,只要令牌桶中有足够的令牌,请求就可以被处理。

- 可以快速响应流量的变化。

缺点:

- 实现相对复杂,需要维护令牌生成和消耗的逻辑。

- 初始阶段可能令牌较少,对突发请求的响应不如后期快。

应用场景:

- 对于既要控制平均流量又要允许偶尔的突发流量的服务,例如视频流媒体、社交网络等高并发场景。

总结而言,选择哪种算法取决于具体的业务需求,包括对流量波动的容忍度、是否允许突发请求、响应速度要求等方面。在实践中,令牌桶算法因其兼顾平滑流量和允许突发请求的优点,常常被用于处理复杂的限流需求。

如果大模型算力不足,怎么在算力,模型不变的情况下提高服务端大模型对话系统的性能?

在算力和模型结构不变的情况下,提高服务端大模型对话系统的性能可以从以下几个方面入手:

- 优化存储和计算效率:- 模型量化:通过模型量化技术(如INT8量化或混合精度量化),减少模型参数的存储需求和计算负担,提高推理速度。- 知识蒸馏:将大模型的知识蒸馏到一个小模型中,减小模型大小的同时保持较高的准确率。

- 缓存与索引优化:- 缓存策略:对常见问题和答案进行缓存,减少模型推理次数,特别是对于高频问题,可以极大提高响应速度。- 知识库索引优化:如果大模型与知识库交互,优化索引结构和查询算法,提高知识查找速度。

- 服务端优化:- 负载均衡:通过负载均衡技术分配请求到多个模型副本,避免单个模型过载。- 并发控制:合理控制并发请求的数量,避免过多请求导致资源争抢。- GPU资源共享:利用CUDA等技术实现GPU多进程或多线程并行计算,提高GPU利用率。

- 请求过滤与预处理:- 请求筛选:设置前置过滤规则,减少无效或重复的请求,减轻模型压力。- 预处理优化:对用户输入进行有效预处理,简化模型输入,降低模型计算复杂度。

- 模型剪枝与稀疏化:- 模型剪枝:剔除模型中对性能贡献较小的参数,减少模型规模,加快计算速度。- 稀疏矩阵运算:利用稀疏矩阵运算库,对模型中的稀疏参数进行高效计算。

- 延迟容忍策略:- 优先级排序:对请求设置优先级,优先处理重要或紧急的请求,非紧急请求可适当延后处理。

- 改进对话策略:- 上下文敏感对话:优化对话模型对上下文的理解和记忆能力,尽可能减少重复计算和无意义的循环对话。- 短路逻辑:对于简单或常见问题,设置快捷回答路径,不必每次都完整运行大模型。

- 基础设施升级:- 硬件升级:虽然你提到了算力不变,但如果可能的话,适时升级硬件设施,如使用高性能GPU、TPU或其他加速器,或者通过云计算平台租用更强算力资源。

- 服务优化:- API Gateway:使用API Gateway来聚合和管理请求,减少网络通信开销。- 冷热数据分离:将近期常用的模型参数放在高速存储介质中,减少I/O延迟。

这些优化方法并非孤立使用,而是需要结合具体应用场景和系统架构综合考虑,通过一系列技术手段来改善大模型对话系统的性能表现。

如何进行知识库索引优化?

知识库索引优化是一个旨在提高搜索效率和响应速度的过程,确保用户能够快速准确地在知识库中找到所需信息。以下是一些进行知识库索引优化的方法:

- 选择恰当的索引类型:- 全文索引:对于文本类知识库,全文索引可以索引文档的全部内容,支持关键词搜索,可通过词根分解、停用词过滤等技术优化索引大小和搜索性能。- 倒排索引:在搜索引擎中广泛使用的索引结构,将词语与其所在的文档关联起来,查询时从词语出发查找包含该词语的文档。

- 字段索引:- 根据用户检索习惯和知识库内容特点,对经常用于搜索的关键字段(如标题、标签、作者、分类等)创建单独索引。

- 前缀索引:- 对于较长的字符串字段,如URL或文档ID,可以创建前缀索引,以减少索引大小并提高部分匹配查询的性能。

- 复合索引:- 创建复合索引(多列索引),当查询涉及多个字段时,复合索引可以大幅提高查询效率,但要注意复合索引的列顺序应当遵循最左前缀原则。

- 覆盖索引:- 覆盖索引是指索引中包含了查询需要的所有字段,查询可以直接从索引中获取结果,而无需访问原始数据,极大地减少了IO操作。

- 索引维护:- 定期维护索引,如重建索引以消除碎片,移除不再需要的索引以减少存储和维护成本。

- 索引选择策略:- 分析查询日志,找出最常执行的查询和慢查询,为这些查询涉及的字段创建或优化索引。

- 索引去重:- 对于含有大量重复值的字段,可能需要考虑是否有必要建立索引,以免造成索引过大但效果不明显的现象。

- 索引更新策略:- 在知识库内容频繁更新的场景下,需要考虑索引更新的开销和策略,比如延迟索引更新、批量更新索引等。

- 性能测试与监控:- 定期进行索引性能测试,监控索引的使用情况和性能表现,根据实际情况调整索引结构和配置。

在具体实施时,根据知识库所使用的数据库系统(如MySQL、PostgreSQL、MongoDB等)和搜索技术(如Elasticsearch、Solr等),选择和应用对应的索引优化技术。同时,注意平衡索引带来的查询性能提升与索引维护、存储空间等方面的代价。

什么是索引?

索引是一种数据结构,用于快速访问数据库、文件系统或者其他数据存储系统中的信息。在数据库中,索引是对数据库表中一列或多列数据建立的一种特殊数据结构,用来加速对表中数据行的查找和排序操作。MySQL索引优化总结_mysql索引优化的几种方式-CSDN博客

当表的数据量非常大时,如果不使用索引,数据库在执行查询时可能需要扫描整个表来找到匹配的数据行,这是非常低效的。而通过索引,数据库可以更快地定位到所需的数据,就像一本书的目录可以帮助读者迅速找到感兴趣的章节一样。

在数据库领域中,常见的索引类型包括:

- B-Tree索引(包括B-Tree和B+Tree)

- 哈希索引

- Bitmap索引

- 全文索引

- R-Tree索引(用于空间数据索引)

对于不同类型的查询,数据库会选择最适合的索引类型以提高查询性能。不过,需要注意的是,虽然索引可以极大地提高查询速度,但也会占用额外的存储空间,并可能影响插入、更新和删除数据时的性能。因此,在数据库设计时需要根据实际应用场景合理创建和管理索引。

怎么优化mysql索引?

MySQL数据库中优化索引的方法可以从以下几个方面来进行:

- 选择合适的索引列:- 确定业务中频繁作为WHERE条件、JOIN连接条件、ORDER BY和GROUP BY的列作为索引候选列。- 对于UPDATE和DELETE频繁的列,如果不是查询条件,尽量避免为其创建索引,因为每次修改都会导致索引重建,增加开销。

- 创建复合索引:- 当查询条件涉及多个列时,可以创建复合索引。复合索引的列顺序非常重要,应遵循最左前缀原则,即在查询语句中,索引的第一列是必须参与条件的,之后的列可以按需使用。

CREATE INDEX idx_example ON table_name (col1, col2, col3); - 避免冗余索引:- 删除冗余索引,如果多个索引包含相同的列并且顺序相同,那么保留一个即可。

- 考虑索引选择性:- 高选择性的列(唯一值较多的列)更适合创建索引,因为它们能更精确地定位到数据。

- 区分度高的列优先:- 对于区分度很高的列(如性别就不如身份证号区分度高),优先考虑创建索引。

- 使用覆盖索引:- 尽可能使查询只需要通过索引就能获取所有需要的数据,无需访问表数据,这称为覆盖索引。例如,如果查询只需要索引列加上其他索引列的查询结果,创建一个包含所有必要列的复合索引可以避免额外的随机I/O。

- 考虑查询优化:- 修改查询语句,使其能更好地利用已有的索引,例如避免在索引列上使用函数、不使用NOT操作符等。

- 定期分析和重构索引:- 使用

ANALYZE TABLE命令分析表,让MySQL了解表的统计信息,以便做出更优的查询计划。- 对于频繁更新的表,定期检查并清理不再需要的索引。 - 索引维护:- 对于大数据量表,定期重建或优化索引,以修复索引碎片,提高索引效率。

- 考虑索引类型:- 根据业务场景选用合适的索引类型,如对于全文搜索,可以考虑使用全文索引(FULLTEXT)。

总之,索引优化是一项细致的工作,需要结合具体业务需求和查询性能分析,才能得出最优的索引策略。同时,数据库管理系统版本、硬件资源配置等也是影响索引效果的重要因素。

知识库一般使用什么数据库存储,索引底层原理是什么?

知识库的存储方式可以根据知识库的类型、规模、访问模式和查询需求等因素选择合适的数据库系统。常见的知识库数据库存储方案包括关系型数据库(如MySQL、PostgreSQL)、NoSQL数据库(如MongoDB、Cassandra)、全文搜索引擎(如Elasticsearch、Solr)、图数据库(如Neo4j)以及知识图谱存储系统(如Blazegraph、Amazon Neptune)等。

对于索引的底层原理,以下以关系型数据库为例说明:

在关系型数据库中,索引是对数据库表中一列或多列的值进行预处理和组织的数据结构,它提高了数据检索的速度,降低了数据库查询的成本。索引的底层原理主要体现在以下几点:

- B-Tree索引:- B-Tree索引是最常用的索引结构,尤其在MySQL InnoDB存储引擎中。B-Tree索引将数据以树状结构组织,每个节点存储一部分数据,并通过指针连接层级结构中的下一个节点。查找时,可以很快定位到数据所在的叶子节点,从而实现快速检索。

- 哈希索引:- 哈希索引(如MySQL Memory存储引擎支持)使用哈希函数将索引键转化为哈希值,然后通过哈希表快速定位数据。哈希索引特别适用于等值查询,但对于范围查询、排序等操作效率较低,因为哈希表不具备有序性。

- R-Tree索引:- R-Tree索引主要用于处理地理空间数据,存储多维数据的索引,可以加速空间查询。

- 全文索引:- 全文索引适用于文本搜索,MySQL有自己的全文索引机制,而全文搜索引擎(如Elasticsearch)则有更复杂的倒排索引结构。倒排索引将单词作为关键字,记录每个单词出现在哪些文档中,从而实现快速全文检索。

- 位图索引:- 位图索引主要用于处理大量重复值且基数较小的列,如性别、行政区划等。位图索引用二进制位数组表示数据,大大减少了存储空间。

索引的底层实现通常包括以下步骤:

- 创建索引:对选定的列或列组合计算索引值,并按照特定的排序规则存储到索引结构中。

- 查找索引:当执行查询时,数据库系统首先检查查询语句是否可以利用索引,若是,则通过索引结构快速定位到相应数据行的位置。

- 维护索引:当对表进行插入、删除或更新操作时,数据库需要同步更新索引结构,以保持数据和索引的一致性。

选择合适的索引类型、设计合理的索引策略,并根据业务场景和查询模式优化索引,是提高知识库性能的重要手段。

为什么要使用索引?

使用索引的主要原因在于显著提高数据库系统的查询性能,具体包括以下几个方面:

- 加速查询速度: 索引提供了数据的快速访问路径。通过索引,数据库系统能够在较短的时间内找到满足查询条件的数据,尤其是对于大型表来说,索引可以大幅度减少全表扫描的时间,提高查询效率。

- 减少磁盘I/O: 没有索引时,数据库可能需要进行全表扫描来查找数据,这会导致大量的磁盘读取操作。而有了索引,数据库可以迅速定位到数据所在位置,从而减少磁盘I/O,这对于存储在硬盘上的数据尤为重要。

- 优化排序与分组操作: 当查询语句包含ORDER BY、GROUP BY等操作时,如果对应的字段有索引,数据库可以利用索引的有序性来更快地完成排序和分组操作,而不是在内存中重新排序所有数据。

- 唯一性约束: 对于唯一性索引(UNIQUE INDEX),数据库能够确保索引列的唯一性,避免数据冗余和错误。

- 关联查询优化: 在多表关联查询中,索引可以提高JOIN操作的性能,通过索引可以更快地找到关联数据。

然而,值得注意的是,虽然索引带来诸多好处,但也存在一些潜在的负面影响:

- 索引需要额外的存储空间,会占用物理磁盘资源;

- 插入、删除和更新操作时,数据库不仅要修改数据本身,还需维护索引结构,这会增加数据库维护索引的开销;

- 不适当的索引或过度索引反而可能导致查询性能下降,因为数据库需要在多个索引间做出选择,或者在更新时同步更多索引。

因此,在设计数据库时应根据实际业务需求和查询模式合理创建和维护索引。

什么是B-Tree (B树) ,Mysql的索引用了什么树?Linux的文件索引用了什么树?

B-Tree (B树) 是一种自平衡的树形数据结构,非常适合用于数据库和文件系统索引。在B-Tree中,数据分布在多级节点上,每个节点可以包含多个键和多个子节点的指针。每个节点的关键特性在于:

- 所有叶子节点都在同一层,方便范围查询。

- 每个节点都可以存储多个键值对和子节点指针,所以相对于二叉查找树,B-Tree在每个节点上能存储更多的信息,从而减少查询所需的磁盘I/O次数。

- B-Tree在插入和删除数据时能自动保持树的平衡,使得查询效率相对稳定。

MySQL的索引: 在MySQL数据库中,默认的存储引擎InnoDB使用了B-Tree的变体B+Tree作为索引结构,尤其是在处理整数和字符串类型的索引时。B+Tree相较于B-Tree的主要改进在于:

- 所有叶子节点形成一个连续的链表,方便区间扫描。

- 非叶子节点不存储数据,只存储键值和子节点指针,数据只存储在叶子节点上。

Linux的文件索引: Linux文件系统的索引结构根据不同文件系统有不同的实现,但目前许多主流的文件系统,如EXT4、XFS、Btrfs等,主要使用B-Tree或者B-Tree变种(如HTree索引在ext2/ext3中,B+Tree在ext4中)作为元数据索引和目录项索引。

例如,在EXT4文件系统中,inode(索引节点)的查找通常使用B+Tree实现,这样可以高效地定位文件系统中的文件和目录。而对于大量小文件,EXT4还引入了HTree索引,这是一种特殊的B-Tree变种,用于优化目录索引,提高目录查询性能。而在XFS文件系统中,使用了B+Tree来索引整个文件系统中的块位置,以支持大容量存储和高效检索。

B树和B+树的区别是什么?为什么使用B+树?

B树(B-Tree)和B+树(B+Tree)都是用于数据存储和检索的自平衡树数据结构,它们在设计上有以下关键区别:MySQL索引底层:B+树详解 - 掘金 (juejin.cn)一文彻底搞懂MySQL基础:B树和B+树的区别_mysql b树和b+树的区别-CSDN博客

- 数据存储位置:- B树:每个节点(包括内部节点和叶子节点)都可以存储数据(键值对)。这意味着搜索过程中,沿途经过的内部节点也可能存储待查找的数据。- B+树:内部节点(非叶子节点)只存储键而不存储数据,所有数据都存储在叶子节点上。叶子节点不仅包含键,还包含指向实际数据的指针或直接存储数据。

- 叶子节点链接:- B树:叶子节点各自独立,不互相链接。- B+树:所有叶子节点通过指针形成一个链表,这使得进行范围查询时,可以从一个叶子节点轻松跳转到下一个叶子节点,非常高效。

- 键的重复:- B树:键在内部节点和叶子节点中都可能出现,因此可能存在重复。- B+树:键只在内部节点中出现,叶子节点上的键不重复,且形成了有序链表。

- 磁盘I/O效率:- B树:因为内部节点也可以存储数据,所以在某些情况下,可能需要多次磁盘I/O才能获取数据。- B+树:由于所有数据都集中在叶子节点,且叶子节点紧密连接,所以在大多数查询场景下,只需要从根节点到叶子节点的一次递归就可以定位到数据,磁盘I/O效率较高。

为什么使用B+树:

- 范围查询效率:B+树的叶子节点形成的有序链表使得范围查询更加高效,只需要遍历链表即可,而B树需要递归遍历每个节点。

- 存储效率:B+树内部节点不存储数据,可以容纳更多的键,这样可以降低树的高度,进而减少磁盘I/O次数,提高查询性能。

- 缓存友好:在数据库系统中,B+树的内部节点不存储数据,可以更有效地利用缓存,因为一次缓存可以加载更多的键,提高命中率。

因此,B+树在数据库和文件系统中广泛用于索引结构,特别是对于需要大量读取操作和范围查询的应用场景,如MySQL等关系型数据库的索引就采用了B+树结构。

底子不错,抗住了DDos攻击,最后一个问题,防火墙和网关有什么区别?

防火墙和网关是两种不同的网络设备,它们各自在计算机网络中承担着不同的角色和功能。下面是防火墙和网关的主要区别:什么是网关,网关的作用是什么? - 知乎 (zhihu.com)

- 防火墙(Firewall):- 定义:防火墙是一种网络安全设备(可以是软件形式或硬件形式),设计用于监控并控制进出特定网络的所有流量。- 功能:防火墙的核心功能是根据预设的安全策略判断网络流量是否允许通过。它主要关注于保护内部网络免受未经授权的外部访问,通过对数据包进行过滤、状态检查和作为应用代理等方式,阻止潜在的恶意流量进入内部网络,同时允许合法的通信通过。- 工作层次:通常,防火墙在OSI模型的第三层(网络层)及以上的层级工作,有些高级防火墙甚至能在应用层(第七层)进行深度包检测。

- 网关(Gateway):- 定义:网关是一个更为抽象的概念,它可以是一个物理设备(如路由器、服务器或防火墙),也可以是一个逻辑概念。网关主要负责不同网络、不同协议或不同安全域之间的通信。- 功能: - 协议转换:如果两个网络使用的协议不同,网关会转换数据包,确保它们可以在目标网络中被正确解析。- 路由选择:网关决定如何将数据从一个网络转发到另一个网络,这是通过路由表和路由协议来实现的。- 安全网关:除了基本的路由功能外,安全网关还增加了安全功能,它可以执行深度防御策略,包括但不限于身份验证、加密、反病毒扫描、入侵检测等,因此也起到了类似防火墙的作用。- 工作层次:网关通常在网络层(第三层)及更高层次工作,因为它们需要理解多个协议层的信息以便于进行有效的数据封装和转换。

简单来说,防火墙主要是为了网络安全而设计的,侧重于防止非法访问;而网关则更多地关注于网络间的连接和通信,其中安全网关则是具备了额外安全功能的网关设备,集成了防火墙的部分或全部功能。在现代网络环境中,两者往往共同存在于网络架构中,协同工作以提供多层次的安全防护和网络互联服务。

协议转换(Protocol Translation)是如何实现的?

协议转换是指将一种网络协议的数据格式转换为另一种网络协议的数据格式,以便不同协议的网络能够相互通信。实现协议转换通常需要专门的设备或软件,例如协议转换器(Protocol Translators)或网关(Gateways)。以下是协议转换的一般过程:

- 解析原协议:- 首先,协议转换器接收到数据包后,根据源协议的格式规范对其进行解析,提取出有效载荷和其他相关信息。

- 映射数据:- 然后,将源协议的数据结构和字段映射到目标协议的数据结构和字段上。这一步可能需要重新打包数据,或者将一种类型的编码(例如ASCII字符)转换为另一种编码(如UTF-8)。

- 构造目标协议数据包:- 根据目标协议的格式规范,用转换后的数据构造一个新的数据包,包括封装必要的头部信息,如地址、校验和、控制标志等。

- 发送目标协议数据包:- 最后,将构造好的目标协议数据包发送到目标网络。

例如,TCP/IP协议栈中的私有IP地址通过NAT(Network Address Translation)转换为公网IP地址,这也是一个特定形式的协议转换。

路由选择(Routing)是如何实现的?

路由选择是路由器决定如何将数据包从源地址转发到目的地地址的过程。以下是如何实现路由选择的基本步骤:

- 构建路由表:- 路由器通过多种途径获取路由信息,如静态配置、动态路由协议(如RIP、OSPF、BGP等)或DHCP。这些信息填充到路由表中,路由表记录了到各个网络或特定主机的下一跳地址和度量值(如跳数、带宽、延迟等)。

- 查找路由表:- 当路由器接收到数据包时,它会查看数据包的目标IP地址,并根据路由表查找匹配项。路由表中的每一个条目都有一个网络掩码和一个目标网络地址范围,以及相关的下一跳信息。

- 转发决策:- 如果找到了匹配项,路由器会根据路由表中的信息,将数据包转发到指定的下一跳地址。如果没有找到明确的匹配项,则根据默认路由(default route)或其他策略(如黑洞路由)处理。

- 更新路由信息:- 动态路由协议会不断地与邻居路由器交换路由信息,以便更新路由表,适应网络拓扑的变化。

- 执行QoS策略:- 在某些高端路由器中,还会基于服务质量(Quality of Service, QoS)策略对不同流量进行优先级排序,进一步决定数据包的转发顺序和路径选择。

总的来说,协议转换是网络层及应用层之间的转换机制,而路由选择主要发生在网络层,它们共同构成了网络通信的基础要素。

版权归原作者 JAVA技术开发员 所有, 如有侵权,请联系我们删除。