Hadoop分布式安装部署软件

VMware Workstation Pro17

CentOS7

Hadoop-3.3.6

jdk1.8.0_391

第一步:创建虚拟机

修改网络配置

事先需要在本地电脑安装VMware,再创建虚拟机,并且克隆该虚拟机,使用多台机器配合完成完全的分布式文件系统。本文使用三台虚拟机搭建Hadoop。

Hadoop在安装部署之前,需要对虚拟机进行网络配置,将虚拟机的网络状态由动态修改为动态,通过对/etc/sysconfig/network-scripts/ifcfg-ens33修改再支持systemctl restart network.service重新启动网络即可生效。

其余两台机器也需要将网络同步修改为静态网络。

主机名与IP映射

修改主机名在/etc/hostname中修改,再重启系统即可修改成功

主机名与IP映射需要在/etc/hosts中添加

可使用ping命令测试是否能够连接,三台虚拟机均需进行此项操作。

第二步:安装JDK和Hadoop

安装JDK

- 创建linux系统时默认自带安装了openjdk,需要先将openjdk卸载后再重新安装jdk。

- 使用rpm -qa | grep jdk查询openjdk的安装包,再使用rpm -e --nodeps + 安装包将其卸载。

- 使用tar -zvxf + jdk压缩包路径将其解压

- 在/etc/profile修改环境变量,再使用source /etc/profile使其生效

export JAVA_HOME=/usr/java/jdk1.8.0_391

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

安装Hadoop环境

同样先将hadoop压缩包解压,在/etc/profile添加环境变量,再source /etc/profile。

export HADOOP_HOME=/usr/local/hadoop-3.3.6

export HADOOP_PREFIX=$HADOOP_HOME

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

修改Hadoop相关配置文件,具体文件配置详情:Hadoop安装部署之修改配置文件

第三步:ssh免密登录

防火墙关闭(三台机器)

- 关闭防火墙:systemctl stop firewalld.service

- 禁止防火墙自启动:systemctl disable firewalld.service

- 查看防火墙状态:systemctl status firewalld.service

ssh免密登录

- 主机器终端执行:ssh-keygen #需要多次回车生成公钥、私钥

- 将其复制到这三台机器中:ssh-copy-id 主机名

- 使用ssh 主机名免密登录,exit命令即可推出

第四步:Hadoop初始化

将主机器的hadoop文件使用scp命令复制到其余两台机器,因hadoop文件太大了,故本文三台机器的hadoop事先已先解压,只需要将hadoop配置文件复制过去即可

若是将整个hadoop文件都拷贝到别的机器,执行scp -r hadoop安装目录路径 root@主机名:$PWD

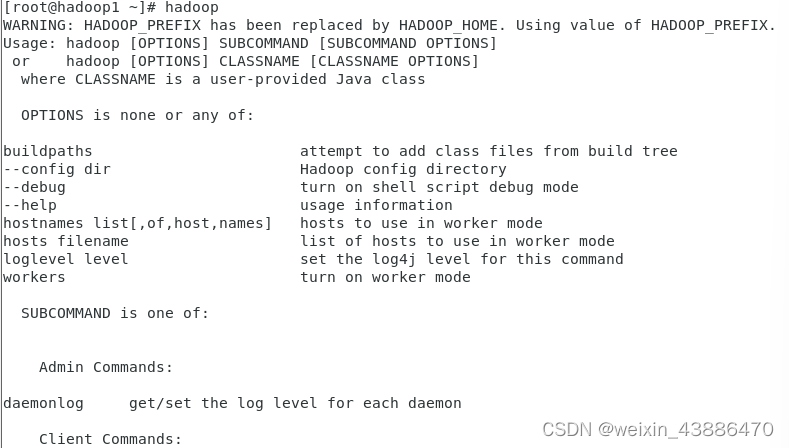

可通过执行hadoop命令检验hadoop是否安装部署成功

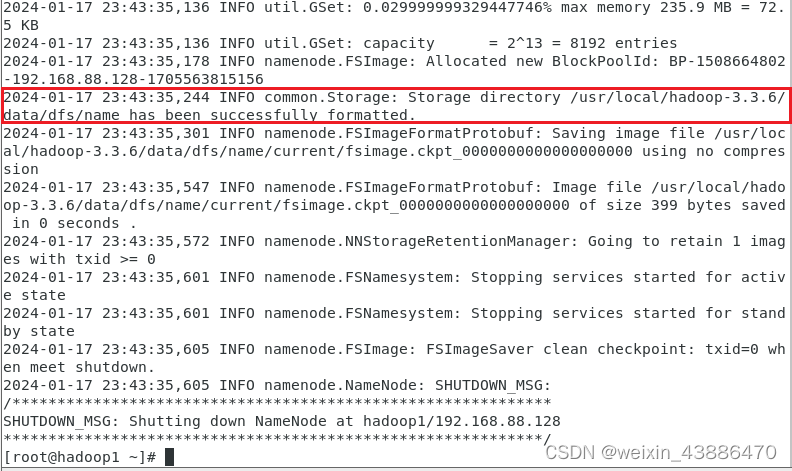

hadoop集群启动之前,需要进行format初始化操作,但初始化操作只需要一次即可!!!

多次初始化会造成数据丢失,也会造成hdfs集群主从角色互不识别,需要通过删除所有机器hadoop.tmp.dir目录(core-site.xml中设置该目录)重新进行format初始化!!!

执行hdfs namenode -format命令出现如下信息即可初始化成功

第五步:Hadoop集群启动

在配置好机器之间的ssh免密登录和workers文件的前提下,可在主机器上使用终端启动Hadoop集群

HDFS集群:start-dfs.sh #开启hdfs集群

stop-dfs.sh #关闭hdfs集群

YARN集群:start-yarn.sh #开启YARN集群

stop-yarn.sh #关闭YARN集群

Hadoop集群:start-all.sh #开启Hadoop集群

stop-all.sh #关闭Hadoop集群

版权归原作者 weixin_43886470 所有, 如有侵权,请联系我们删除。