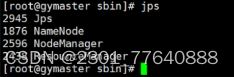

hadoop首次启动需要格式化,这时若是因为一些原由导致格式化不止一次,就会导致主点之间互相不识别,就会导致一些节点不会启动(如图是没问题的)

方法

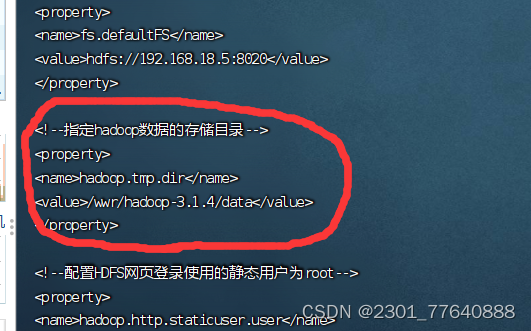

一.删除配置文件core-site.xml 和hdfs-site.xml中指定目录下的文件(在如例地找 /root/wwr/hadoop-3.1.4/etc/hadoop)

1.删除 hadoop.namenode.dir、hadoop.datanode.dir和hadoop.tmp.dir所指目录里的文件

3.删除 dfs.namenode.dir和dfs.datanode.dir所指目录里的文件

rm -rf name

rm -rf data

4.删除logs日志文件和tmp缓存文件

rm -rf logs

rm -rf tmp

5.重新格式化

hdfs namenode -format

版权归原作者 2301_77640888 所有, 如有侵权,请联系我们删除。