1.简介

1.什么是EMR

EMR是运行在阿里云平台上的一种大数据处理的系统解决方案。可以简单的理解为一个对标ambari的产品。EMR构建于云服务器ECS上,基于开源的Apache Hadoop和Apache Spark。可以方便地使用Hadoop和Spark生态系统中的其他周边系统分析和处理数据。EMR提供on ECS和on ACK两种方式,on ACK指的是容器化。

2.组成

E-MapReduce的核心是集群。E-MapReduce集群是由一个或多个阿里云ECS实例组成的Hadoop、Flink、Druid、ZooKeeper集群。以Hadoop为例,每个ECS 实例上通常都运行了一些daemon进程(例如,NameNode、DataNode、ResouceManager和NodeManager),这些daemon进程共同组成了Hadoop集群。

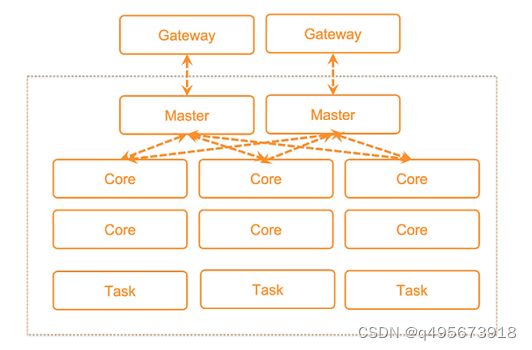

- Master节点,部署了Hadoop的主节点服务,包括HDFS NameNode、HDFS JournalNode、ZooKeeper、YARN ResourceManager和HBase HMaster等服务,可以根据集群的使用场景,选择高可用集群或非高可用集群。测试环境可以选择非高可用集群,生产环境建议选择高可用集群。高可用集群可以选择2个或3个Master节点,当选择2个Master节点时,HDFS JournalNode和ZooKeeper会部署在Core的emr-worker-1节点。生产环境建议创建高可用集群时选择3个Master节点。

- Core节点,部署了HDFS DataNode和YARN Nodemanager,用于HDFS数据的存储和YARN的计算,不可以弹性伸缩。

- Task节点,部署了YARN NodeManager,用于YARN计算,可以通过弹性伸缩的方式灵活扩容或缩容。

- Gateway集群,部署了Hadoop的客户端文件,您可以通过Gateway提交作业,避免直接登录集群产生的安全和客户端环境隔离问题。您需要先创建Hadoop集群,然后创建Gateway集群关联至Hadoop集群。

3.与自建hadoop集群对比

对比项阿里云EMR自建Hadoop集群成本支持按量和包年包月付费方式,集群资源支持灵活调整,数据分层存储,资源使用率高。无额外软件License费用。需提前预估资源,且资源相对固定,资源使用率低。采用Hadoop发行版,需额外支付License费用。性能较开源版本性能大幅提升。采用开源社区版本,性能需自行优化。易用性分钟级别启动Hadoop集群,敏捷响应业务需求。采购服务器,部署Hadoop生态组件,周期长达数周。弹性可根据作业临时启动和销毁集群。集群资源可根据时间周期或集群负载动态自动调整。基于JindoFS计算存储分离架构,轻松分别扩展计算和存储资源。计算和存储耦合,资源相对固定,无法弹性调整资源。安全支持企业级多租户资源管理,支持对表、列、行级别的权限控制和日志审计,支持数据加密。多租户管理能力需自行配置,能力不完善,无法满足企业级需求。可靠大规模、企业级环境的检验,随开源版本升级,并经过专业的兼容性验证测试,提供优于社区版本的使用体验。需自行更新和升级开源版本,验证各组件版本兼容性,自行修复社区bug。服务专业和资深大数据专家技术服务团队提供售后支持。社区版本无服务支持,Hadoop发行版,需额外支付License和服务费用。

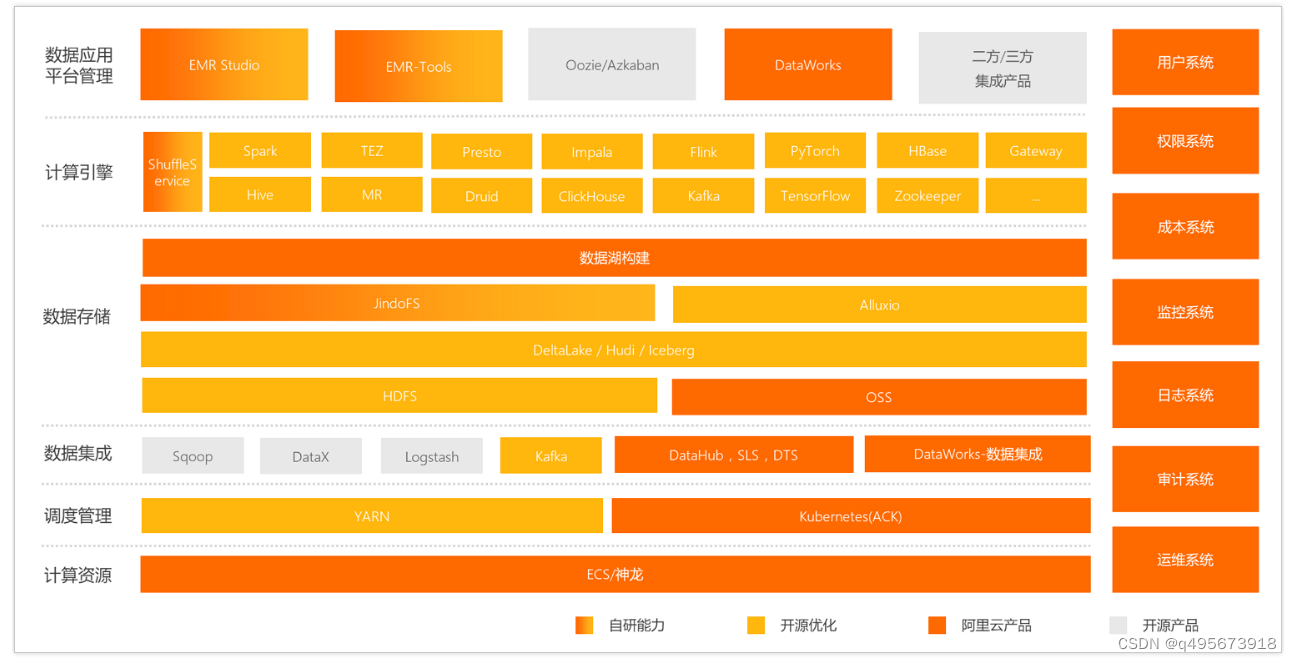

4.产品架构

2.使用

1.创建EMR集群

1.登录EMR on ECS控制台

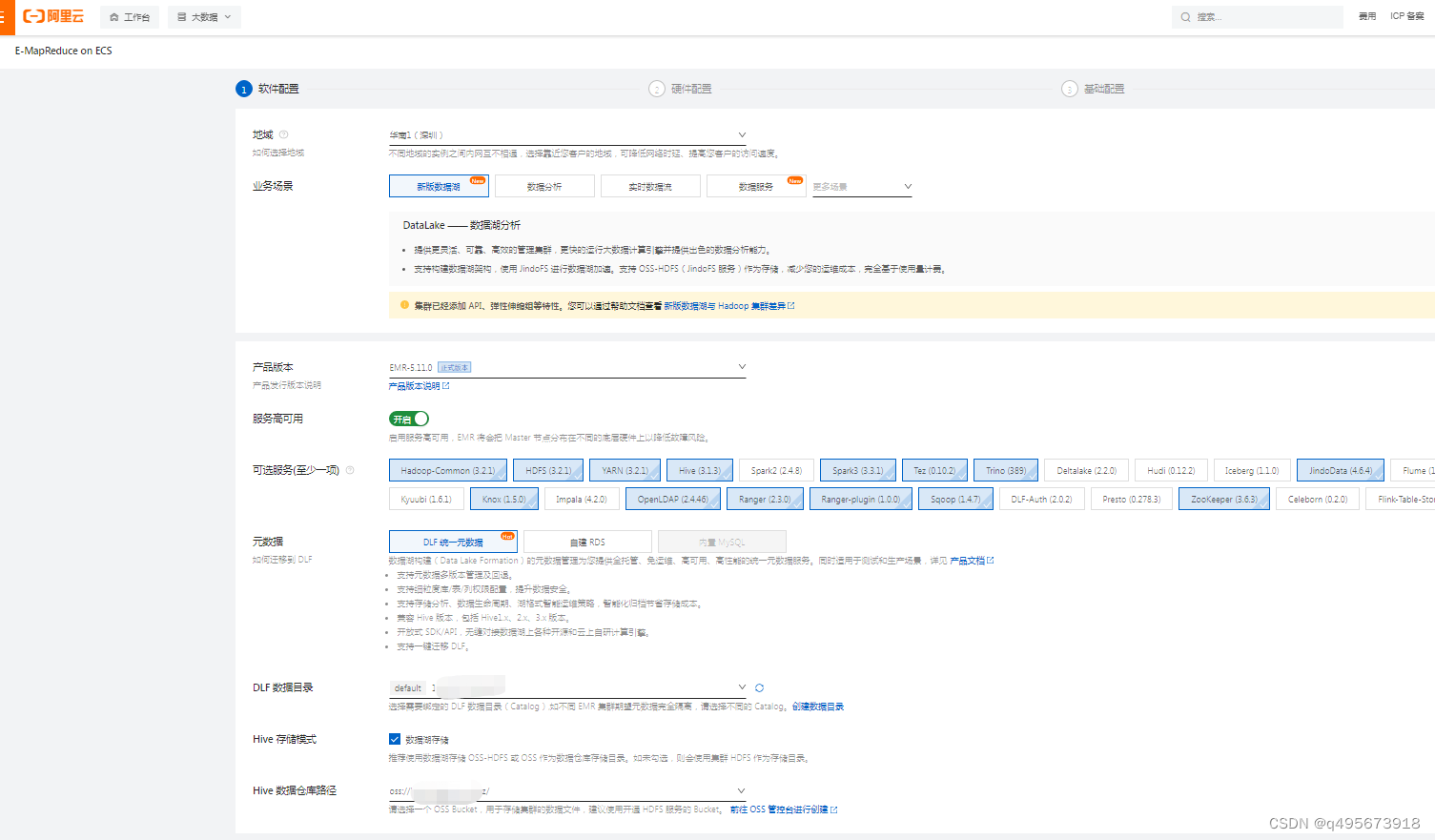

2.软件设置

根据实际情况选择地域和资源组。

这里选择是数据湖的场景,如果有数据分析的可以重新再另建一个数据分析的EMR集群,这样以便于计算资源的隔离,如果不同的业务使用一个集群那资源就是混用的。

如果是生产环境需要开启服务高可用,服务高可用将会使用3个master节点保障服务的高可用。

元数据我们选择DLF统一元数据管理,当然也可以使用自建的RDS,不过这样就需要自己买个mysql的费用。

DLF数据目录我们使用默认的就好,也可以自建创建一个目录,如果其他EMR集群使用了同一个DLF数据目录,那就是使用的同一个元数据信息,这个需要注意。后面我们可以通过DLF 元数据管理对元数据进行查询及管理。

Hive存储模式使用数据湖存储,使用OSS-HDFS作为数据存储,所以这里需要我们在创建集群之前需要创建一个OSS的bucket,并开通OSS-HDFS服务。

Hive数据仓库路径这里填入前面创建OSS的bucket

3.硬件设置

付费类型,如果短期使用的我们选择按量付费,如果是长期选择包年包月。

专有网络,也就是vpc用于网络隔离的。

可用区我们这里选择和业务系统在同一个地域的同一个可用区内,保证效率。

节点组,master节点这个是不能扩容的,所以需要我们前面规划好。Master节点主要用来存储HDFS元数据和组件Log文件,属于计算密集型,对磁盘IO要求不高。HDFS元数据存储在内存中,建议根据文件数量选择16 GB以上内存空间。

Core节点会同时运行DataNode和Nodemanager。作为存储和计算节点使用,我们可以把数据存在OSS中,集群中的HDFS仅作为YARN任务分发的临时存储空间使用。

core节点的云盘不支持卸载和缩容,只支持扩容。如果卸载云盘和缩容会导致集群出问题。

core节点必须有一个数据盘,计算过程生成的临时文件会在disk1下,hdfs才会用到所有的数据盘,所以如果使用oss作为存储的话那只需要一个数据盘就行了。

查看集群组件服务的日志可以去/mnt/disk1/log目录下查看

3.基础配置

身份凭证建议使用密钥对,这样更安全。

2.配置

1.组件配置

1.hive

点击集群服务->选择Hive配置,修改配置项

hive.execution.engine=tez

hive.metastore.warehouse.dir=ossxxx/apps/hive/managed/warehouse/

hive.metastore.warehouse.external.dir=ossxx/apps/hive/warehouse

metastore.create.as.acid=false

2.hadoop-common

fs.trash.interval=360

3.hdfs

dfs.replication=3

dfs.namenode.avoid.read.stale.datanode=true

dfs.namenode.acls.enabled=true

dfs.namenode.avoid.write.stale.datanode=true

dfs.cluster.administrators=hdfs

dfs.permissions.superusergroup=hdfs

4.yarn

mapreduce.job.counters.max=1000

mapreduce.task.io.sort.mb=2048

mapreduce.map.memory.mb=6144

mapreduce.reduce.memory.mb=12288

mapreduce.reduce.shuffle.parallelcopies=30

mapreduce.task.io.sort.factor=100

yarn.app.mapreduce.am.resource.mb=6144

2.用户管理

我们前面选择的knox,它可以让我们通过公网方式访问HDFS、YARN、Spark和Ganglia等Web UI页面,它可以帮助我们只开放一个端口访问所有的UI。

点击EMR集群->点击用户管理->添加用户,选择我们要添加的用户,然后设置密码,这个用户和密码用于后面访问组件UI的时候的验证。

3.安全组

knox默认使用了8443端口,所以在安全组中我们手动添加8443端口,授权对象为需要访问资源机器的ip地址。

4.Gateway

Gateway 主要用于向计算集群提交任务和进行安全隔离。部署组件客户端,访问EMR集群。

其部署过程如下

- 在 ECS 控制台创建 ECS 实例

- 在 ECS 实例安装 EMR-CLI 工具,并配置认证信息

- 通过 EMR-CLI 命令完成部署客户端软件包、同步集群配置及更新软件包操作。

部署完成之后各客户端使用的配置文件默认存在/etc/taihao-apps目录下,在这里可以查看组件config。

在ECS实例安装EMR-CLI工具过程如下:

需要注意的是,如果使用spark客户端需要配置Gateway节点的域名解析。

如何创建ECS实例并基于EMR-CLI快速部署Gateway环境_开源大数据平台 E-MapReduce-阿里云帮助中心

5.trino配置

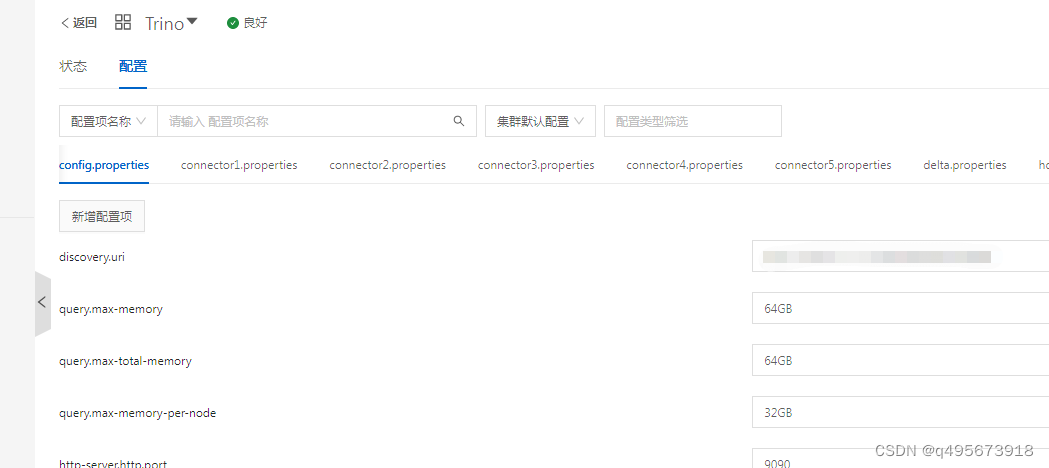

1.设置内存

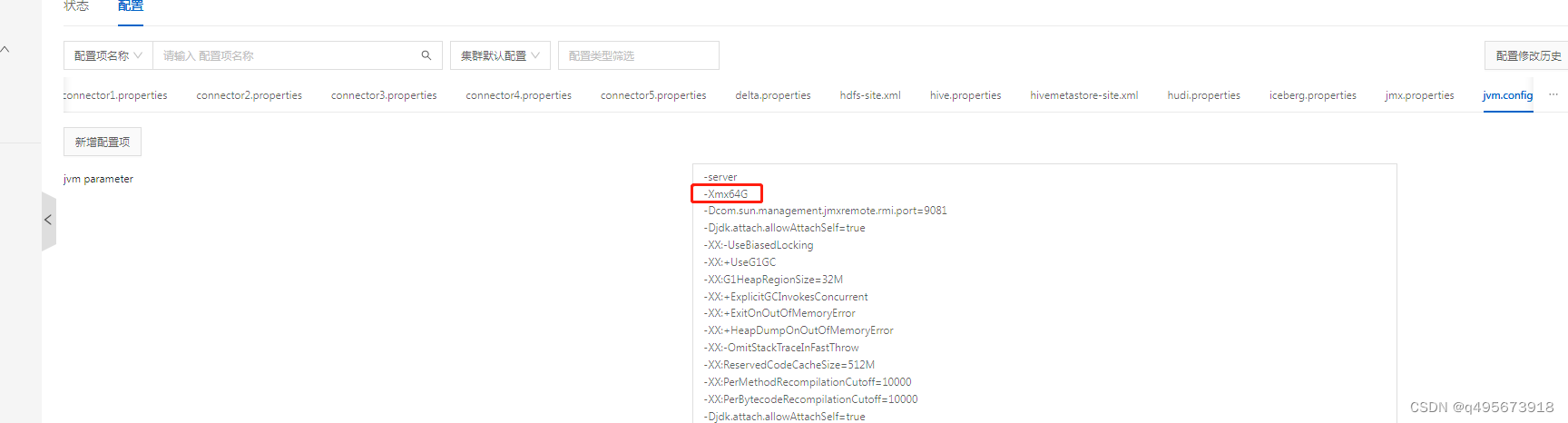

调整query.max-memory、query.max-total-memory、query.max-memory-per-node大小,并且query.max-memory-per-node的内存大小+ heap headroom的内存必须小于jvm的内存。其中heap headroom默认大小是10G,修改之后重启trino生效。

3.组件UI

点击集群->访问链接与端口。点击之后输入我们前面添加的用户和密码访问。

3.遇到的问题

1.emr-cli

1.ecs部署了emr-cli,然后使用spark的时候会报错,但是在emr管理的机器上启动没这个问题

解决方法:

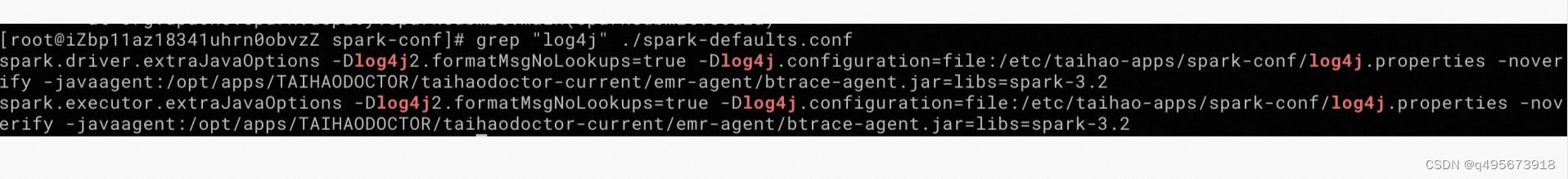

gateway 上的/etc/taihao-apps/spark-conf/spark-defaults.conf 的配置有问题。在这个文件里找这两个配置,看一下 -Dlog4j.configuration 这个参数配的是什么,检查一下gateway集群上指向的文件是否存在,没有就会报错。

改成 /etc/taihao-apps/spark-conf/log4j.properties 就可以了

版权归原作者 q495673918 所有, 如有侵权,请联系我们删除。