kettle****连接hive

版本说明:kettle:pdi-ce-8.3.0.0-371.zip

Hadoop集群:hadoop-3.3.2

hive: hive-3.1.3

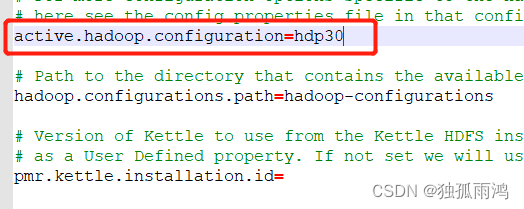

1、修改kettle的plugin.properties 文件(文件位置D:\programfile\data-integration\plugins\pentaho-big-data-plugin)

主要设置

active.hadoop.configuration=hdp30

.

.

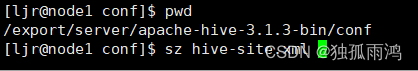

2、从Hadoop、hive上下载相关文件并替换kettle中对应的文件

sz core-site.xml hdfs-site.xml yarn-site.xml mapred-site.xml

sz hive-site.xml

要替换kettle文件的位置:D:\programfile\data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations\hdp30

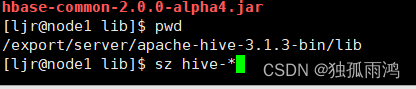

3、从hive的lib目录上下载以hive开头的jar包并替换kettle中对应的包

sz hive-*

要替换kettle中的包的位置:

D:\programfile\data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations\hdp30\lib

说明:把hdp30中以hive开头的包删除后再替换即可;注意是要放在hdp30目录下的lib文件夹,而不是像把Oracle/MySQL驱动一样放在data-integration目录下的lib文件夹

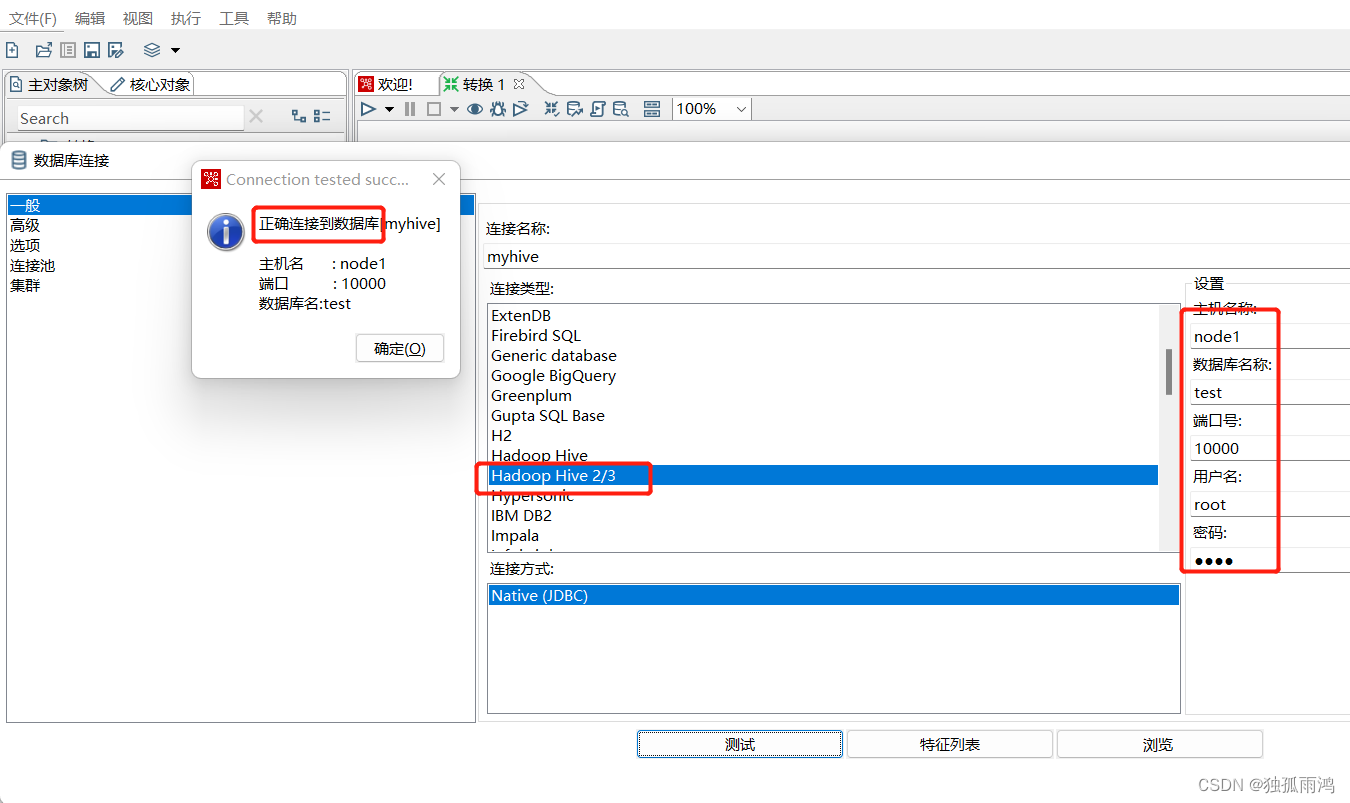

4、验证

启动Hadoop集群及hiveserver2服务

重启ketlle

如下建立db连接,恭喜测试成功!

版权归原作者 独孤雨鸿 所有, 如有侵权,请联系我们删除。