Hadoop的安装和使用(windows)

下载hadoop在windows上运行的软件winutils

由于Hadoop不直接支持Windows系统,需要使用工具集winutils进行支持。到github.com网站(https://github.com/s911415/apache-hadoop-3.1.3-winutils)下载与Hadoop3.1.3配套的winutils。

将hadoop3.1.3解压到常用的学习路径(E:\minghuan\hadoop-3.1.3)

在解压路径(E:\minghuan\hadoop-1.3)下,先创建tmp目录,然后再tmp目录下创建两个子目录,分别是datanode和namenode。

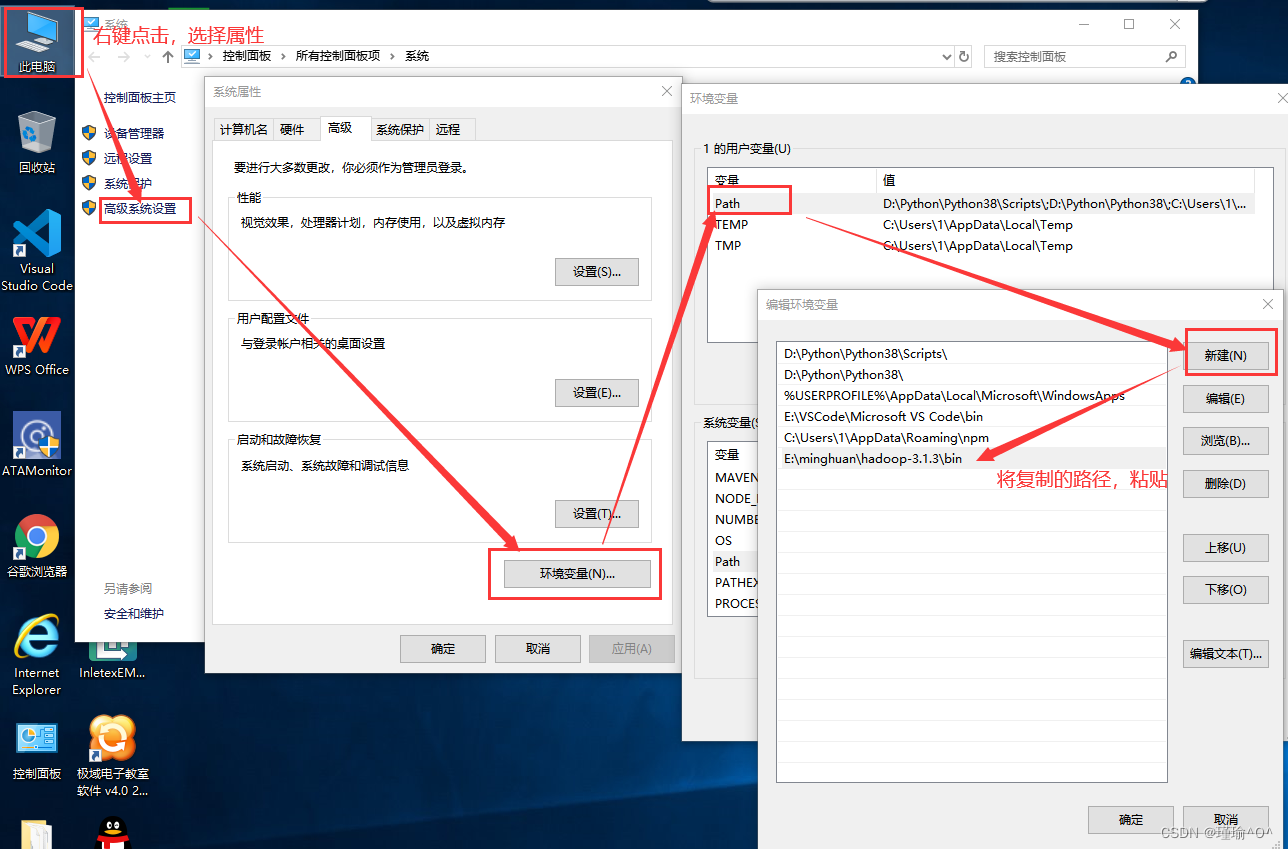

配置hadoop3.1.3的环境变量

将Hadoop3.1.3的解压路径(到bin目录)复制(E:/…/hadoop3.1.3/bin),右键单击计算机(此电脑)—>再点击属性—>高级系统设置—>环境变量—选择Path—>新建

- 将apache-hadoop-3.1.3-winutils-master.zip解压到(E:\minghuan\),然后将其目录的bin目录下所有的文件复制到hadoop3.1.3的解压路径(E:\minghuan\hadoop-3.1.3)的bin目录下。

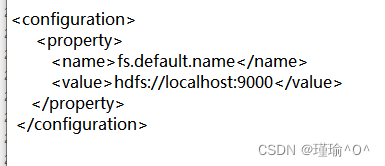

切换到E:\minghuan\hadoop-3.1.3\etc\hadoop下修改三个文件

修改文件(再windows中找到解压路径下的etc/hadoop:

E:\minghuan\hadoop-3.1.3\etc\hadoop,使用记事本打开,然后编辑文件)

core-site.xml

hdfs-site.xml

hadoop-env.cmd

修改hadoop-env.cmd****文件,找到如下一行:

set JAVA_HOME=%JAVA_HOME%替换为 Java****的安装路径(建议路径中不要包含中文和空格)

set JAVA_HOME=E:**PROGRA~1**\Java\jdk1.8.0_281或者

set JAVA_HOME="E:\Program Files"\Java\jdk1.8.0_281

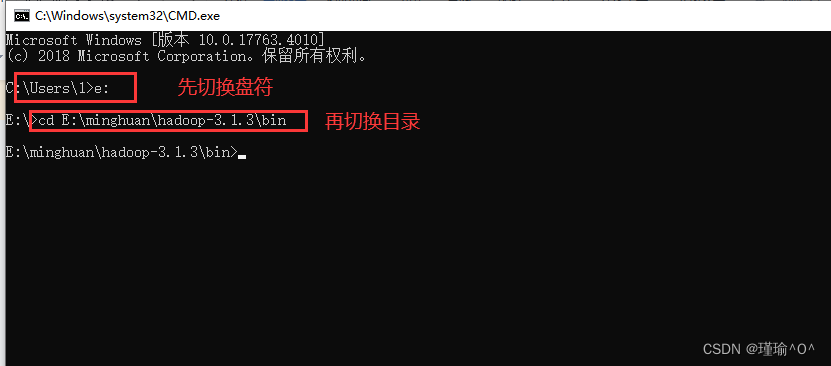

- 打开windows的cmd命令行窗口,然后执行如下命令:

格式化hadoop集群:

cd E:\minghuan\hadoop3.1.3\bin

hdfs namenode -format

启动集群:

cd E:\minghuan\hadoop3.1.3\sbin

start-dfs.cmd

停止集群:

cd E:\minghuan\hadoop3.1.3\sbin

stop-dfs.cmd

访问集群:

在浏览器中输入:http://localhost:9870

HDFS的shell命令

- 创建一个目录(在HDFS****上)

** 切换到解压路径下的bin目录 **cd E:\minghuan\hadoop3.1.3\bin

使用**hadoop fs ( **等价于hdfs) -mkdir 要创建目录的路径

hadoop fs -mkdir hdfs://localhost:9000/user/

hadoop fs -mkdir hdfs://localhost:9000/user/xiaofang

- 上传一个本地文件到hdfs的xiaofang的目录

在E盘的minghuan创建一个文件test.txt(新建一个文本文档),输入I love Hadoop

*切换到解压路径下的bin***目录 **cd E:\minghuan\hadoop3.1.3\bin

hadoop fs -put 本地文件的所在路径 目的路径(HDFS的路径)

hadoop fs -put E:\minghuan\test.txt hdfs://localhost:9000/user/xiaofang

- 查看hdfs****路径下的目录及文件

*切换到解压路径下的bin***目录 **cd E:\minghuan\hadoop3.1.3\bin

hadoop fs -ls 要查看的HDFS的路径

hadoop fs -ls hdfs://localhost:9000/

- 查看hdfs的xiaofang目录下的文件内容

*切换到解压路径下的bin***目录 **cd E:\minghuan\hadoop3.1.3\bin

hadoop fs -cat 要查看的HDFS的文件路径

hadoop fs -cat hdfs://localhost:9000/user/xiaofang/test.txt

- 下载hdfs的xiaofang目录下的文件test.txt

*切换到解压路径下的bin***目录 **cd E:\minghuan\hadoop3.1.3\bin

hadoop fs -get 要下载的HDFS的文件路径 下载到本地存放文件的路径

hadoop fs -get hdfs://localhost:9000/user/xiaofang/test.txt E:\minghuan\test01.txt

- 删除hdfs上的test.txt文件

*切换到解压路径下的bin***目录 **cd E:\minghuan\hadoop3.1.3\bin

**hadoop fs -rm ** 要删除的HDFS的文件路径

hadoop fs -rm hdfs://localhost:9000/user/xiaofang/test.txt

- 删除hdfs****上的目录及目录下的文件

*切换到解压路径下的bin***目录 **cd E:\minghuan\hadoop3.1.3\bin

hadoop fs -rm -r 要删除的HDFS的文件路径

hadoop fs -rm -r hdfs://localhost:9000/user/xiaofang

版权归原作者 瑾寰 所有, 如有侵权,请联系我们删除。