首先需要安装hive

书上用的是hive1.2.1

但是官网说1.2.1不兼容hadoop3

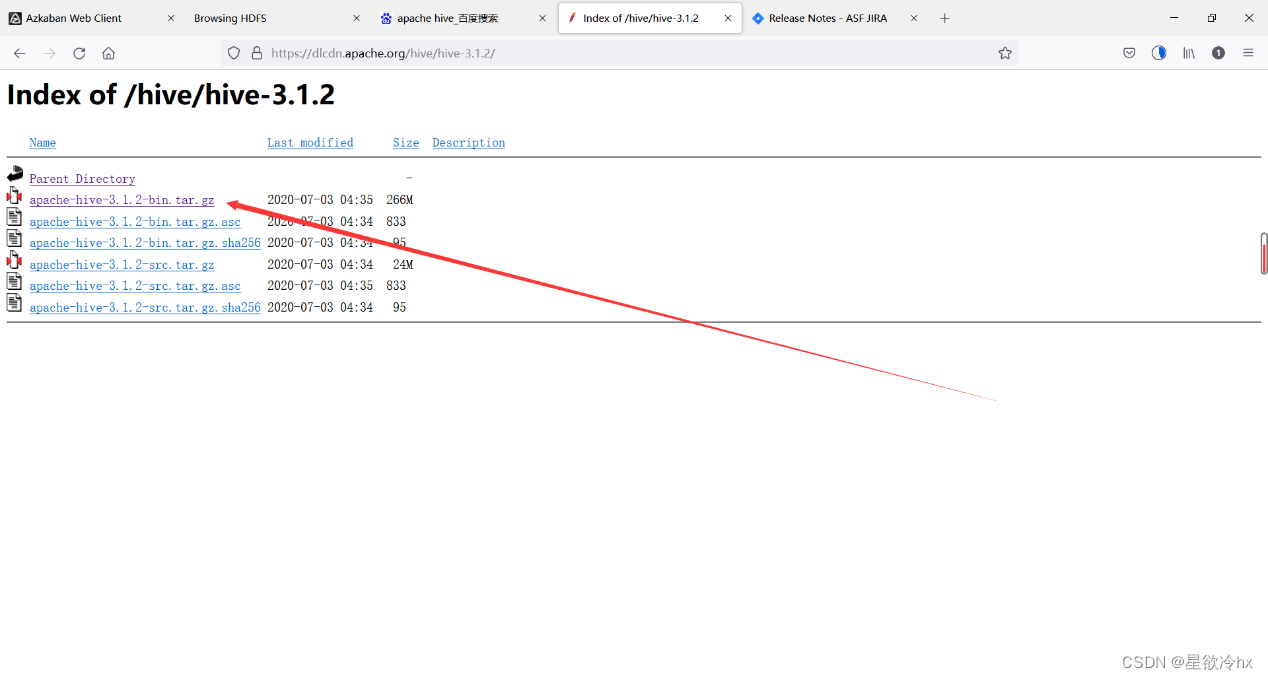

所以选择其他的版本

用这个

大家去官网下载就行,这里把ba网盘链接也给大家

https://pan.baidu.com/s/1rkI1PZeBNusBddYLk868Yw?pwd=1234 提取码:1234

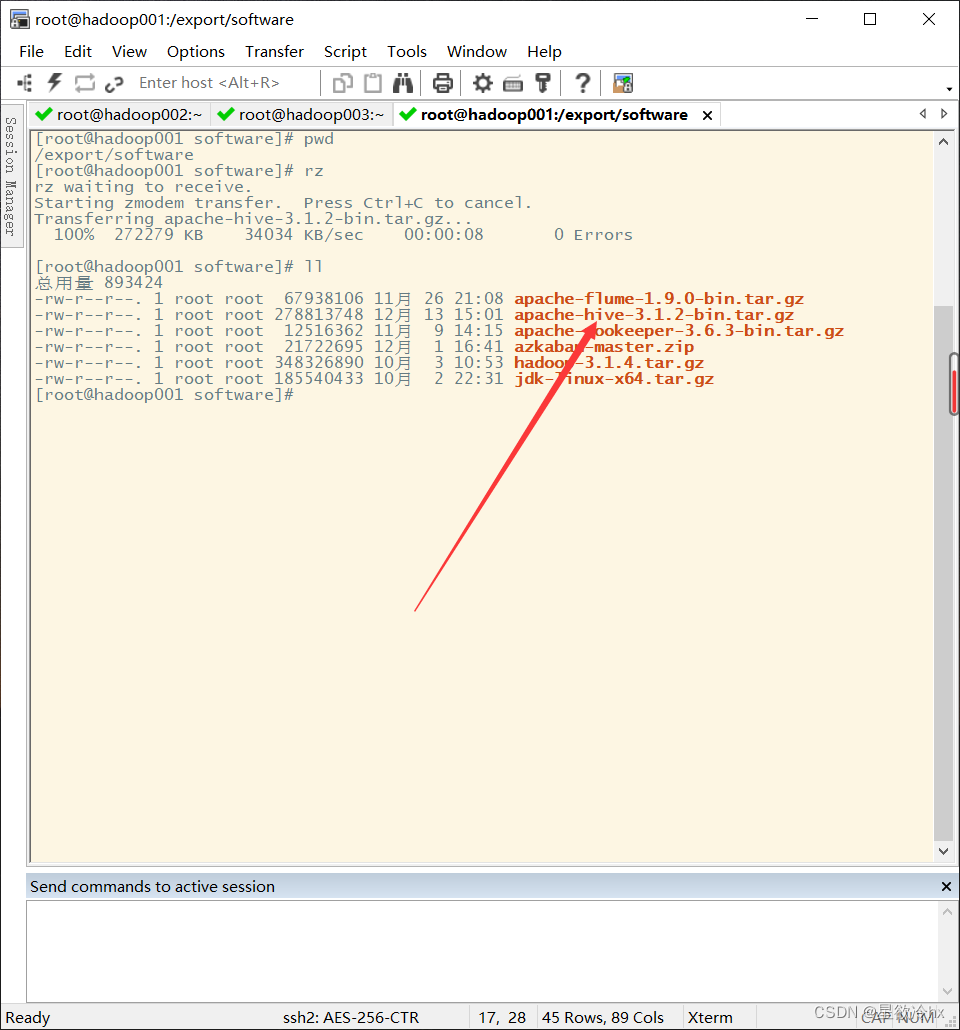

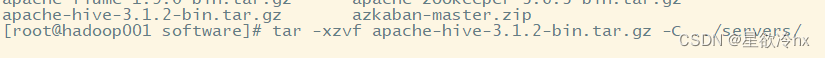

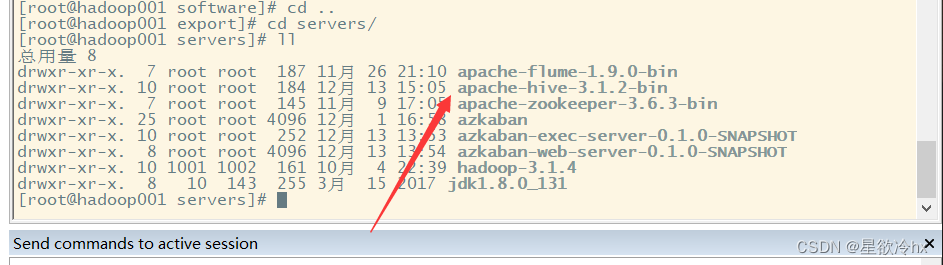

解压

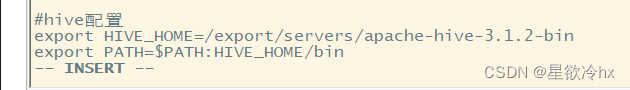

配置环境变量(这里有错,见下一张图)

使环境变量生效

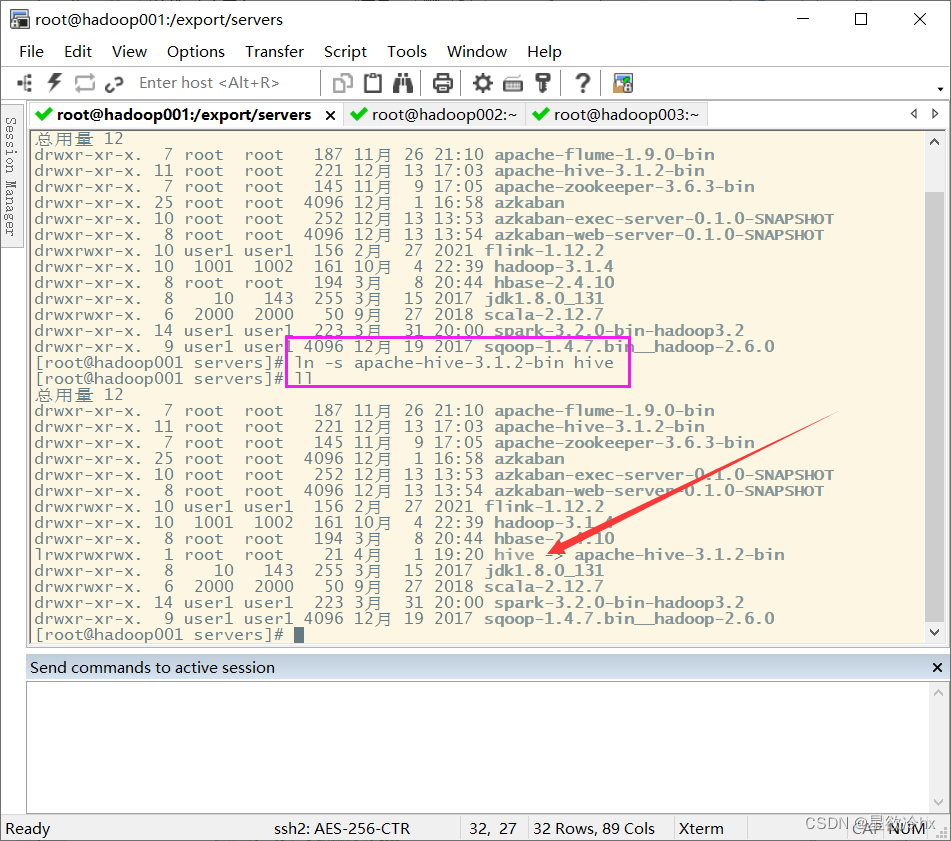

创建软连接

首先介绍一下软连接,就是相当于给他取一个另外的名字,这两个名字叫哪个都一样,也可以不用软连接直接改名更方便,我就是直接改的名字。

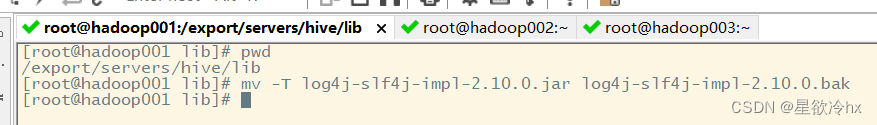

解决日志jar包冲突

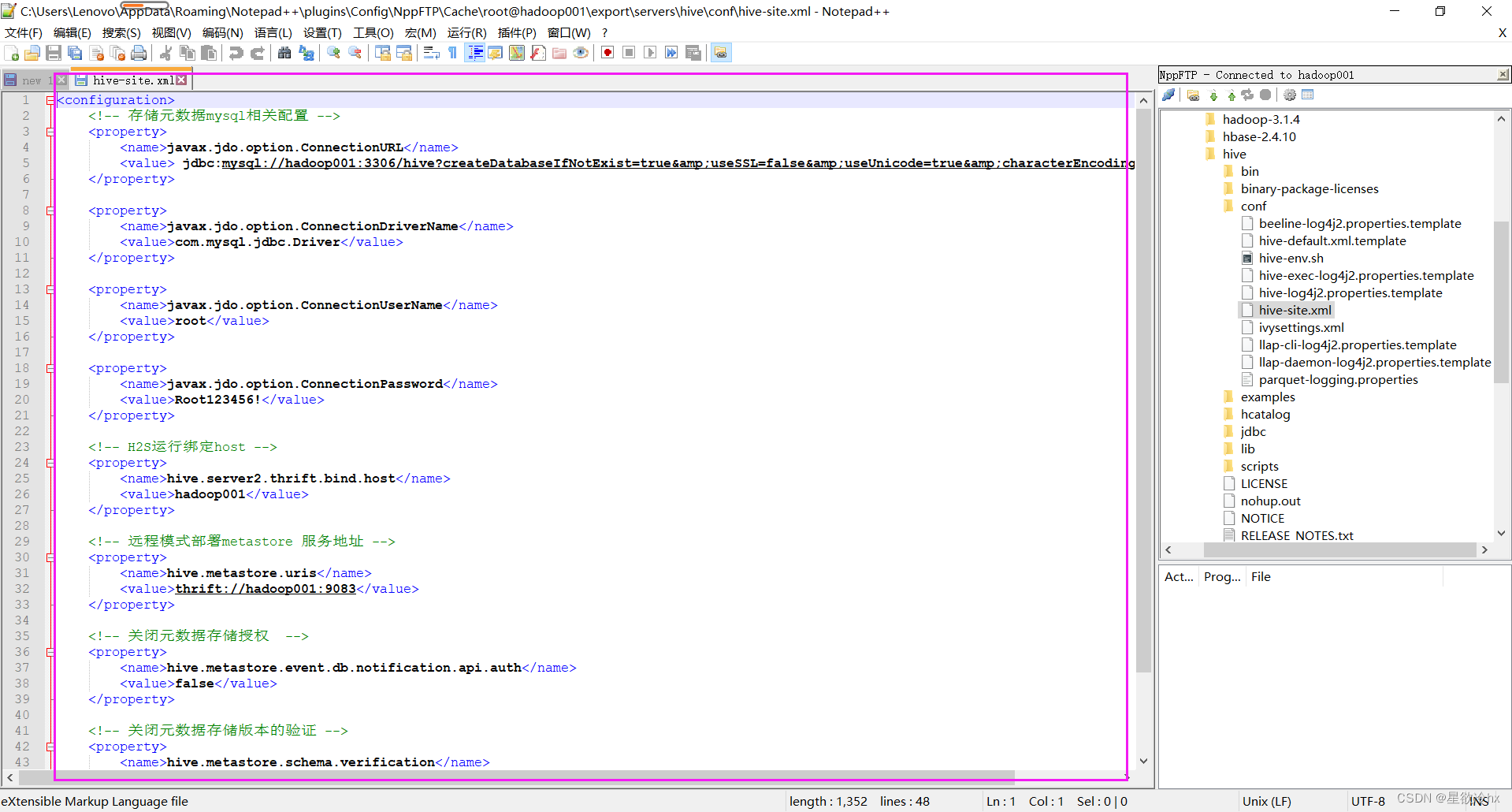

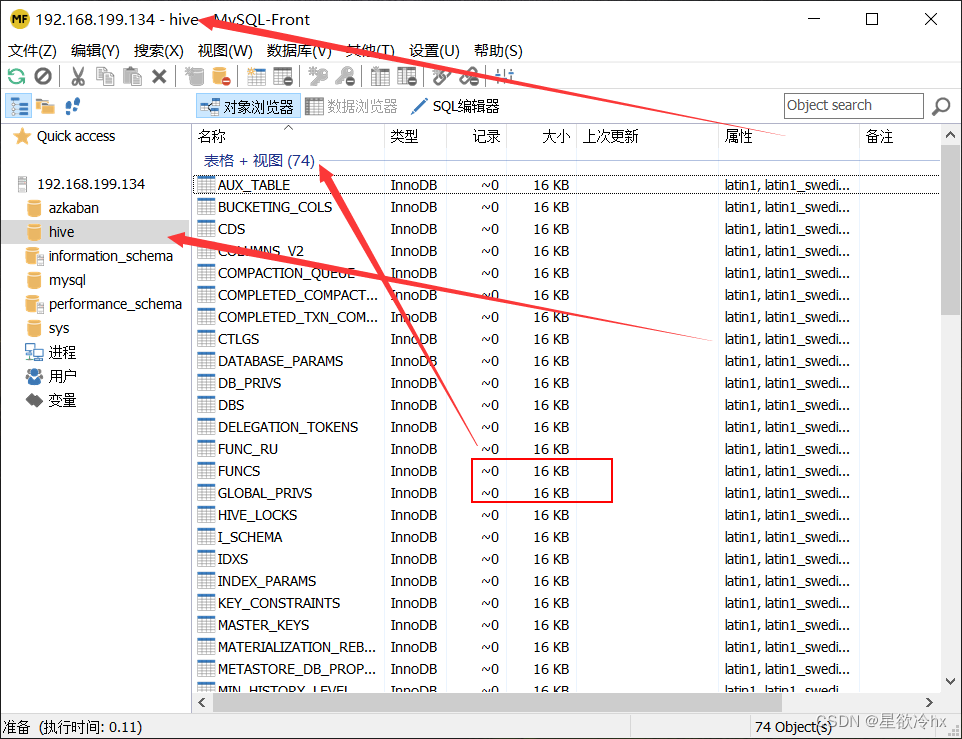

修改hive配置文件

<configuration>

<!-- 存储元数据mysql相关配置 -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value> jdbc:mysql://hadoop001:3306/hive?createDatabaseIfNotExist=true&useSSL=false&useUnicode=true&characterEncoding=UTF-8</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>Root123456!</value>

</property>

<!-- H2S运行绑定host -->

<property>

<name>hive.server2.thrift.bind.host</name>

<value>hadoop001</value>

</property>

<!-- 远程模式部署metastore 服务地址 -->

<property>

<name>hive.metastore.uris</name>

<value>thrift://hadoop001:9083</value>

</property>

<!-- 关闭元数据存储授权 -->

<property>

<name>hive.metastore.event.db.notification.api.auth</name>

<value>false</value>

</property>

<!-- 关闭元数据存储版本的验证 -->

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

</configuration>

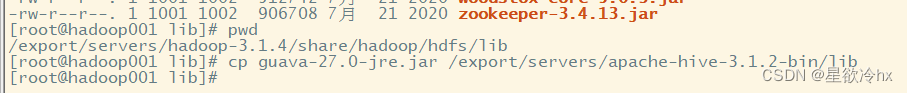

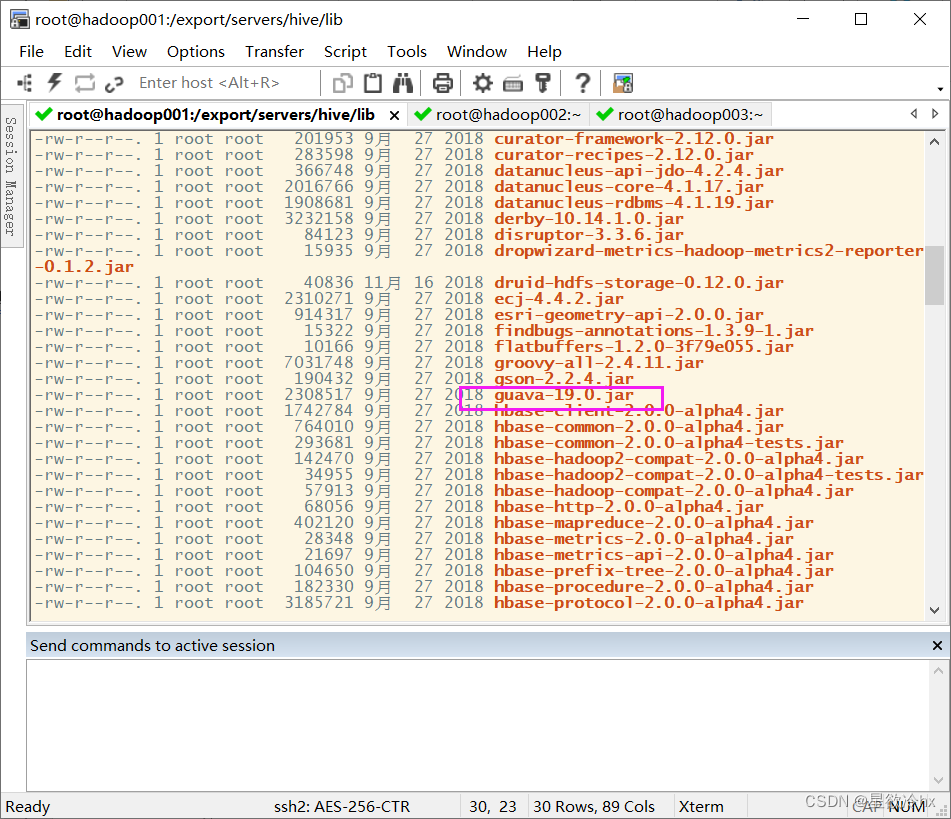

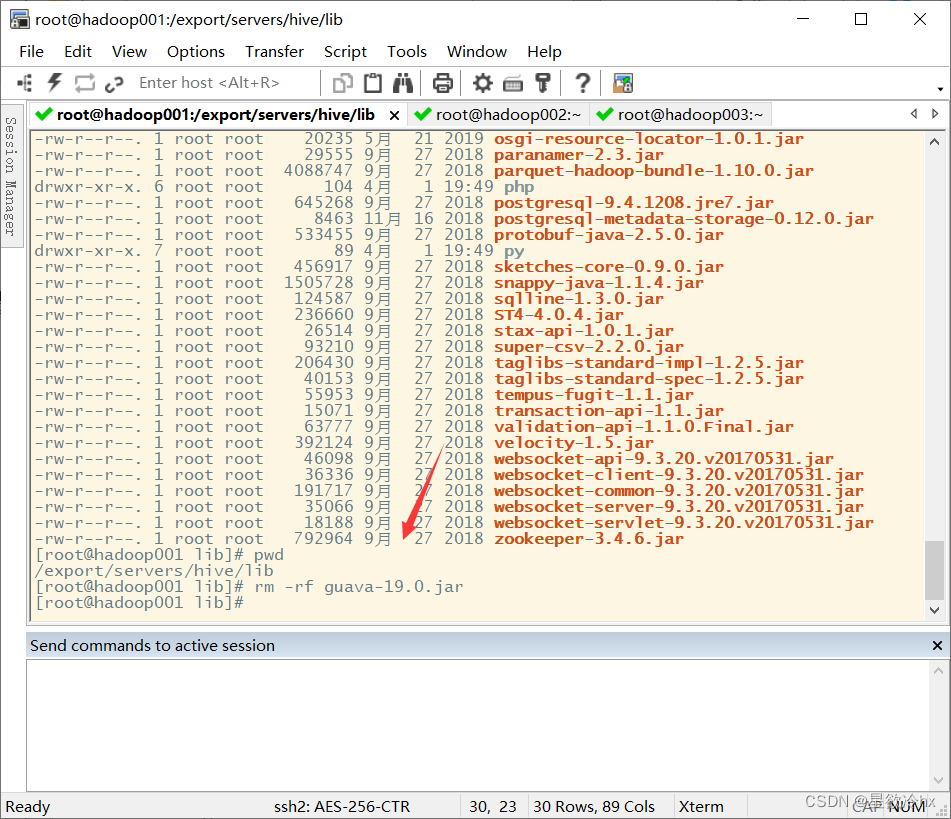

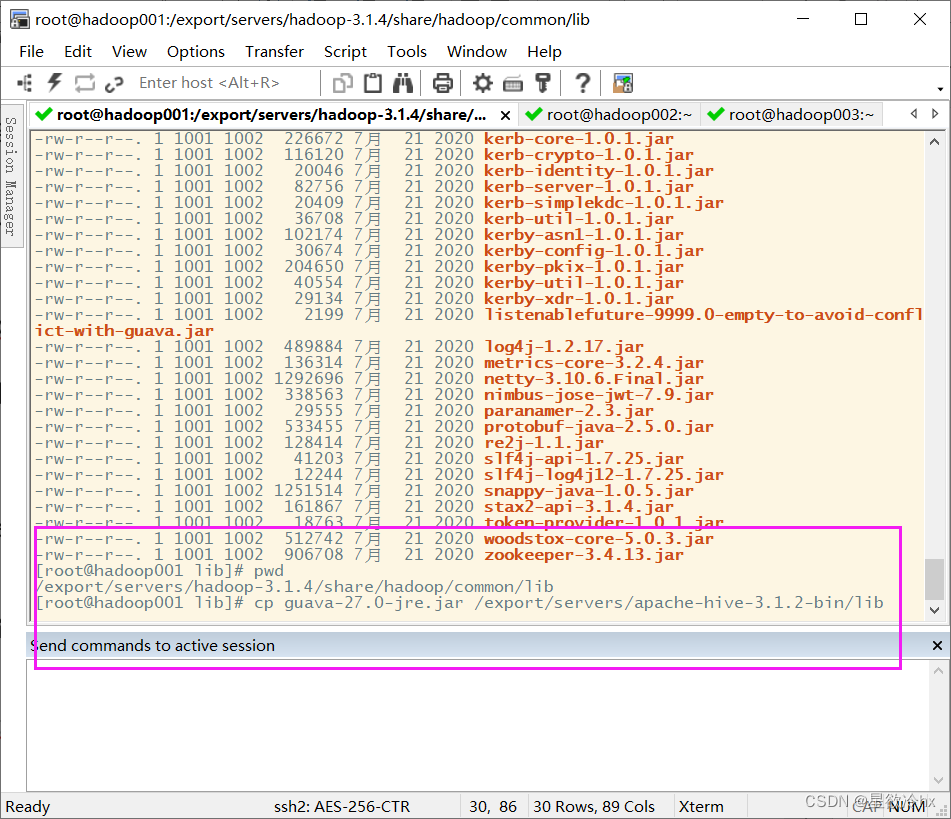

把hadoop下的gua给hive一份

先把hive lib里的删了

修改hive env.sh

cd /export/servers/hive/conf/

mv hive-env.sh.template hive-env.sh

vi hive-env.sh

export HADOOP_HOME=/export/servers/hadoop-3.1.4

export HIVE_CONF_DIR=/export/servers/hive/conf

export HIVE_AUX_JARS_PATH=/export/servers/hive/lib

添加连接插件和初始化

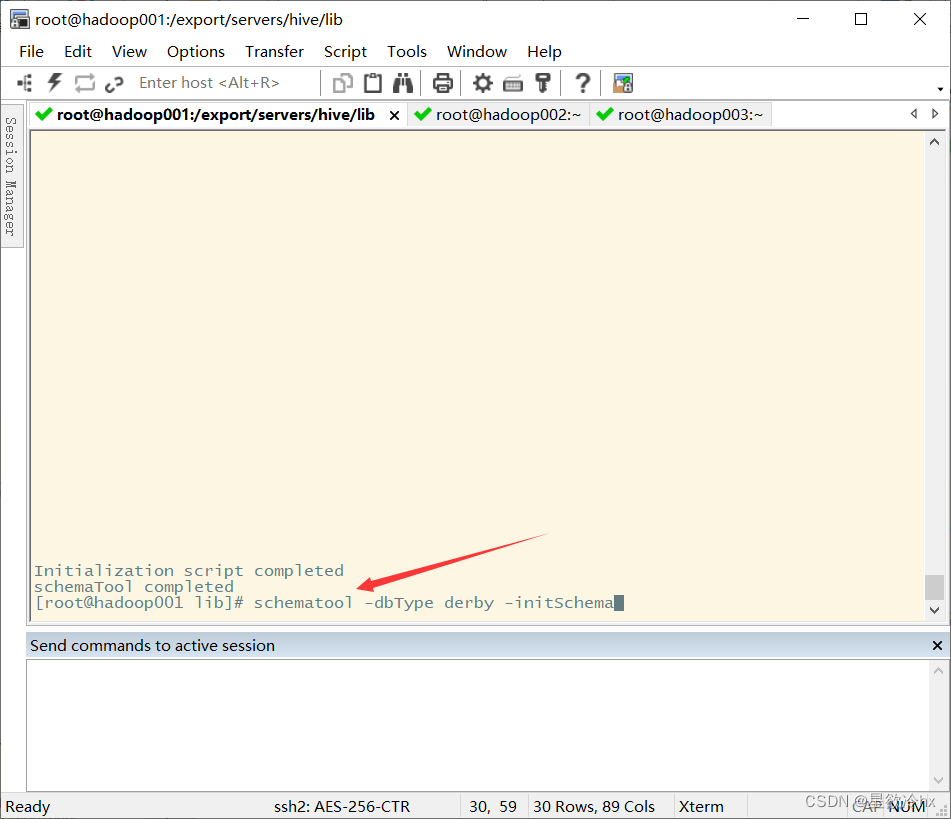

初始化并且查看

cd /export/servers/hive

bin/schematool -initSchema -dbType mysql -verbos

Mysql安装

这个以前做过了,并且也发过文章了,见我这篇文章

https://blog.csdn.net/hx1156477702/article/details/127117270?spm=1001.2014.3001.5501

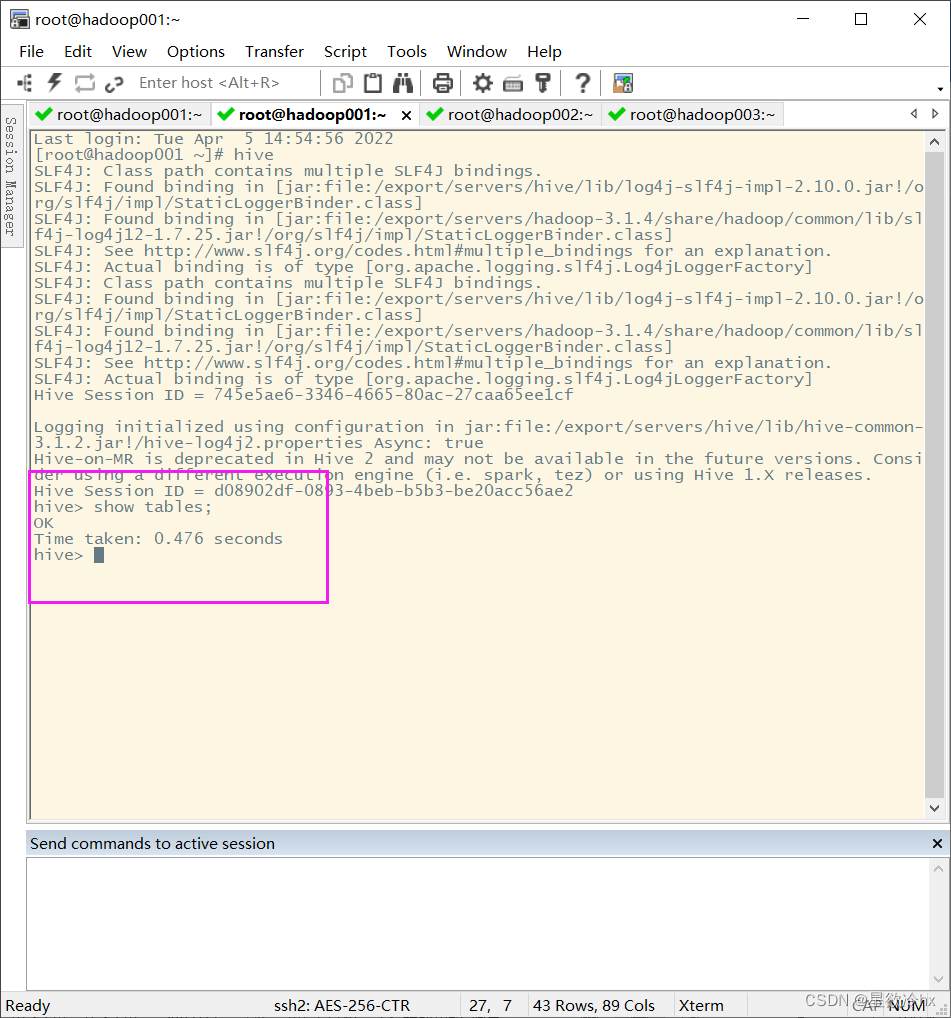

启动及测试

首先先得启动hive的服务

/export/servers/hive/bin/hive --service metastore

然后在克隆一个来运行hive

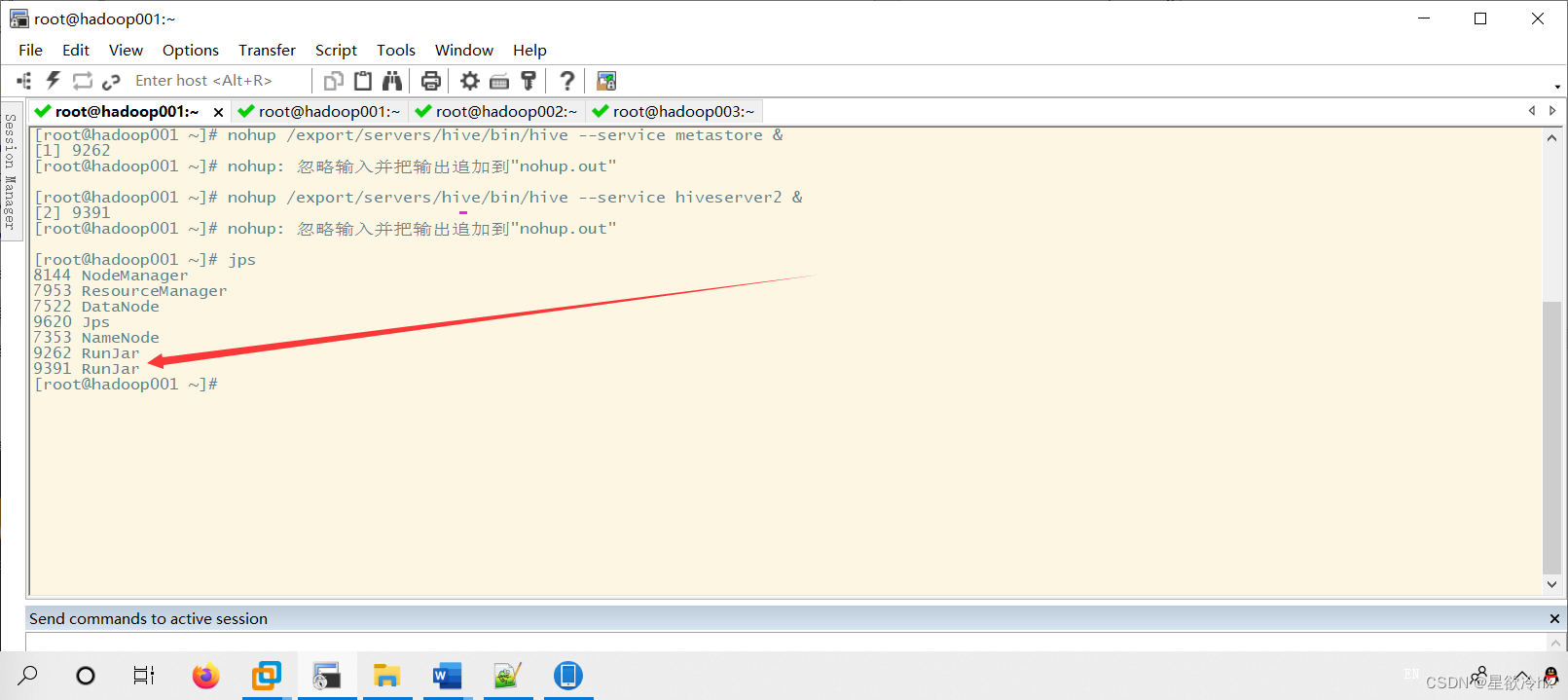

也可以后台启动

nohup /export/servers/hive/bin/hive --service metastore &

两次回车

开启debug日志

/export/servers/hive/bin/hive --service metastore --hiveconf hive.root.logger=DEBUG,console

beeline启动顺序

反正这是我的启动方式,下面还有脚本启动,但是脚本有时候会出问题

下面有脚本启动的代码

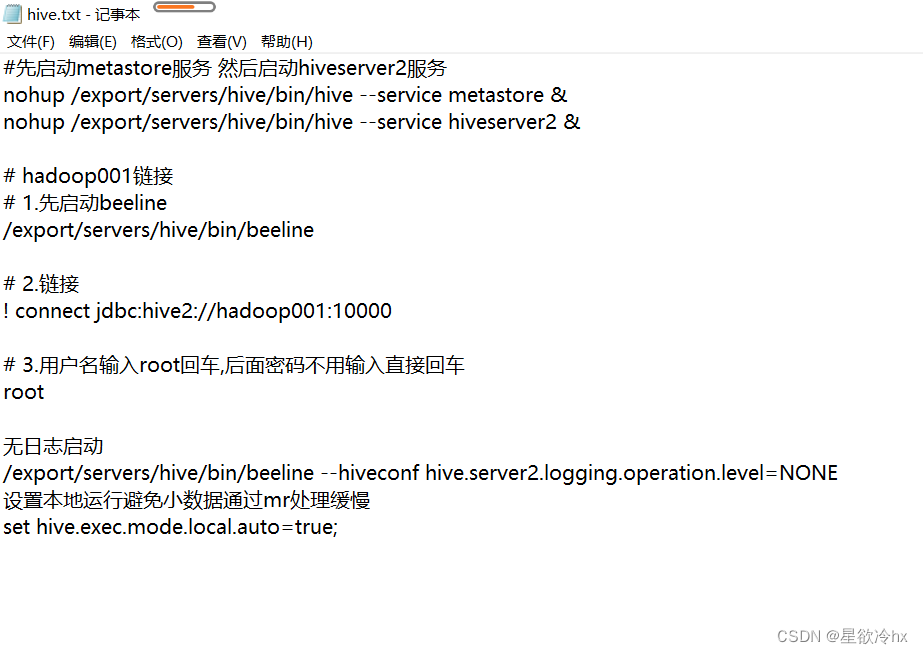

#先启动metastore服务 然后启动hiveserver2服务

nohup /export/servers/hive/bin/hive --service metastore &

nohup /export/servers/hive/bin/hive --service hiveserver2 &

hadoop001链接

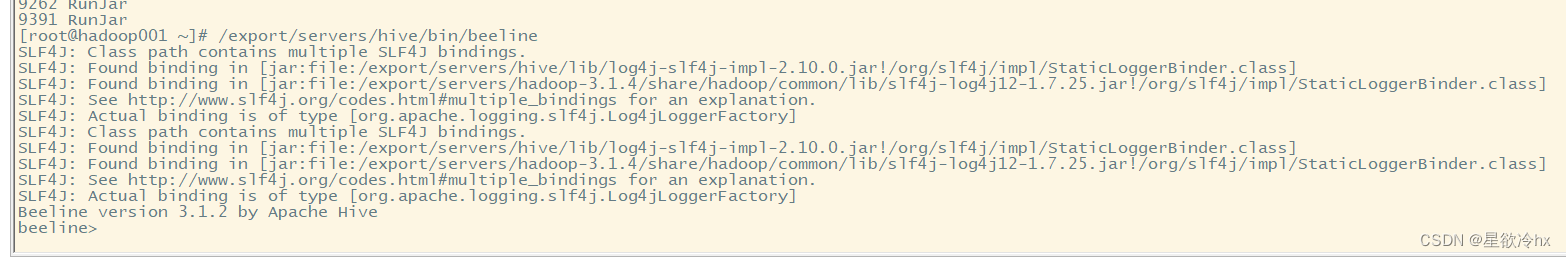

1.先启动beeline

/export/servers/hive/bin/beeline

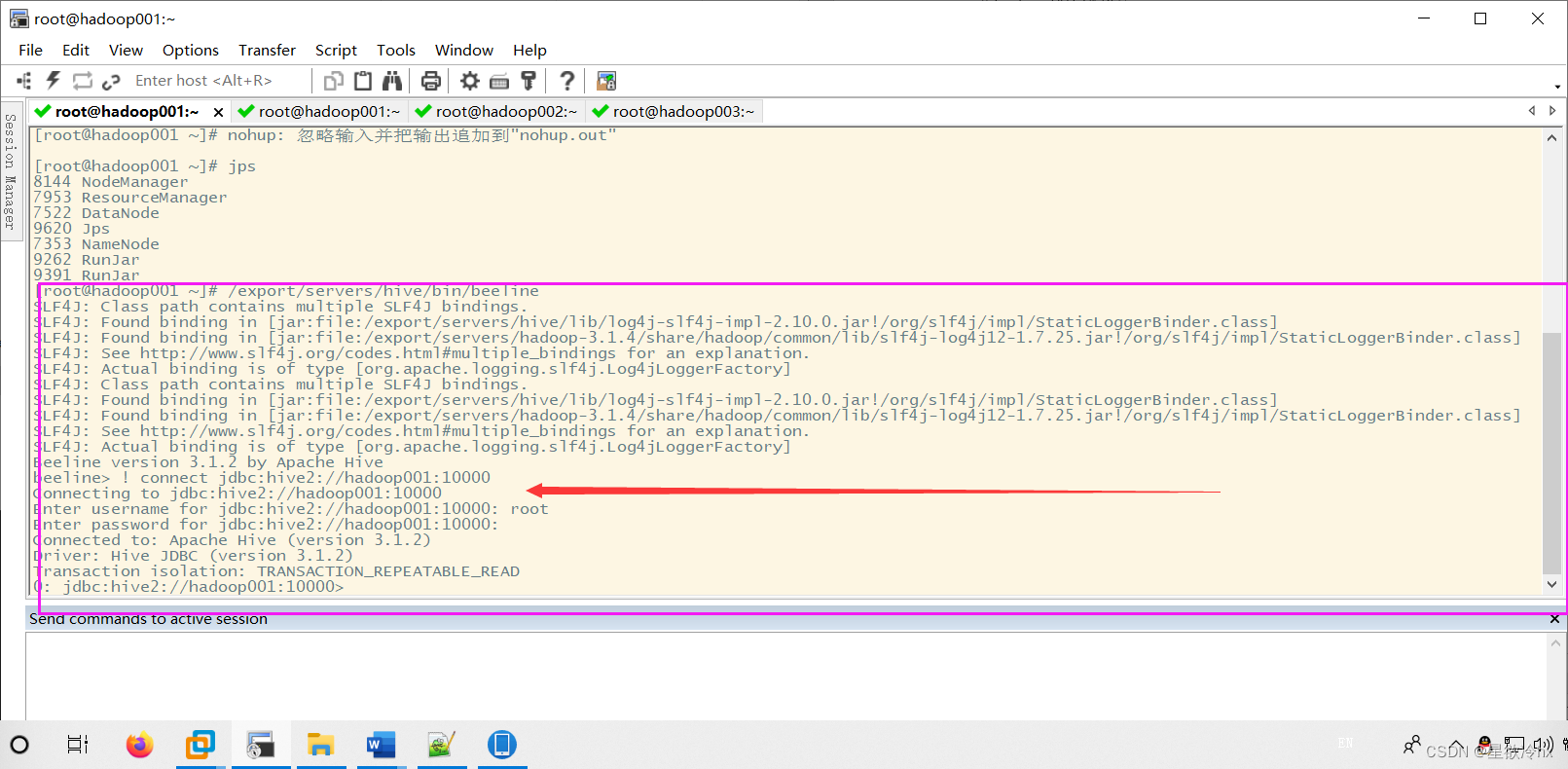

2.链接一般要等一分钟

! connect jdbc:hive2://hadoop001:10000

3.用户名输入root回车,后面密码不用输入直接回车

root

无日志启动

/export/servers/hive/bin/beeline --hiveconf hive.server2.logging.operation.level=NONE

设置本地运行避免小数据通过mr处理缓慢

set hive.exec.mode.local.auto=true;

hive启动脚本

以上启动或停止hive的方法比较麻烦,可以通过编写一个hive脚本hive-script.sh,用于简化步骤

注:hive-script.sh脚本只是启动了metastore服务以及hiveserver2服务,运行hive命令还需要启动beeline服务端

cd /opt/app/hive/bin

vim hive-script.sh

权限chmod +x hive-script.sh

#!/bin/bash

HIVE_LOG_DIR=$HIVE_HOME/logs

mkdir -p $HIVE_LOG_DIR

#检查进程是否运行正常,参数1为进程名,参数2为进程端口

function check_process()

{

pid=$(ps -ef 2>/dev/null | grep -v grep | grep -i $1 | awk '{print $2}')

ppid=$(netstat -nltp 2>/dev/null | grep $2 | awk '{print $7}' | cut -d '/' -f 1)

echo $pid

[[ "$pid" =~ "$ppid" ]] && [ "$ppid" ] && return 0 || return 1

}

function hive_start()

{

metapid=$(check_process HiveMetastore 9083)

cmd="nohup hive --service metastore >$HIVE_LOG_DIR/metastore.log 2>&1 &"

cmd=$cmd" sleep 4; hdfs dfsadmin -safemode wait >/dev/null 2>&1"

[ -z "$metapid" ] && eval $cmd || echo "Metastroe服务已启动"

server2pid=$(check_process HiveServer2 10000)

cmd="nohup hive --service hiveserver2 >$HIVE_LOG_DIR/hiveServer2.log 2>&1 &"

[ -z "$server2pid" ] && eval $cmd || echo "HiveServer2服务已启动"

}

function hive_stop()

{

metapid=$(check_process HiveMetastore 9083)

[ "$metapid" ] && kill $metapid || echo "Metastore服务未启动"

server2pid=$(check_process HiveServer2 10000)

[ "$server2pid" ] && kill $server2pid || echo "HiveServer2服务未启动"

}

case $1 in

"start")

hive_start

;;

"stop")

hive_stop

;;

"restart")

hive_stop

sleep 2

hive_start

;;

"status")

check_process HiveMetastore 9083 >/dev/null && echo "Metastore服务运行正常" || echo "Metastore服务运行异常"

check_process HiveServer2 10000 >/dev/null && echo "HiveServer2服务运行正常" || echo "HiveServer2服务运行异常"

;;

*)

echo Invalid Args!

echo 'Usage: '$(basename $0)' start|stop|restart|status'

;;

esac

⽤脚本启动、停⽌、重启、检测运⾏状态的命令分别为:‘

hive-script.sh start

hive-script.sh stop

hive-script.sh restart

hive-script.sh restart

beeline -u 'jdbc:hive2://master:10000' -n root

已经将hive的配置文件加载到/etc/profile下,随地能打开

这时候hive的环境基本上能运行了,但是还有一个hive 和hbase整合时候无法show databases

将在以后介绍。

版权归原作者 星欲冷hx 所有, 如有侵权,请联系我们删除。