1. 版本异常处理

版本问题;

本编使用的是python12.exe解释器,解决问题,将python.exe版本降低即可,我这里降低到了python10.exe;

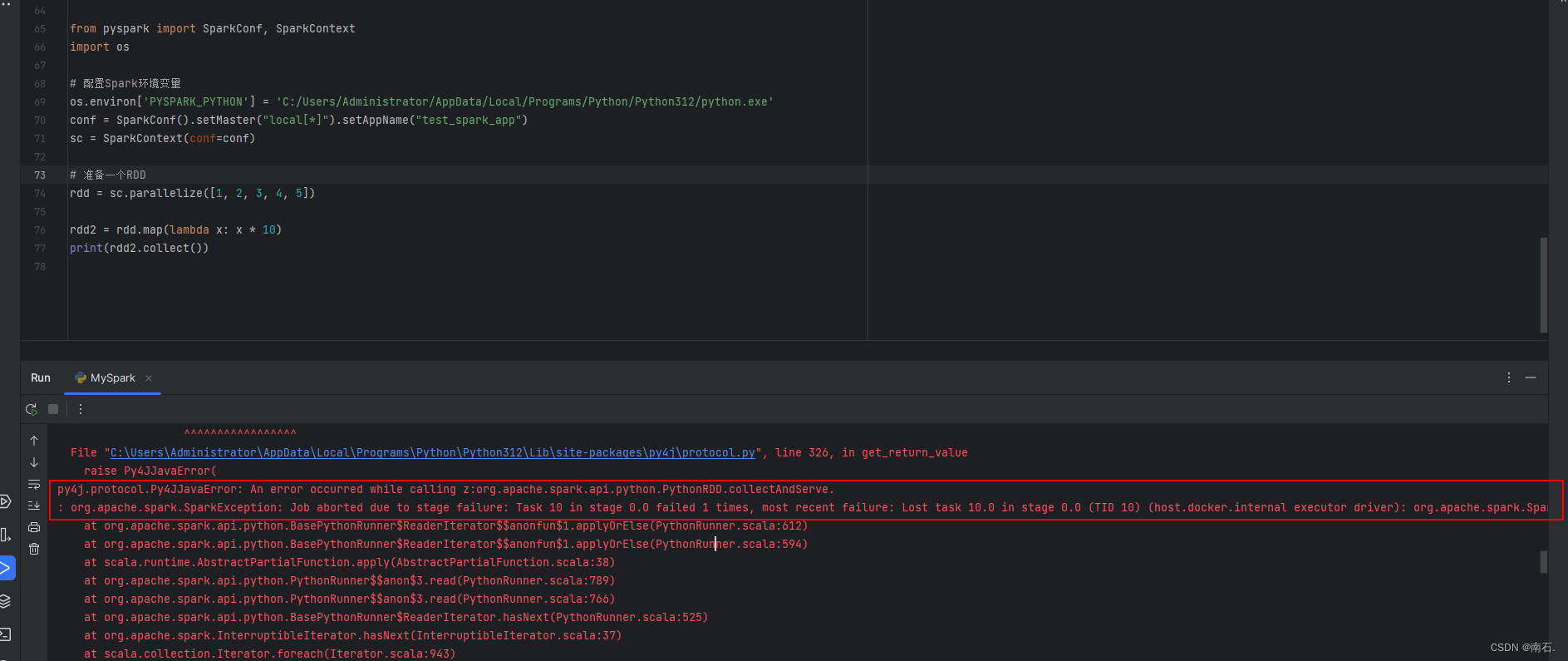

这是错误日志:

官方下载python解释器:Download Python | Python.org

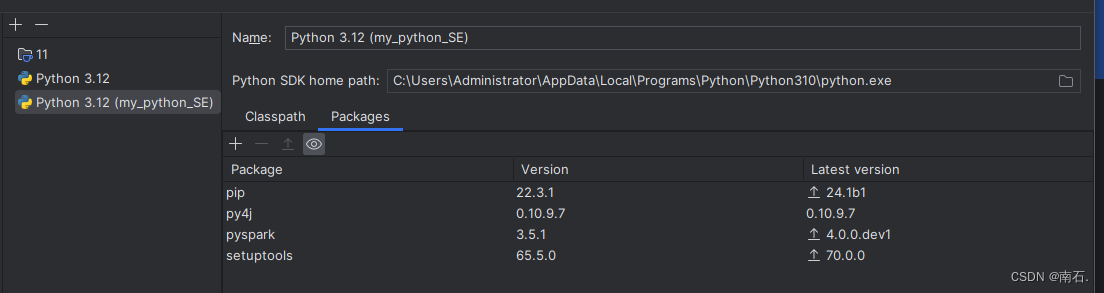

下载好后在开发工具中(idea)去修改python解释器版本:

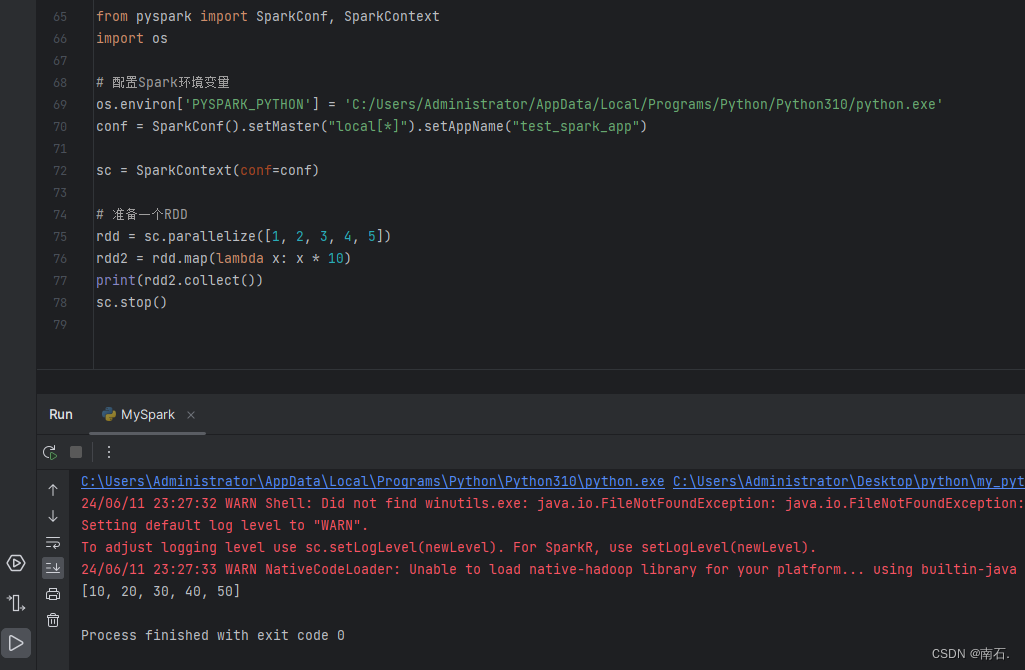

运行结果(map使用):

2. 环境变量异常

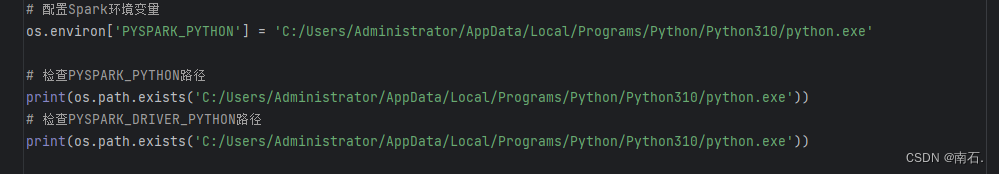

给Spark设置环境变量(不设置的时候,控制台会报错,出现找不到python.exe解释器的情况)

字符串中输入当前项目python.exe解释器路径;

from pyspark import SparkConf, SparkContext

import os

# 配置Spark环境变量

os.environ['PYSPARK_PYTHON'] = 'C:/Users/Administrator/AppData/Local/Programs/Python/Python310/python.exe'

# 检查PYSPARK_PYTHON路径

print(os.path.exists('C:/Users/Administrator/AppData/Local/Programs/Python/Python310/python.exe'))

# 检查PYSPARK_DRIVER_PYTHON路径

print(os.path.exists('C:/Users/Administrator/AppData/Local/Programs/Python/Python310/python.exe'))

版权归原作者 南石. 所有, 如有侵权,请联系我们删除。