生产者的分区写入策略

- 轮询策略

- 随机策略

- 按key写入策略

- 自定义分区策略

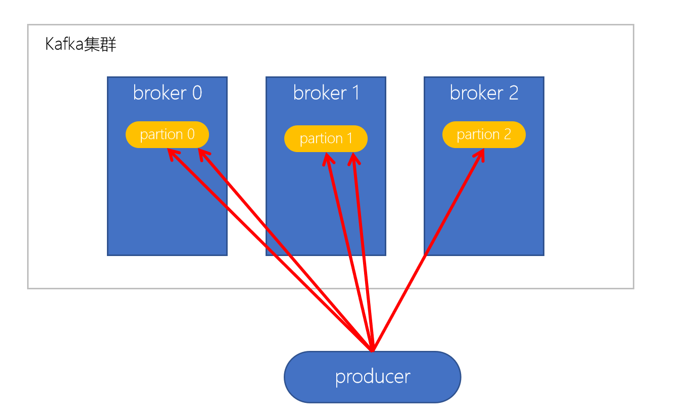

轮询策略

默认的策略,也是使用最多的策略,可以最大限度保证所有的消息平均分配到每一个分区。

如果在生产消息的时候,key为null,则使用轮询算法均衡的分配分区。

随机策略

随机策略,就是随机的将每条消息随机的分配到每个分区。

按key分配策略

按key分配策略,有可能会出现数据倾斜,例如:某个key包含了大量的数据,因为key的值所有的数据都分配到了一个分区,造成分区的消息数量远远大于其他分区。

乱序分区

轮询和随机策略都会导致一个问题,就是生产到kafka的数据都是乱序存储的,而按照key存储的也是一定程度上的有序,也是局部有序,但又有可能导致数据倾斜,所以要结合实际情况取舍。

- 在Kafka中生产者是有写入策略,如果topic有多个分区,就会将数据分散在不同的partition中存储

- 当partition数量大于1的时候,数据(消息)会打散分布在不同的partition中

- 如果只有一个分区,消息是有序的

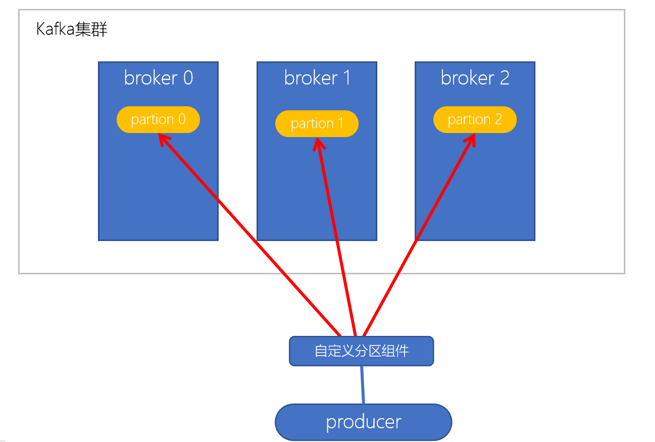

自定义分区策略

实现步骤:

1.自定义分区器

public class KeyWithRandomPartitioner implements Partitioner {

private Random r;

@Override

public void configure(Map<String, ?> configs) {

r = new Random();

}

@Override

public int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster) {

// cluster.partitionCountForTopic 表示获取指定topic的分区数量

return r.nextInt(1000) % cluster.partitionCountForTopic(topic);

}

@Override

public void close() {

}

}

2.在kafka生产者配置中,自定义使用自定义分区器的类名

props.put(ProducerConfig.PARTITIONER_CLASS_CONFIG, KeyWithRandomPartitioner.class.getName());

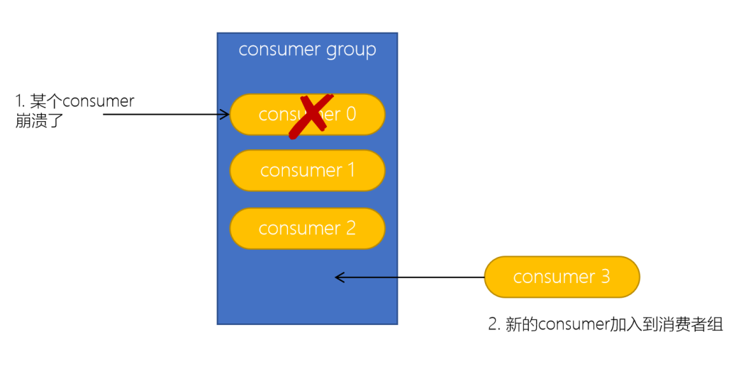

消费者组Rebalance机制

Kafka的Rebalance称之为再平衡,是kafka确保Consumer group下所有consumer如何达成一致,分配订阅的topic的每个分区的机制。

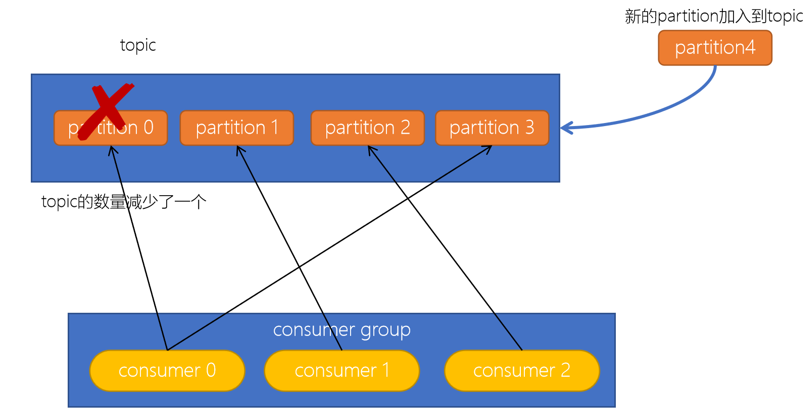

Rebalance触发时机

1.消费者组中consumer的个数发生变化。

例如:有新的consumer加入到消费者组,或者是某个consumer停止了。

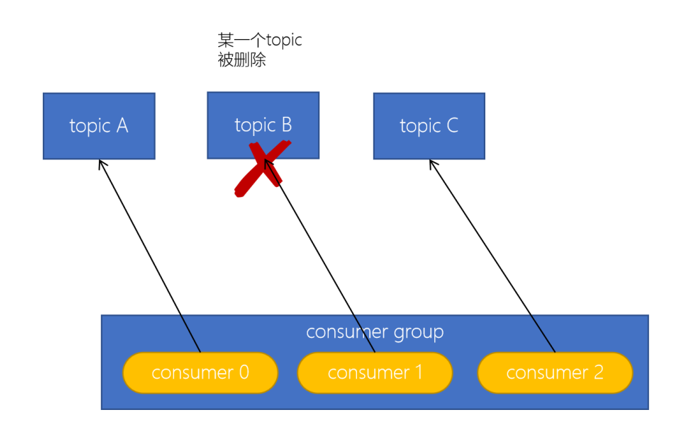

2.订阅的topic的个数发生变化

消费者可以订阅多个主题,假设当前的消费者组订阅了三个主题,但有一个主题突然被删除了,此时也需要发生再均衡。

3.订阅的topic分区数发生变化

Rebalance的不良影响

- 发生Rebalance时,consumer group下的所有consumer都会协调在一起共同参与,Kafka使用分配策略尽可能达到最公平的分配

- Rebalance过程会对consumer group产生非常严重的影响,Rebalance的过程中所有的消费者都将停止工作,直到Rebalance完成

消费者分区分配策略

Range范围分配策略

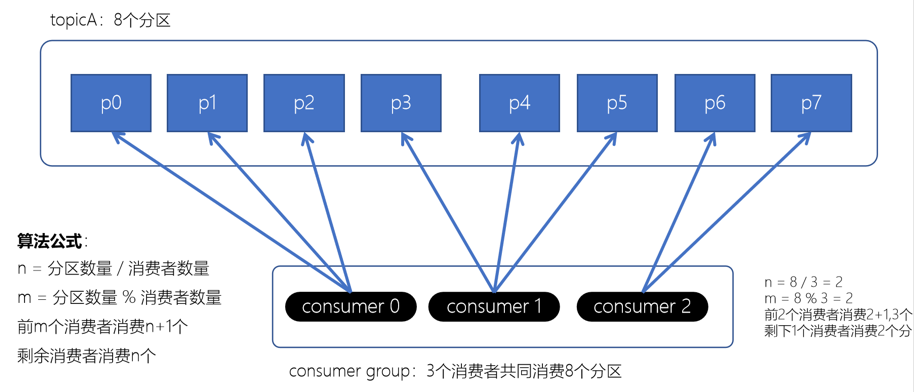

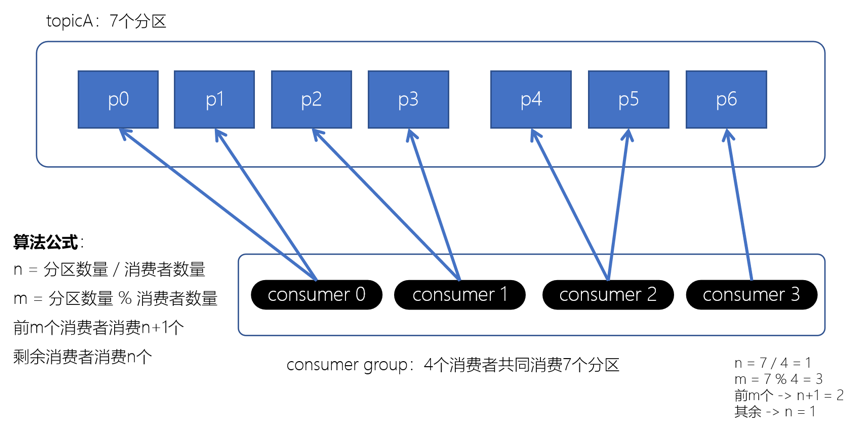

Range范围分配策略是Kafka默认的分配策略,它可以确保每个消费者消费的分区数量是均衡的。

注意:Rangle范围分配策略是针对每个Topic的。

配置

算法公式

n = 分区数量 / 消费者数量

m = 分区数量 % 消费者数量

前m个消费者消费n+1个

剩余消费者消费n个

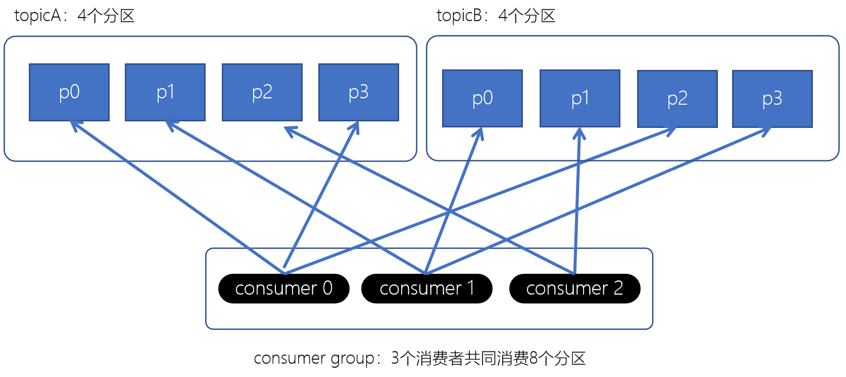

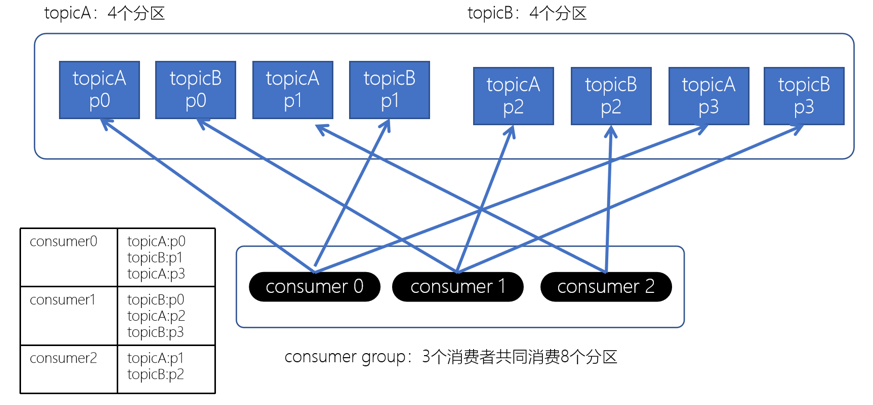

RoundRobin轮询策略

RoundRobin轮询策略是将消费者以及消费者的所订阅的所有topic的所有partitions按照字典序排序(topic和分区的hashcode进行排序)。然后通过轮询方式逐个将分区以此分配给每个消费者。

配置

配置消费者的partition.assignment.strategy为org.apache.kafka.clients.consumer.RoundRobinAssignor

Stricky粘性分配策略

从Kafka 0.11x开始,引入此类分配策略,主要目的:

- 分区分配尽可能均匀

- 在发生rebalance的时候,分区的分配尽可能与上一次分配保持相同

没有发生rebalance时,Striky粘性分配策略和RoundRobin分配策略类似。

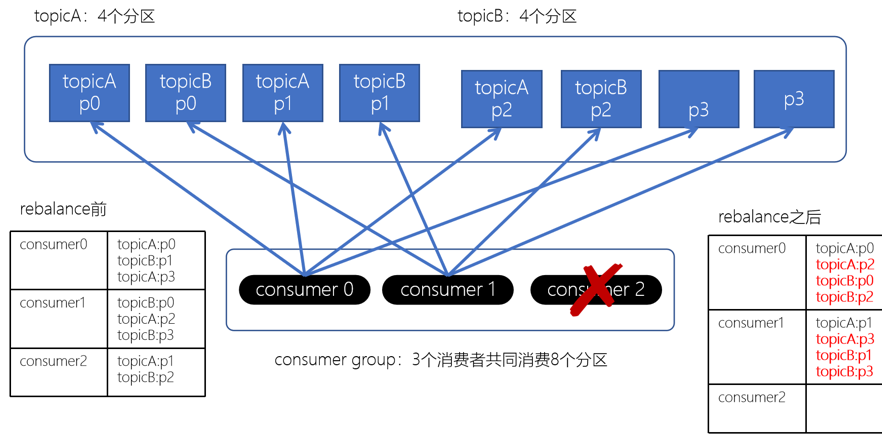

上面如果consumer2崩溃了,此时需要进行rebalance。如果是Range分配和轮询分配都会重新进行分配,例如:

通过上图,我们发现,consumer0和consumer1原来消费的分区大多发生了改变。接下来我们再来看下粘性分配策略。

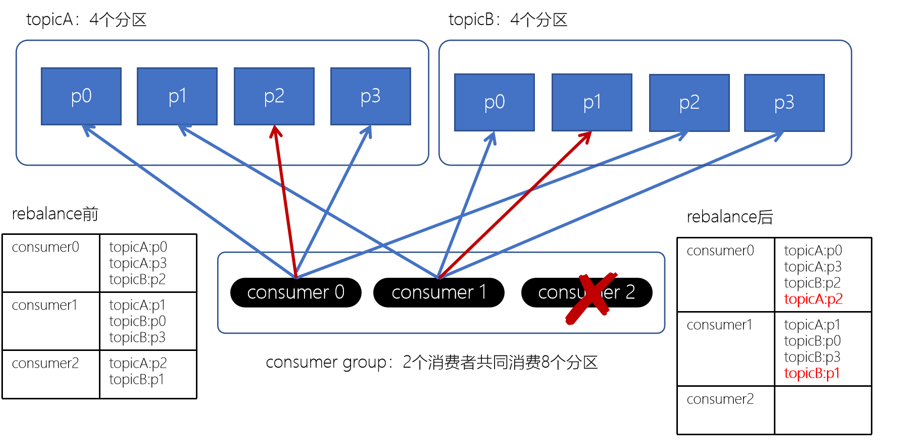

我们发现,Striky粘性分配策略,保留rebalance之前的分配结果。这样,只是将原先consumer2负责的两个分区再均匀分配给consumer0、consumer1。这样可以明显减少系统资源的浪费,例如:之前consumer0、consumer1之前正在消费某几个分区,但由于rebalance发生,导致consumer0、consumer1需要重新消费之前正在处理的分区,导致不必要的系统开销。(例如:某个事务正在进行就必须要取消了)

版权归原作者 五敷有你 所有, 如有侵权,请联系我们删除。