一、下载Hadoop源码

这里有所有Hadoop历史版本,我搭建的是Hadoop2.9版本,下载完成后,放到本地合适的目录下

二、Hadoop环境变量配置

打开.bash_profile文件

vim ~/.bash_profile

进入编辑模式配置hadoop环境路径

export HADOOP_HOME=/Users/Xiaopeng/Projects/hadoop/hadoop-2.8.2

export PATH=$PATH:$HADOOP_HOME/bin

使修改后的配置生效

source ~/.bash_profile

查看hadoop版本

hadoop version

三、修改Hadoop 的配置文件

1、修改hadoop-env.sh 文件

export JAVA_HOME=/Library/Java/JavaVirtualMachines/jdk1.8.0_191.jdk/Contents/Home

export HADOOP_CONF_DIR=/Users/Xiaopeng/Projects/hadoop-2.9.2/etc/hadoop

2、修改core_site.xml 文件

设置Hadoop的临时目录和文件系统,localhost:9000表示本地主机。如果使用远程主机,需要使用ip或者域名表示,需要到/etc/hosts 文件中做DNS 映射,在core-site.xml 中的配置如下:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<!--用来指定hadoop运行时产生文件的存放目录 自己创建-->

<property>

<name>hadoop.tmp.dir</name>

<value>/Users/Xiaopeng/Projects/hadoop-2.9.2/tmp</value>

</property>

</configuration>

3、修改hdfs-site.xml 文件

配置namenode 和 datanode 的存储路径

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!--不是root用户也可以写文件到hdfs-->

<property>

<name>dfs.permissions</name>

<value>false</value> <!--关闭防火墙-->

</property>

<!--把路径换成本地的name坐在位置-->

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/hadoop/cdh4/hadoop/dfs/name</value>

</property>

<!--在本地新建一个存放hadoop数据的文件夹,然后将路径在这里配置一下-->

<property>

<name>dfs.datanode.data.dir</name>

<value>/data1/hadoop</value>

</property>

</configuration>

4、修改mapred-site.xml 文件

/etc/hadoop文件夹下没有mapred-site.xml 文件,需要将 mapred-site.xml.template 拷贝一下再修改

<configuration>

<property>

<!--指定mapreduce运行在yarn上-->

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

5、修改yarn-site.xml 文件

配置资源管理器yarn

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>localhost:9000</value>

</property>

</configuration>

三、启动Hadoop

1、hdfs启动

首先进入sbin目录

cd /Users/Xiaopeng/Projects/hadoop-2.9.2/sbin

namenode 初始化

hadoop namenode -format

启动hdfs

./start-dfs.sh

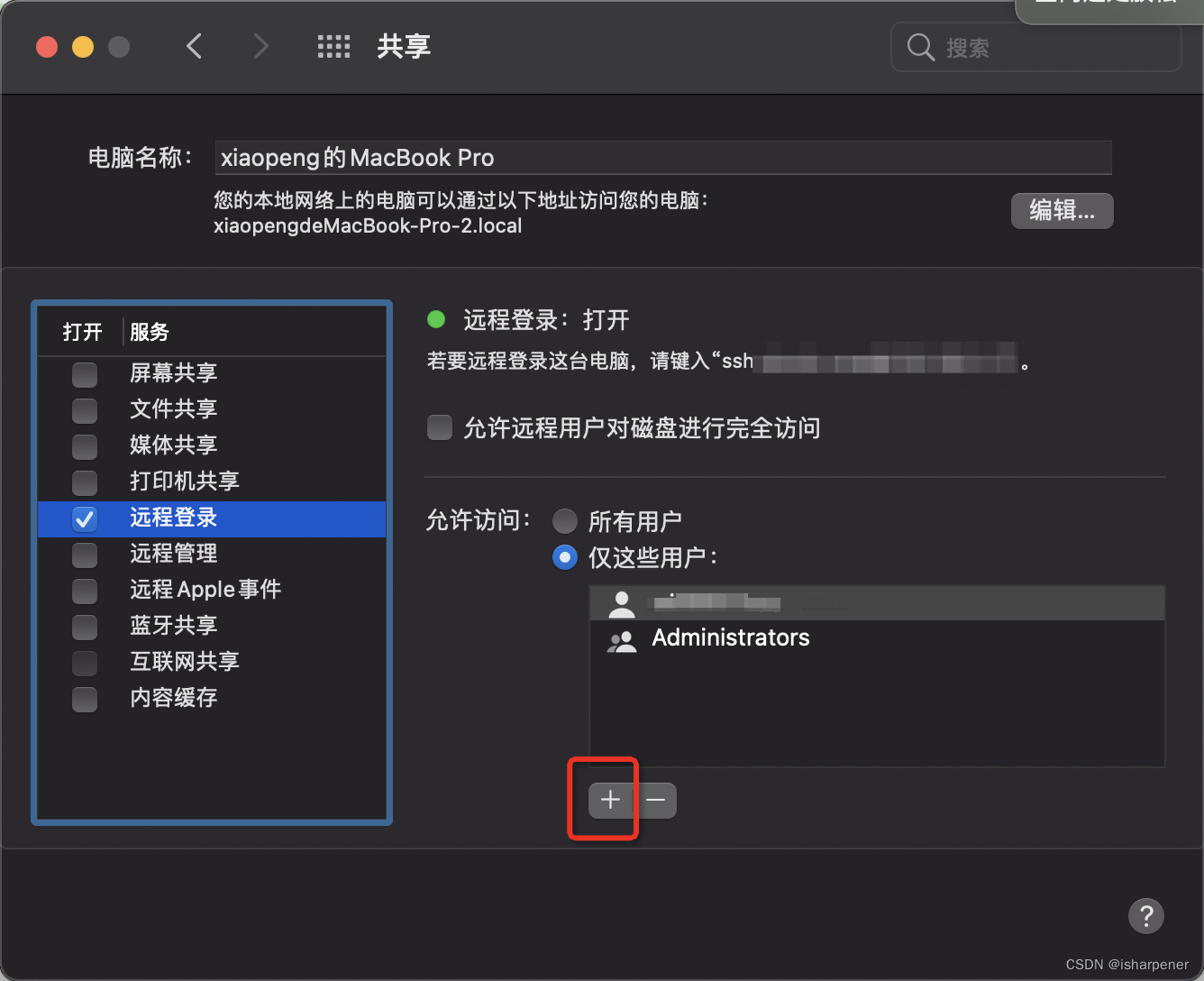

如果遇到“connection refused”,则需要打开远程登录许可,如下图,添加当前用户,使其能远程登录

如果遇到 “Incorrect configuration: namenode address dfs.namenode.servicerpc-address or dfs.namenode.rpc-address is not configured.” 问题,则是hadoop配置 的环境变量没有设置好 或者设置错误,需要重新设置

export HADOOP_CONF_DIR = $HADOOP_HOME/etc/hadoop

2、yarn 启动

在sbin目录运行命令

./start-yarn.sh

至此就可以打开 http://localhost:50070/ 查看hadoop运行情况了

版权归原作者 isharpener 所有, 如有侵权,请联系我们删除。