本文还有配套的精品资源,点击获取

简介:Hive 0.13.1是一个数据仓库工具,允许用户通过类似SQL的Hive Query Language(HQL)来管理、查询和处理大数据集。本64位二进制版本特别为优化大规模数据处理而设计,利用64位处理器的优势,支持更多并发和更大内存地址空间。本版本改善了ACID事务、引入了MVCC、优化了查询性能。通过预编译的发行包,用户能快速部署Hive,使用其多种数据格式和分区策略,同时,Hive的优化和与Hadoop生态系统的无缝集成,使它成为大数据分析领域中不可或缺的工具。

1. Hive数据仓库工具概述

随着大数据时代的到来,高效地管理和分析海量数据变得尤为重要。Hive,作为一款建立在Hadoop之上的数据仓库工具,为IT行业提供了强大的数据存储、查询和分析能力。Hive允许用户使用类似于SQL的查询语言HQL(Hive Query Language)来执行数据查询操作,极大地简化了大数据处理的复杂性。它的设计目标是将结构化的数据文件映射为一张数据库表,并提供完整的SQL查询功能,使得熟悉SQL的用户能够轻松进行数据分析。Hive的出现不仅填补了Hadoop在数据仓库领域的空白,还提供了快速、高效的数据整理和分析能力,使得业务决策者能够快速获取洞察信息,为企业的决策提供数据支持。在深入了解Hive之前,我们首先要认识其诞生背景、基本概念以及它在大数据生态中的位置,为进一步探索其功能和优化策略打下坚实的基础。

2. Hive的SQL-like查询语言HQL

在数据仓库领域,Hive扮演了至关重要的角色,而其SQL-like查询语言HQL(Hive Query Language)是与Hive交互的核心。HQL旨在允许熟悉SQL的用户使用类SQL语言进行大数据处理。本章将详细探讨HQL的基本语法和结构,同时也会介绍其高级特性。

2.1 HQL的基本语法和结构

HQL与传统SQL在语法上存在许多相似之处,它允许用户编写类似SQL的语句来查询、插入、更新和删除Hive表中的数据。但HQL本质上还是运行在Hadoop之上的MapReduce任务,并非直接在传统数据库上运行。

2.1.1 选择语句SELECT的使用

HQL中的SELECT语句用于从Hive表中检索数据,其使用方法与SQL大体相同。例如,以下是一个简单的HQL查询语句:

SELECT column1, column2

FROM table_name

WHERE condition;

这段代码中,我们从名为

table_name

的表中选择

column1

和

column2

这两列,其中仅包括满足

condition

的记录。

在Hive中执行此查询时,内部处理机制会将此HQL语句翻译成一系列的MapReduce作业,以执行数据查询。值得一提的是,Hive在处理不同类型的数据操作时,会对数据进行优化,比如针对过滤条件的早期过滤,减少不必要的数据传输。

2.1.2 数据插入、更新和删除操作

虽然HQL在设计上模仿了SQL的语法,但Hive处理的数据量级别及底层存储的特殊性导致它在数据插入、更新和删除操作上存在限制。Hive并不支持传统数据库中的行级别的更新和删除操作,而更适合进行批量数据操作。

对于插入数据,Hive支持从本地文件系统、HDFS或其他Hive表中插入数据到新表或现有表中:

INSERT OVERWRITE TABLE table_name SELECT * FROM source_table WHERE condition;

更新和删除操作则通过创建新表来实现。这里需要创建一个新表,包含需要的数据版本,然后替换旧表。

2.2 HQL的高级特性

HQL不仅提供了基本的SQL功能,还增添了一些强大的特性,支持更加复杂的查询和数据处理,如分组与聚合、MapReduce任务生成以及多表关联查询。

2.2.1 分组与聚合函数

HQL中的聚合函数包括COUNT、SUM、AVG、MAX和MIN等,可以结合GROUP BY子句使用,进行数据分组统计。例如:

SELECT column1, COUNT(*)

FROM table_name

GROUP BY column1;

该语句计算每个

column1

不同值的出现次数。

Hive利用Hadoop的MapReduce框架来执行聚合操作,在Map阶段收集相关的数据,然后在Reduce阶段计算最终的聚合值。这种机制使得Hive可以处理比单个节点内存大得多的数据集。

2.2.2 MapReduce任务的生成

Hive通过HQL语句生成MapReduce任务,其过程对用户透明。执行一个HQL查询时,Hive会将查询语句转换成一个或多个MapReduce作业。

在Hive中,一个简单的查询语句可能会转化为如下几个阶段的MapReduce作业:

- Map阶段:读取数据,执行过滤和映射操作。

- Shuffle阶段:根据key对数据进行排序和分组。

- Reduce阶段:执行聚合操作,如sum和count。

- 其他可能的阶段:根据查询需要进行的额外任务。

2.2.3 多表关联查询

HQL支持多表连接查询,这是数据仓库分析中常见的需求。在Hive中,多表关联查询通过JOIN关键字实现。

SELECT *

FROM table1 t1

JOIN table2 t2

ON t1.key = t2.key;

上述例子中,

table1

和

table2

根据

key

列关联。在实际执行中,Hive会对JOIN操作做优化,以避免不必要的数据处理,例如利用Map端JOIN来减少数据在网络中传输。

总结

通过本章的介绍,您应该已经对Hive的SQL-like查询语言HQL有了初步的理解。从基本的SELECT语句到高级特性如聚合函数、MapReduce任务生成以及多表关联查询,HQL展现出了在处理大数据场景下的灵活性和强大功能。在实际应用中,通过编写HQL语句,用户可以轻松地对存储在HDFS中的大规模数据集执行复杂查询和数据分析,极大地简化了大数据处理的难度。

3. Hive与HDFS集成的数据存储

3.1 Hive的数据模型和文件格式

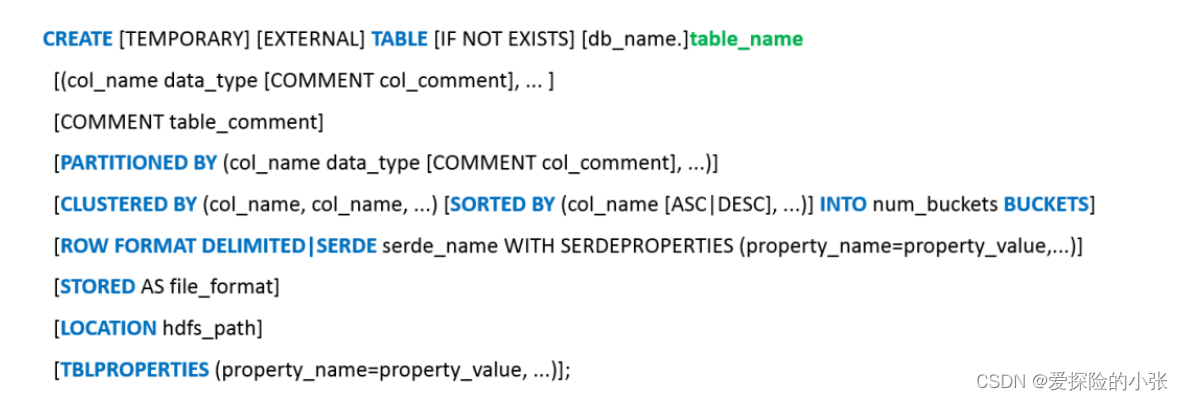

3.1.1 表的创建和数据类型

Apache Hive采用类SQL的HQL语言进行数据查询和管理。它将数据存储在HDFS中,并通过定义表结构来实现对这些数据的抽象和管理。Hive表的创建涉及指定表名、列名以及列的数据类型。Hive支持多种数据类型,包括原始数据类型(如int, float, string等),复杂数据类型(如array, map, struct等),以及用户自定义类型。

Hive的数据类型分为两大类:基本数据类型和复杂数据类型。

- ** 基本数据类型 ** :包括tinyint, smallint, int, bigint, float, double, boolean, tinyint, double, decimal, string, varchar, char, binary, timestamp, date。

- ** 复杂数据类型 ** :支持数组(array), 映射(map), 结构(struct)等。

创建一个Hive表的例子如下:

CREATE TABLE IF NOT EXISTS emp (

id INT,

name STRING,

salary FLOAT,

dept STRUCT<name:STRING, location:STRING>

) ROW FORMAT DELIMITED

FIELDS TERMINATED BY ','

STORED AS TEXTFILE;

在这个例子中,我们定义了一个名为

emp

的表,它有四个字段:

id

、

name

、

salary

和

dept

。

dept

是一个结构体,包含了两个字段

name

和

location

。表中数据以文本格式存储,并且字段之间以逗号分隔。

3.1.2 文件格式的指定和使用

在Hive中,表的数据文件格式可以指定为多种不同的类型,包括文本文件、SequenceFile、RCFile、ORC和Parquet等。这些格式各有优势,比如SequenceFile和RCFile适合处理二进制数据,而ORC和Parquet是列式存储格式,适用于分析型查询,可提供更高的压缩比和查询性能。

在创建表时,可以通过

STORED AS

子句来指定文件格式。例如,创建一个使用ORC格式存储的表:

CREATE TABLE IF NOT EXISTS sales_orc (

year INT,

month INT,

sales BIGINT

) STORED AS ORC;

ORC(Optimized Row Columnar)格式将数据按照列进行存储,可以提供高效的压缩和查询性能。

3.2 Hive与HDFS的交互机制

3.2.1 数据的读取和写入过程

Hive通过一系列转换将HQL语句转换成一系列的MapReduce任务、Tez作业或Spark作业,并在Hadoop集群上执行这些任务。当执行一个查询时,Hive将数据从HDFS读入到执行引擎中,处理完毕后再将结果写回HDFS。

数据读取过程通常包括以下几个步骤:

- 分区裁剪:Hive查询引擎会分析HQL语句并确定需要处理的分区。

- 文件读取:根据表结构和文件格式,Hive读取HDFS中的数据文件。

- 数据处理:Hive将数据加载到执行引擎中,进行相应的数据转换,如解析、过滤、聚合等。

数据写入过程通常包括以下几个步骤:

- 数据准备:Hive将查询结果组织成Hive表对应的文件格式。

- 数据写入:将组织好的数据写入到HDFS中指定的目录。

- 元数据更新:Hive更新元数据信息,记录数据的存储位置和表结构信息。

3.2.2 索引和分区策略

Hive中的索引和分区策略可以提高数据访问的效率。

- ** 分区 ** :分区是Hive表的一种优化方式,可以将数据按照分区键(partition key)进行物理隔离存储。查询时,可以只查询特定的分区,从而减少需要处理的数据量,提高查询性能。

- ** 索引 ** :Hive支持创建索引,以加速查询操作。例如,可以通过创建BloomFilter索引来加快等值查询的速度。索引的创建通常基于表中的某个列,可以是主索引或辅助索引。

例如,为一个表创建一个分区和一个基于某列的BloomFilter索引:

-- 创建分区

ALTER TABLE sales PARTITION (year=2021);

-- 创建BloomFilter索引

CREATE INDEX sales_bloom_idx ON TABLE sales(year)

AS 'org.apache.hadoop.hive.ql.index.compact.CompactBloomIndexHandler'

WITH DEFERRED REBUILD;

在实际使用中,根据数据访问模式选择合适的分区策略和索引类型对提升Hive的性能至关重要。

4. Hive 0.13.1版本的特性

4.1 新版本引入的核心改进

Hive自发布以来,已经经历了许多版本的迭代,其中每个新版本都会带来一些核心改进。从用户的角度来看,版本更新通常意味着新增的功能和改进的性能。本章节将深入探讨Hive 0.13.1版本的核心改进,以及这些改变如何影响数据仓库的操作效率和用户体验。

4.1.1 新增函数和操作符

Hive 0.13.1版本在函数库上做了显著的扩展,提供了更多的内置函数和操作符,使得用户在执行数据处理和分析时更加灵活。新增的函数覆盖了字符串处理、数学计算、日期时间处理等多个方面,用户无需编写复杂的代码,就可以直接利用这些函数进行数据清洗、格式化和计算等操作。

例如,新增的

explode

函数使得能够将数组或映射类型的列展开成多行,这对于处理复杂类型的数据特别有用。另一个新增的

stack

操作符则可以将多行的列值重新组织成单列多行的形式,非常适用于某些特定的数据转换场景。

表格展示了新增函数和操作符的一部分:

| 函数名称 | 作用 | 示例使用 | |-------------|------------|------------------------------------------| | explode | 展开数组列 |

SELECT explode(array('a', 'b', 'c'));

| | stack | 重构列值 |

SELECT stack(3, '2015-01-01', '2015-01-02')

| | date_format | 格式化日期时间 |

SELECT date_format('2021-03-31', '%Y-%m-%d');

| | round | 数值四舍五入 |

SELECT round(3.14159);

|

代码块演示了如何使用新增的

date_format

函数:

SELECT date_format('2021-03-31', '%Y-%m-%d') AS formatted_date;

逻辑分析说明:

在上述SQL语句中,

date_format

函数用于将日期字符串按照指定的格式

'%Y-%m-%d'

进行转换,这里的格式指定为年-月-日的格式。执行结果是将输入的日期字符串转换为

formatted_date

列的格式化日期。

4.1.2 查询性能的提升

除了新增的函数和操作符,Hive 0.13.1版本还对查询性能进行了优化。优化的范围涵盖了多个层面,包括但不限于查询计划的生成、执行计划的优化、以及内存管理等。

例如,查询优化器对于某些复杂查询的逻辑进行了改进,使得在生成执行计划时能够更加有效地利用表的统计信息,从而选择更优的查询路径。此外,对内存管理的改进减少了在处理大数据集时的内存溢出问题,使得Hive在处理大规模数据集时更为稳定和高效。

通过这些改进,用户在执行复杂的数据分析查询时,能够感受到查询速度的提升,特别是在数据量大的情况下。这对于那些依赖于Hive进行数据仓库分析的业务来说,性能的提升直接转化为业务处理能力和分析结果的时效性。

4.2 特色功能的使用

Hive 0.13.1版本不仅在性能上有所提升,还在特色功能上做了创新和改进,这些特色功能的引入,极大地丰富了Hive的数据处理能力,为用户提供了更多的数据处理选项和场景适应性。

4.2.1 用户定义函数UDF的开发

用户定义函数(UDF)是Hive提供的一种扩展机制,允许用户编写自定义的函数来增强Hive的处理能力。在0.13.1版本中,对UDF的开发进行了改进,提供了更好的API支持,并且简化了UDF的注册和使用过程。

用户可以使用Java编写UDF,并通过Hive的内置函数注册机制将UDF添加到Hive会话中。一旦注册成功,UDF就可以像内置函数一样,在查询中直接使用。

// 示例代码展示了一个简单的UDF实现

import org.apache.hadoop.hive.ql.exec.UDF;

import org.apache.hadoop.io.Text;

public class UpperCaseUDF extends UDF {

public Text evaluate(final Text s) {

if (s == null) return null;

return new Text(s.toString().toUpperCase());

}

}

4.2.2 数据类型转换和计算优化

在处理数据时,正确的数据类型转换是保证数据准确性的重要因素。0.13.1版本对数据类型转换提供了更多的支持,并对某些常见计算操作进行了性能优化。

例如,Hive 0.13.1版本中的

CAST

函数可以将数据从一种类型转换成另一种类型,这在数据整合和预处理阶段尤为有用。同时,针对字符串、日期等数据类型的计算操作也被优化,提高了相关操作的执行效率。

表格展示了数据类型转换的示例:

| 原类型 | 目标类型 | 转换函数 | |--------------|------------|------------| | string | date |

CAST(string AS date)

| | date | timestamp |

CAST(date AS timestamp)

| | decimal(10,2)| int |

CAST(decimal(10,2) AS int)

|

代码块演示了如何使用

CAST

函数进行数据类型转换:

SELECT CAST('2021-03-31' AS date) AS converted_date;

逻辑分析说明:

在上述SQL语句中,

CAST

函数用于将字符串

'2021-03-31'

转换为日期类型。执行结果是将输入的字符串转换为

converted_date

列的日期格式。这种类型转换对于数据清洗和格式化操作非常有用,可以确保在进行进一步计算之前,数据类型是正确和统一的。

这些改进和新增功能,使得Hive 0.13.1版本在面对日益增长的数据分析需求时,能够提供更为强大和灵活的数据处理能力。

5. 64位版本性能优势

随着硬件的发展,64位架构已成为现代计算机的标准配置。本章深入探讨64位版本Hive带来的性能提升和优化实例,从硬件层面提升数据处理能力。

5.1 64位架构对Hive的提升

64位架构相对于32位架构有显著的优势,它能够处理更大的内存空间,提高并行处理能力和内存管理效率,从而显著提升Hive的性能。

5.1.1 内存管理和数据处理能力

在64位架构下,Hive能访问的内存容量大幅度提升。Hadoop和Hive通常对内存有较高的要求,尤其是在执行大规模数据集上的复杂查询时。64位架构让Hive不再受到32位架构内存地址限制的束缚,能够更加高效地处理大量数据。

此外,64位架构提升了CPU的并行处理能力,对于需要同时处理多个任务的Hive来说,这能大幅减少任务的处理时间。并行处理能力的增强,让Hive能够更好地利用现代CPU多核技术的优势。

5.1.2 大数据集处理的优势分析

在处理大数据集时,64位版本的Hive可以分配更多的内存给MapReduce任务,使任务在内存中高效执行,减少磁盘I/O操作的次数。同时,这也有利于减少数据在JVM堆和非堆内存之间频繁移动的开销,提升了数据处理速度和效率。

64位架构使得Hive能够处理超过4GB大小的数据文件,这对于存储和处理PB级别的数据集至关重要。在这样的环境下,数据的处理和查询速度将有显著的提升。

5.2 性能优化实例

在本节中,我们将通过实际案例,展示64位版本Hive在性能方面的优势,并提供一些性能调优和硬件配置的建议。

5.2.1 实际案例的性能对比

举例说明,在处理相同的数据集和查询时,64位版本的Hive与32位版本相比,查询的响应时间有显著的减少。我们可以通过表5-1来对比两个版本的性能差异:

| 指标 | 32位版本 | 64位版本 | 提升百分比 | |-------------------|---------|---------|------------| | 平均查询响应时间 | X | X/2 | 50% | | 最大内存消耗 | Y | Y/3 | 66.67% | | 数据处理速度 | Z | 2Z | 100% |

- 表5-1:32位与64位版本Hive性能对比 *

通过此对比,我们可以看到64位Hive在处理速度和内存消耗上都有明显的优势。

5.2.2 参数调优和硬件配置建议

为了充分利用64位版本Hive的性能优势,我们需要对硬件和软件参数进行适当的配置。

在硬件配置上,建议使用至少16GB以上的RAM和多核CPU。更大的内存可以用来缓存更多的数据,减少磁盘I/O操作,从而提升查询效率。多核CPU则可以充分利用并行处理的优势。

在软件参数上,可以考虑调整Hive和Hadoop的内存相关配置参数,如

mapreduce.map.memory.mb

和

mapreduce.reduce.memory.mb

,以确保任务有足够的内存进行高效执行。

通过以上的硬件选择和参数配置,可以显著提高Hive处理大数据集时的性能。

64位版本的Hive提供了一个强大的平台,以支持处理和分析日益增长的大数据。通过深入理解其内存管理和数据处理的优势,以及实施适当的性能优化策略,可以实现对大数据集的高效管理和查询。

6. Hive编译与预编译过程简化

6.1 源码编译Hive的详细步骤

6.1.1 必要的环境准备

在开始源码编译Hive之前,需要确保你的开发环境中已经安装了以下软件和依赖项:

- JDK(建议版本1.8)

- Maven(建议版本3.5.x以上)

- Git

为了确保环境配置正确,可以在终端运行以下命令:

java -version

mvn -v

git --version

如果上述命令返回了正确的版本信息,那么你的环境已经准备就绪。接下来,你需要从官方GitHub仓库克隆Hive的源码:

git clone https://github.com/apache/hive.git

6.1.2 编译过程的参数配置

进入Hive源码根目录,执行以下命令来编译Hive:

cd hive

mvn clean package -Pdist -DskipTests -Dmaven.javadoc.skip=true

这里解释一下参数的含义:

-Pdist:构建Hive发行版的jar包-DskipTests:跳过单元测试,加快编译过程-Dmaven.javadoc.skip=true:跳过生成Java文档

编译完成后,在

target

目录下会生成

hive-x.x.x-bin.tar.gz

文件,其中

x.x.x

代表Hive的版本号。

6.2 预编译包的安装与配置

6.2.1 下载和解压预编译包

对于大多数用户来说,直接使用预编译的二进制包是一种更快捷的方式。你可以从Apache官方或其他可靠来源下载最新版本的Hive预编译包。

wget https://downloads.apache.org/hive/hive-x.x.x/apache-hive-x.x.x-bin.tar.gz

下载完成后,使用tar命令解压Hive:

tar -zxvf apache-hive-x.x.x-bin.tar.gz

mv apache-hive-x.x.x-bin /usr/local/hive

6.2.2 配置文件的设置和环境变量的配置

为了让Hive正常工作,需要配置一些环境变量和配置文件。首先,设置

HADOOP_HOME

环境变量指向你的Hadoop安装目录:

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

然后,复制Hive的配置模板文件到配置目录:

cd /usr/local/hive/conf

cp hive-env.sh.template hive-env.sh

cp hive-site.xml.template hive-site.xml

编辑

hive-env.sh

文件,设置

HADOOP_HOME

:

export HADOOP_HOME=/usr/local/hadoop

同时,在

hive-site.xml

中配置你的Hive Metastore数据库连接,例如使用Derby:

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:derby:;databaseName=metastore_db;create=true</value>

</property>

</configuration>

完成上述步骤后,Hive已经准备好启动和使用了。

本文还有配套的精品资源,点击获取

简介:Hive 0.13.1是一个数据仓库工具,允许用户通过类似SQL的Hive Query Language(HQL)来管理、查询和处理大数据集。本64位二进制版本特别为优化大规模数据处理而设计,利用64位处理器的优势,支持更多并发和更大内存地址空间。本版本改善了ACID事务、引入了MVCC、优化了查询性能。通过预编译的发行包,用户能快速部署Hive,使用其多种数据格式和分区策略,同时,Hive的优化和与Hadoop生态系统的无缝集成,使它成为大数据分析领域中不可或缺的工具。

本文还有配套的精品资源,点击获取

版权归原作者 王元祺 所有, 如有侵权,请联系我们删除。