开源ETL(Extract, Transform, Load)工具为组织提供了一种经济高效的方法来集成来自不同源的数据,以便进行分析、报告和业务智能。这些工具通常具有灵活性、可扩展性和较低的总体拥有成本。以下是几种流行的开源ETL工具及其特点、安装步骤和应用场景的概述。

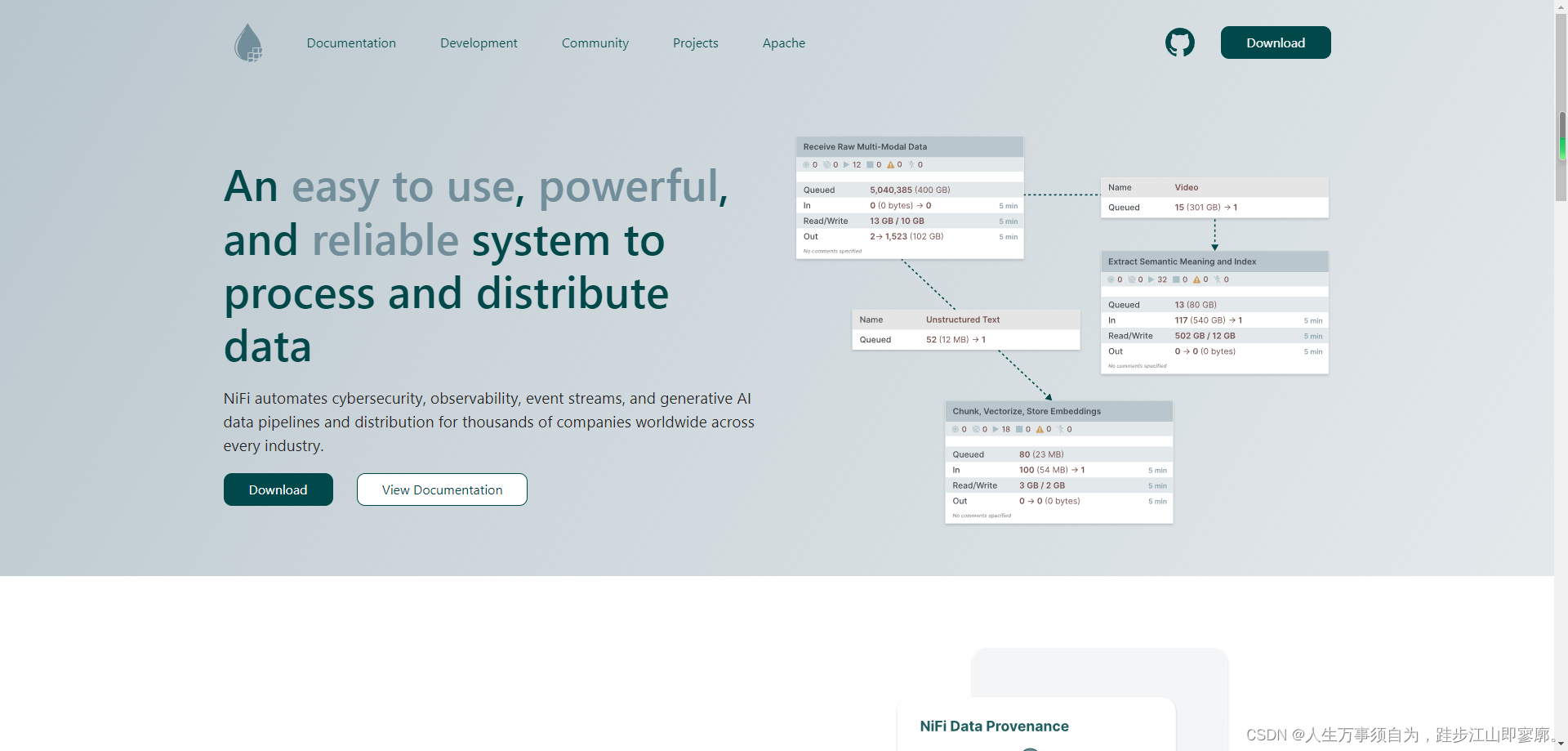

** 1. Apache NiFi**

Apache NiFi是一个开源的数据流动管理系统,用于处理和分发数据。

特点

- 用户友好的界面:NiFi使用图形界面,允许用户轻松设计数据流。

- 强大的数据处理:支持各种数据处理组件,如过滤器、转换器和路由器。

- 高度可配置:可以自定义数据流和处理组件的行为。

- 集群支持:NiFi可以在集群环境中运行,提高可靠性和吞吐量。

安装步骤

- 下载NiFi:从Apache NiFi官网下载最新版本。

- 解压文件:将下载的文件解压到目标目录。

- 配置NiFi:编辑

conf/nifi.properties文件,设置相关配置。 - 启动NiFi:运行

bin/nifi.sh脚本启动NiFi服务。

应用场景

- 数据集成:将数据从多个源整合到一个中央存储系统中。

- 数据处理:对数据进行清洗、转换和归一化。

- 数据分发:将数据分发到不同的目标系统。

** 2. Pentaho Data Integration (PDI)**

PDI,也称为Kettle,是一个强大的开源ETL工具,用于数据集成和数据仓库。

特点

- 图形化设计:通过图形界面设计ETL流程,无需编程。

- 丰富的转换:提供广泛的转换步骤,满足各种数据处理需求。

- 插件支持:支持扩展和插件,增加新功能。

- 跨平台:在Windows、Linux和Mac OS X上运行良好。

安装步骤

- 下载PDI:从Pentaho官网下载最新版本。

- 解压文件:将下载的文件解压到目标目录。

- 启动PDI:运行

bin/spoon.sh(Linux/Mac)或bin/spoon.bat(Windows)启动PDI。

应用场景

- 数据迁移:在不同数据库和文件系统之间迁移数据。

- 数据仓库:构建和维护数据仓库。

- 数据清洗:处理和清洗不完整或不一致的数据。

** 3. Talend Open Studio**

Talend Open Studio是一个全面的ETL和数据集成平台。

特点 - 企业级功能:提供企业级数据集成解决方案的功能。

- 社区支持:有一个活跃的社区支持,提供大量的资源和插件。

- 丰富的组件:包含广泛的预构建组件,用于数据处理和集成。

安装步骤

- 下载Talend Open Studio:从Talend官网下载最新版本。

- 安装JDK:安装Java Development Kit,因为Talend是Java应用程序。

- 安装Talend Studio:运行安装程序并按照指示完成安装。

应用场景

大数据集成:处理大规模数据集。

云数据集成:与云服务提供商(如AWS、Azure)集成。

数据质量和治理:确保数据的准确性和一致性。

** 4. Apache Sqoop**

Sqoop是一个开源工具,用于在Hadoop生态系统和传统的基于SQL的数据库系统之间传输数据。

特点

- 数据迁移:将数据从数据库迁移到Hadoop环境。

- 数据同步:支持数据在Hadoop和数据库之间同步。

- 简单易用:用户可以通过简单的命令行界面使用Sqoop。

安装步骤

- 下载Sqoop:从Apache Sqoop官网下载最新版本。

- 安装Hadoop:Sqoop通常与Hadoop一起使用,需要先安装Hadoop。

- 配置Sqoop:编辑

sqoop-env.sh文件,设置Hadoop和Java的路径。 - 启动Sqoop:运行

sqoop命令行工具。

应用场景

- 大数据数据迁移:将数据从传统数据库迁移到Hadoop环境。

- 数据集成:在Hadoop生态系统和传统数据库系统之间集成数据。

** 5. Apache Flume**

Apache Flume是一个用于收集、聚合和移动大量日志数据的分布式服务。

特点 - 高可靠性:能够处理大量的数据,并且具有高可靠性。

- 灵活性:支持多种数据源和数据接收器。

- 可扩展性:可以轻松扩展以处理更多的数据。

安装步骤

- 下载Flume:从Apache Flume官网下载最新版本。

- 解压文件:将下载的文件解压到目标目录。

- 配置Flume:编辑

flume-conf.properties文件,设置相关配置。 - 启动Flume:运行

bin/flume-ng agent --conf conf --conf-file $CONF_FILE --name $AGENT_NAME命令。

应用场景

- 日志数据收集:从多个服务器收集日志数据。

- 数据流处理:在数据流入Hadoop或其他数据存储系统之前,对数据进行处理。

** 6. Apache Storm**

Apache Storm是一个分布式实时计算系统,用于处理和分析数据流。

特点 - 实时处理:能够对数据流进行实时处理和分析。

- 高可用性:在发生故障时,系统可以继续运行。

- 扩展性:可以根据需要轻松扩展系统。

安装步骤

- 下载Storm:从Apache Storm官网下载最新版本。

- 解压文件:将下载的文件解压到目标目录。

- 配置Storm:编辑

storm.yaml文件,设置相关配置。 - 启动Storm:运行

bin/storm nimbus和bin/storm supervisor命令。

应用场景

- 实时数据流处理:处理来自各种源的大量实时数据。

- 实时分析:对实时数据进行分析,如股票价格分析、社交媒体监控等。

** 7. Apache Kafka**

Kafka是一个分布式流处理平台,用于构建实时数据管道和流式应用程序。

特点 - 高吞吐量:能够处理大量的数据,并提供高吞吐量。

- 可扩展性:可以轻松扩展以处理更多的数据。

- 容错性:即使在出现故障的情况下,系统也可以继续运行。

安装步骤

- 下载Kafka:从Apache Kafka官网下载最新版本。

- 解压文件:将下载的文件解压到目标目录。

- 配置Kafka:编辑

server.properties文件,设置相关配置。 - 启动Kafka:运行

bin/kafka-server-start.sh脚本。

应用场景

- 消息队列:作为消息队列系统,用于生产者和消费者之间的异步通信。

- 实时数据流处理:与Apache Storm等流处理框架结合使用,进行实时数据处理和分析。

** 安装步骤和应用场景的总结**

安装步骤通常包括下载、解压、配置和启动应用程序。具体步骤可能会根据不同的工具和操作系统有所不同。应用场景涵盖了数据集成、数据处理、数据分析和实时数据处理等多种用途。根据组织的具体需求,可以选择适合的工具来完成数据集成任务。

开源ETL工具提供了强大的功能和灵活性,同时降低了成本。用户可以根据自己的需求选择合适的工具,并利用社区资源来解决可能遇到的问题。通过合理使用这些工具,组织可以有效地管理和整合数据,支持数据驱动的决策和业务流程。

版权归原作者 人生万事须自为,跬步江山即寥廓。 所有, 如有侵权,请联系我们删除。