如果觉得我的分享对您的学习有帮助,可以点赞关注哈!谢谢哈!!!

(一)、理论部分:

1.数据处理

2.模型构建

1)复杂构建方法(方便熟悉构建过程)

2)简单构建方法(较为简单)

(二)、代码实战

1.导入模块

import os #python中import os是指导入os模块到当前程序。

os.environ["KMP_DUPLICATE_LIB_OK"]="TRUE"##如果没有这段代码,将会出现内核断掉的情况

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import torch

import torch.optim as optim

import warnings

warnings.filterwarnings("ignore")

%matplotlib inline

(1)、%matplotlib inline

官方给出的定义是:Python有一组预先定义好的所谓的魔法函数(Magic Functions),你可以通

过命令行的语法形式来访问它们。所以%matplotlib inline 可以在python编译器里直接使用,功能是

可以内嵌绘图,并且可以省略掉plt.show()这一步。用在Jupyter notebook(不能在pycharm中使

用)中具体作用是当你调用matplotlib.pyplot的绘图函数plot()进行绘图的时候,或者生成一个figure

画布的时候,可以直接在你的python console里面生成图像。使用%matplotlib命令可以将

matplotlib的图表直接嵌入到Notebook之中,或者使用指定的界面库显示图表,它有一个参数指定

matplotlib图表的显示方式。inline表示将图表嵌入到Notebook中。

(2)、warnings.filterwarnings("ignore")

警告过滤器用于控制警告消息的行为,如忽略,显示或转换为错误(引发异常)。警告过滤器维护

着一个有序的过滤规则列表,匹配规则用于确定如何处理警告,任何特定警告都将依次与列表中的

每个过滤规则匹配,直到找到匹配为止。import warnings,warnings.filterwarnings('ignore')。这两

行代码可以用在,解决在 Python 数据分析时, 不管是调用模型还是调整参数,都充满了满篇红

色,有些可忽略,有些不可忽略。

2.读入数据

这个数据包可以自己在Excel中创建一个csv文件(我是看一个主播的csv文件,然后自己编了一个数据)

features=pd.read_csv("temps.csv")#pandas读取数据的格式

#看看数据长什么样子

features.head()#查看前五行数据

features.shape

(8, 9)

数据表中

year,moth,day,week分别表示的具体的时间; temp_2:前天的最高温度值; temp_1:昨天的最高温度值; average:在历史中,每年这一天的平均最高温度值; actual:这就是我们的标签值了,当天的真实最高温度; friend:这一列可能是凑热闹的,你的朋友猜测的可能值,咱们不管它就好了;

#处理时间数据

import datetime

#分别得到年,月,日

years=features['year']

months=features['month']

days=features['day']

#datetime格式

#必须把str转换为datetime。转换方法是通过datetime.strptime()实现

#datetime.datetime.strptime:万能的日期格式转换

dates = [str(int(year)) + '-' + str(int(month)) + '-' + str(int(day)) for year, month, day in zip(years, months, days)]

dates = [datetime.datetime.strptime(date, '%Y-%m-%d') for date in dates]

dates

输出结果为:

[datetime.datetime(2016, 1, 1, 0, 0),

datetime.datetime(2016, 1, 2, 0, 0),

datetime.datetime(2016, 1, 3, 0, 0),

datetime.datetime(2016, 1, 4, 0, 0),

datetime.datetime(2016, 1, 5, 0, 0),

datetime.datetime(2016, 1, 6, 0, 0),

datetime.datetime(2016, 1, 7, 0, 0),

datetime.datetime(2016, 1, 8, 0, 0)]

##要理解上面这段代码

dates = [str(int(year)) + '-' + str(int(month)) + '-' + str(int(day)) for year, month, day in zip(years, months, days)]

dates = [datetime.datetime.strptime(date, '%Y-%m-%d') for date in dates]##这一段主要讲的是datetime和列表表达式的知识点,要是小伙伴们不太理解,看看我的其他内容,有讲解的

上面的列表表达式在我的上一章节中有详细讲解。

3.展示和数据标准化(使用matplotlib画图)

plt.style.use('fivethirtyeight')##准备画图,##指定默认风格

fig, ((ax1, ax2), (ax3, ax4)) = plt.subplots(nrows=2, ncols=2, figsize = (15,15))# 设置布局

fig.autofmt_xdate(rotation = 45)#X轴上旋转45度并且右对齐

ax1.plot(dates, features['actual'])

ax1.set_xlabel(''); ax1.set_ylabel('Temperature'); ax1.set_title('Max Temp')#

ax2.plot(dates, features['temp_1'])# 昨天

ax2.set_xlabel(''); ax2.set_ylabel('Temperature'); ax2.set_title('Previous Max Temp')

ax3.plot(dates, features['temp_2'])# 前天

ax3.set_xlabel('Date'); ax3.set_ylabel('Temperature'); ax3.set_title('Two Days Prior Max Temp')

ax4.plot(dates, features['friend'])# friend

ax4.set_xlabel('Date'); ax4.set_ylabel('Temperature'); ax4.set_title('Friend Estimate')#tight_layout会自动调整子图参数,使之填充整个图像区域

plt.tight_layout(pad=2)#会自动调整子图参数,使之填充整个图像区域。这是个实验特性,可能在一些情况下不工作。它仅仅检查坐标轴标签、刻度标签以及标题的部分。

上面画出的图像为:

1)图像风格问题:

这样可以查看画出的图像都有哪些风格?

print(plt.style.available) # 打印风格列表,需要哪一种风格就选哪一种风格

执行上面的代码可以看出有下面这些风格:

['Solarize_Light2', '_classic_test_patch', '_mpl-gallery', '_mpl-gallery-nogrid', 'bmh', 'classic', 'dark_background', 'fast', 'fivethirtyeight', 'ggplot', 'grayscale', 'seaborn', 'seaborn-bright', 'seaborn-colorblind', 'seaborn-dark', 'seaborn-dark-palette', 'seaborn-darkgrid', 'seaborn-deep', 'seaborn-muted', 'seaborn-notebook', 'seaborn-paper', 'seaborn-pastel', 'seaborn-poster', 'seaborn-talk', 'seaborn-ticks', 'seaborn-white', 'seaborn-whitegrid', 'tableau-colorblind10']

2)、把数据转化为可以构建成网络模型的数据(独热编码)

features = pd.get_dummies(features)

features.head(5)

运行结果为:

这一步关键的操作可以将features转化为下面的这种格式,这一步就是利用pandas实现one hot encode(独热编码)的方式。可以将非数字字符比如(" Fri Sat Sun Mon Tues Wed Thur ")转化为用数字表示的形式:

转化后的数据为:

3)去除真实值(actual列),将来用模型预测出的值与这项值进行比较

3)去除真实值(actual列),将来用模型预测出的值与这项值进行比较

# 标签

labels = np.array(features['actual'])

# 在特征中去掉标签

#drop函数默认删除行,列需要加axis = 1

features = features.drop('actual', axis = 1)

features

输出:

4)将数据标准化(数据的跨度比较大,有的值为‘1’,还有的是‘45’)

#对数据进行标准化,sklearn.preprocessing包提供了几个常用的实用函数和转换器类

from sklearn import preprocessing

#fit_transform是fit和transform的组合,既包括了训练又包含了转换。

input_features = preprocessing.StandardScaler().fit_transform(features)

#展示

input_features[0]

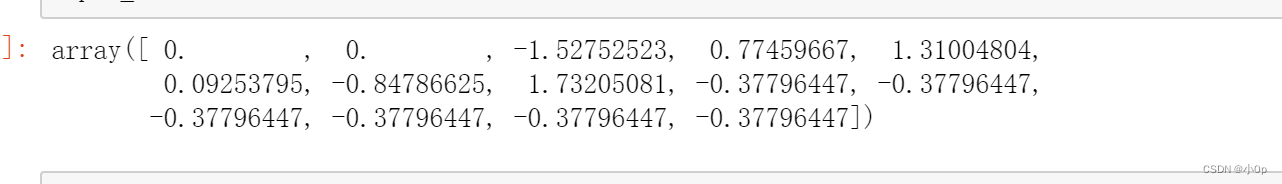

输出:

可以看出来处理完成之后的数据浮动较小,收敛速度较快。

可以看出来处理完成之后的数据浮动较小,收敛速度较快。

4、构建网络模型

#转化成张量格式

x = torch.tensor(input_features, dtype = float)

y = torch.tensor(labels, dtype = float)

#初始化权重参数#返回一个张量,包含了从标准正态分布(均值为0,方差为1,即高斯白噪声)中抽取的一组随机数。

weights = torch.randn((14, 128), dtype = float, requires_grad = True)

biases = torch.randn(128, dtype = float, requires_grad = True)

weights2 = torch.randn((128, 1), dtype = float, requires_grad = True)

biases2 = torch.randn(1, dtype = float, requires_grad = True)

learning_rate = 0.001

losses = []

for i inrange(1000):

# 计算隐层;x.mm(weights) x与weights相乘

hidden = x.mm(weights) + biases

# 加入激活函数

hidden = torch.relu(hidden)

# 预测结果,第二层

predictions = hidden.mm(weights2) + biases2

# 计算损失

loss = torch.mean((predictions - y) ** 2)

losses.append(loss.data.numpy())

# 打印损失值if i % 100 == 0:

print('loss:', loss)

# 反向传播

loss.backward()

#更新参数,-号表示反方向

weights.data.add_(- learning_rate * weights.grad.data)

biases.data.add_(- learning_rate * biases.grad.data)

weights2.data.add_(- learning_rate * weights2.grad.data)

biases2.data.add_(- learning_rate * biases2.grad.data)

# 每次迭代都得记得清空

weights.grad.data.zero_()

biases.grad.data.zero_()

weights2.grad.data.zero_()

biases2.grad.data.zero_()

randn(4*128)表示将输入的14个特征转化为128个隐层的特征。

输出结果为:

loss: tensor(5093.8568, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

loss: tensor(28.5000, dtype=torch.float64, grad_fn=<MeanBackward0>)

5、更简单的网络模型

input_size = input_features.shape[1]

hidden_size = 128

output_size = 1

batch_size = 16#通过Squential将网络层和激活函数结合起来,输出激活后的网络节点

my_nn = torch.nn.Sequential(

#指定好输入输出

torch.nn.Linear(input_size, hidden_size),

torch.nn.Sigmoid(),

torch.nn.Linear(hidden_size, output_size),

)

#计算损失函数

cost = torch.nn.MSELoss(reduction='mean')

#优化器, 用做好的,会动态调整

optimizer = torch.optim.Adam(my_nn.parameters(), lr = 0.001)

#训练网络

losses = []

for i inrange(1000):

batch_loss = []

#MINI-Batch方法来进行训练for start inrange(0, len(input_features), batch_size):

end = start + batch_size if start + batch_size < len(input_features) elselen(input_features)

#取了部分数据

xx = torch.tensor(input_features[start:end], dtype = torch.float, requires_grad = True)

yy = torch.tensor(labels[start:end], dtype = torch.float, requires_grad = True)

prediction = my_nn(xx)

loss = cost(prediction, yy)

#优化,梯度清零,反响传播,更新参数

optimizer.zero_grad()

loss.backward(retain_graph=True)

optimizer.step()

batch_loss.append(loss.data.numpy())

# 打印损失if i % 100 == 0:

losses.append(np.mean(batch_loss))

print(i, np.mean(batch_loss))

输出结果为:

0 28.514753

100 28.50165

200 28.500153

300 28.500011

400 28.5

500 28.499996

600 28.5

700 28.5

800 28.5

900 28.499996

训练结果

x = torch.tensor(input_features, dtype = torch.float)

predict = my_nn(x).data.numpy()

格式转化,为画图准备1

# 转换日期格式

dates = [str(int(year)) + '-' + str(int(month)) + '-' + str(int(day)) for year, month, day inzip(years, months, days)]

dates = [datetime.datetime.strptime(date, '%Y-%m-%d') for date in dates]

# 创建一个表格来存日期和其对应的标签数值

true_data = pd.DataFrame(data = {'date': dates, 'actual': labels})

# 同理,再创建一个来存日期和其对应的模型预测值

months = features[:, feature_list.index('month')]

days = features[:, feature_list.index('day')]

years = features[:, feature_list.index('year')]

test_dates = [str(int(year)) + '-' + str(int(month)) + '-' + str(int(day)) for year, month, day inzip(years, months, days)]

test_dates = [datetime.datetime.strptime(date, '%Y-%m-%d') for date in test_dates]

predictions_data = pd.DataFrame(data = {'date': test_dates, 'prediction': predict.reshape(-1)})

画图

# 真实值

plt.plot(true_data['date'], true_data['actual'], 'b-', label = 'actual')

# 预测值

plt.plot(predictions_data['date'], predictions_data['prediction'], 'ro', label = 'prediction')

plt.xticks(rotation = '60');

plt.legend()

# 图名

plt.xlabel('Date'); plt.ylabel('Maximum Temperature (F)'); plt.title('Actual and Predicted Values');

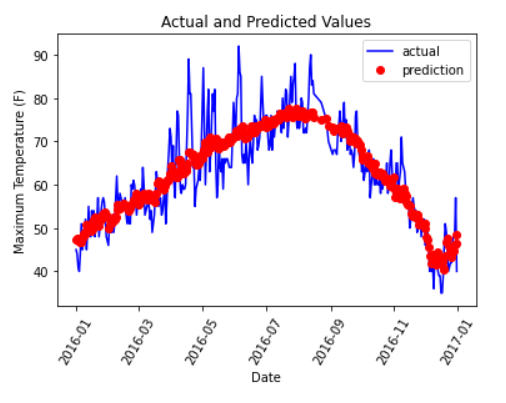

输出的结果为:

可以看出预测值与真实值还是比较拟合的。

版权归原作者 小0p 所有, 如有侵权,请联系我们删除。