本文目录

写在前面

配置前须知

- 请用root用户登录虚拟机,以保证有充分的操作权限

- 可以使用第三方终端来连接虚拟机,这样会让我们配置的效率更高

- 有良好的心态来应对可能出现的意料之外的问题,有问题可以留言或私信,博主将会第一时间回复

- 在中途配置的过程中,尽量不要重启虚拟机,以免配置失效,如果重启,可能需要重新配置/etc/下的文件

- 配置过程中的主机名等请自行修改为自己的个人所需信息

第三方终端可以使用Windows自带的cmd,也可以使用之前博主推荐过的Tabby,详见往期博客

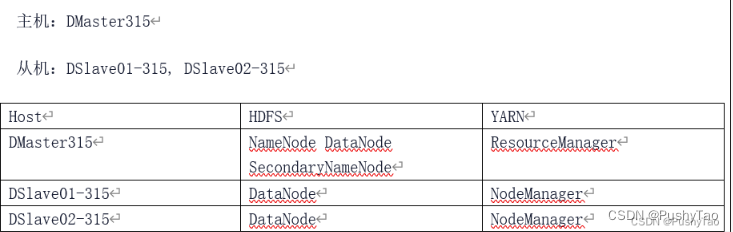

集群规划

一主两从

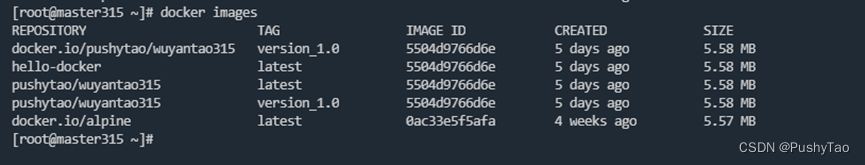

step1 开启docker拉取镜像

Docker 镜像查看:

docker images

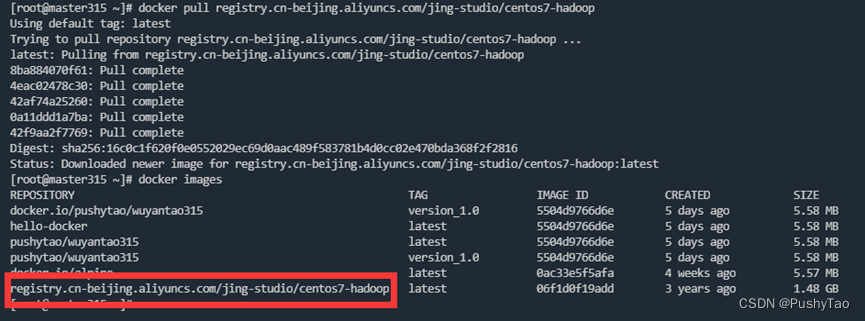

拉取镜像:

docker pull registry.cn-beijing.aliyuncs.com/jing-studio/centos7-hadoop

进行中:

结束:

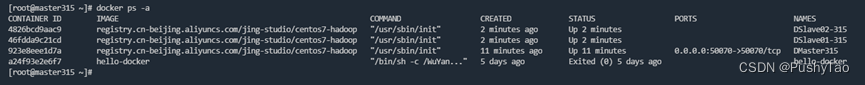

step2 创建容器

DMaster315:

docker run -d --name DMaster315 -h DMaster315 \

-p 50070:50070 --privileged=true \

registry.cn-beijing.aliyuncs.com/jing-studio/centos7-hadoop /usr/sbin/init

DSlave01-315 && DSlave02-315:

docker run -d --name DSlave01-315 -h DSlave01-315 \

--privileged=true \

registry.cn-beijing.aliyuncs.com/jing-studio/centos7-hadoop /usr/sbin/init

docker run -d --name DSlave02-315 -h DSlave02-315 \

--privileged=true \

registry.cn-beijing.aliyuncs.com/jing-studio/centos7-hadoop /usr/sbin/init

docker images

查看:

step3 免密登录配置

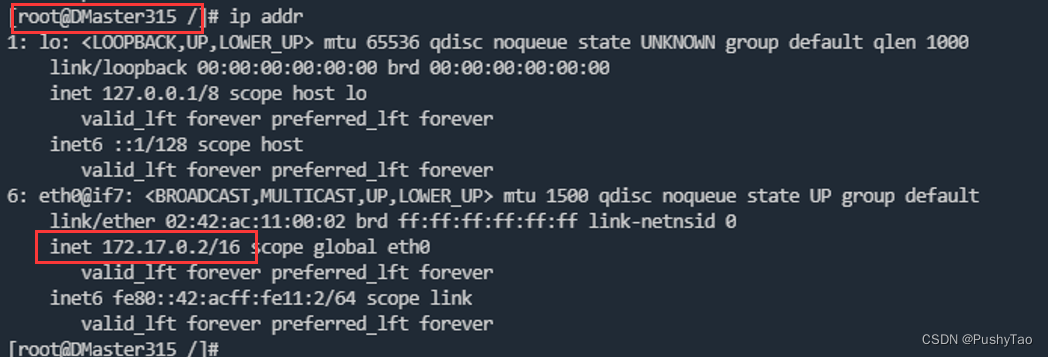

1. ip查看

如果此时你下载了第三方终端,建议开启三个标签页同时连接虚拟机,并使得三个标签页分别进入docker的三个机器:一个进入DMaster,一个进入DSlave01,另一个进入DSlave02

请先确认容器已经开启(

docker ps

查看所有已经开启的容器),如果未开启,请用命令

docker ps -a

查看想要开启的容器的id,然后用命令

docker start 容器id

来开启

命令:

进入DMaster315,并进入该机器的命令行终端

dockerexec -it DMaster315 /bin/bash

进入DSlave01-315,并进入该机器的命令行终端

dockerexec -it DSlave01-315 /bin/bash

进入DSlave02-315,并进入该机器的命令行终端

dockerexec -it DSlave02-315 /bin/bash

进入容器查看IP:

命令是:

ip addr

172.17.0.2/16 DMaster315

172.17.0.3/16 DSlave01-315

172.17.0.4/16 DSlave02-315

整理一下:

172.17.0.2 DMaster315

172.17.0.3 DSlave01-315

172.17.0.4 DSlave02-315

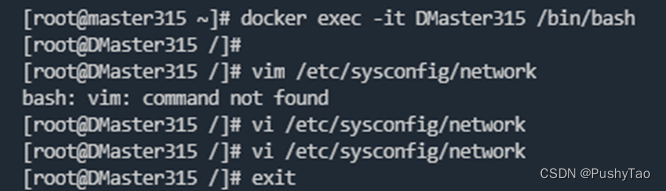

2. 设置主机名

DMaster315

vi /etc/sysconfig/network

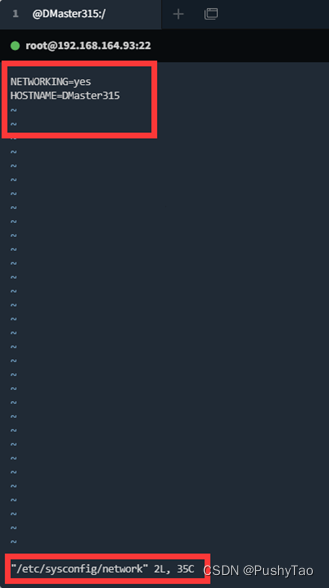

需要写入:

NETWORKING=yes

HOSTNAME=DMaster315

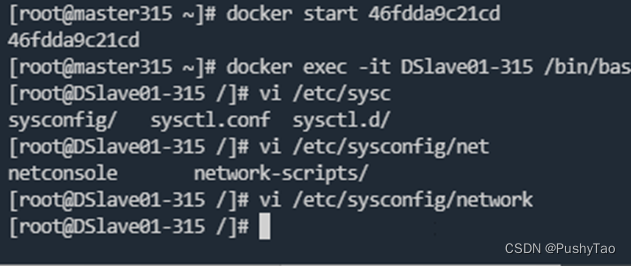

DSlave01-315

vi /etc/sysconfig/network

需要写入:

NETWORKING=yes

HOSTNAME=DSlave01-315

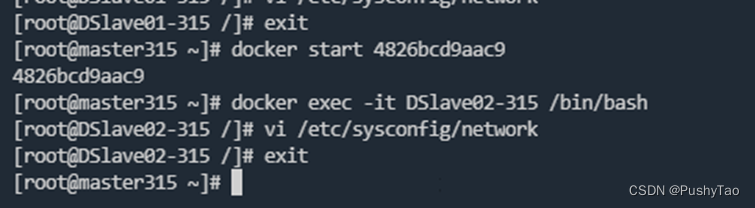

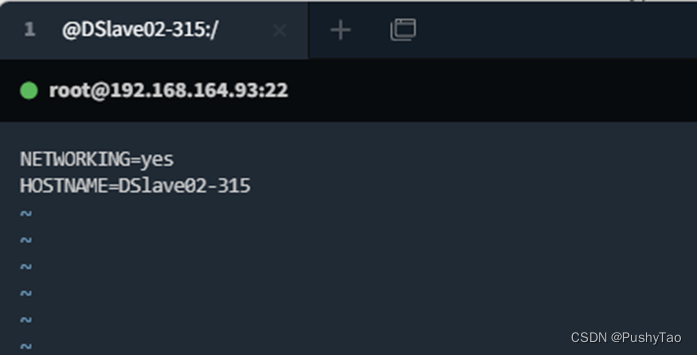

DSlave02-315:

vi /etc/sysconfig/network

需要写入:

NETWORKING=yes

HOSTNAME=DSlave02-315

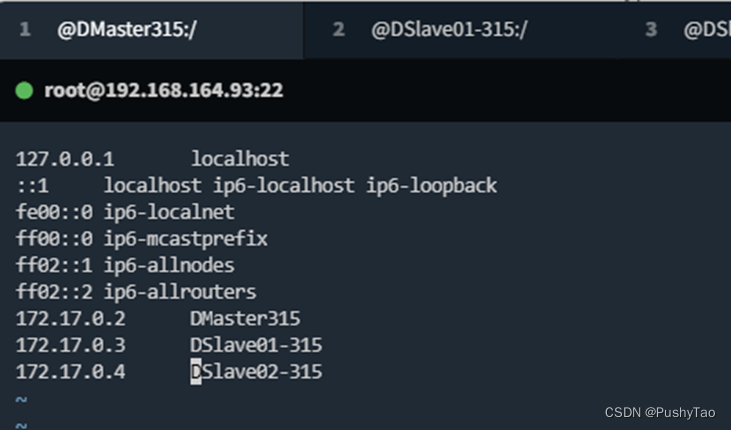

3. 主机名与ip地址映射

在三个机器上操作

修改

/etc/hosts

使得三个机器该文件都有以下三行:

172.17.0.2 DMaster315

172.17.0.3 DSlave01-315

172.17.0.4 DSlave02-315

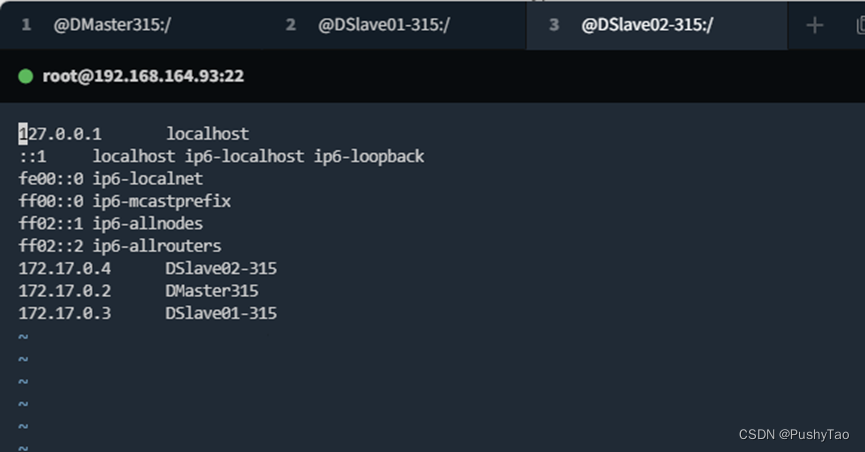

DMaster315:

DSlave01-315:

DSlave02-315:

开启多个标签页分别进入三个机器配置效率真的的很高

4. 免密登录

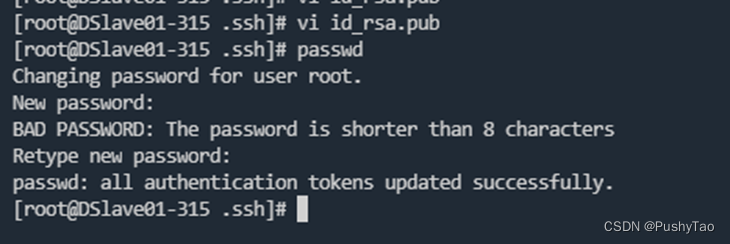

安装

passwd

yum install passwd

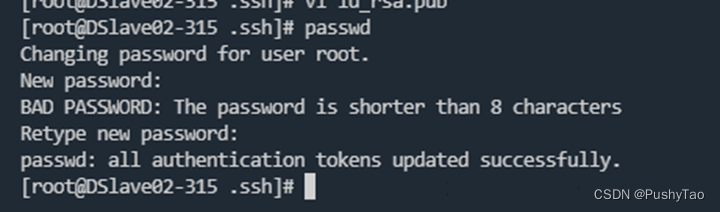

修改root密码,需要两次输入相同密码

DMaster315修改密码: DSlave01-315:

DSlave01-315: DSlave02-315:

DSlave02-315:

查看各个机器

~/.ssh

下是否有密钥文件(

id_rsa.pub

文件)

如果没有需要自己生成,已经有的话,查看三个机器的密钥文件是否相同

- 如果相同的话,只需要在三个机器分别连接其他机器

- 如果不相同的话,参考本人博客进行配置 查看

authorized_keys中是否包含有三个机器的id_rsa.pub - 如果有,便不用追加进入

authorized_keys - 如果没有,需要将文件追加进入

authorized_keys如果和博主一样三个机器均已经含有id_rsa.pub文件,并且authorized_keys文件中已经含有三个机器的id_rsa.pub文件,可以不必进行任何修改

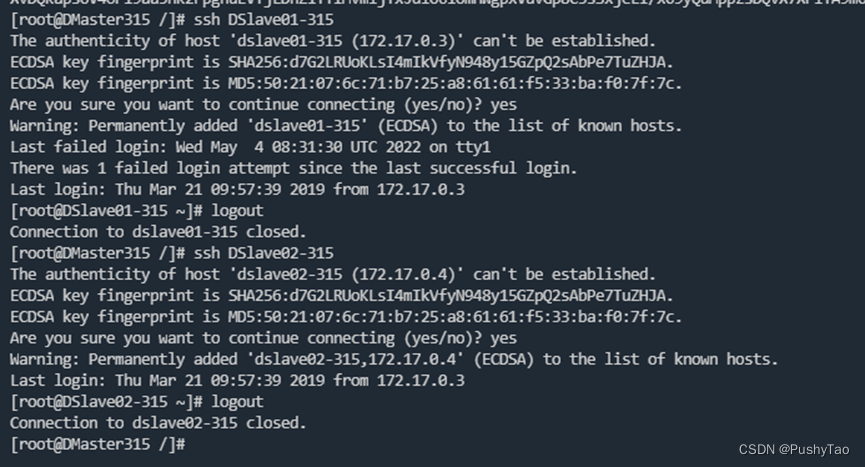

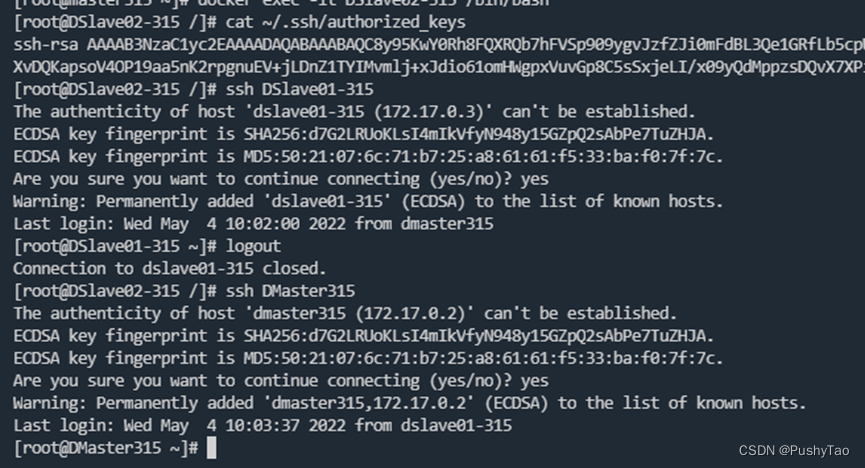

5. 免密登录效果

DMaster315 ssh 其他机器

DSlave01-315 ssh 其他机器: DSlave02-315 ssh 其他机器:

DSlave02-315 ssh 其他机器:

免密登陆成功

***bug fix1.0 /etc/hosts修改完成后重启容器失效

在配置完/etc/hosts之后,由于一些原因就关闭了虚拟机,再次打开之后发现免密登录失效

查看之后得知,在每次重启之后,/etc/hosts就会重置,因为运行容器是以挂载的方式进行的,所以就会在下次登陆的时候失效:

可以参考博客

解决方式:

要在三个机器的

/etc/hosts

中都含有ip和主机名的映射

在三个机器的

~/.bashrc

中分别添加:

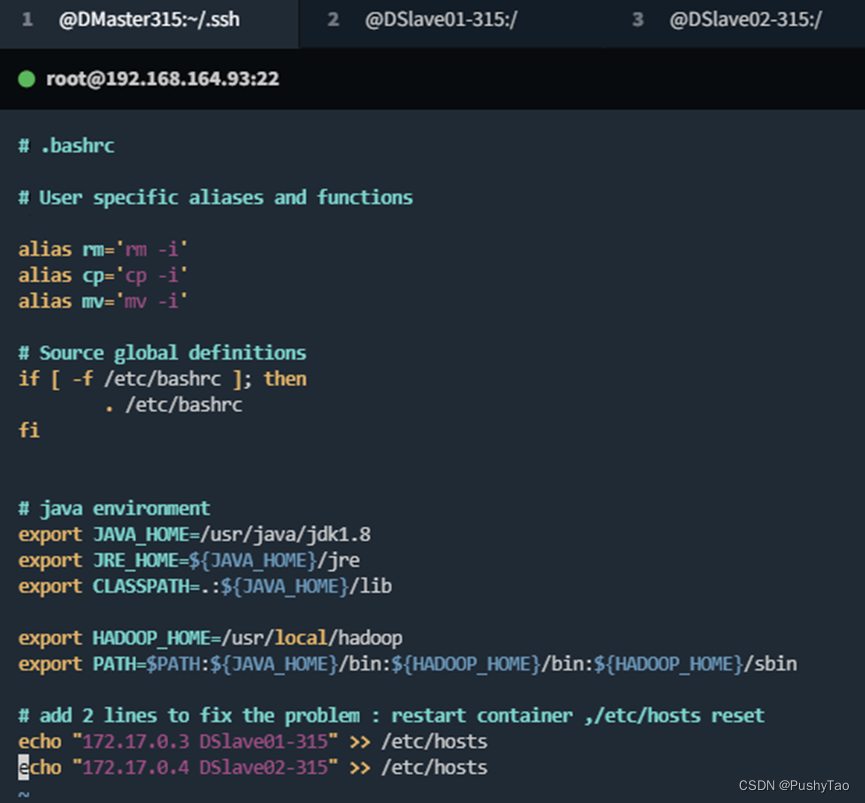

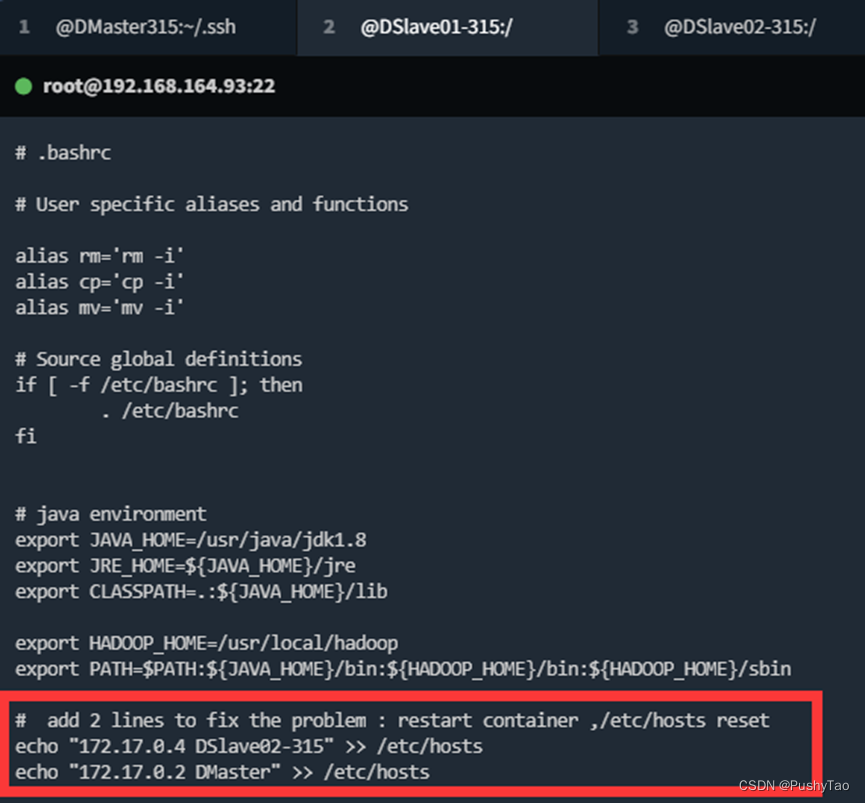

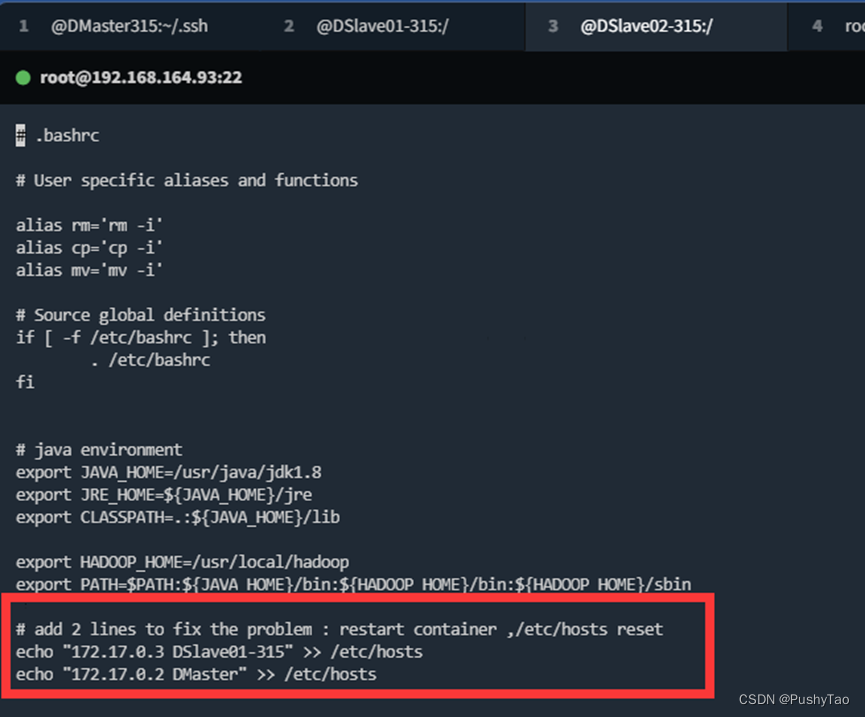

为了方便复制:

是>>追加写,切勿少了一个大于号

# add 2 lines to fix the problem : restart container ,/etc/hosts resetecho"172.17.0.3 DSlave01-315">> /etc/hosts

echo"172.17.0.4 DSlave02-315">> /etc/hosts

echo"172.17.0.2 DMaster">> /etc/hosts

Dmaster315:

DSlave01-315:

DSlave02-315:

然后必须要

source ~/.bashrc

,必须在三个机器上均进行source操作

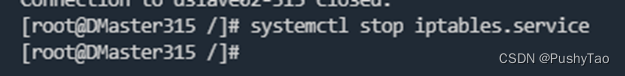

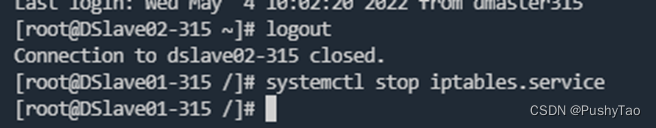

step4 关闭防火墙

命令是

systemctl stop iptables.service

在三个机器都需要进行操作:

DMaster315:

DSlave01-315: DSlave02-315:

DSlave02-315:

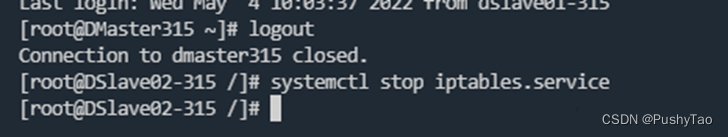

step5 hadoop配置文件修改

在DMaster315操作:

cd /usr/local/hadoop/etc/hadoop

1. core-site.xml

vim core-site<Tab>

配置文件中的主机名端口等根据自己实际情况修改,切勿盲目CV

property标签对要放在configuration标签对中

<configuration><property><name>fs.defaultFS</name><value>hdfs://DMaster315:9000</value></property><property><name>hadoop.tmp.dir</name><value>/home/data/hadoopdata</value></property></configuration>

创建目录

mkdir -p /home/data

mkdir -p /home/data/hadoopdata

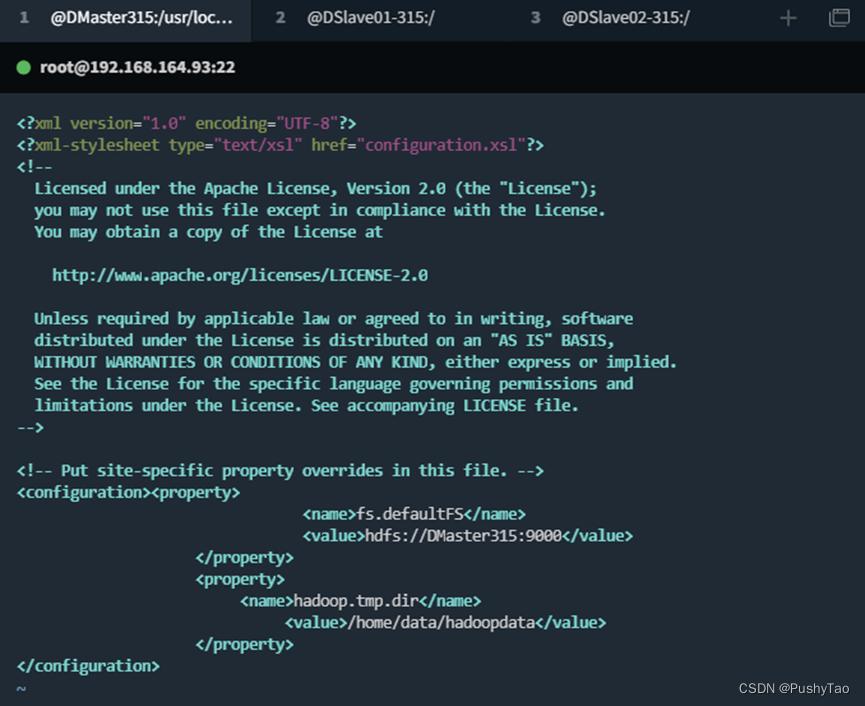

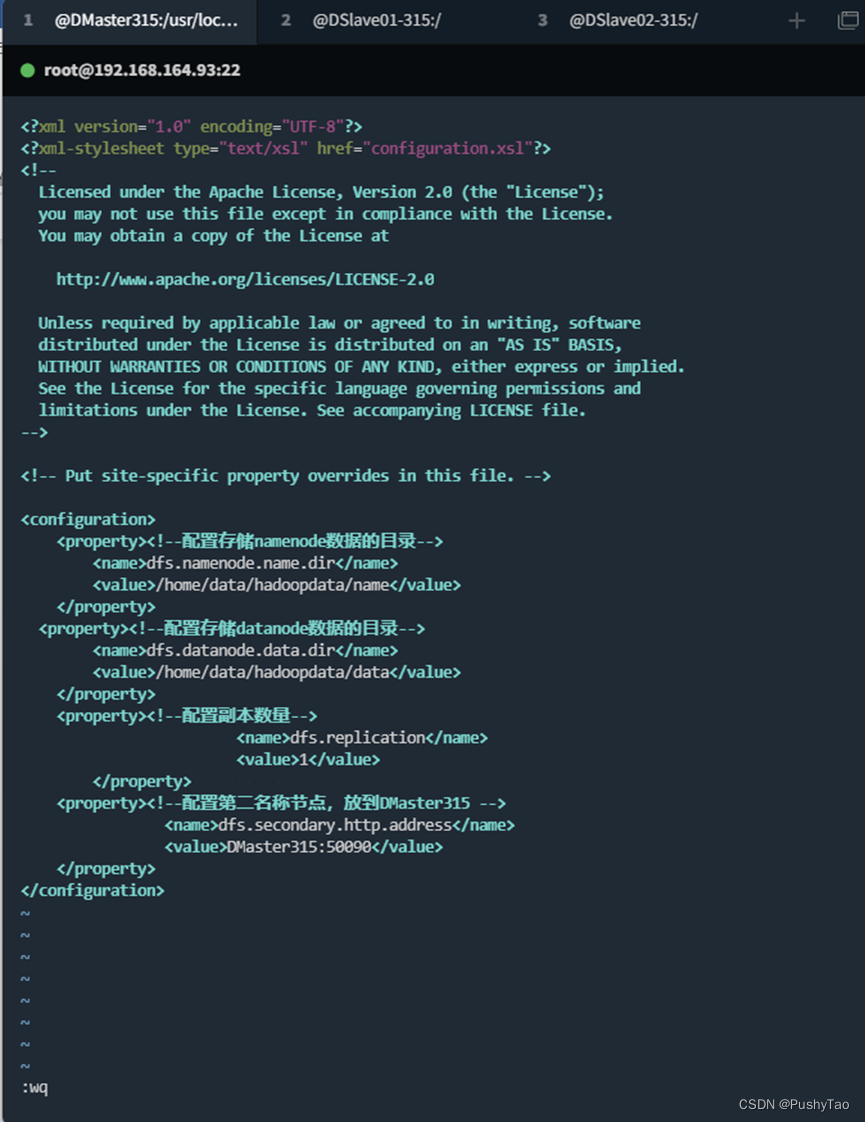

2. hdfs-site.xml

配置文件中的主机名端口等根据自己实际情况修改,切勿盲目CV

property标签对要放在configuration标签对中

<configuration><property><!--配置存储namenode数据的目录--><name>dfs.namenode.name.dir</name><value>/home/data/hadoopdata/name</value></property><property><!--配置存储datanode数据的目录--><name>dfs.datanode.data.dir</name><value>/home/data/hadoopdata/data</value></property><property><!--配置副本数量--><name>dfs.replication</name><value>1</value></property><property><!--配置第二名称节点,放到DMaster315 --><name>dfs.secondary.http.address</name><value>DMaster315:50090</value></property></configuration>

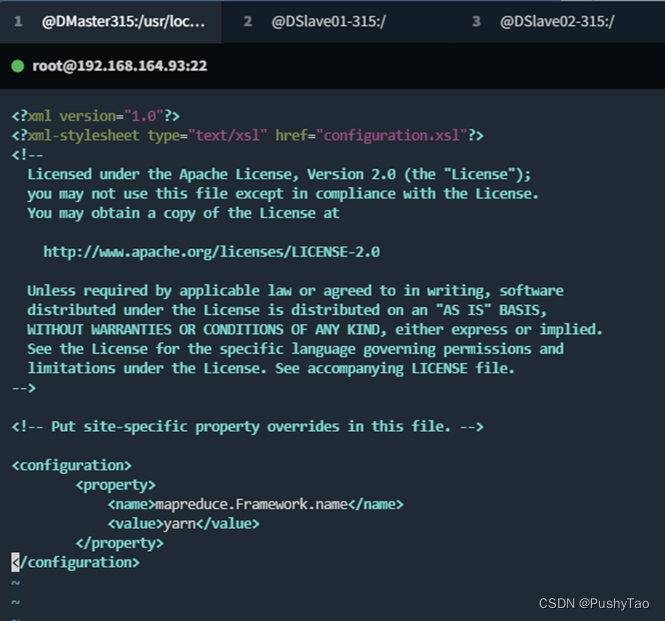

3. mapred-site.xml:

配置文件中的主机名端口等根据自己实际情况修改,切勿盲目CV

property标签对要放在configuration标签对中

首先运行命令:

cp mapred-site.xml.template mapred-site.xml

然后

vim mapred-site.xml

<configuration><property><name>mapreduce.Framework.name</name><value>yarn</value></property></configuration>

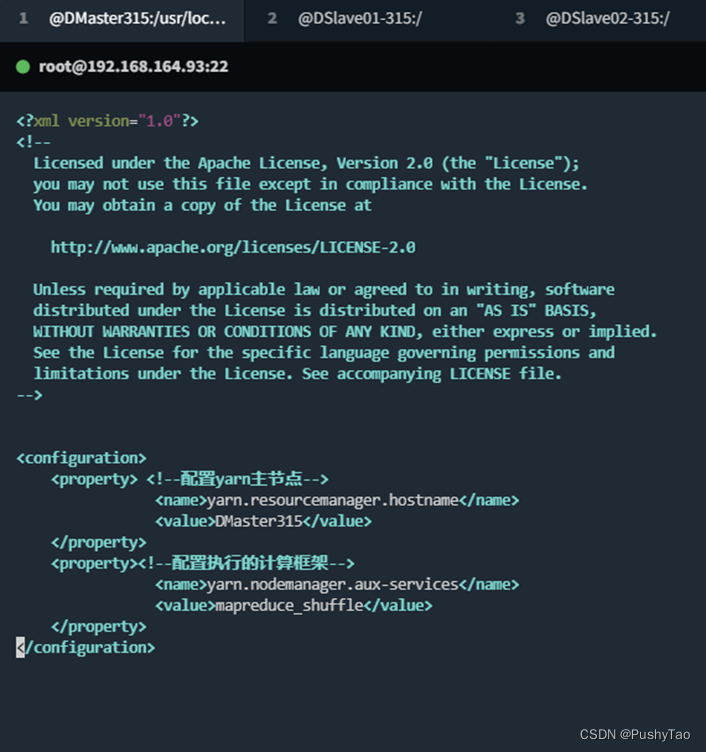

4. yarn-site.xml

配置文件中的主机名端口等根据自己实际情况修改,切勿盲目CV

property标签对要放在configuration标签对中

<configuration><property><!--配置yarn主节点--><name>yarn.resourcemanager.hostname</name><value>DMaster315</value></property><property><!--配置执行的计算框架--><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property></configuration>

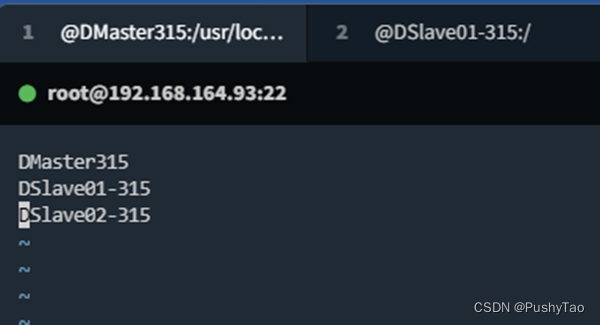

5. slaves

配置文件中的主机名端口等根据自己实际情况修改,切勿盲目CV

property标签对要放在configuration标签对中

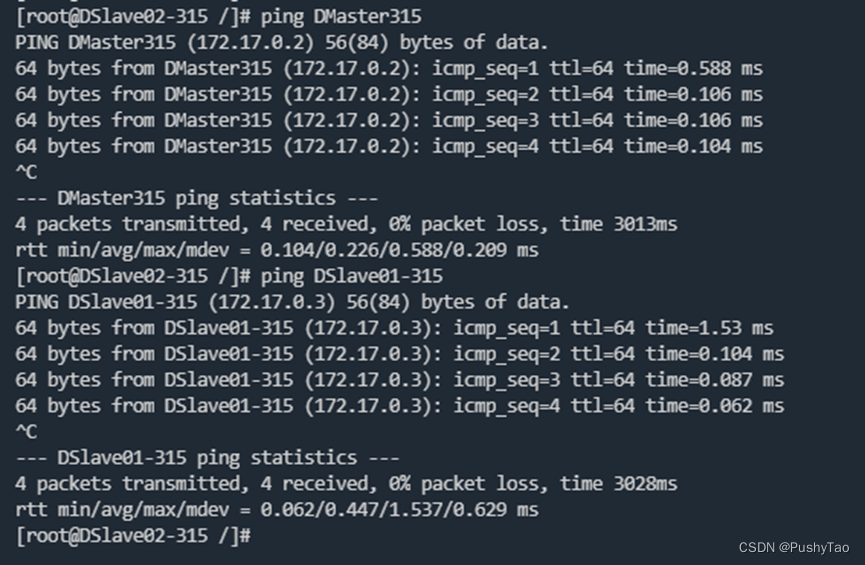

6. 测试互联互通

Dmaster ping dslave01-315 dslave02-315:

Dslave01-315 ping dmaster315 dslave02-315:

DSlave02-315 ping DMaster315 DSlave01-315:

可以互联互通,接下来传送文件

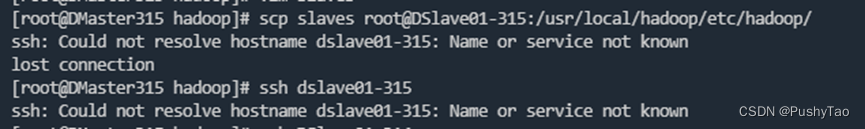

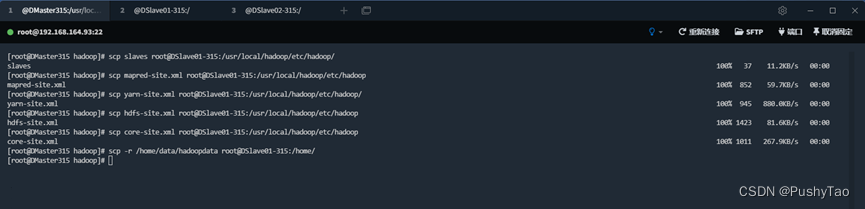

7. 传送到其他节点

切换到对应的目录:

cd /usr/local/hadoop/etc/hadoop

命令:

传送到DSlave01-315

scp slaves root@DSlave01-315:/usr/local/hadoop/etc/hadoop/

scp mapred-site.xml root@DSlave01-315:/usr/local/hadoop/etc/hadoop

scp yarn-site.xml root@DSlave01-315:/usr/local/hadoop/etc/hadoop/

scp hdfs-site.xml root@DSlave01-315:/usr/local/hadoop/etc/hadoop

scp core-site.xml root@DSlave01-315:/usr/local/hadoop/etc/hadoop

scp -r /home/data/hadoopdata root@DSlave01-315:/home/

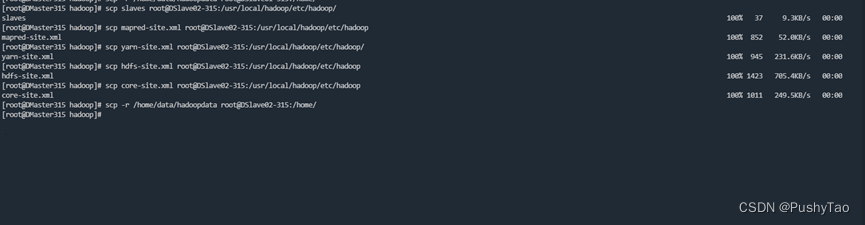

传送到DSlave02-315

scp slaves root@DSlave02-315:/usr/local/hadoop/etc/hadoop/

scp mapred-site.xml root@DSlave02-315:/usr/local/hadoop/etc/hadoop

scp yarn-site.xml root@DSlave02-315:/usr/local/hadoop/etc/hadoop/

scp hdfs-site.xml root@DSlave02-315:/usr/local/hadoop/etc/hadoop

scp core-site.xml root@DSlave02-315:/usr/local/hadoop/etc/hadoop

scp -r /home/data/hadoopdata root@DSlave02-315:/home/

传送给DSlave01-315:

传送给DSlave02-315:

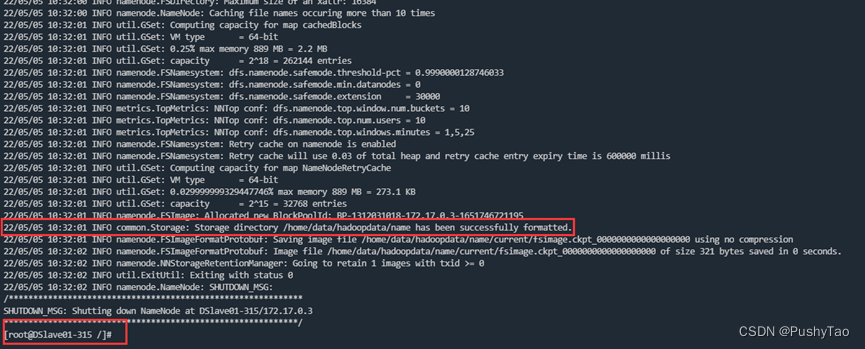

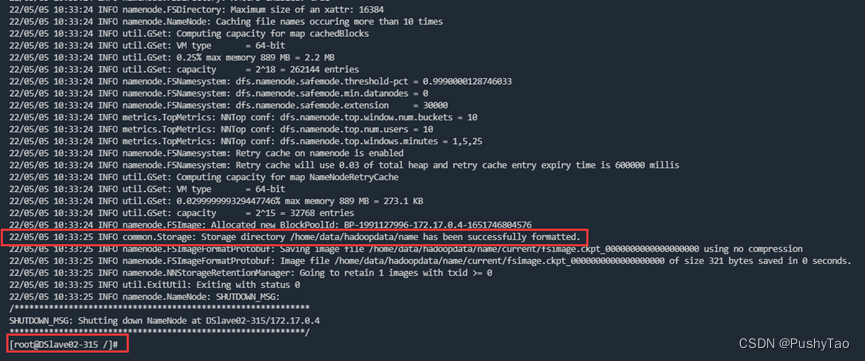

step6 格式化节点

在三台机器分别执行:

hadoop namenode -format

DMaster315:

DMaster315格式化成功: DSlave01-315 格式化成功:

DSlave01-315 格式化成功:

DSlave02-315 格式化成功:

step7 开启集群查看状态

开启集群

经典命令(应该记住的):

/usr/local/hadoop/sbin/start-all.sh

现在切换到Dmaster315开启集群:

在中途输入了一个yes,应该是首次没有确认的原因

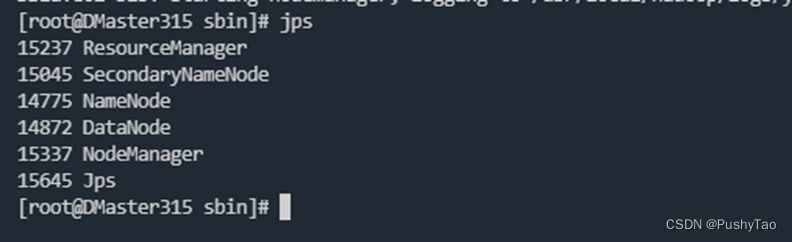

Jps信息查看:

DMaster315: DSlave01-315:

DSlave01-315: DSlave02-315:

DSlave02-315:

与预期设计一致~

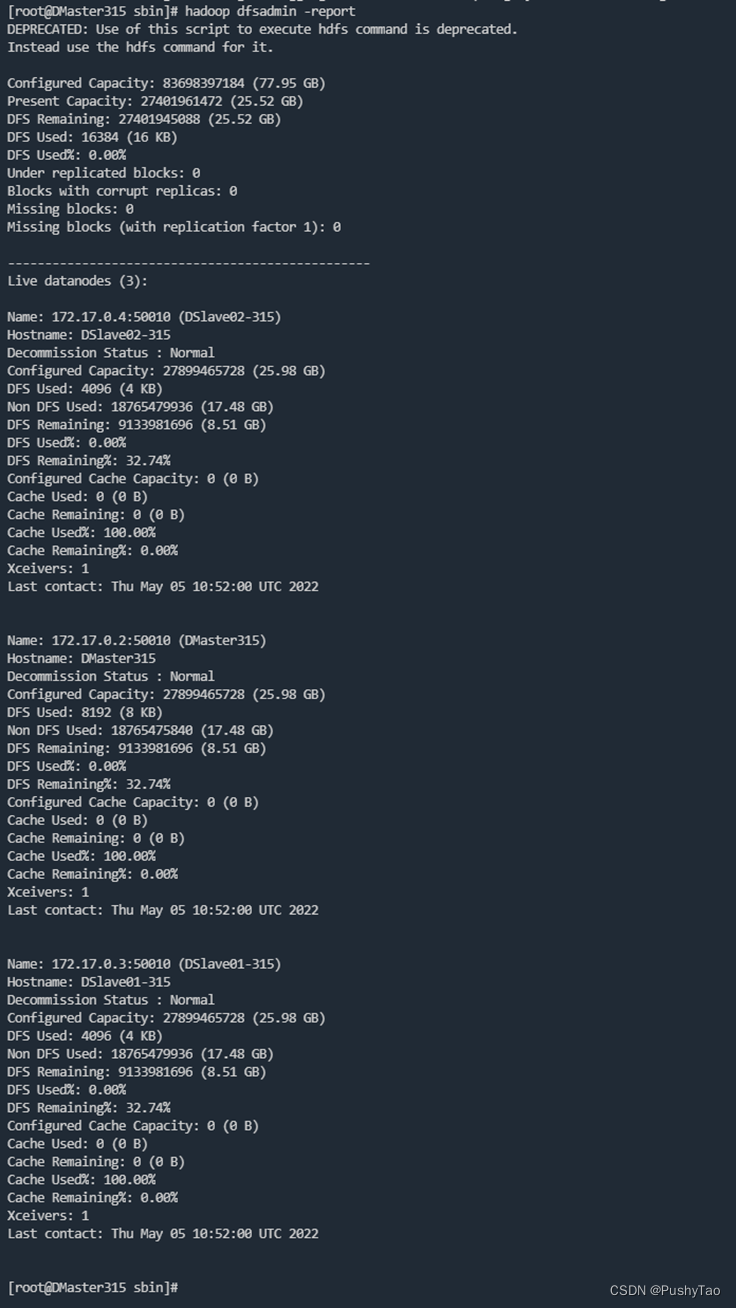

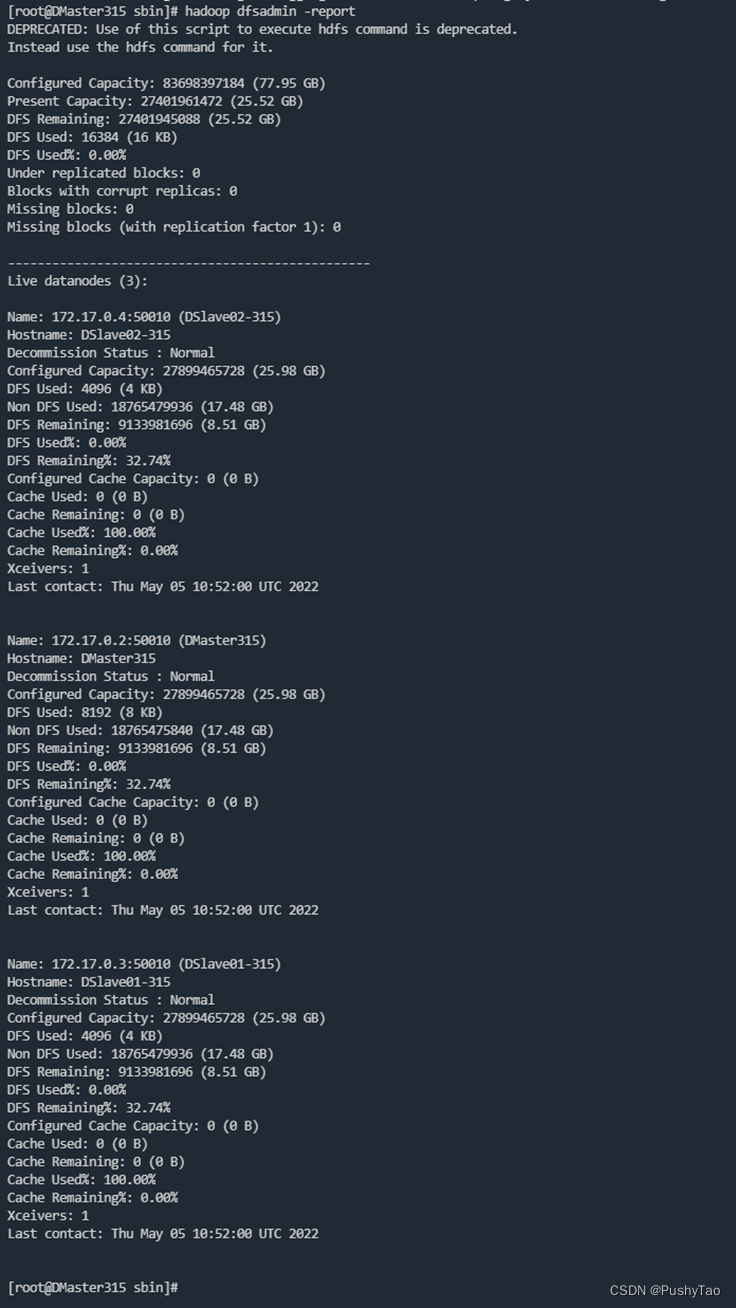

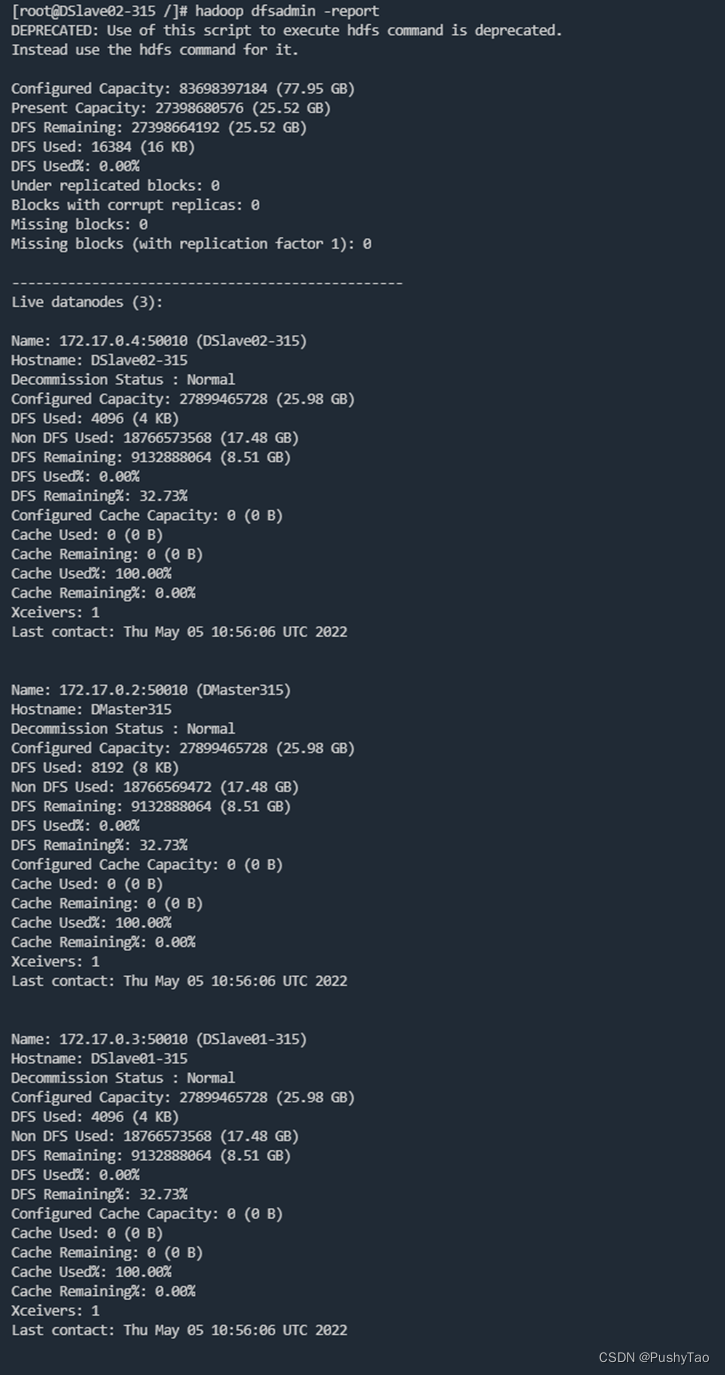

查看运行状况

hadoop dfsadmin -report

datanode三个节点全有,配置齐全~

到DSlave01-315查看:

datanode三个节点全有,配置齐全~

到DSlave02-315查看:

datanode三个节点全有,配置齐全~

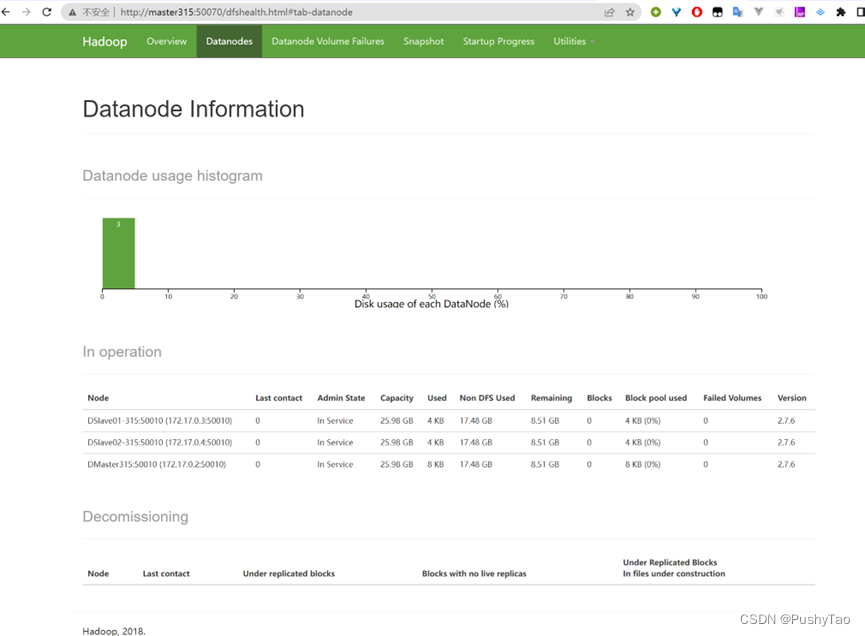

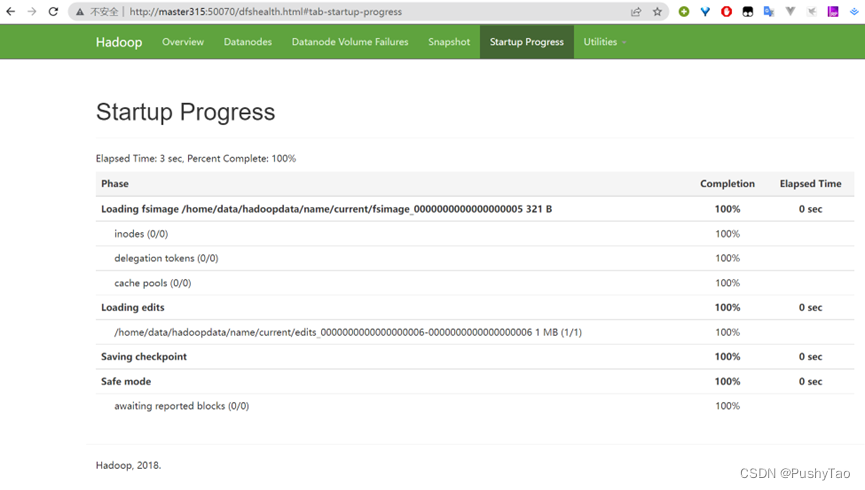

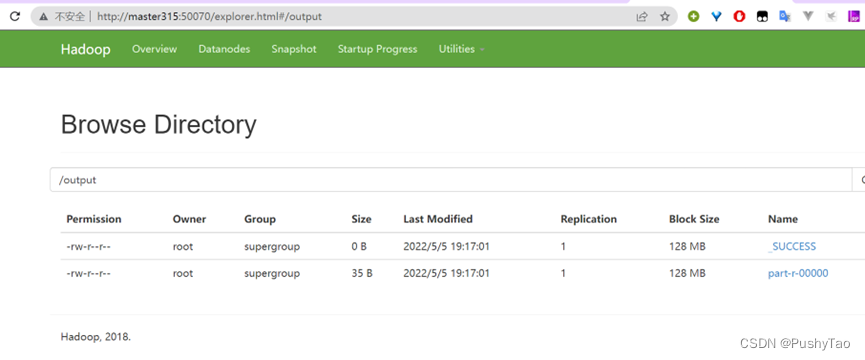

Web UI查看集群状态

进入虚拟机主机名的50070端口:

master315:50070

三个节点都有,配置齐全~

到这里,Docker上配置Hadoop集群配置完成,下面运行WordCount测试一下

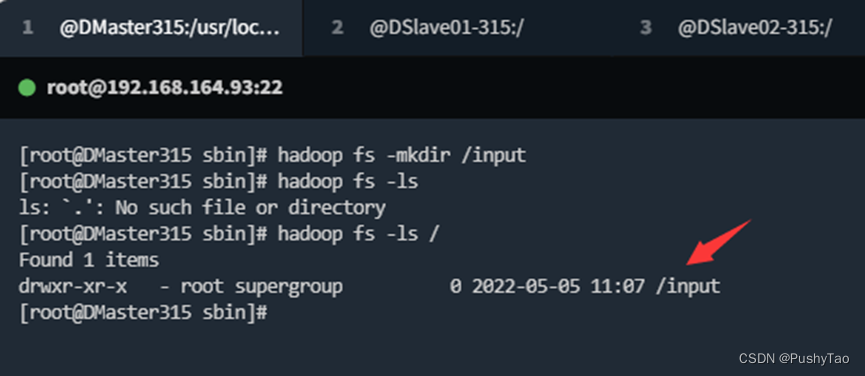

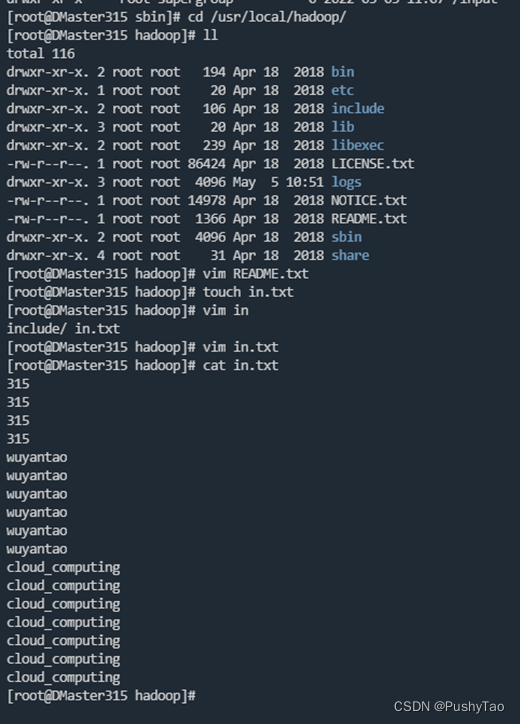

step8 运行wordCount

在DMaster315 运行:

hadoop fs -mkdir /input

hadoop fs -ls /

cd /usr/local/hadoop

touch in.txt

vim in.txt

写点东西进去

将

in.txt

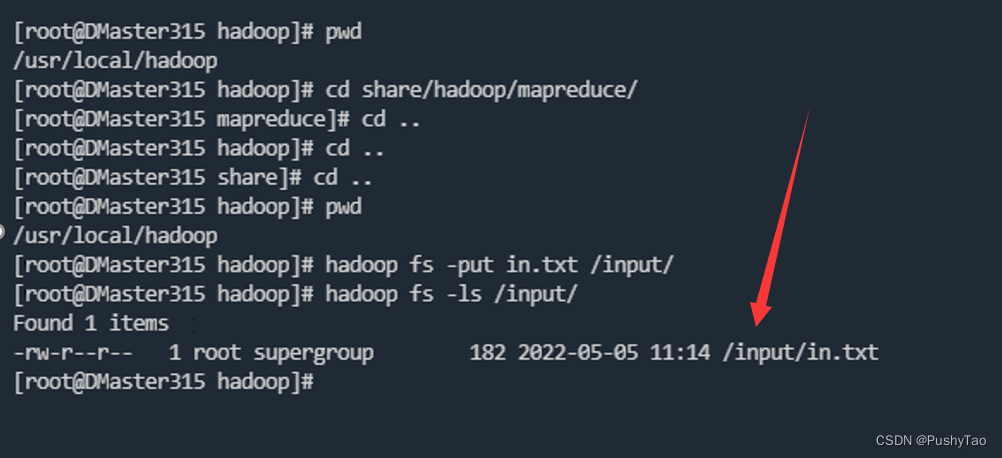

文件添加到hdfs /input/下:

hadoop fs -put in.txt /input/

提交:

注意切换到和博主同样的目录具体可见下图:

cd share/hadoop/mapreduce

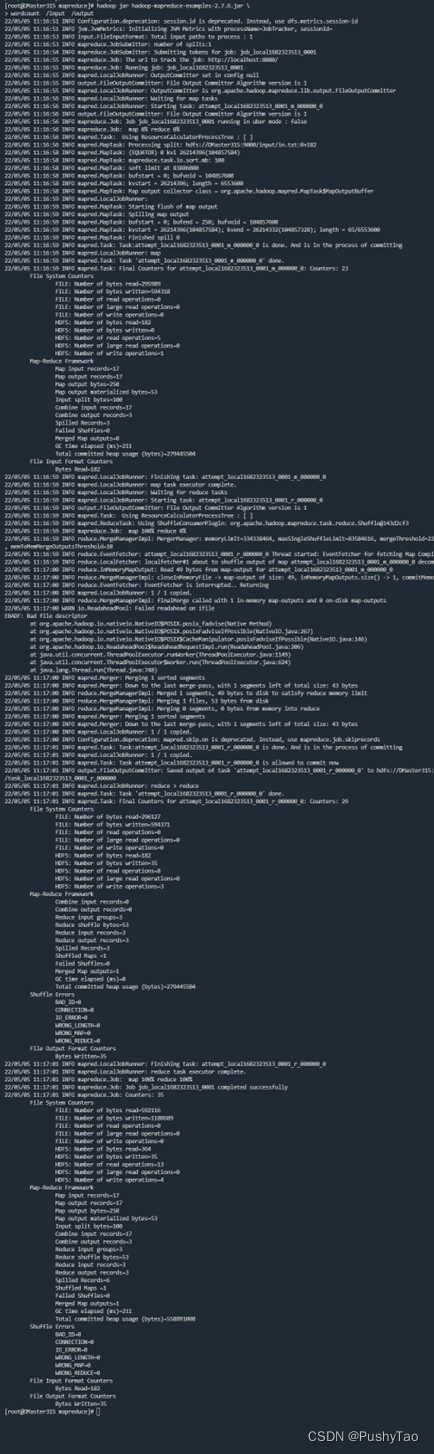

提交命令:

hadoop jar hadoop-mapreduce-examples-2.7.6.jar \

wordcount /input /output

提交之后:

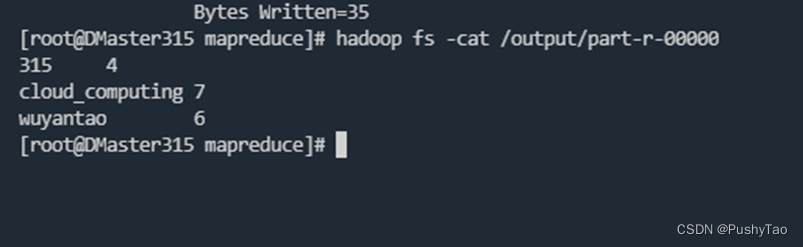

查看结果:

状态显示成功

命令查看:

hadoop fs -cat /output/part-r-00000

结果正确!

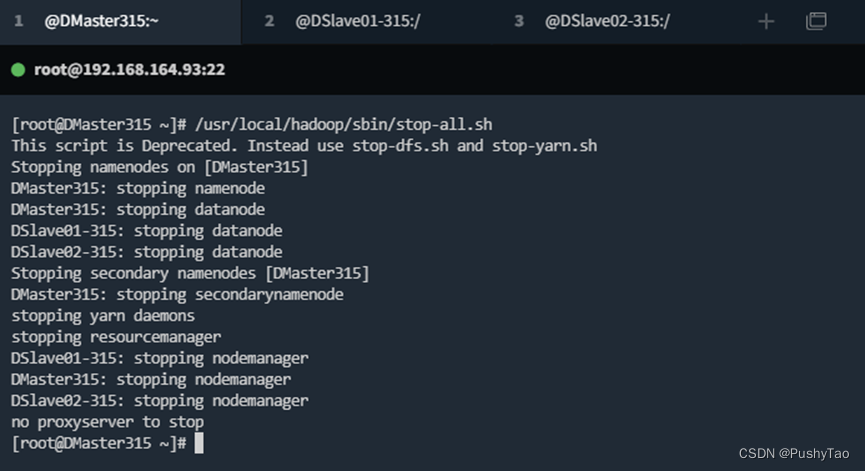

关闭集群

如果有的地方不对,请及时联系/评论/私信博主进行修改

更文不易,麻烦点个赞

版权归原作者 PushyTao 所有, 如有侵权,请联系我们删除。