摘要:本文将详细介绍 LainChain 的工作原理,以及如何通过结合 RAG(Retrieval-Aggregated Generation)技术来增强大型语言模型(如 GPT 和 ChatGPT 等)的性能。我们将探讨 COT、TOT、RAG 以及 LangChain 的概念,并通过一个简单的例子展示如何使用 HuggingGPT 工具来调用 OpenAI API。

一、引言

随着自然语言处理(NLP)领域的快速发展,大型语言模型如 GPT 和 ChatGPT 等已经成为了处理各种自然语言任务的强大工具。然而,这些模型在处理知识密集型任务时,仍然面临着一定的挑战。为了解决这些问题,研究者们提出了一种名为 LainChain 的方法,通过结合 RAG 技术来提升大型语言模型的能力。

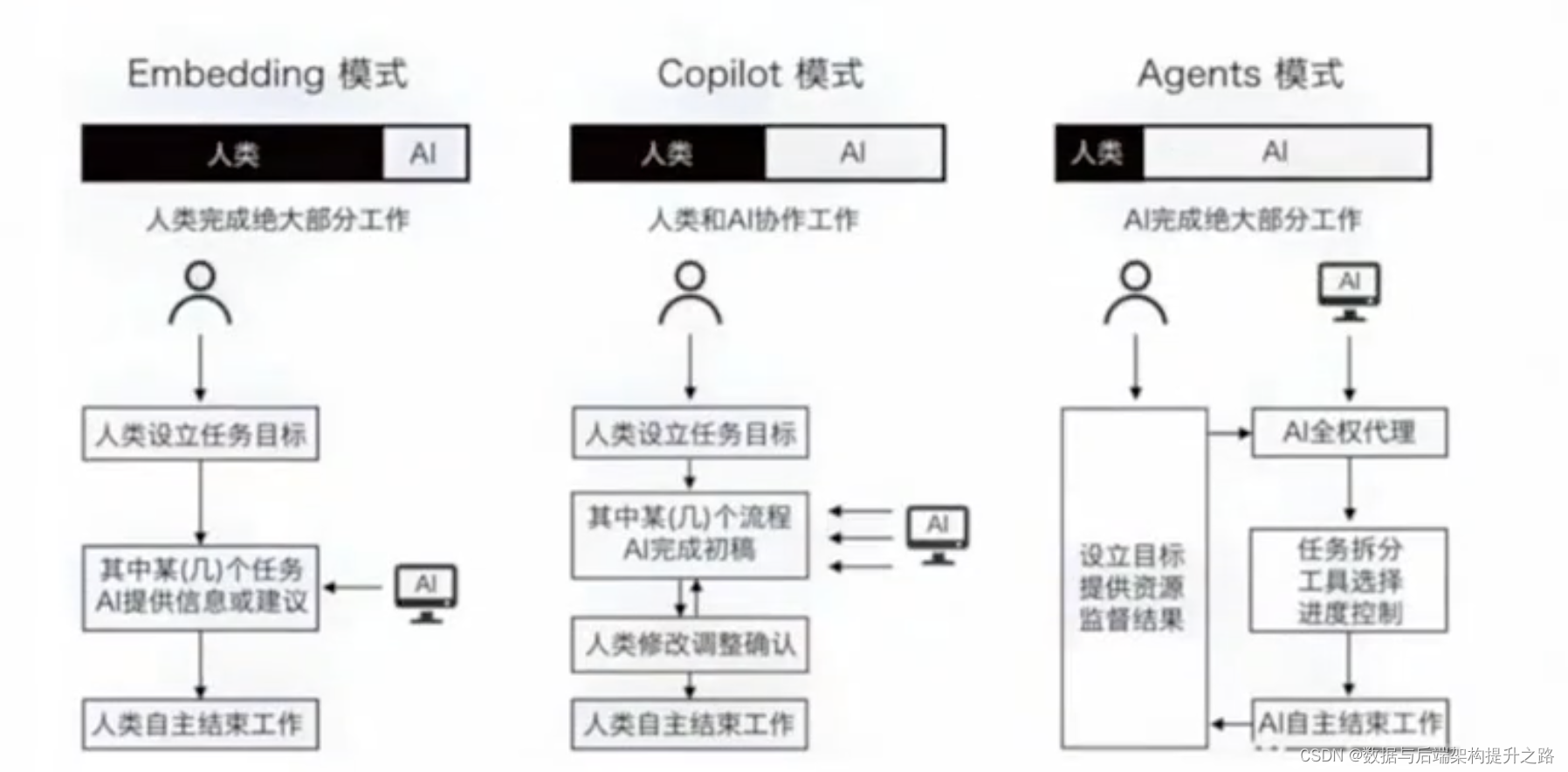

人类和AI协同的三种模式

二、背景知识

COT(Chain of Thought):这是一种解决复杂问题的方法,通过模拟人类思考的连续步骤来生成解答。在这种方法中,模型首先生成一系列解决问题的中间步骤或推理过程,然后再得出最终答案。

TOT(Tree of Thought):这是 COT 的一种扩展,不仅仅生成线性的思考链

版权归原作者 数据与后端架构提升之路 所有, 如有侵权,请联系我们删除。