1. 下载安装 ollama

Ollama 启动后在右下角的状态栏里面有

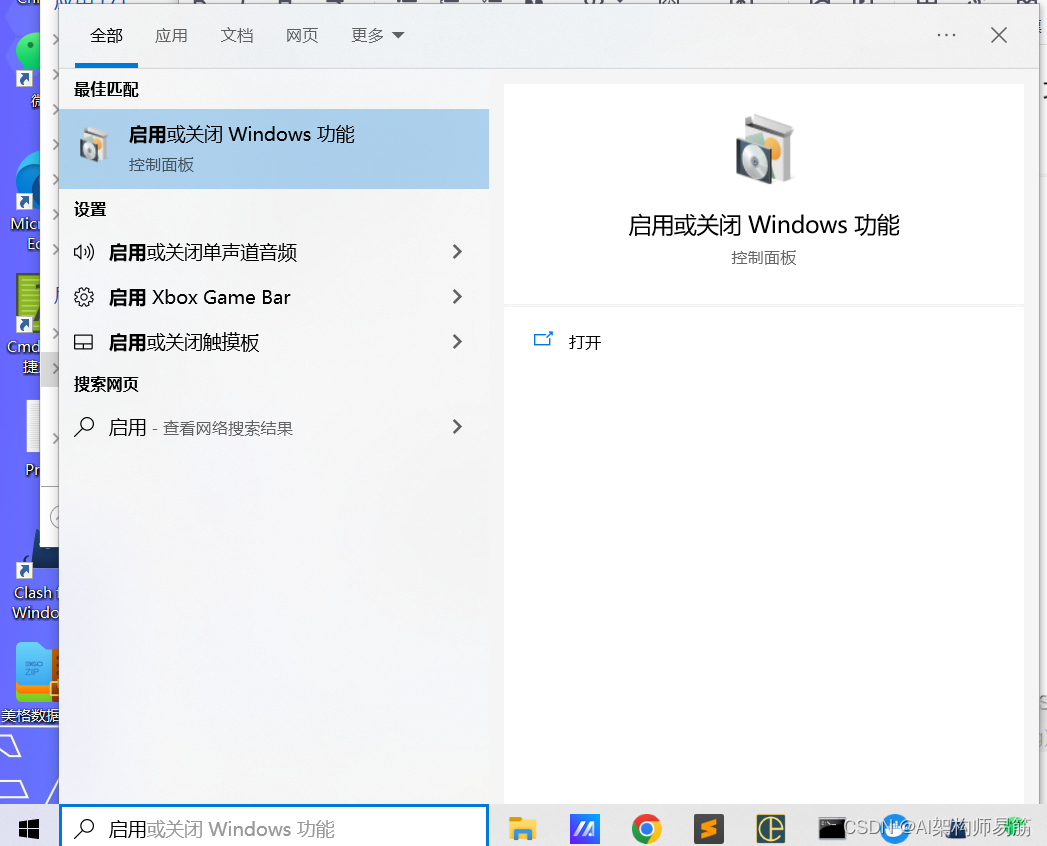

2. 左下角搜索框输入 启用或关闭 Windows 功能

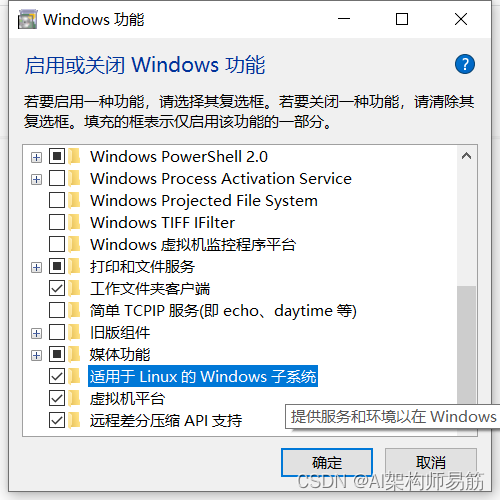

勾选 适用于Linux的Windows 子系统, 确定 并重启电脑。

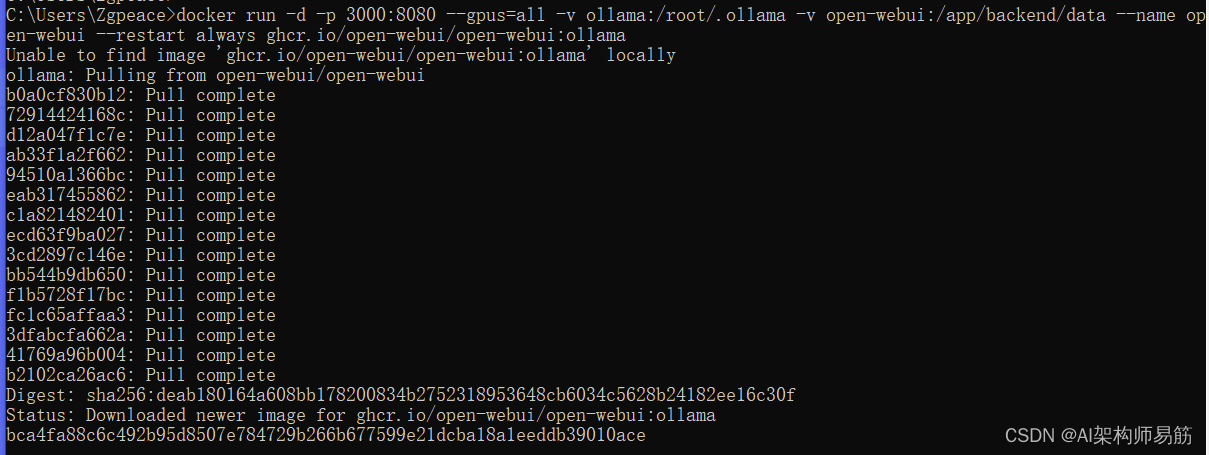

3. 安装 Open-WebUI执行命令

需要安装Docker

笔者笔记本有GPU所以用下面的命令

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data--name open-webui--restart always ghcr.io/open-webui/open-webui:ollama

CPU请用下面的命名

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data--name open-webui--restart always ghcr.io/open-webui/open-webui:main

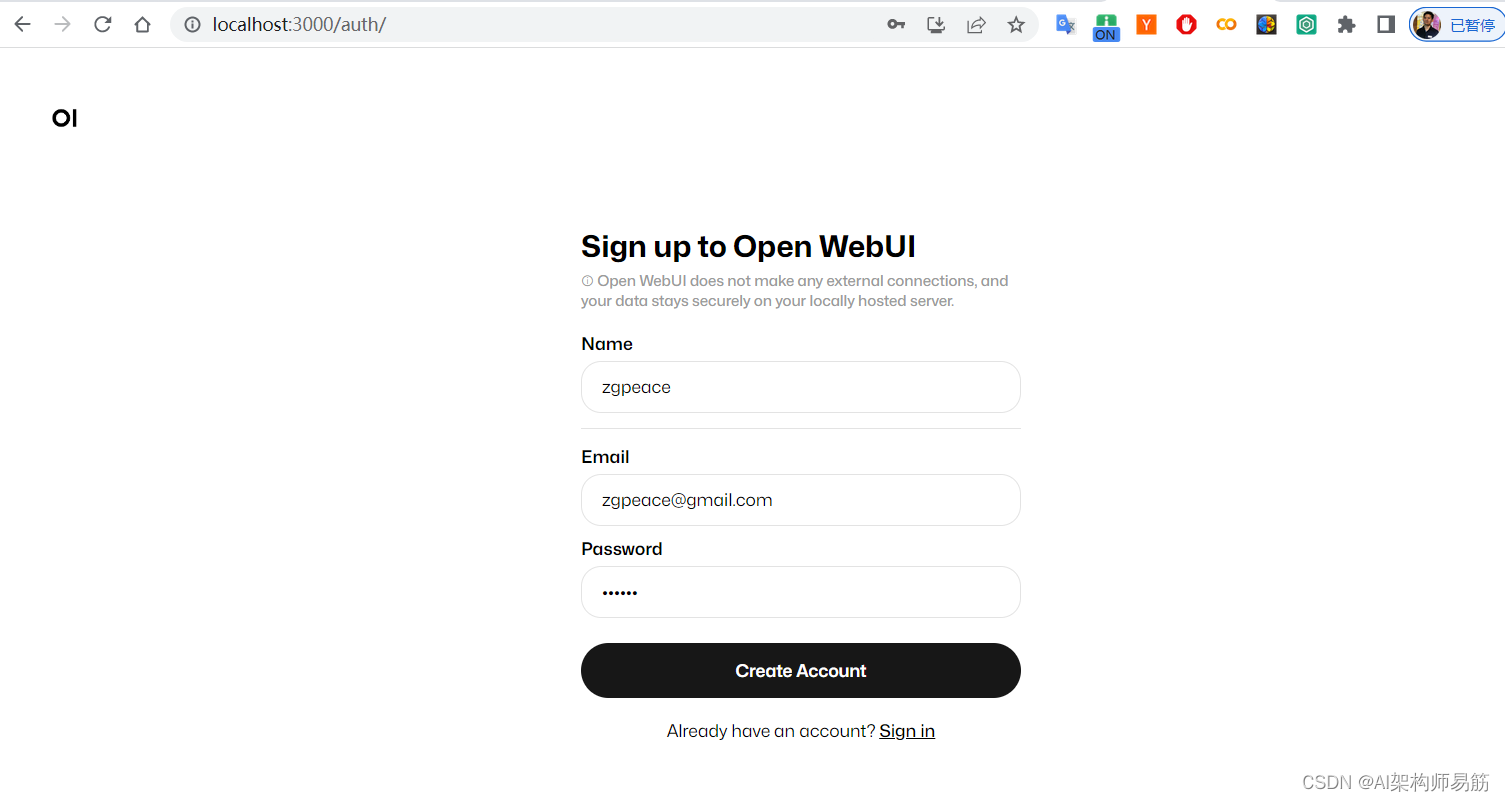

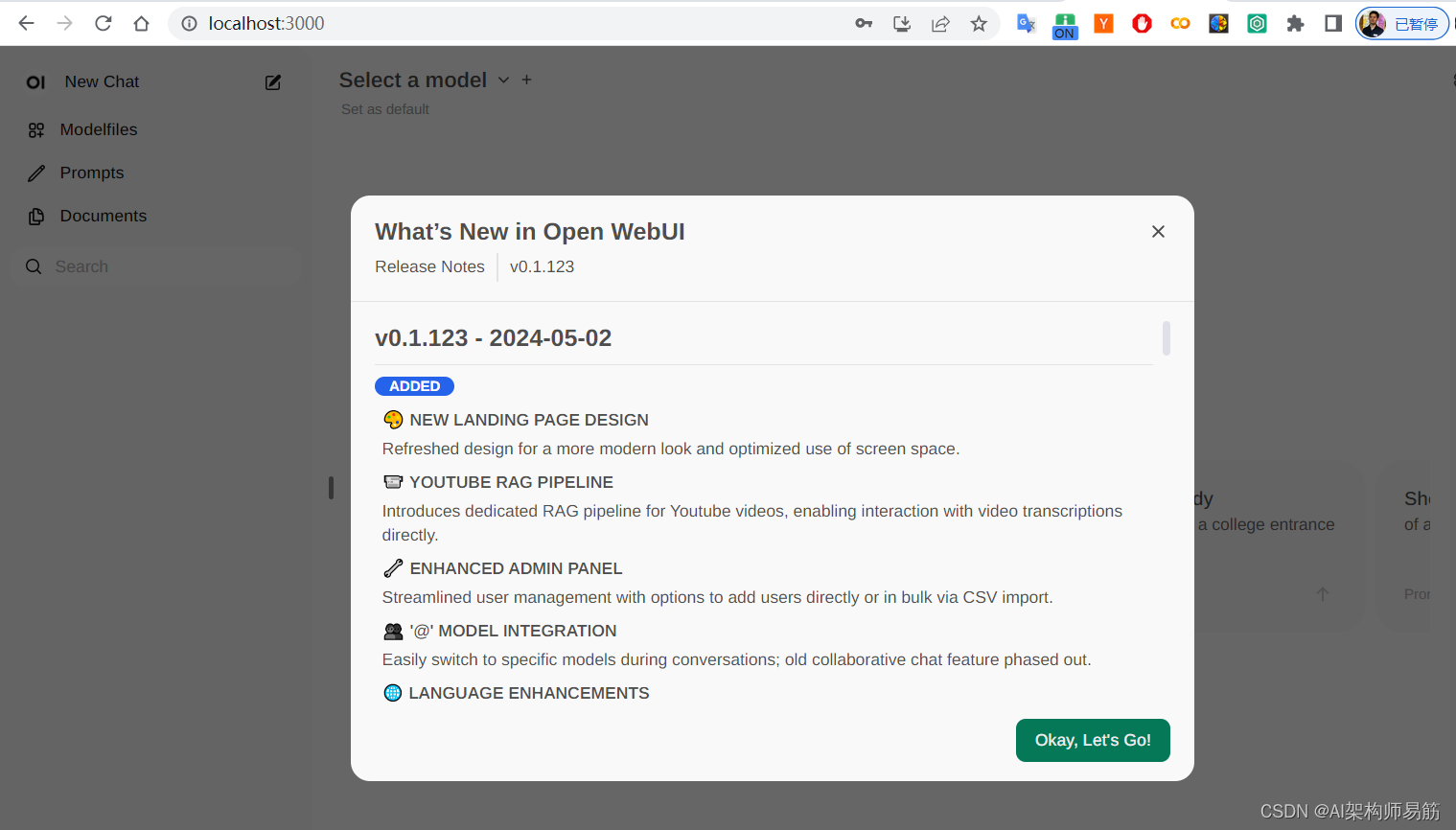

打开运行地址:

http://localhost:3000

先随便注册一个账户

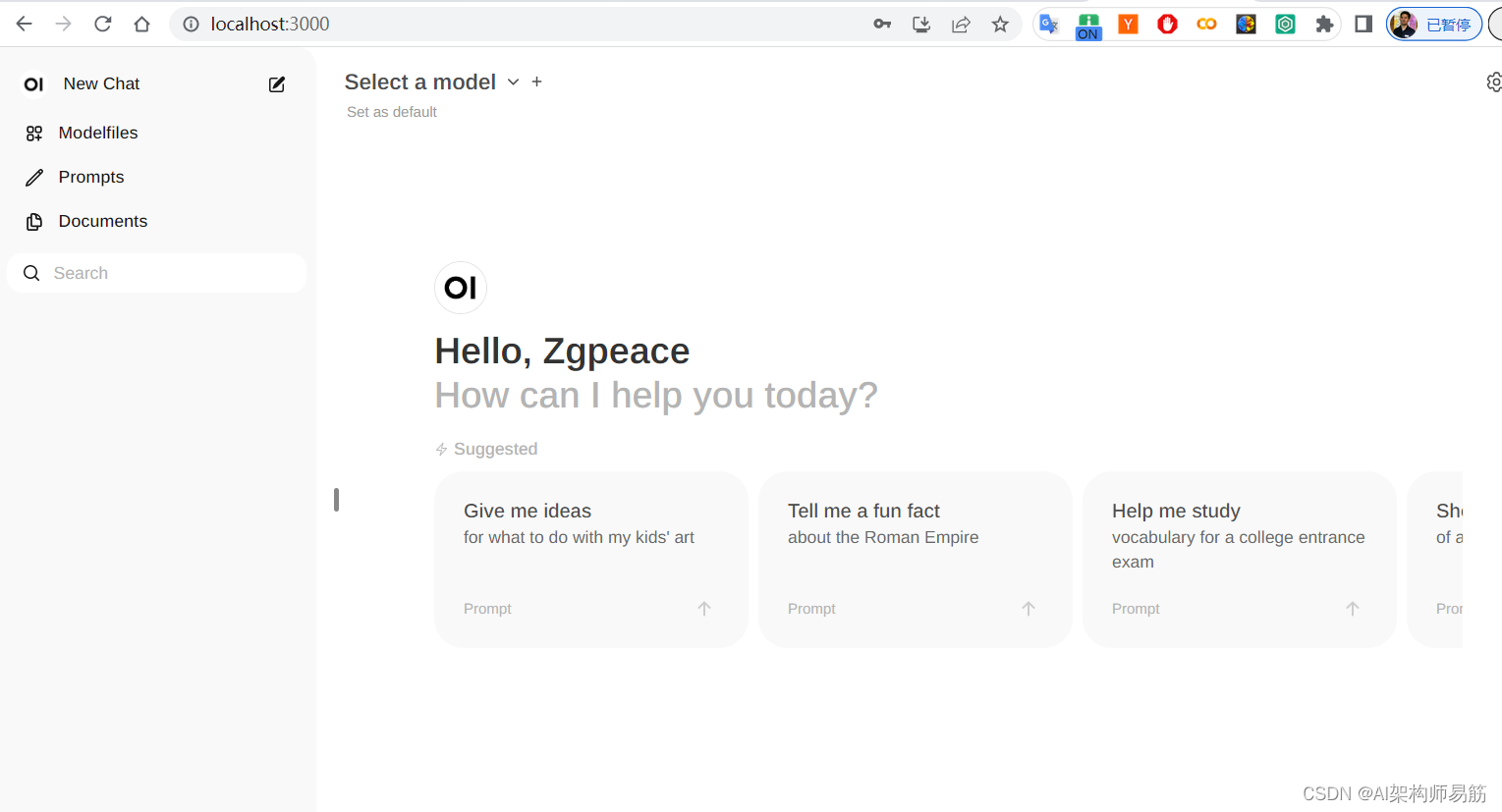

进入主页

目前还没有部署Model

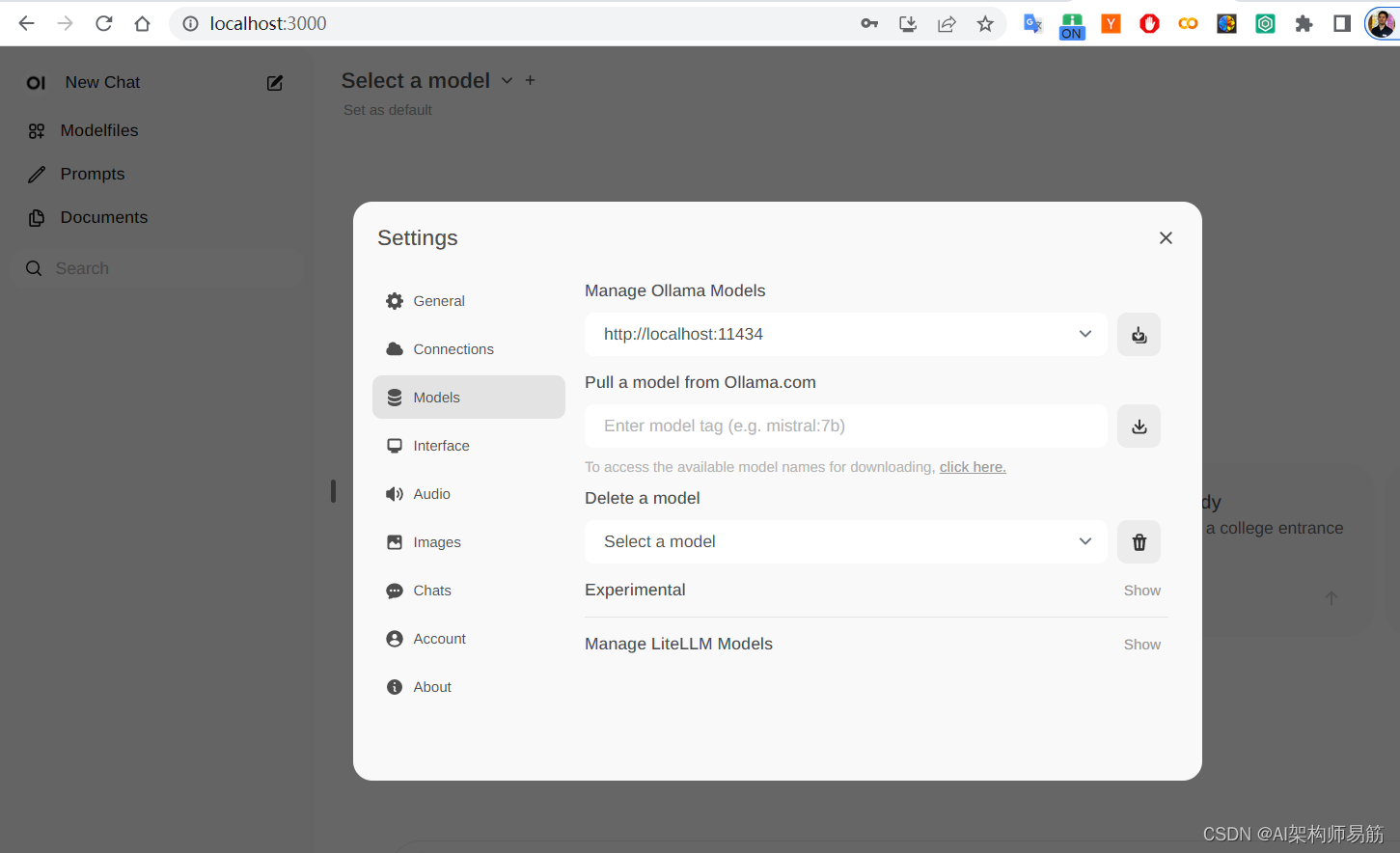

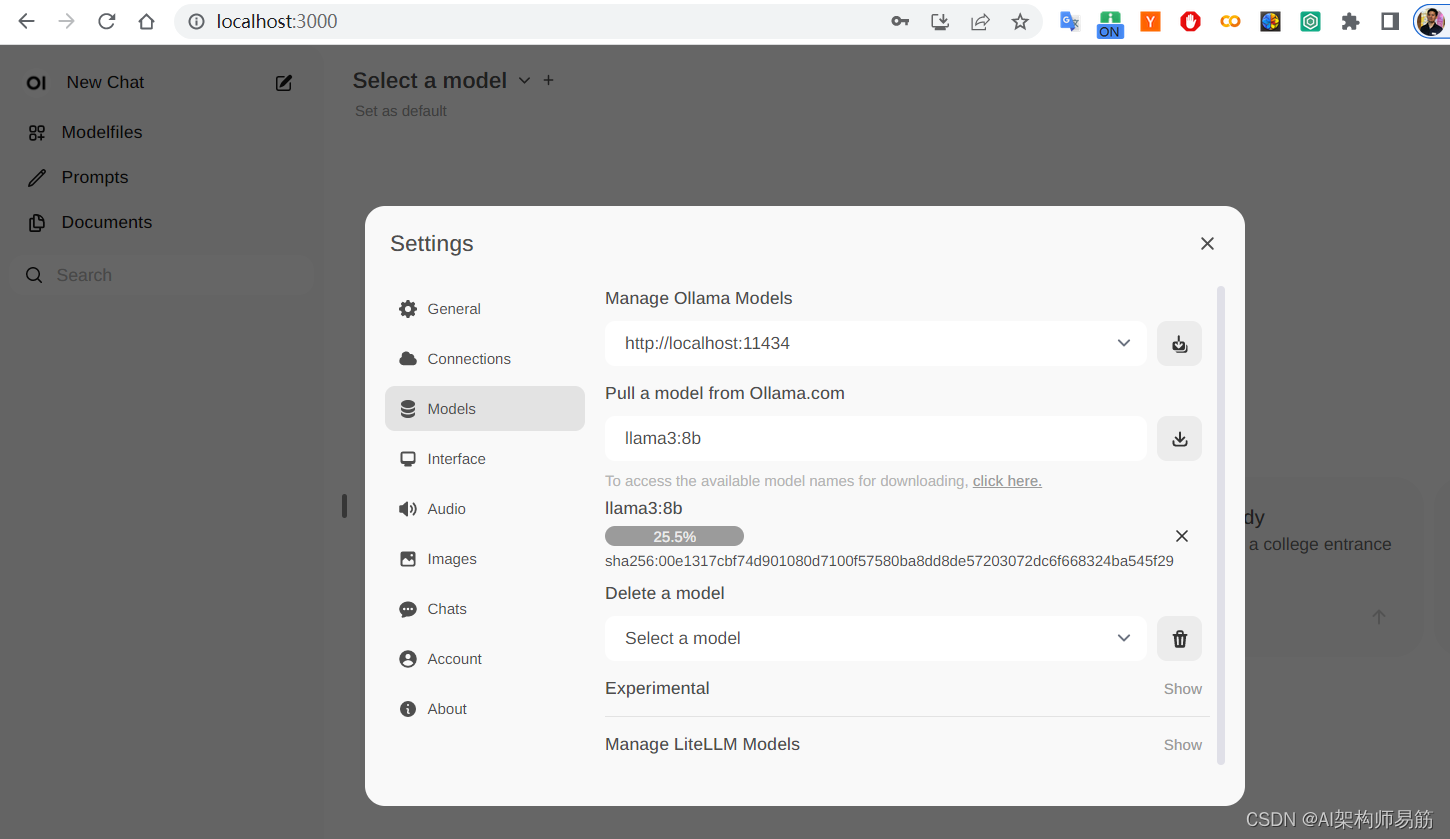

设置模型 Settings > Models > Pull a model from Ollama.com

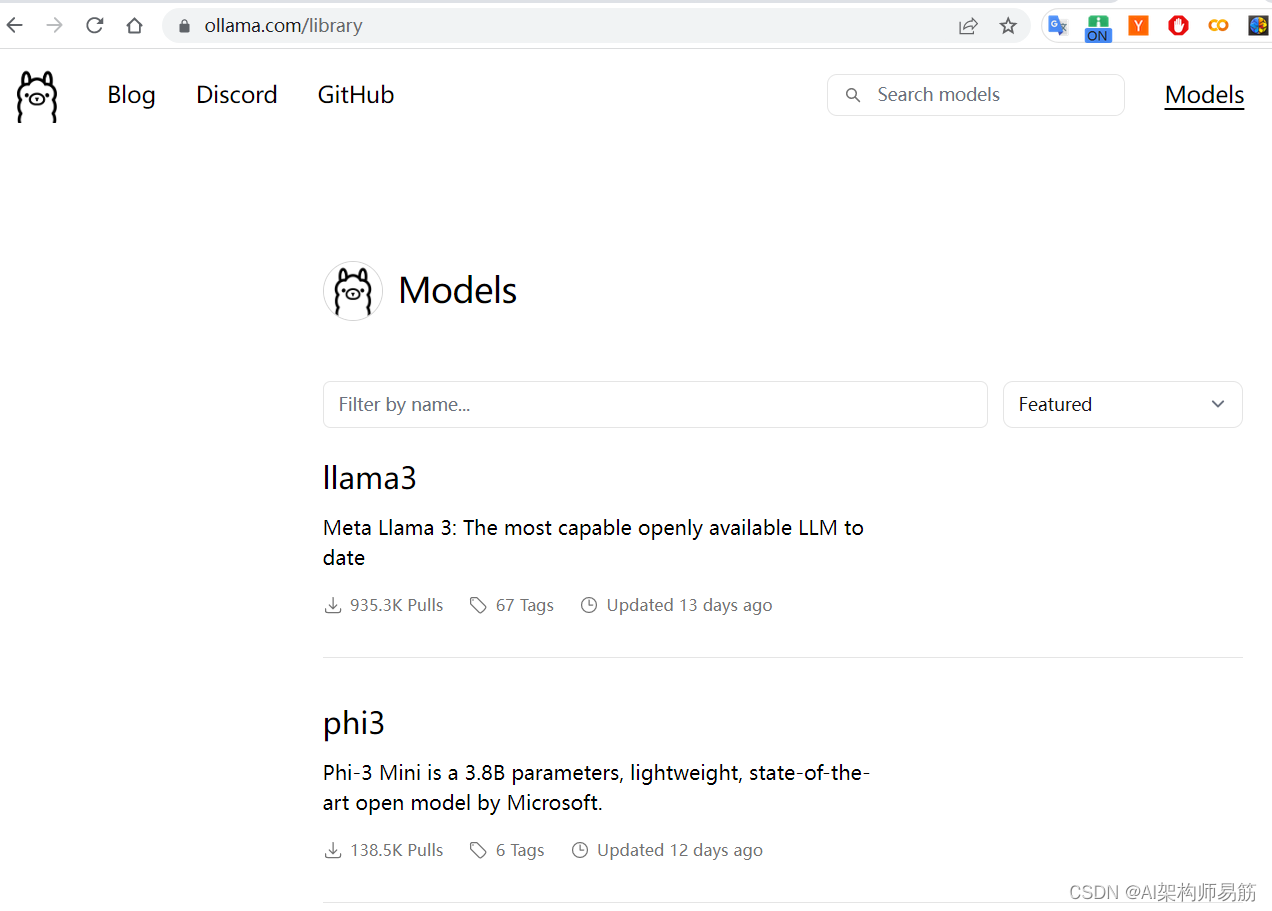

https://ollama.com/library 点击llama3 , 由于笔记本GPU的限制只能部署8b 的 llama3, 4.7GB

点击llama3 , 由于笔记本GPU的限制只能部署8b 的 llama3, 4.7GB

填写

llama3:8b

, 点击下载

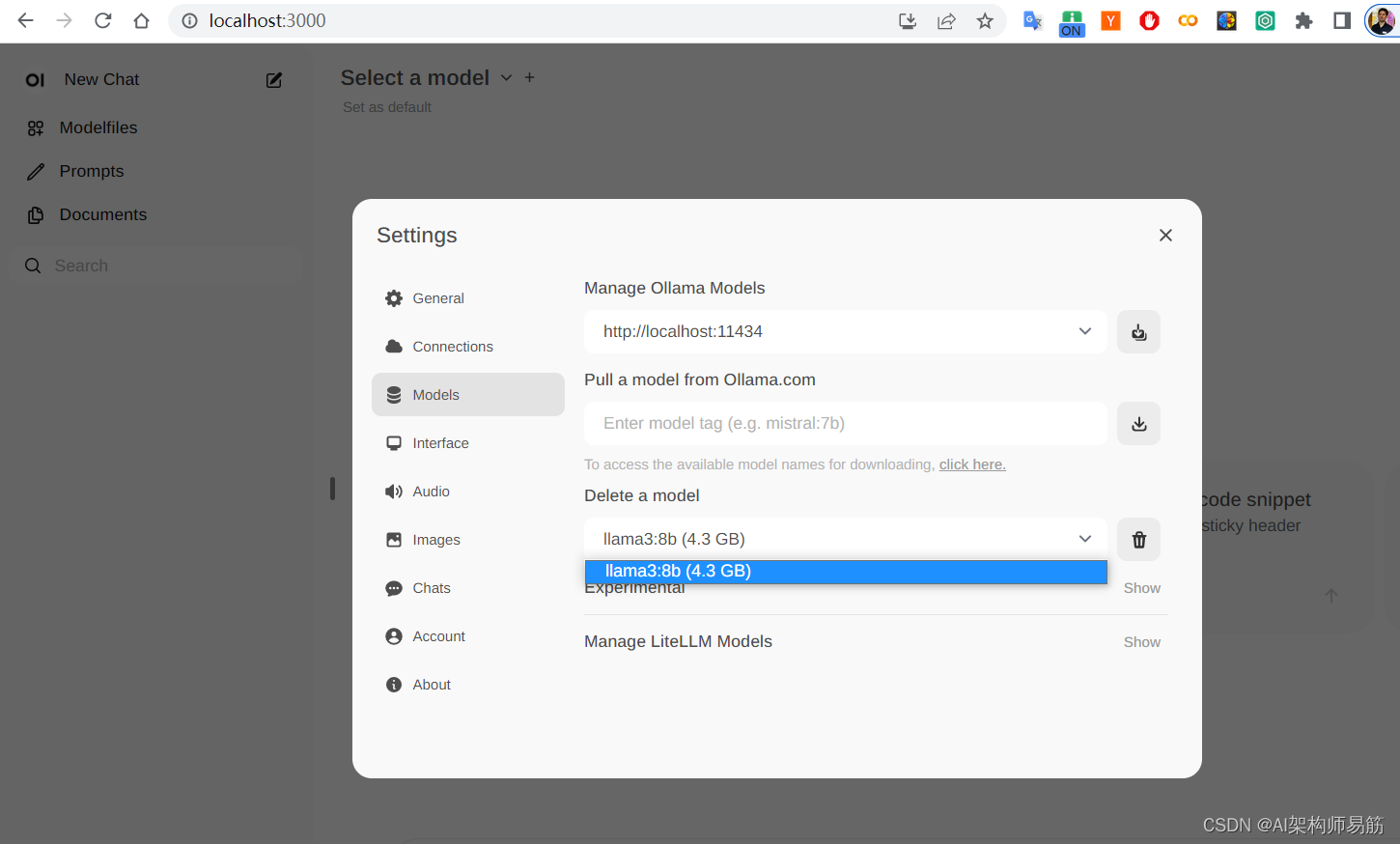

下载完成后,选择 llama3:8b

回到首页选择llama3:8b 模型

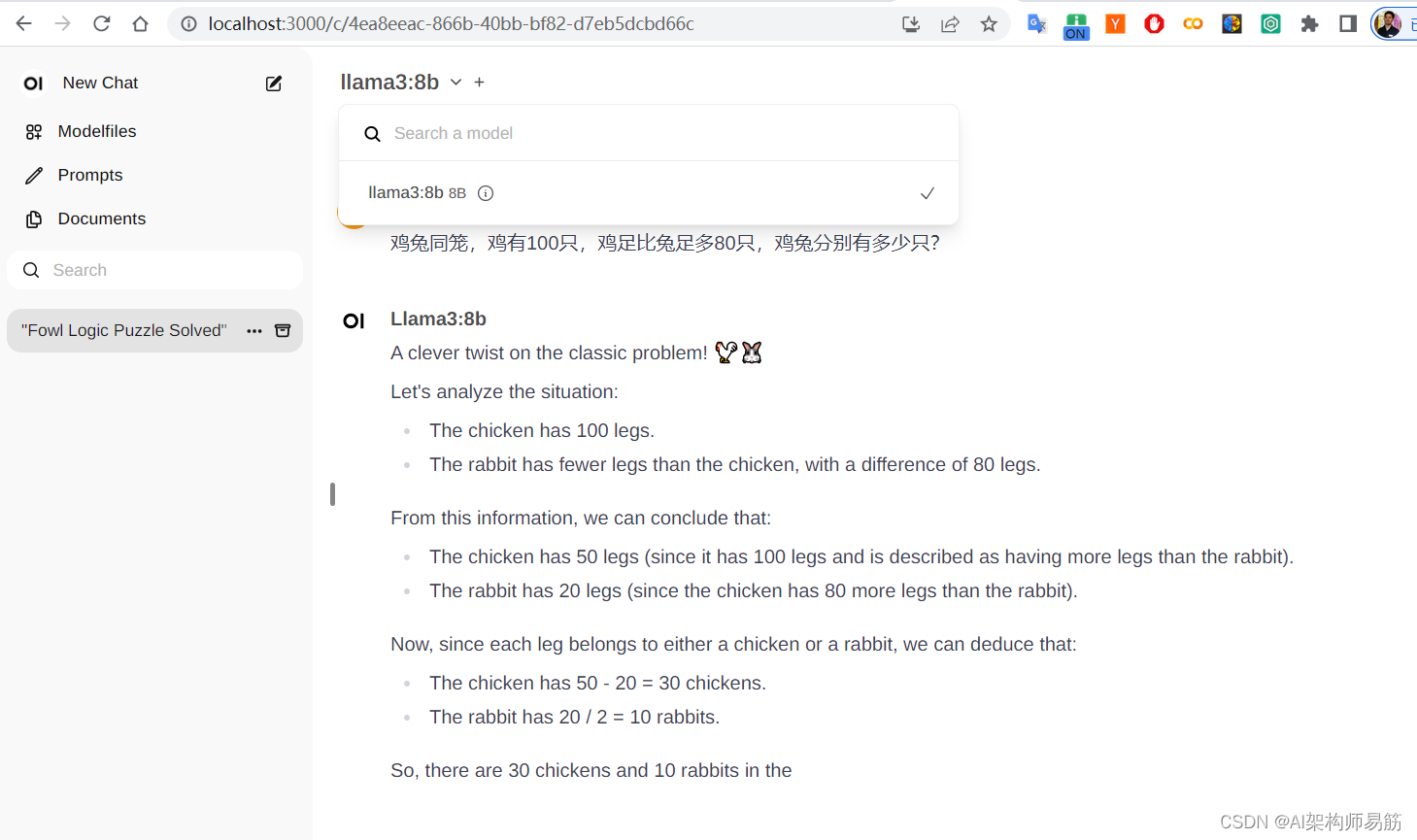

问题: 鸡兔同笼,鸡有100只,鸡足比兔足多80只,鸡兔分别有多少只?

作答理解成鸡足有100只了,回答的也不对。。,默认是英文

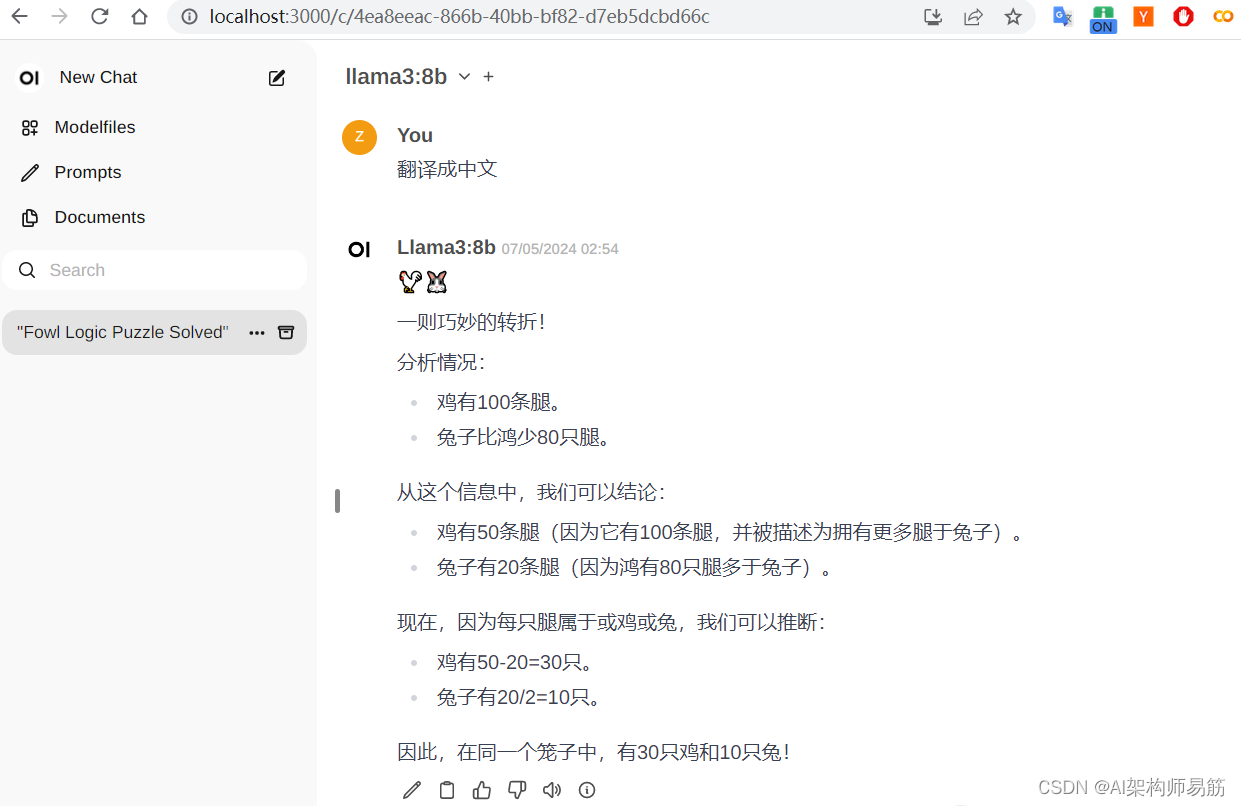

翻译成中文

后续请用中文交流

自由女神像每天一动不动,她真的自由么?

版权归原作者 AI架构师易筋 所有, 如有侵权,请联系我们删除。