1、spark安装包相关连接:

链接:百度网盘 请输入提取码

提取码:wanh

2、上传到虚拟机上

3、在目录/home/hadoop/software下解压:tar -zxvf spark-1.6.2-bin-hadoop2.6.tgz

4、进入conf目录,复制文件cp spark-env.sh.template spark-env.sh

5、vim spark-env.sh 进入文件编辑 点击 i ;

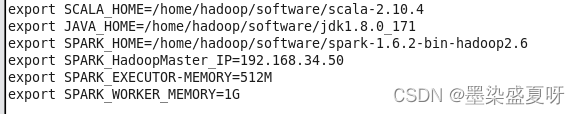

添加对应的安装路径和自己的配置:

export SCALA_HOME=/home/hadoop/software/scala-2.10.4

export JAVA_HOME=/home/hadoop/software/jdk1.8.0_171

export SPARK_HOME=/home/hadoop/software/spark-1.6.2-bin-hadoop2.6

export SPARK_HadoopMaster_IP=192.168.34.50

export SPARK_EXECUTOR-MEMORY=512M

export SPARK_WORKER_MEMORY=1G

6、cd 切换到sbin目录下使用 ./start-all.sh 命令

jps后看到worker和Master节点

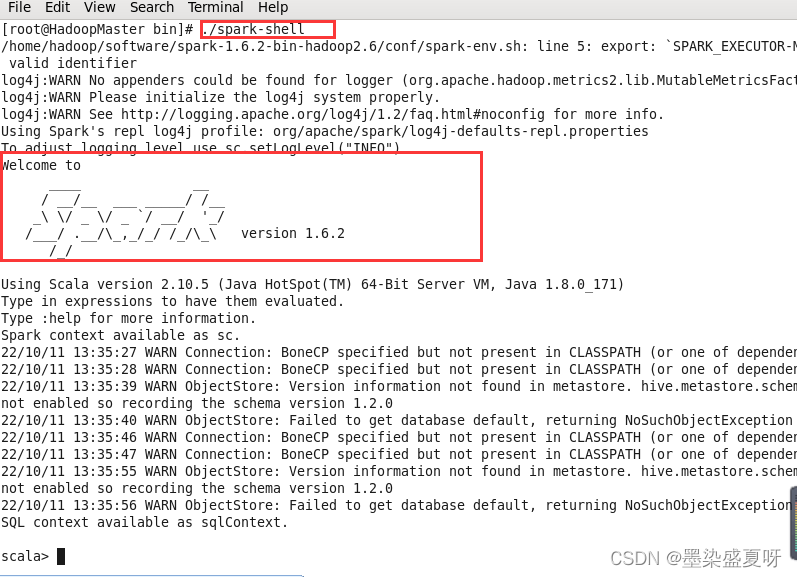

7、cd 到bin目录 使用./saprk-shell

看到spark界面,安装成功!

版权归原作者 墨染盛夏呀 所有, 如有侵权,请联系我们删除。