前言

参考文章中,给出的cdh编译后的flink,已经下架,所以我们得想办法,编译。

参考别人的文章不可怕,怕的是,不思进取,我们可以参考别人的文章,并且对不足之处,进行改进,将优秀的地方,进行学习,这样我们国家和民族的技术文章和社区,才能不断进步。

可能有一天我不干程序员了,但是技术更新了,那时,我也希望,我的文章能被别人拿走,进行改进,造福开源社区。

于是,此文章是基于参考文章为基础,进行的改进版

注意flink版本千万不要选超过1.2的

否则将会多一个很麻烦的shared包编译,会出现很多问题

需要

cdh集群(前提)---我已经搭建好了

flink的-parcel包制作

Flink Parcel包

1)下载制作包

git clone https://github.com/pkeropen/flink-parcel.git

打开git bash,克隆成功后,会在当前文件里生成一个文件夹

千万不要在windows中clone,否则会更改系统格式为windows(以下为错误示范)

将文件夹上传到centos系统,因为要用sh,(你直接从centos系统上git clone也可以)

2)修改配置文件

进入刚下载的制作包内,修改flink-parcel.properties文件

配置如下

flink下载缓慢,所以我提前下载下来放入了本地的httpd服务器中

我在apache官网下载的,下载缓慢

https://dlcdn.apache.org/flink/flink-1.12.7/flink-1.12.7-bin-scala_2.12.tgz

于是改成了国内化腾镜像,速度飞起

https://mirrors.cloud.tencent.com/apache/flink/flink-1.12.7/flink-1.12.7-bin-scala_2.12.tgz

将下载的文件放到自己的本地httpd目录,/var/www/html/下

#flink 下载地址

FLINK_URL=http://192.168.30.101:httpd端口/flink文件路径#flink版本号

FLINK_VERSION=1.12.7#扩展版本号

EXTENS_VERSION=BIN-SCALA_2.12#操作系统版本,以centos为例

OS_VERSION=7#CDH 小版本,我是6.3.2的集群,所以我把最大值设置为6.3.3

CDH_MIN_FULL=5.2

CDH_MAX_FULL=6.3.3#CDH大版本

CDH_MIN=5

CDH_MAX=6

将build.sh和flink-parcel.properties 文档格式 转换为UNIX格式

(1)将文件夹上传到服务的

(2)linux上安装git

sudo yum install -y git

(3)linux安装maven

maven下载,虽然只有8MB,但是官网下载缓慢

我还是下载了下来

** 解压**

tar -zxvf apache-maven-3.8.6-bin.tar.gz

这是我解压的目录/software/apache-maven-3.8.6

环境变量配置(加上这2句)

vi /etc/profile

export MAVEN_HOME=/software/apache-maven-3.8.6

export PATH=$PATH:$MAVEN_HOME/bin

更新

source /etc/profile

测试

mvn- v

因为大神写的Parcel的build.sh脚本需要依赖maven和git以及sh还有java

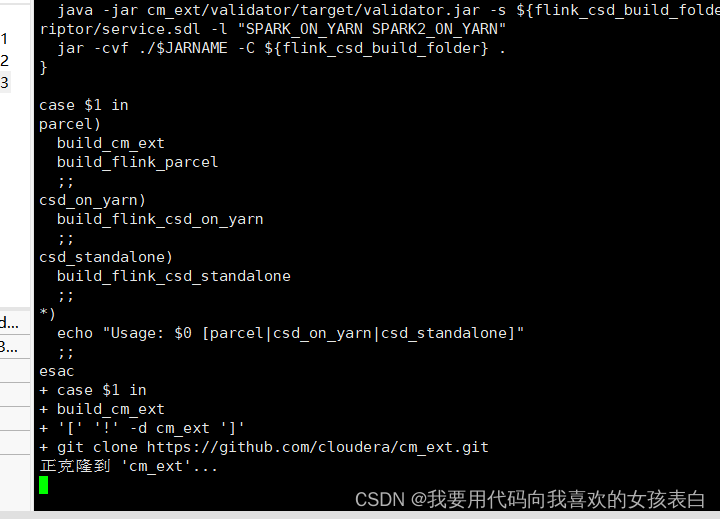

3)build.sh使用

parcel包

使用当前目录的build.sh脚本执行

./build.sh parcel

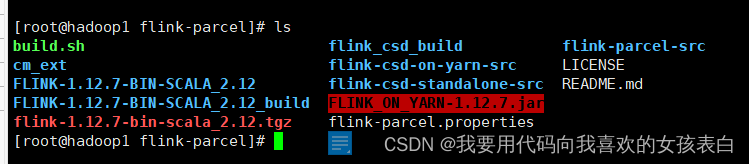

成功后会在当前目录生成

** 构建flink-yarn csd包**

./build.sh csd_on_yarn

成功会生成

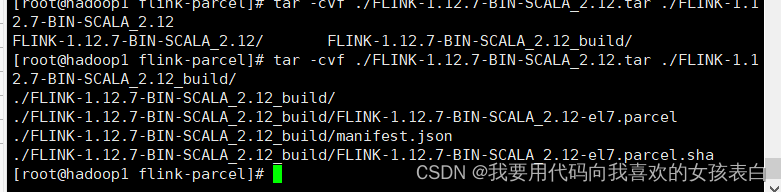

4)打包

tar -cvf ./FLINK-1.12.7-BIN-SCALA_2.12.tar ./FLINK-1.12.7-BIN-SCALA_2.12_build/

生成

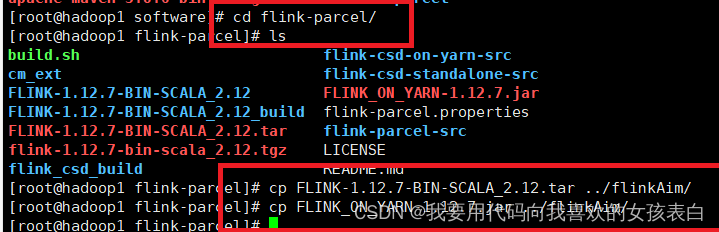

在上1级目录,生成目标包

把这2个包,copy过去

(1)将FLINK-1.12.7-BIN-SCALA_2.11_build里的文件放到/opt/cloudera/parcel-repo

(2) cp FLINK_ON_YARN-1.12.7.jar /opt/cloudera/csd/

** 先点分配**,重启server,

重启server

systemctl restart cloudera-scm-server

然后 在点激活,本来我是截图自己的,csdn给我删掉了,ctrl+z真的吐血,你们的设计,直接给我回退到上次自动保存点,而不是删除我刚刚输入的数据。

配置去掉安全选项

启动flink报错

"未找到与筛选器 'entityName = "flink_on_yarn-FLI xxx 匹配的实体"

之类的话

在cdh中关闭,其他服务,否则按照时候内存不够

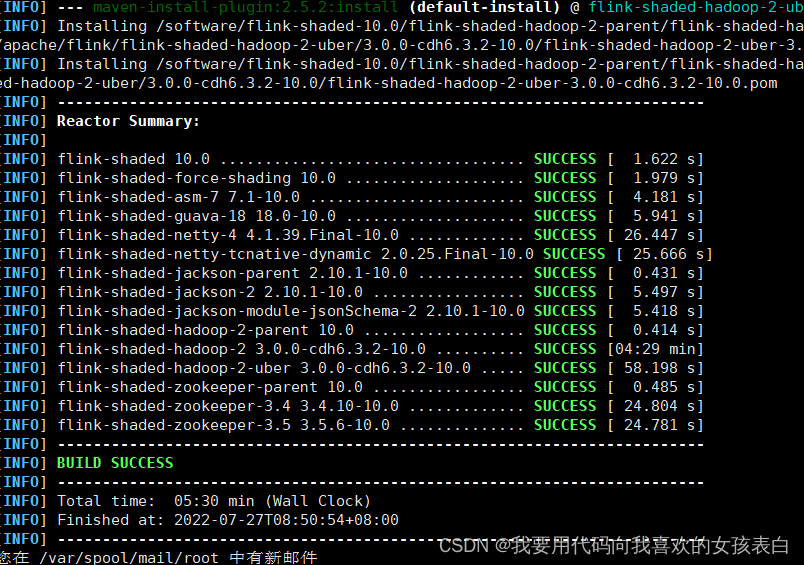

mvn clean install -DskipTests -Pvendor-repos -Dhadoop.version=3.0.0-cdh6.3.2 -Dscala-2.12 -Drat.skip=true -T10C

参考文章:

CDH集成Flink_大数据左右手的博客-CSDN博客_cdh集成flink

自制Flink Parcel集成CDH(Flink1.12.0 + CDH6.3.2)_东东的学习笔记666的博客-CSDN博客

GitHub - pkeropen/flink-parcel: flink 集成CDH5的自定义paracels

版权归原作者 我要用代码向我喜欢的女孩表白 所有, 如有侵权,请联系我们删除。