作者 | 宋慧

出品 | CSDN

生成式人工智能(GenAI)正在持续火爆,不过利用GenAI技术的欺诈和安全威胁也在紧随发生。

例如 2024 年初,香港警方披露了一起 AI“多人换脸”的诈骗案,涉案金额高达 2 亿港元。香港 AI 换脸案件中,一家跨国公司香港分部的职员受邀参加总部首席财务官发起的“多人视频会议”,并按照要求先后转账多次,将 2 亿港元转账到了 5 个本地银行账户内。其后,向总部查询才知道受骗。警方调查得知,这起案件中所谓的视频会议中只有受害人一个人是“真人”,其他“参会人员”都是经过“AI 换脸”后的诈骗人员。

不过另据报道,该“AI 换脸”不是实时演算,嫌疑人使用预制视频,会内主要以上司下属的关系向职员下达命令,其间职员没有机会与会议的参加者进行交流,整个视频会议只要求职员作一次简短的自我介绍,其后骗徒以借口完结会议,并在即时通讯软件继续下达命令。(支付审核流程仍存疑)据国际分析机构 Gartner 的预测,到 2026 年 30%的企业将因为人工智能(AI)生成的人脸生物识别深度伪造攻击而认为此类身份认证和验证解决方案不再能够起到可靠的作用。(https://www.gartner.com/cn/newsroom/press-releases/2024-genai-deepfakes)

近日 Gartner 发布了 2024 年全球网络安全最新趋势报告,从 Gartner 分析师的角度也能看到,越来越多网络安全厂商发布了GenAI 在网络安全的应用与服务,Gartner 的客户也在关注“如何帮助(他们的)企业安全地使用生成式人工智能服务。”

Gartner 研究总监陈延全表示 GenAI的技术与应用(文字、多模态、语音、视频、行业模型、Agent 等等)仍在持续演进,因此,目前没有完整的安全解决方案去应对其中的安全风险,需要持续采用数据、模型层面的技术去降低 GenAI 的风险。不过,2025 年将会出现更多相关的成熟产品,将 GenAI集成到安全工作流程或日常工作中。

报告列出生成式 AI(报告使用 GenAI 表示)与安全所产生的各方面影响

从GenAI和安全的用户侧来说,首先要关注的是使用 GenAI 和大模型时,应从 AI 服务的不同构建和使用方式(如: 自研自建、使用第三方SaaS、API、或集成的第三方GenAI组件…等)去分析和防范安全风险。除了使用 GenAI 与大模型(LLM)之外,用户也要从防御、使用、自建、攻击四个方面去关注 GenAI技术在安全方面的应用或风险:

一、防御:通过GenAI防御外部攻击,即生成式安全人工智能(Generative Cybersecurity AI)

二、攻击:关注黑客如何利用 GenAI攻击系统与环境

三、自建:自建GenAI或自训练LLM时,关注数据、系统开发安全与法规监管等

四、使用:提升安全团队对业务使用GenAI服务的可见度与监控

另外报告也给出了具体的建议,那就是记录监控和管理内部GenAI使用情况,重视对GenAI的使用和实施指南,了解如何防护GenAI所暴露的安全风险,使用 AI 技术的同时不断试验、测量、监控对应的安全措施。

陈延全向 CSDN 分享了另一份报告,指出对于GenAI技术和应用开发者可能遇到在 AI 全生命周期中的攻击。如向训练数据“投毒”,第三方数据库、基础模型、代码库、应用上线后的运行、输入输出、API 集成时的风险等等,这些都是 AI 开发中需要重视的威胁点。

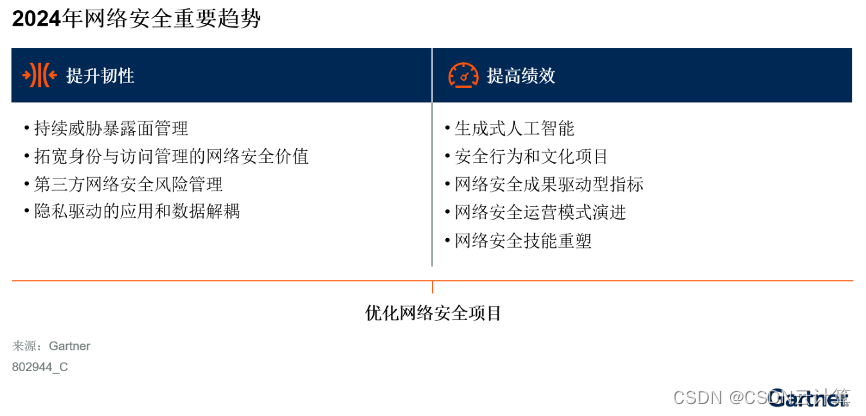

除了生成式人工智能,Gartner 在报告中发布了另外八个重要的趋势,分别是网络安全成果驱动指标、安全行为和文化项目、网络安全运营模式演进、第三方网络安全风险管理、持续威胁暴露面管理、网络安全技能重塑、拓宽身份与访问管理的网络安全价值、隐私驱动的应用和数据解耦。这些趋势涵盖了身份识别等威胁攻击、数据的窃取、不断变化的监管、对应数字化转型(如更多元的业务和应用、系统)的分布式安全,以及安全技能的刷新升级等非常多的方面。

版权归原作者 CSDN云计算 所有, 如有侵权,请联系我们删除。