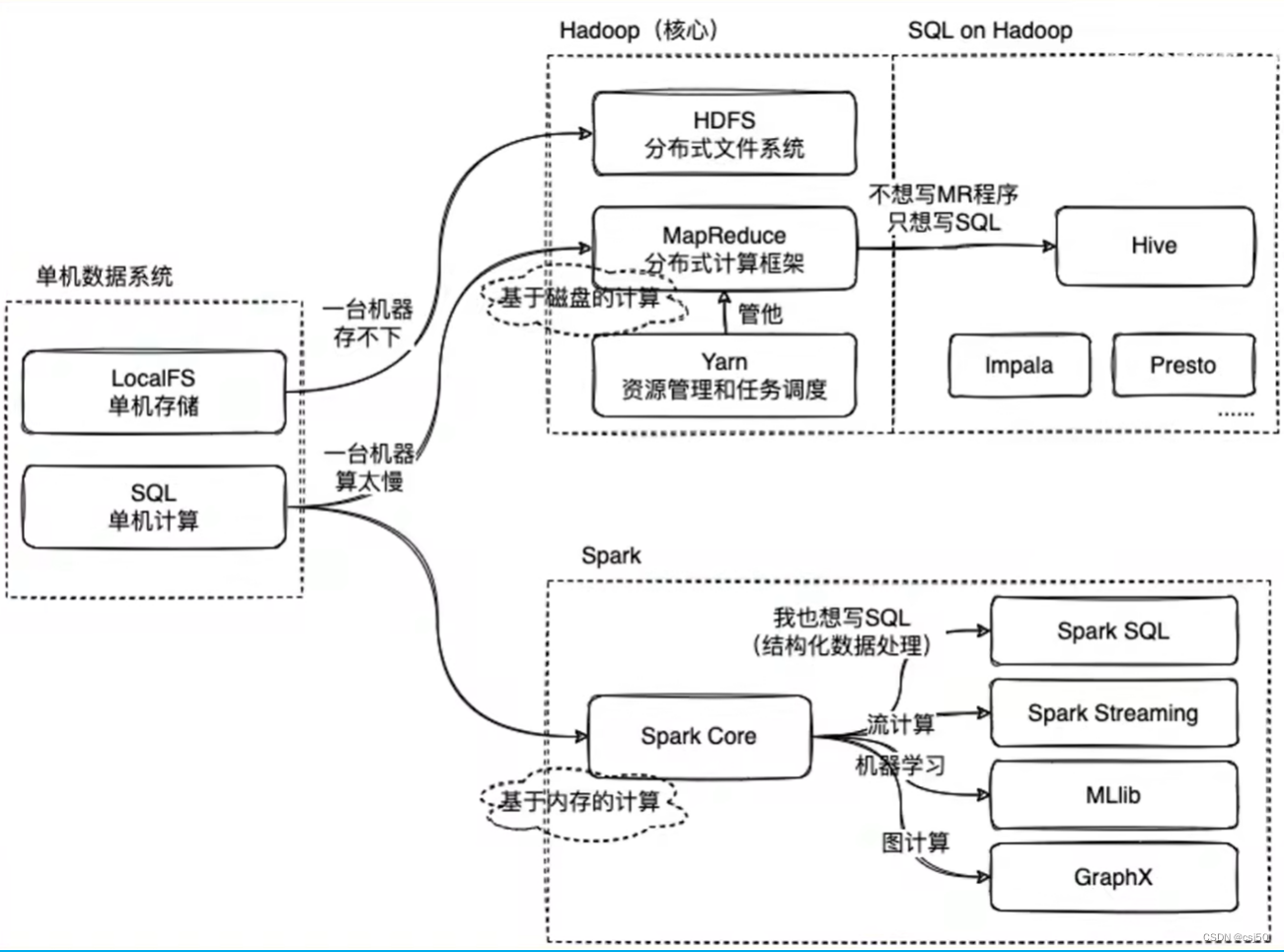

一、Hadoop

1、Hadoop大数据框架,处理分布式环境下数据存储和计算

2、Hadoop的HDFS处理存储

3、Hadoop的MapReduce处理计算

map让任务数据拆分到每一台去执行

reduce处理后的任务合并

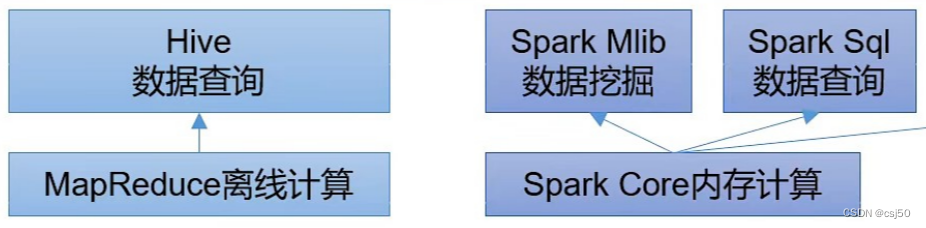

4、Hive作用是在Hadoop上能够让用户来写SQL处理数据

Hive的执行引擎,会把SQL语句翻译成一个MapReduce的任务去执行

二、Spark

1、Spark本身也是一个计算框架,它和Hadoop的MapReduce对比(相当于MapReduce升级版)。不同点是Spark是一个基于内存的计算,MapReduce是基于磁盘的计算,Spark速度会比Hadoop快2-3倍

2、Spark也有Spark SQL的这个模块,让用户在Spark的API上面去写SQL

三、Hadoop的HDFS

1、Hadoop的分布式文件存储系统

2、数据分布在许多计算机中以块的形式存储,但是用户看起来就是一块磁盘

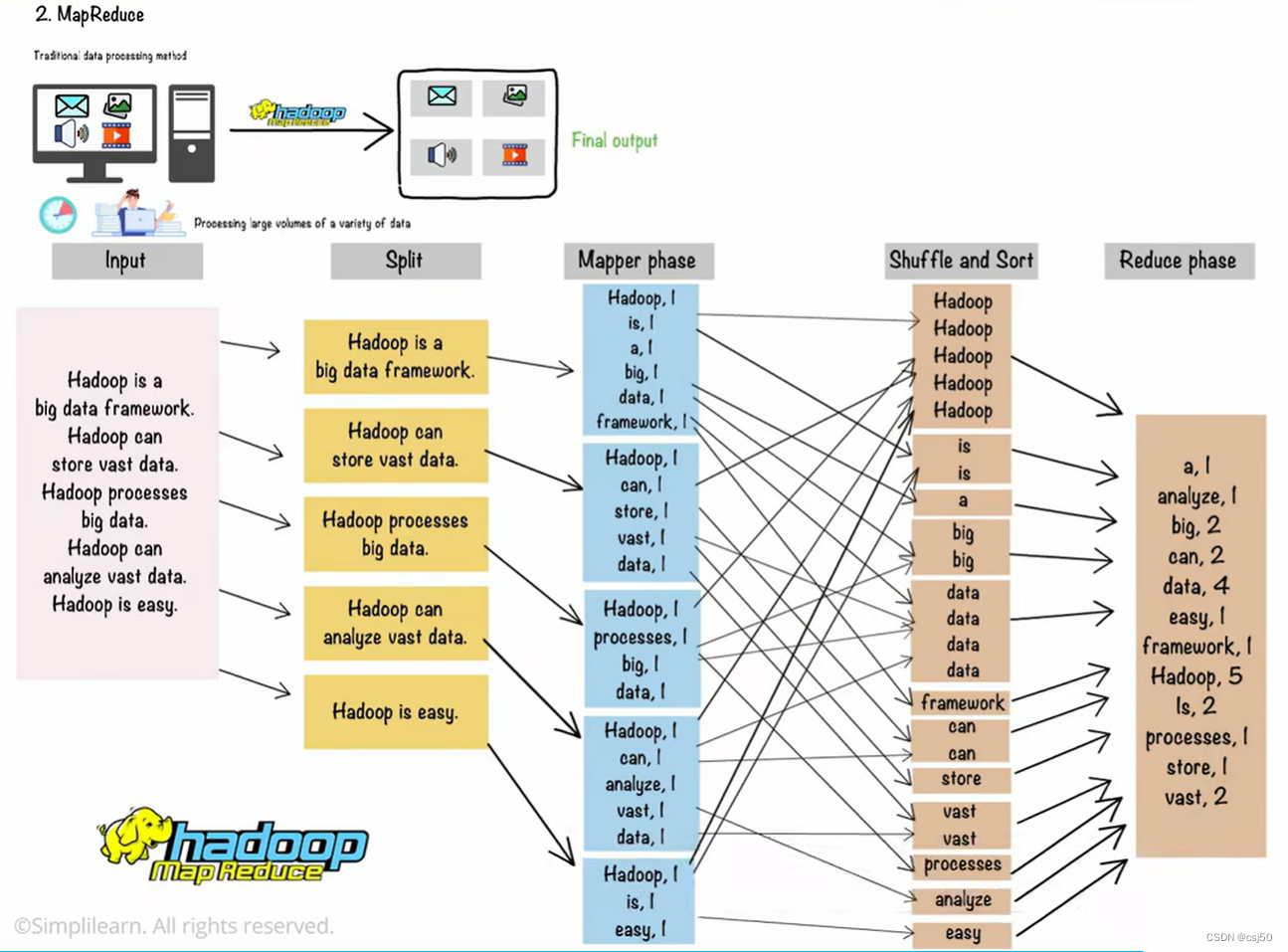

四、Hadoop的MapReduce

MapReduce将数据分成多个部分,并在不同的数据节点上分别处理每个部分,然后将各个结果汇总并输出

五、Hadoop的Yarn

1、资源管理器:分配资源

2、节点管理器:处理节点并监控节点中的资源使用情况

3、应用管理器:管理应用

4、容器:包含物理资源的集合

5、处理创建的MapReduce任务

(1)应用管理器从节点管理器请求容器

(2)节点管理器获得资源后,将它们发送给资源管理器

(3)这样Yarn在Hadoop中就可以处理任务请求并管理集群资源

六、Hadoop其他管理、处理、分析工具

Hive、Pig、Spark、Flume、Scoop等等

七、Flink

用于实时计算,可以与yarn集成

八、Hbase

用于海量存储

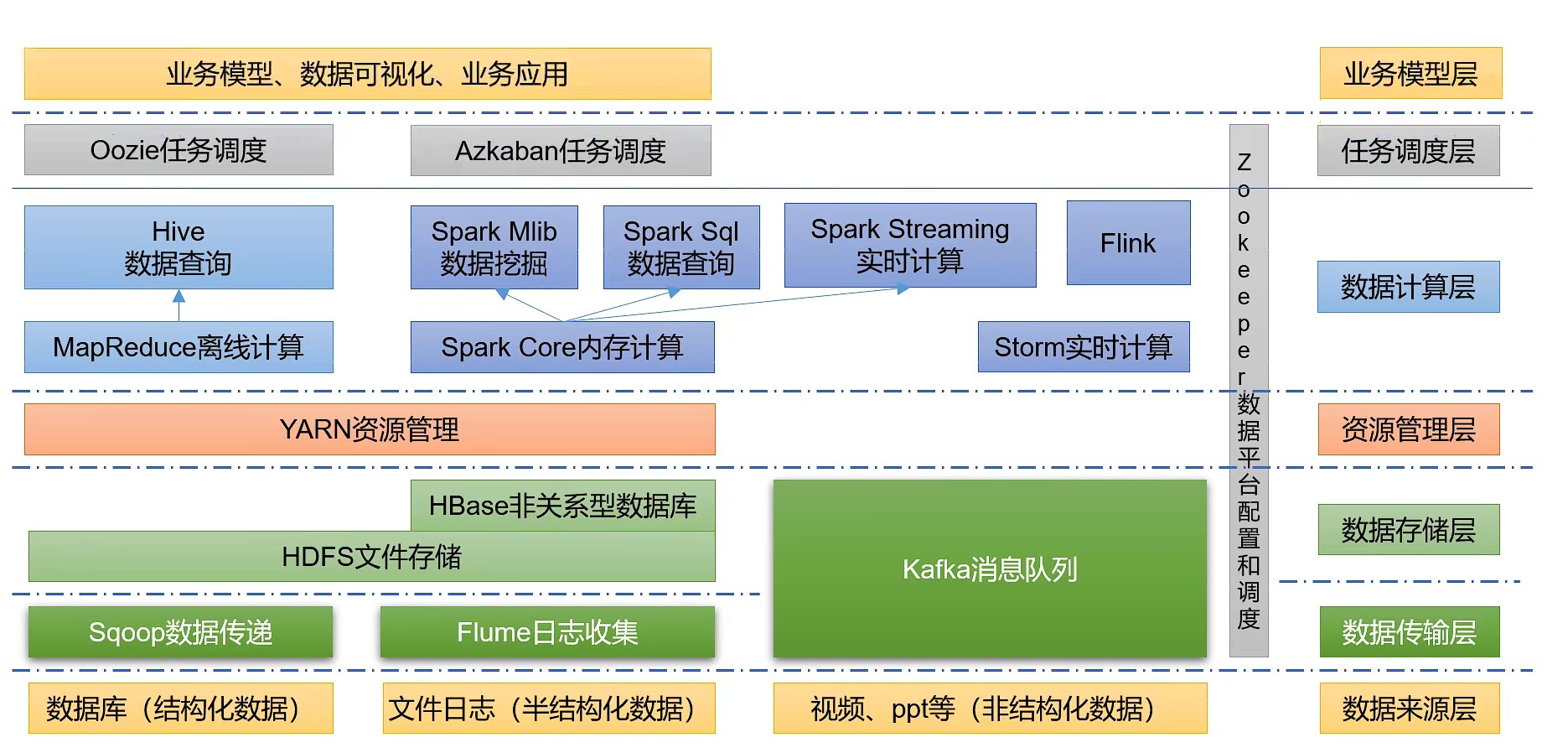

九、大数据技术生态体系

包括数据的收集传递、存储、资源的管理、计算、任务调度、业务应用等层次。

组件包括:

Sqoop:是一款开源的工具,主要用于在Hadoop、Hive与传统数据库(Mysql、Oracle)之间进行数据的传递,可以将一个关系型数据库中的数据导进HDFS中,也可以将HDFS的数据导入关系型数据库中。

Flume:是一个高可用的、高可靠的、分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据。

Kafka:是一种高吞吐量的分布式发布订阅消息系统。

Spark:是当前最流行的开源大数据内存计算框架,可以基于Hadoop上存储的大数据进行计算。

Flink:是当前最流行的开源大数据内存计算框架,用于实时计算的场景比较多。

Oozie:是一个管理Hadoop作业(job)的工作流程调度管理系统。

HBase:是一个分布式的、面向列的开源数据库。HBase不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。

Hive:是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的SQL查询功能,可以将SQL语句转换为MapReduce任务进行执行。可以通过类似SQL语句来快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

ZooKeeper:是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、名字服务、分布式同步、组服务等。

说明:

(1)图中Kafka既可以做数据传输也可以做数据存储。

(2)这些是离线计算

(3)这些是实时计算

版权归原作者 csj50 所有, 如有侵权,请联系我们删除。