身边没有显卡资源或不足以训练模型时,可以租赁服务器的显卡。

1、注册AutoDL并配置环境

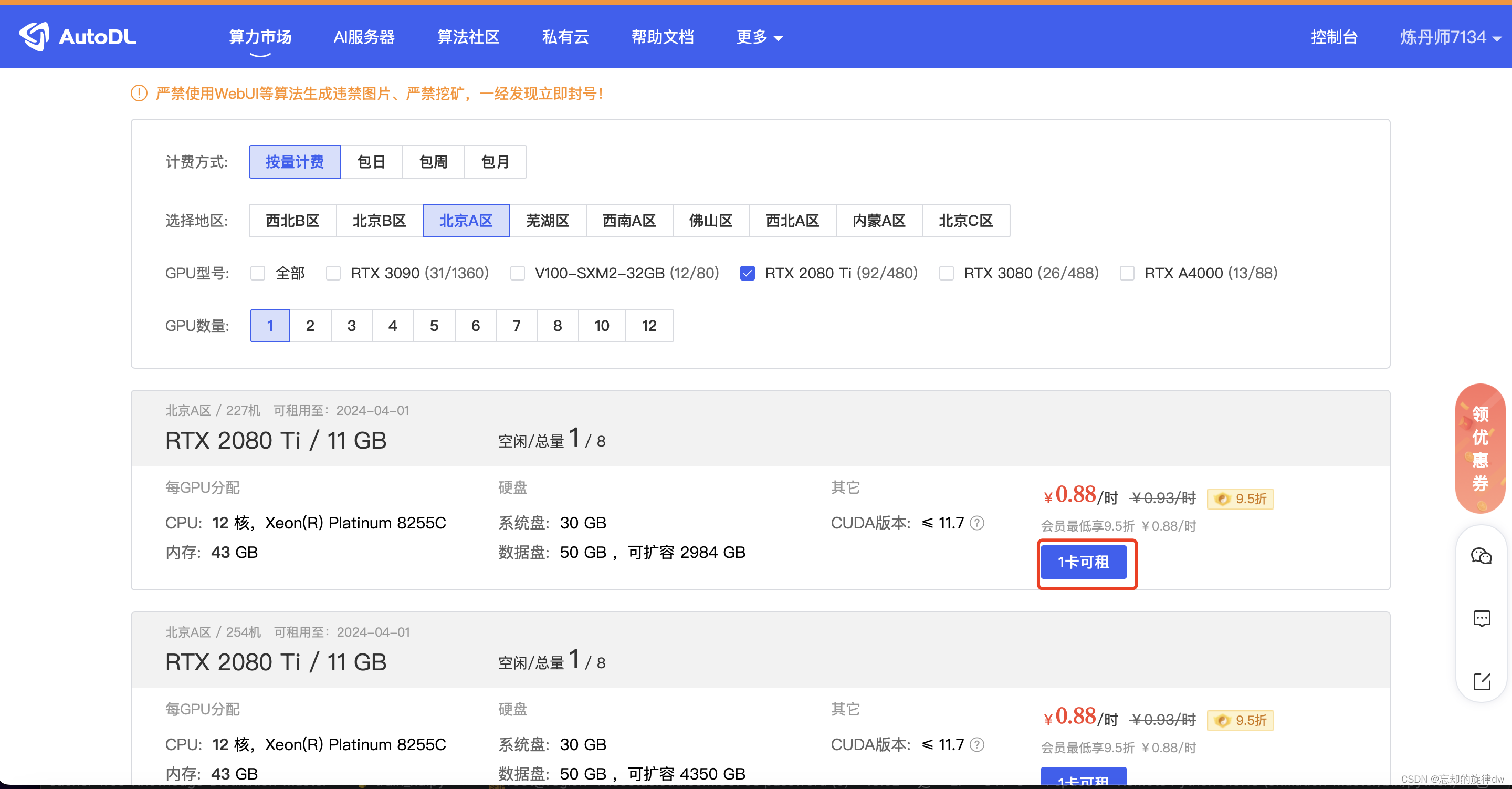

首先打开AutoDL官网,注册账号并租赁自己期望的显卡资源

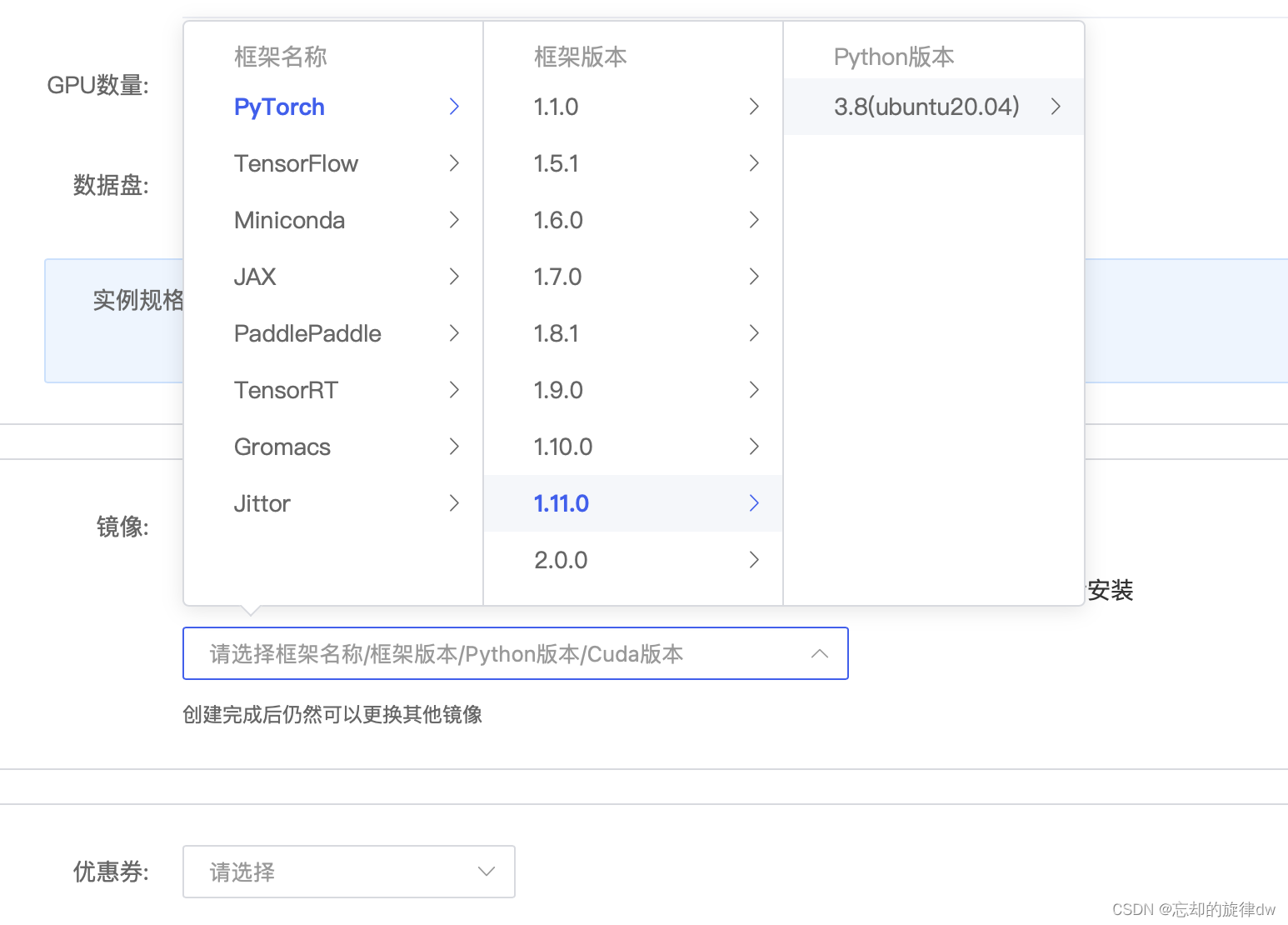

点击“租赁”之后,我们要继续选择基础环境。此处,我们让其自动配置好基础的pytorch,也可以选择Miniconda,后续自己用conda配置。因为我自己的模型需要用到pytorch,我就让它自动配置一下。

然后开机

2、 下载FileZilla并传输项目

写在前面,有可能你的项目会比较大,上传比较耗时,但服务器一直在开着,会比较费钱,可以先去把服务器关了,点“更多”,再点“无限卡模式开机”。这时你的服务器就不带GPU,平台只收你1毛钱一小时。(不过,如果你后面忘了关机并带GPU开机,显然你的项目是跑不起来的)

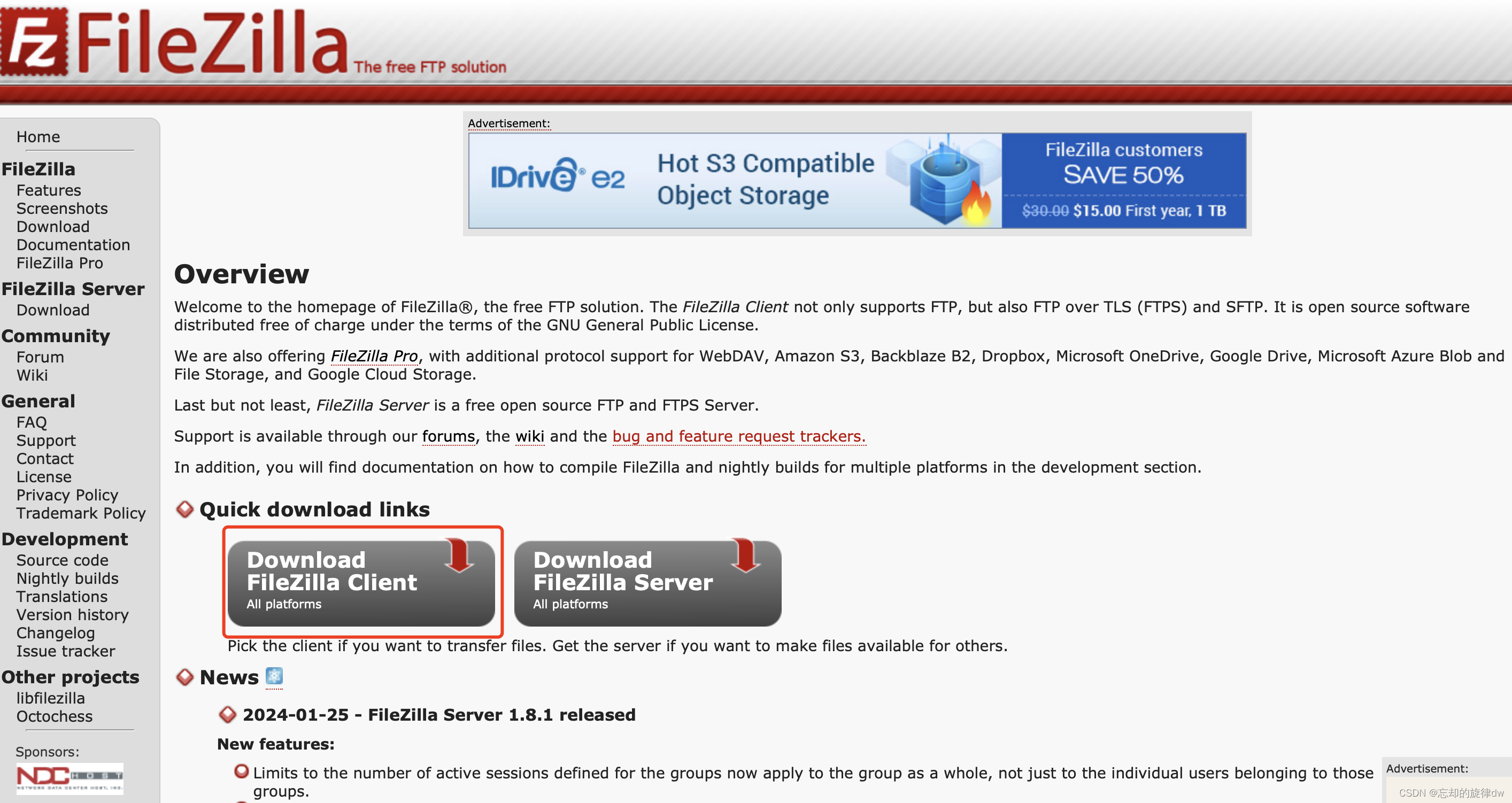

FileZilla用于本地和服务器传输文件。下载FileZilla。

首先打开官网:

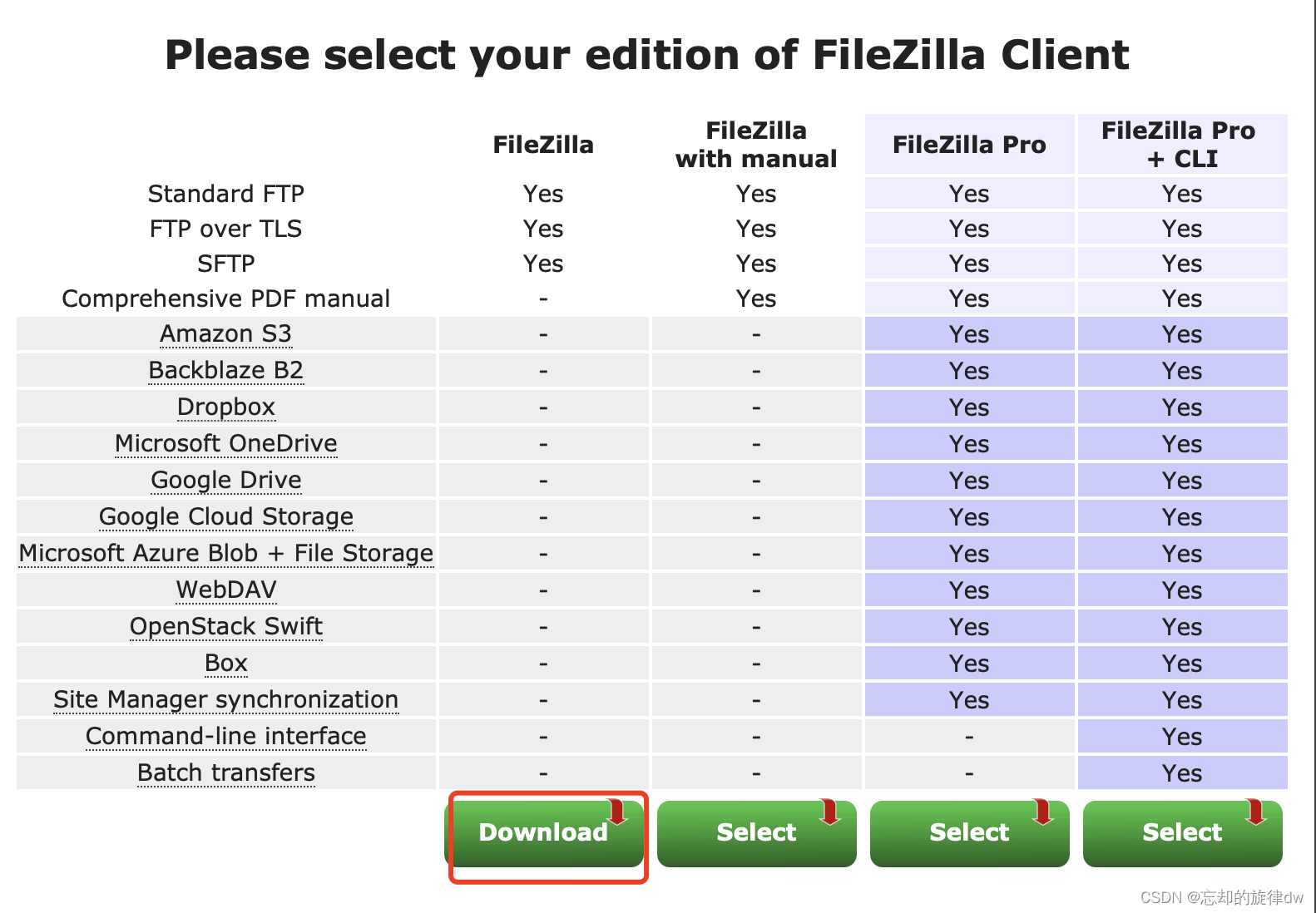

然后选择对应操作系统版本,下载

点这个,下载

然后就是正常的安装过程。。。省略了

接着打开安装好的FileZilla,点左上角这个书架(不听系统版本长得不完全一样,但差不多)

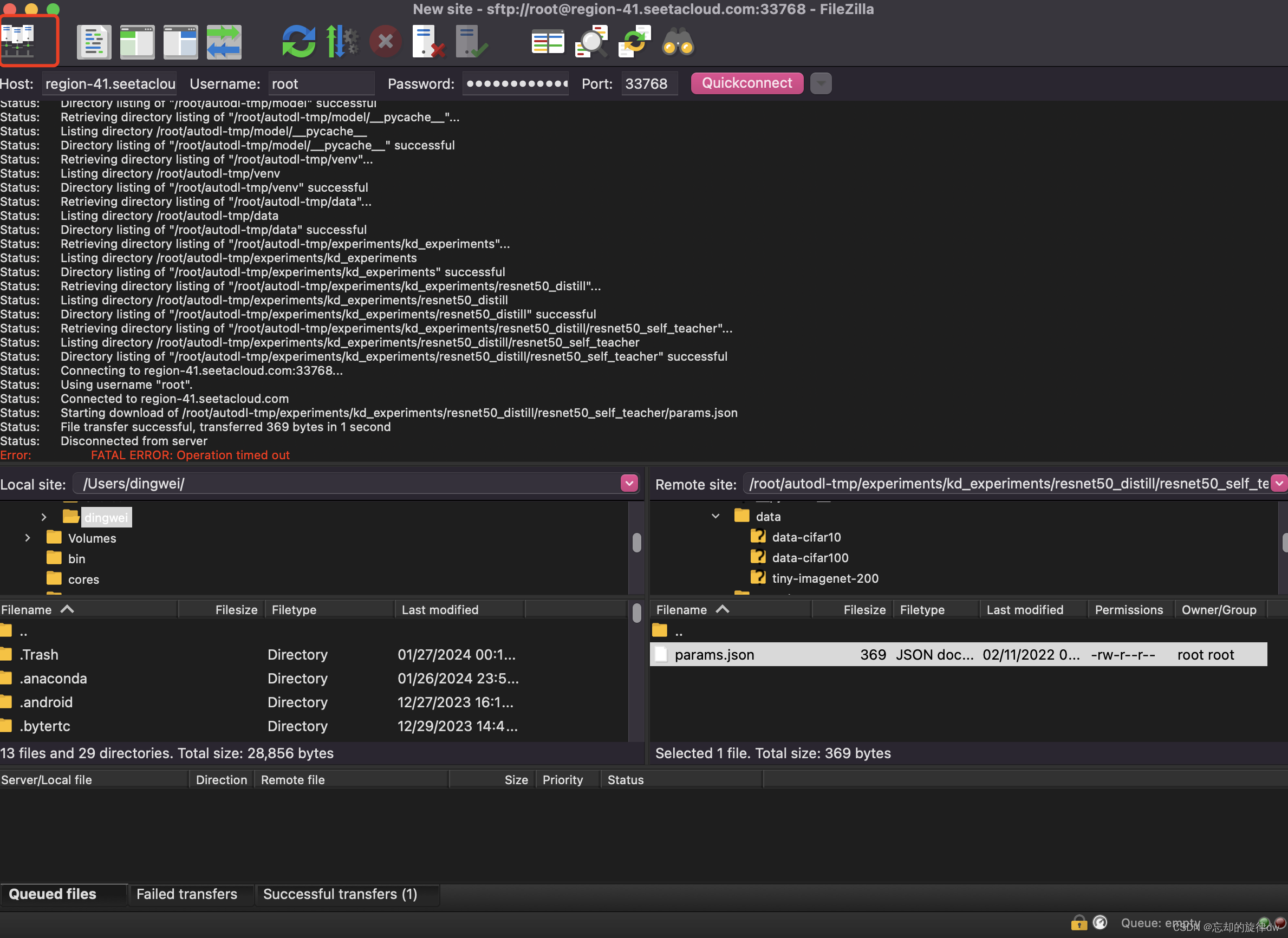

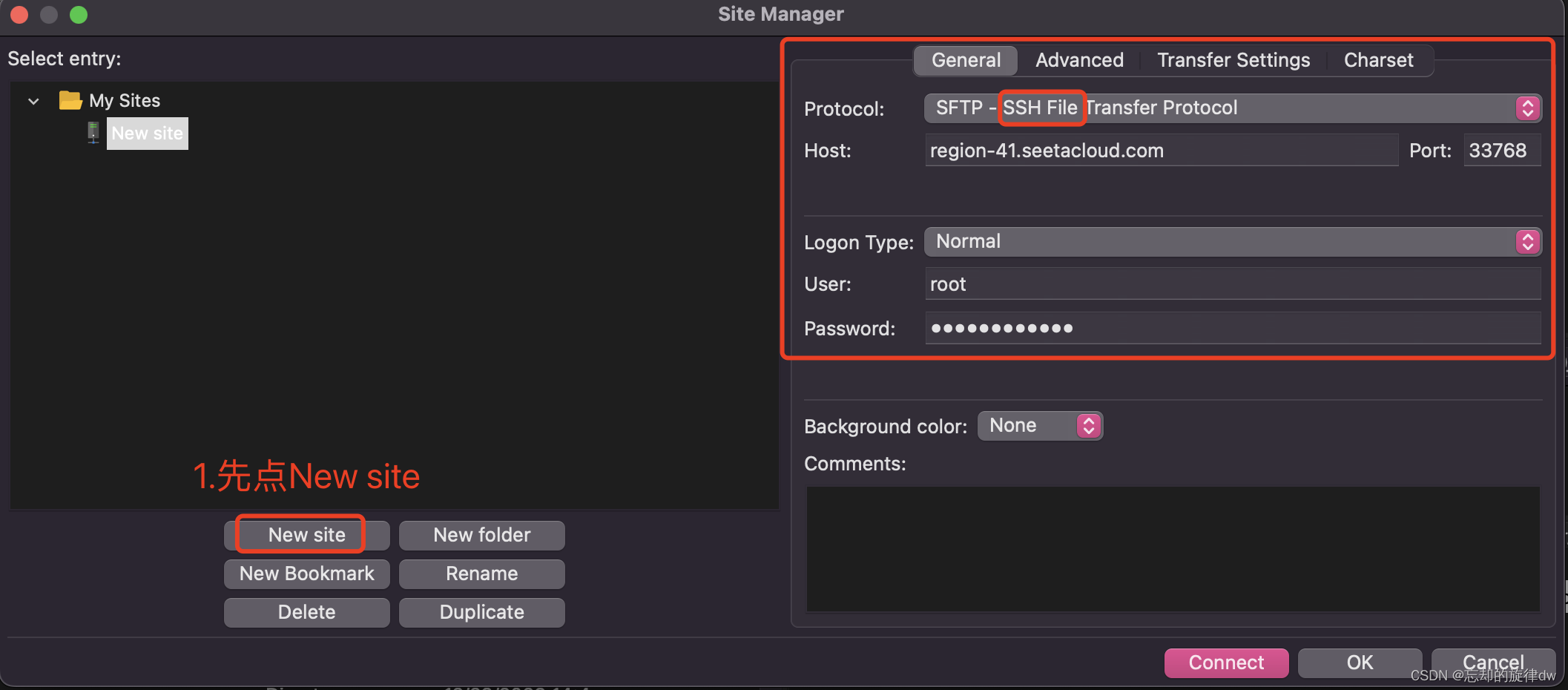

然后点击new site,填写这些信息。这些信息从哪来?看下一步

打开你的Auto DL,看你控制台,容器实例,你刚开机的机器这里有登录指令和密码。复制登录指令长这样:

ssh -p 33768 [email protected]

。我们把它拆解一下

- host,也就是IP地址:

region-41.seetacloud.com - 用户名:

root - 端口:

33768

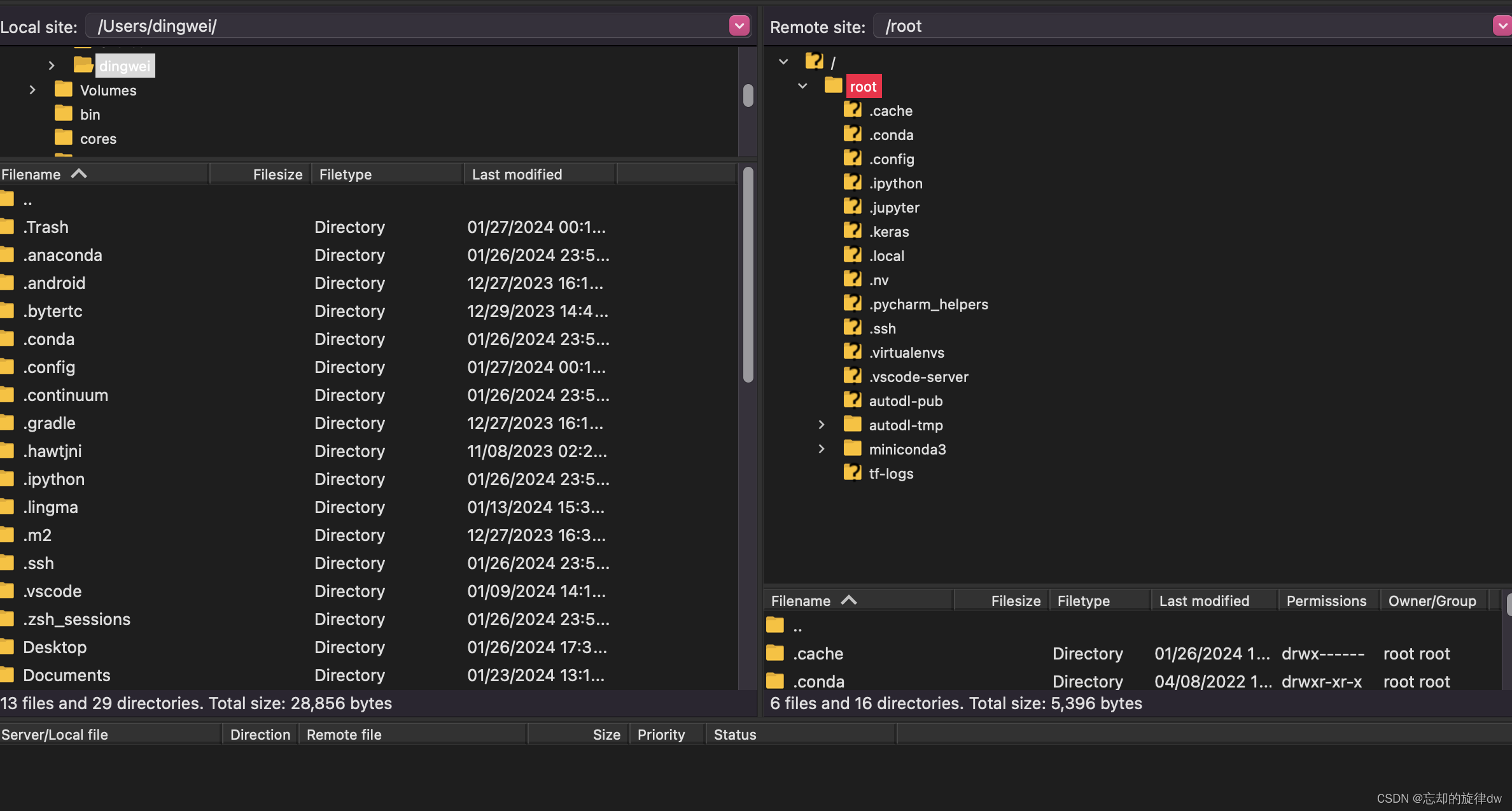

接着,连接FileZilla即可。然后可以传输你本地的项目文件到服务器上。

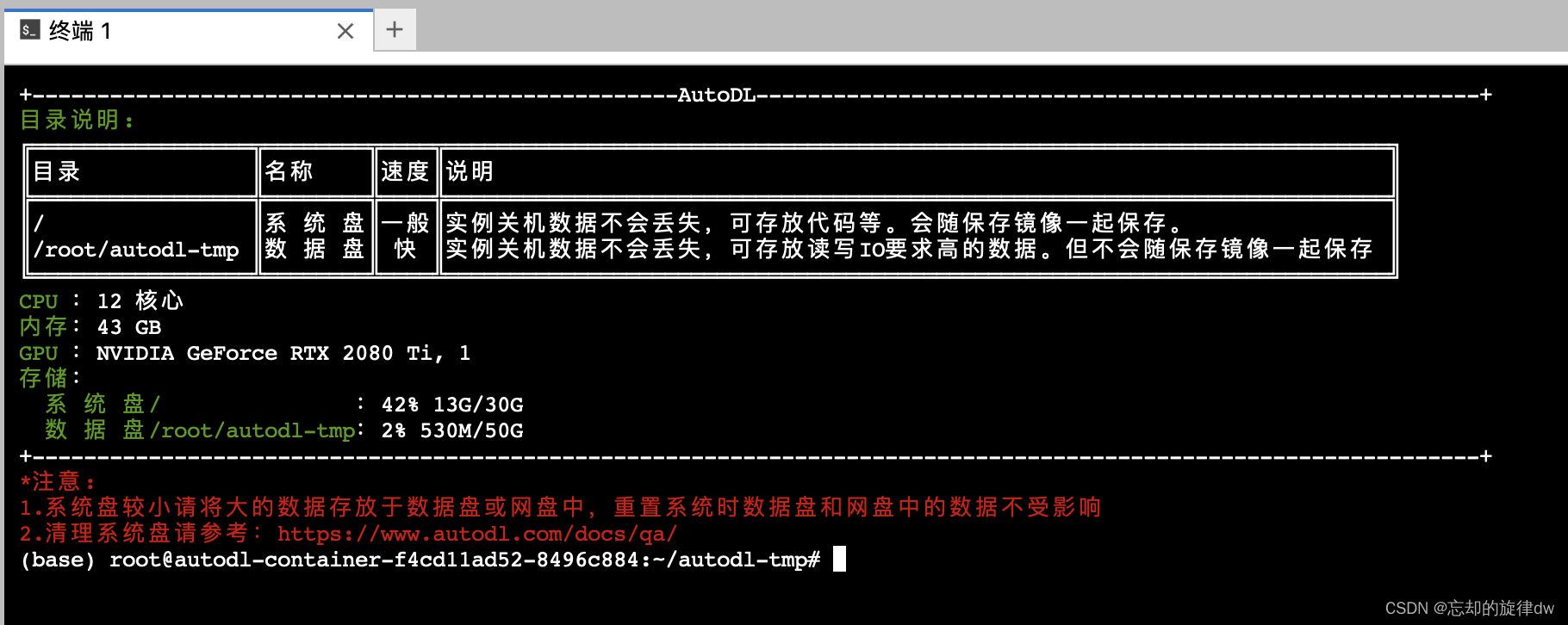

可以解释一下这个服务器上的文件结构:

- 默认的base解释器:/root/miniconda3/bin/python.exe

- conda环境列表:/root/miniconda3/envs

- 一般,我们用来存放项目的位置:/root/autodl-tmp

然后拖拽你的项目到右边就行了。

3、使用Jupyter访问服务器

在这之前,你需要在你的本地电脑上安装好anaconda。然后安装Jupyter notebook。

conda install jupyter notebook

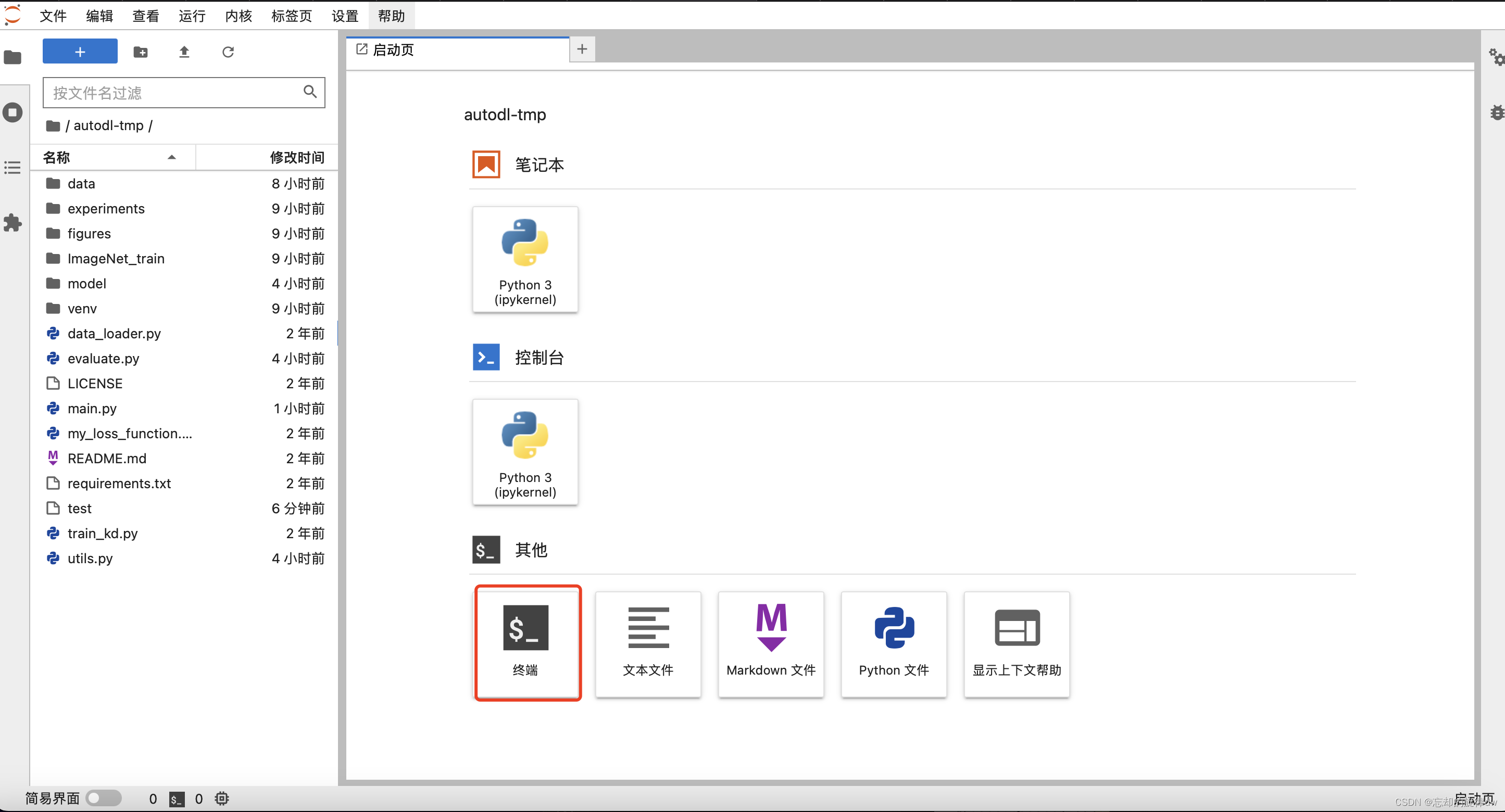

安装好后,再打开你的AutoDL控制台,点这个Jupyter Lab。

应该是这样的画面:

然后点终端,就可以正常使用conda,安装我们自己的环境之类的了。其实jupyter也可以上传本地文件。。。。。:

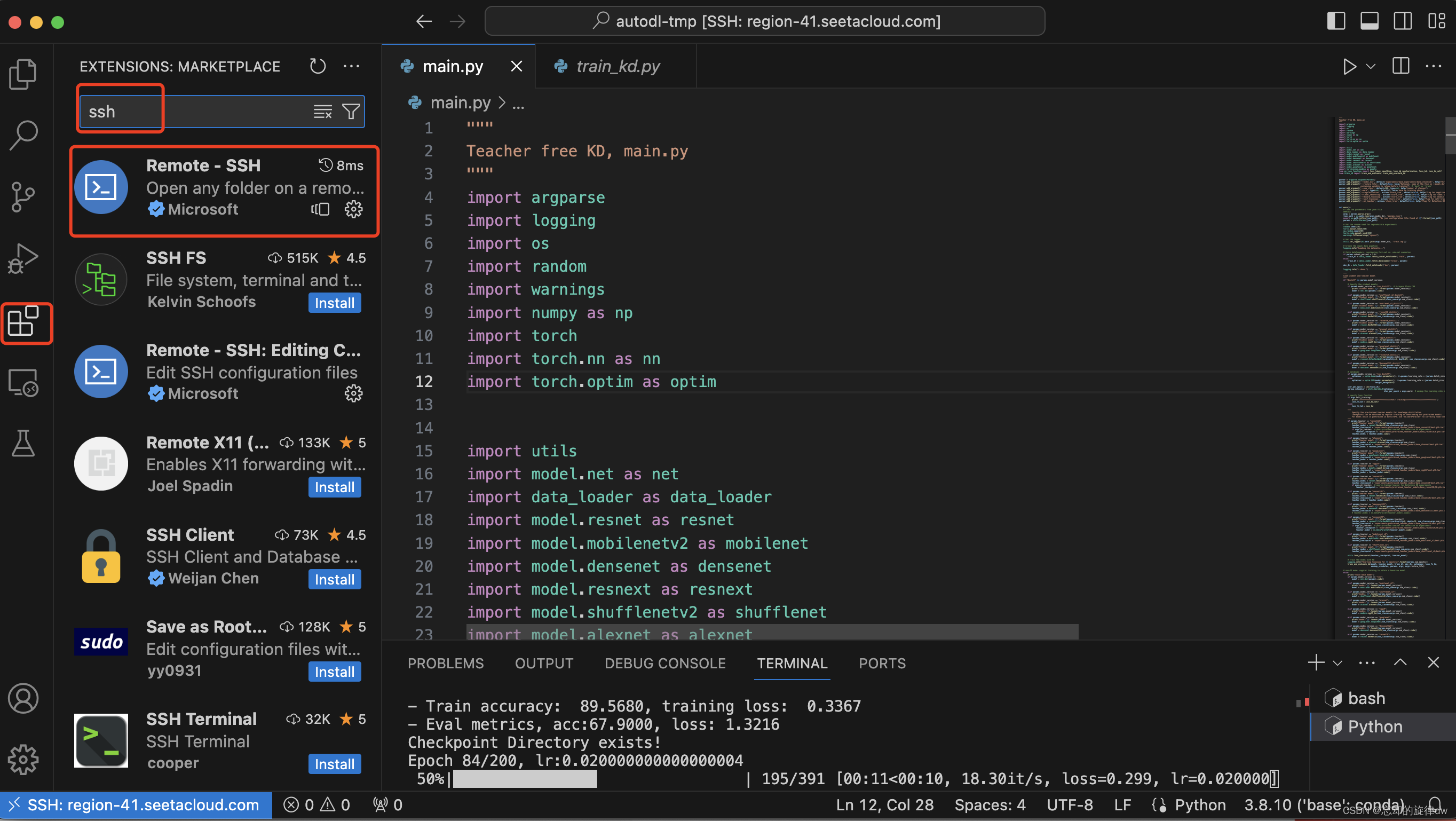

4、在VSCode里安装SSH插件并连接服务器

首先去插件市场里下载remote SSH插件

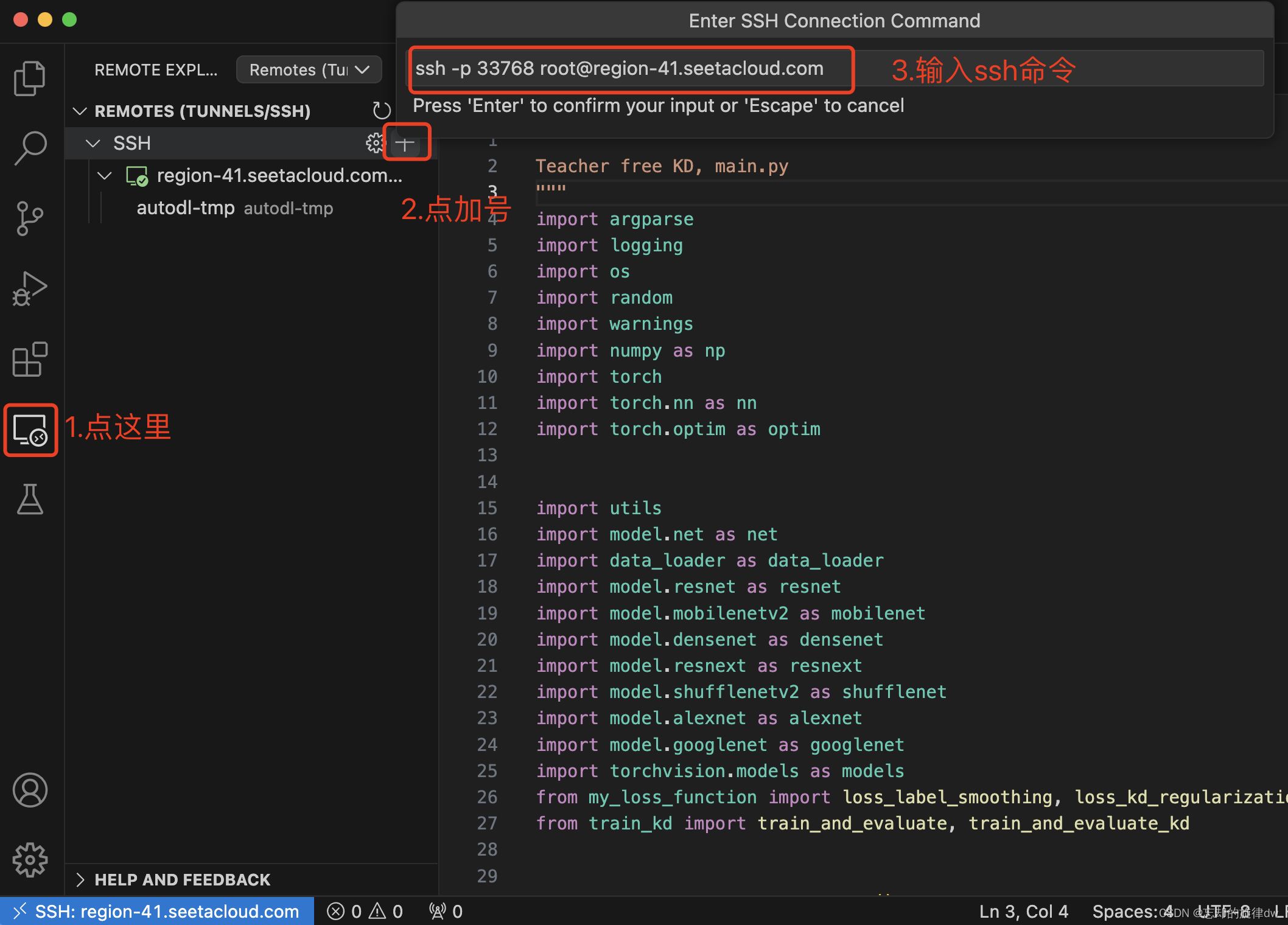

接着,打开这个插件,点击加号,在上面的空行中输入AutoDL的访问命令,就是那一串我们之前说过的命令,直接复制上去,然后回车

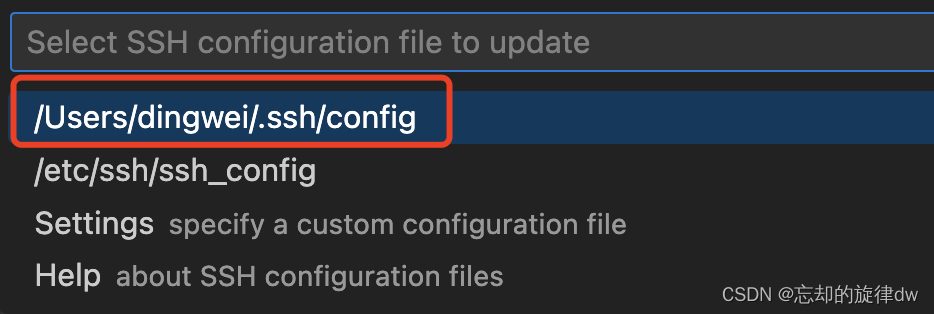

接着,它会让我们选择一个文件来保存我们的连接配置信息,不要多想,这只是便于它以后自动连接。点第一个就行

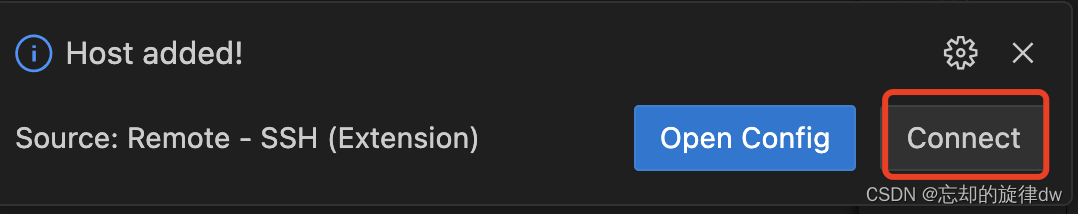

右下角会提示地址添加成功,点击连接即可,

点完之后,上面的空行会让我们输入一下密码。

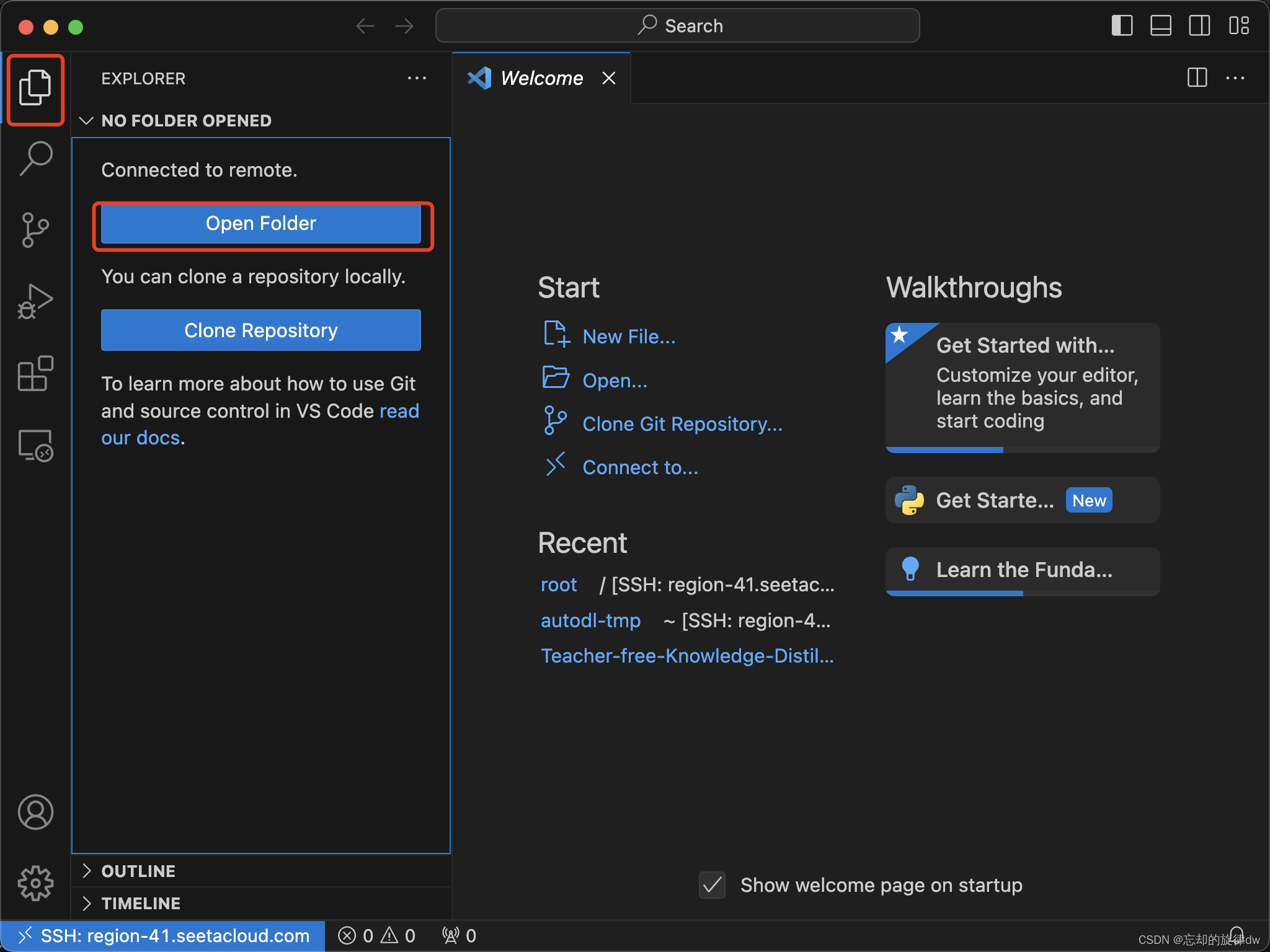

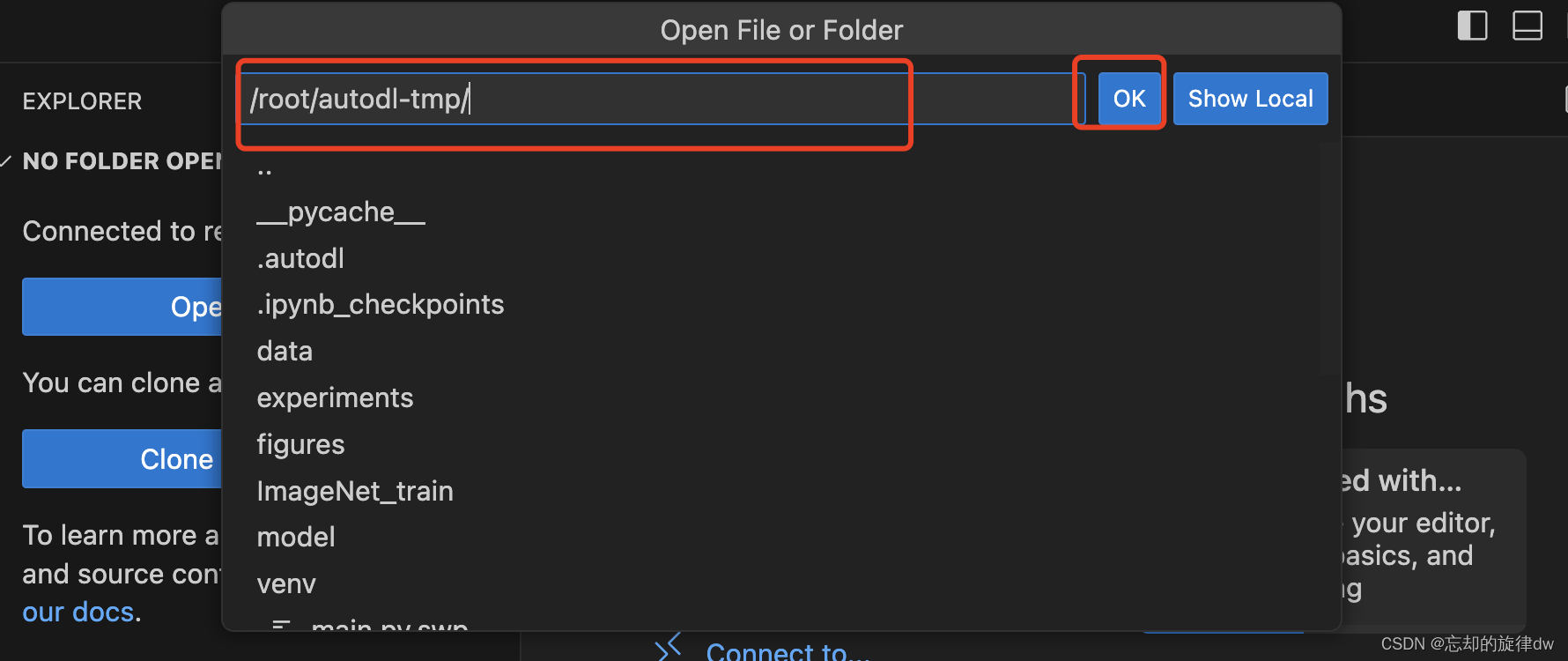

接着,打开我们刚才上传的项目文件。好像还要输入一次密码,如果有弹窗问你是否信任次项目,请点“Trust project”

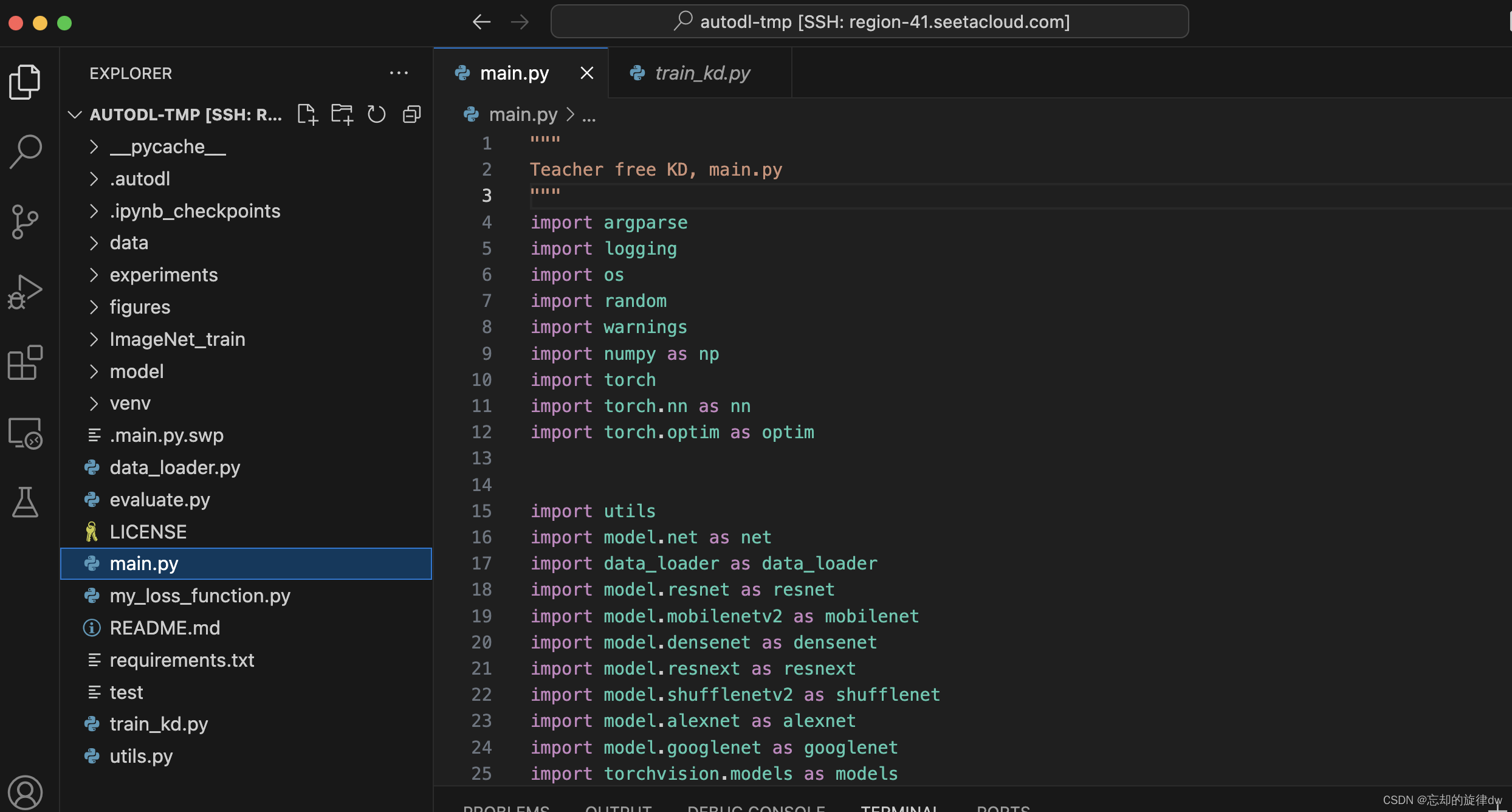

这就是我们的项目了:

5、运行我们的深度学习项目

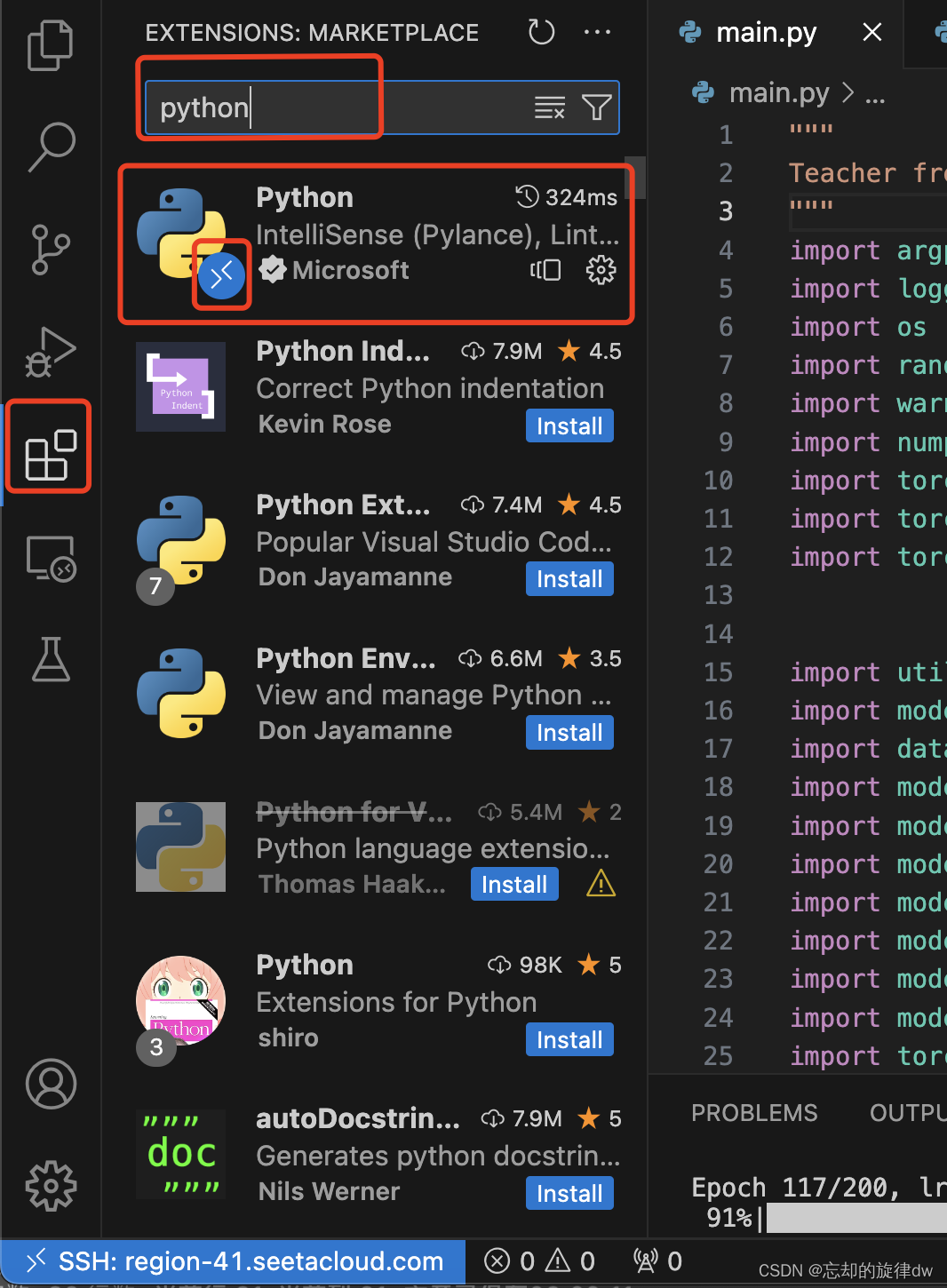

或许你会发现,你的vscode上并没有运行按钮,这是因为,你VSCODE没能识别服务器上这个文件是python项目(虽然你本地应该安装了python插件)。装一下即可(图标都带了一个SSH连接的表示)。

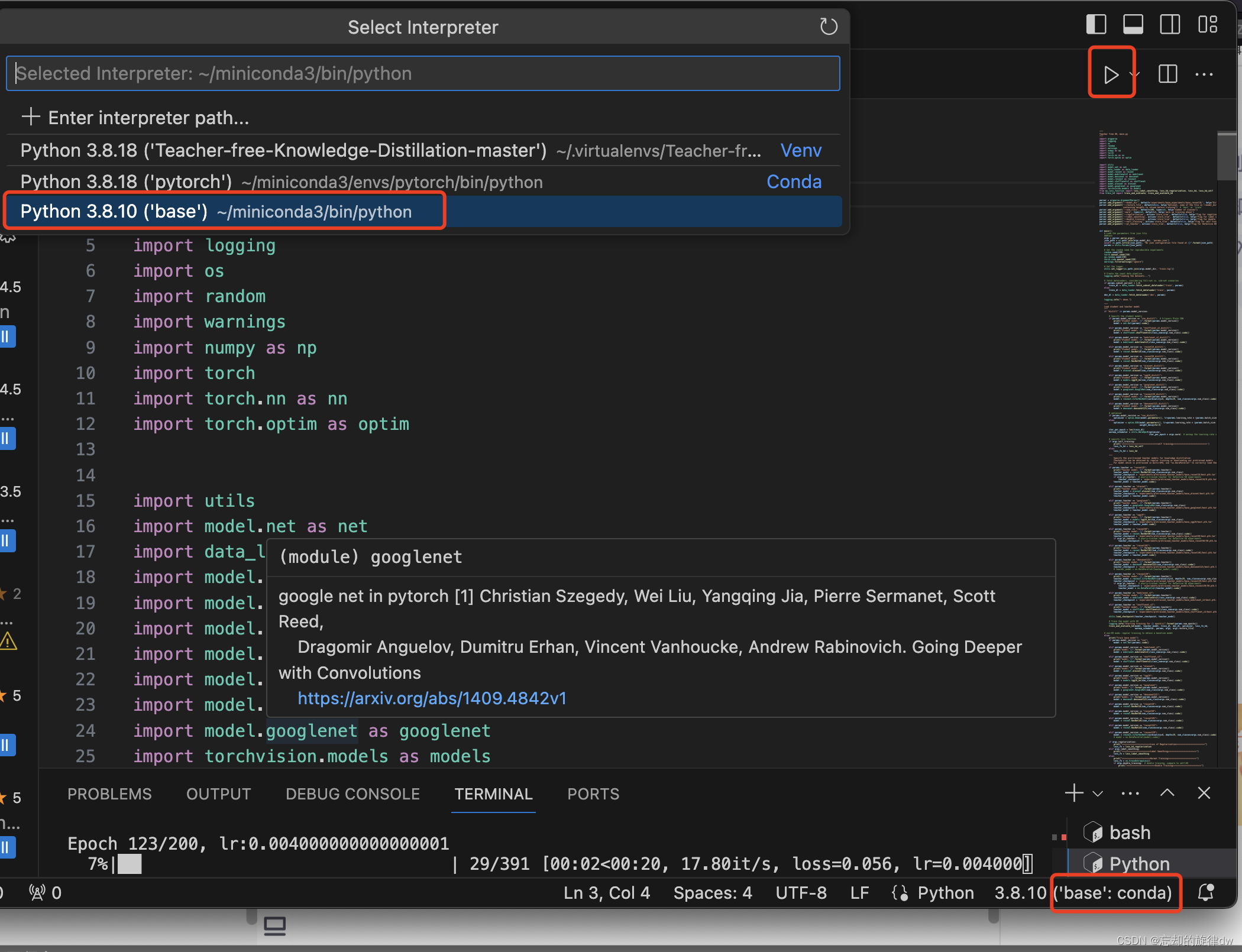

然后选择你的解释器,运行即可。

对了,不同的项目,也许环境不同,根据项目需要,用conda安装剩下所需的环境即可。(用上面所说的Jupyter中的命令行来装)而且如果你是“无显卡模式开机”的,重新带着GPU开机,不然咋跑啊!

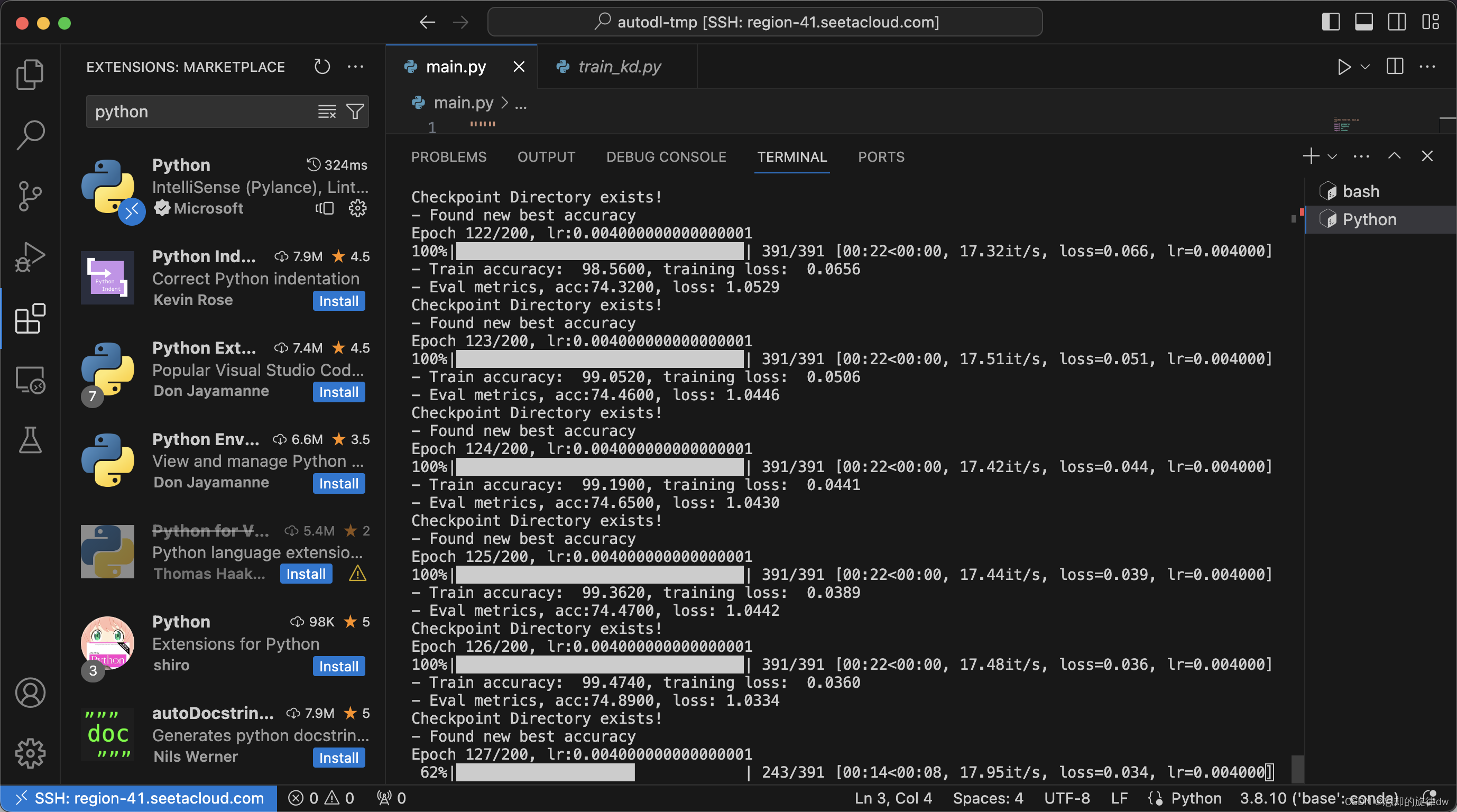

最终项目也是正常跑起来了:

版权归原作者 四进制 所有, 如有侵权,请联系我们删除。