安装hive前确保mysql已经安装Linux下安装mysql_mysql版本适配hdfs-CSDN博客

安装需要的文件链接:https://pan.baidu.com/s/1AnZanBBwa_hYjfxfuGmYgQ?pwd=wf06

提取码:wf06

1.解压配置环境变量

cd /opt/install_packages/

将需要的安装包 apache-hive-3.1.2-bin.tar.gz用MobaXterm拖进去

tar -zxvf apache-hive-3.1.2-bin.tar.gz -C /opt/softs/

cd /opt/softs/

mv apache-hive-3.1.2-bin/ hive3.1.2

配置环境变量

#HIVE_HOME

export HIVE_HOME=/opt/softs/hive3.1.2

export PATH=$PATH:$HIVE_HOME/bin

vim /etc/profile

把上面的内容粘贴进去

source /etc/profile

echo $HIVE_HOME 打印一下

2.处理一些jar包

将mysql驱动包放进hive里

cd /opt/softs/hive3.1.2/lib/

将mysql-connector-java-5.1.37.jar传输到 /opt/softs/hive3.1.2/lib/ 目录下

解决日志冲突

对og4j-slf4j-impl-2.10.0.jar改名使其失去作用

mv log4j-slf4j-impl-2.10.0.jar log4j-slf4j-impl-2.10.0.jar.bak

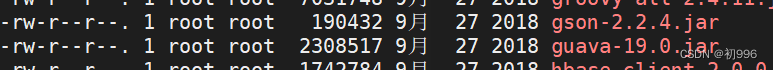

统一guava jar包版本

ll可以看到该目录下的 guava-19.0.jar 版本

/opt/softs/hadoop3.1.3/share/hadoop/common/lib 下也有 guava-27.0-jre.jar 该guava版本比hive里面的高,所以我们需要统一版本

---将hive下的该jar包改名使其失效

mv guava-19.0.jar guava-19.0.jar.bak

---将hadoop里的复制到hive里

cd /opt/softs/hadoop3.1.3/share/hadoop/common/lib

cp guava-27.0-jre.jar /opt/softs/hive3.1.2/lib/

cd /opt/softs/hive3.1.2/lib/

ll查看

修改hive配置文件

cd /opt/softs/hive3.1.2/conf/

这里已经将需要修改的配置文件放在链接里,可以自行下载,在本次修改完保存后再传输到linux上替换

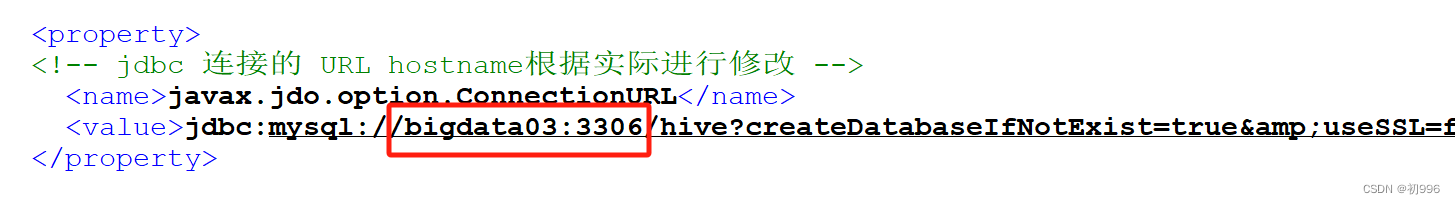

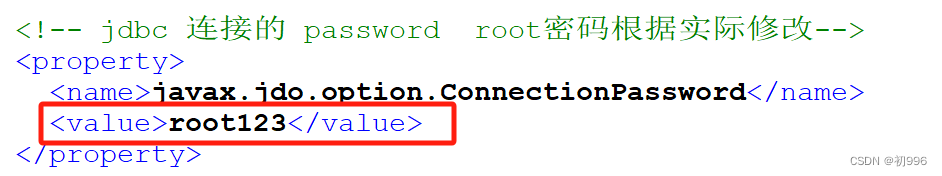

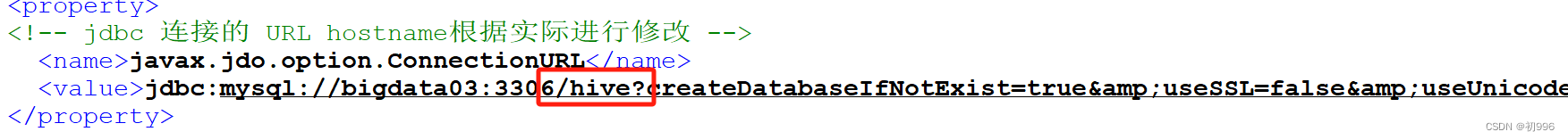

hive-site.xml

修改为自己的主机名

修改为自己的数据库密码

hive安装在哪台主机上就写哪个主机名

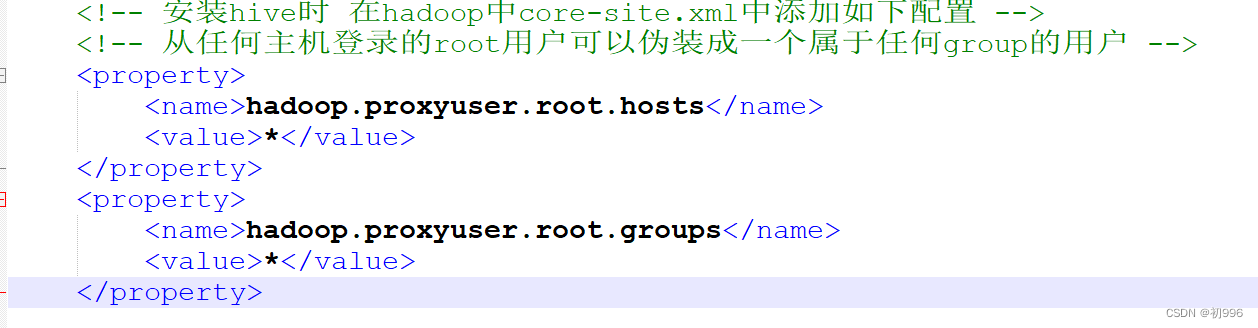

core-site.xml文件

需要将该文件的内容粘贴到hadoop下的core-site.xml文件下

cd /opt/softs/hadoop3.1.3/etc/hadoop/

vim core-site.xml

将上面的内容粘贴进去,然后给bigdata04,bigdata05也发送一份

scp core-site.xml root@bigdata04:/opt/softs/hadoop3.1.3/etc/hadoop/

scp core-site.xml root@bigdata05:/opt/softs/hadoop3.1.3/etc/hadoop/

发送完检查一下

hive初始化元数据库

---启动hdfs

start-dfs.sh

---检查一下节点启动是否有误

jps

---检查mysql是否启动 ,这里需要启动

systemctl status mysqld

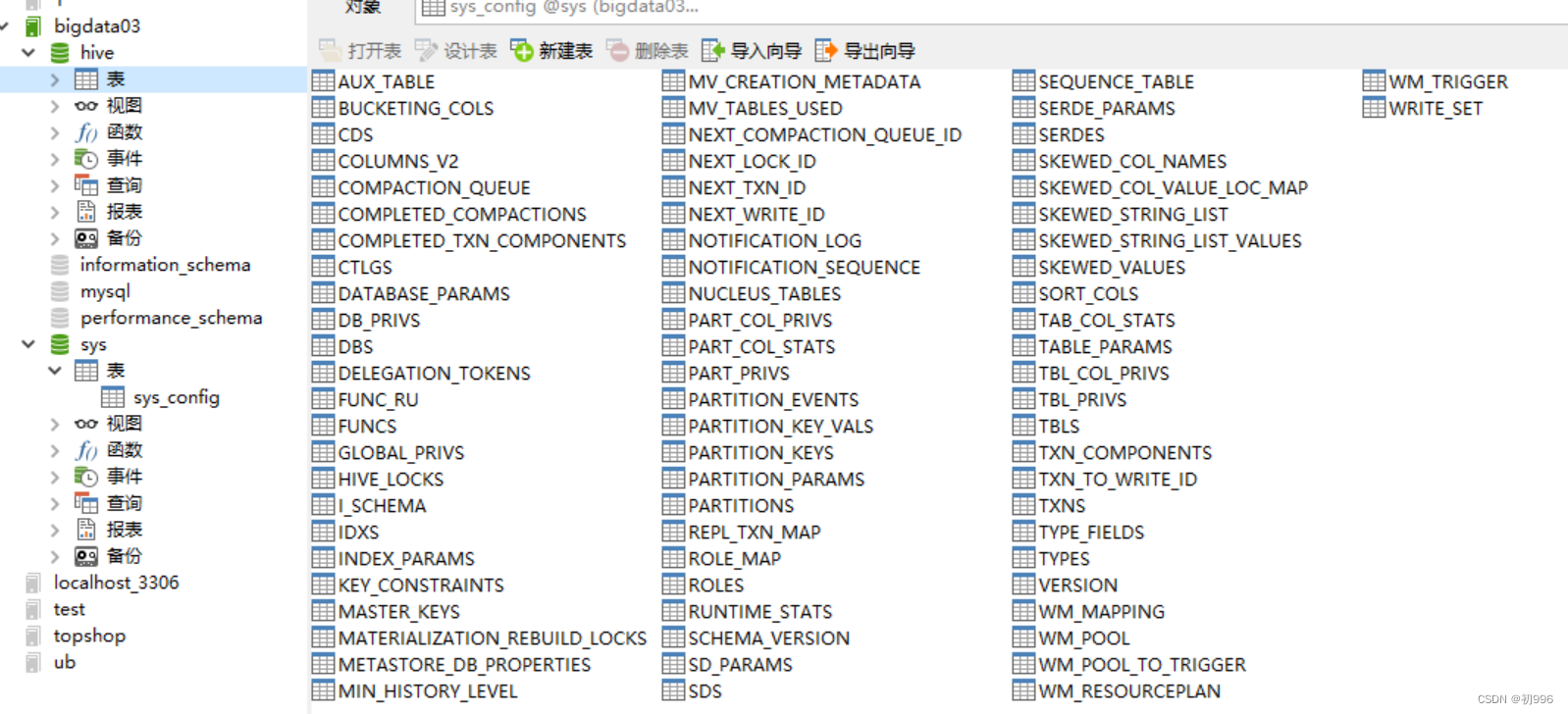

这里初始化后会创建 core-site.xml文件里写的配置的hive数据库

---初始化

schematool -dbType mysql -initSchema

显示初始化完成后可在Navicat下刷新一下,可看到hive数据库

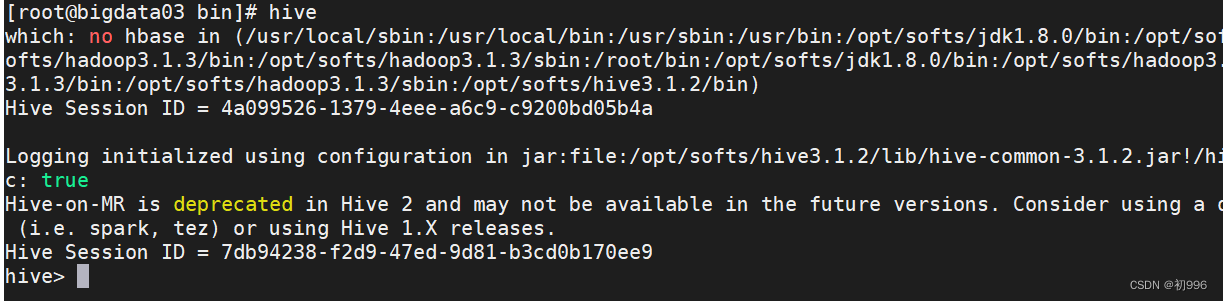

启动hive

输入 hive

启动完成,可Ctrl+c退出

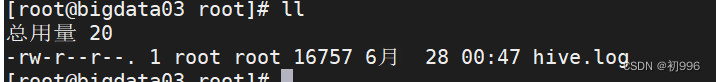

hive日志

想查看hive的日志

cd /tmp/root/

---查看500行

tail -500f hive.log

版权归原作者 初996 所有, 如有侵权,请联系我们删除。