本书涵盖了Docker和Kubernetes的基本概念及常用命令,以及Zookeeper、HDFS、YARN、YARN资源池、HBase、HBase集成Phoenix、Hive、Kafka、Spark、Flink等大数据技术的常用命令。

Zookeeper

安装kerberos客户端

yum install krb5-workstation -y

安装Zookeeper客户端

wget https://dlcdn.apache.org/zookeeper/zookeeper-3.6.3/apache-zookeeper-3.6.3-bin.tar.gz

解压

tar -zxvf apache-zookeeper-3.6.3-bin.tar.gz

启动zk服务端

./zkCli.sh -server zknode-4454-15044:2181

查看ls / 数据打印说明启动成功

HDFS

安装插件yum install -y wget

添加Hadoop客户端

解压tar -zxvf hadoop-3.2.4.tar.gz

将HDFS组件所在位置的hadoop文件拷贝到远程客户端

路径hadoop:/opt/hadoop/etc/hadoop

scp -r hadoop root@172.1.1.1:/root/Test02/Hadoop/hadoop/etc/

在拷贝到/etc/

登录账号kinit zuser01/test

输入密码:123456

主机上需具备jdk (zk\hadoop\hive\hbase都需要JDK环境)

修改环境配置

cat /etc/profile.d/my_env.sh

vim /etc/profile.d/my_env.sh

source /etc/profile

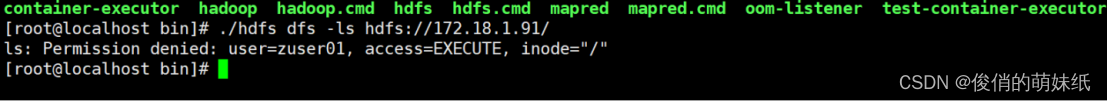

远程链接NameNode

./hdfs dfs -ls hdfs://172.18.1.91/

未配置策略时,会有相应提示无权限

远程创建文件

./hdfs dfs -mkdir hdfs://172.18.1.91/testHadoop

查看./hdfs dfs -ls hdfs://172.18.1.91/

创建文件 ./hdfs dfs -mkdir hdfs://172.18.1.91/testHadoop

上传文件

./hdfs dfs -put hadoop.txt hdfs://172.18.1.91/testHadoop

查看

./hdfs dfs -cat hadoop.txt hdfs://172.18.1.91/testHadoop/hadoop.txt

下载

./hdfs dfs -get hdfs://172.18.1.91/testHadoop/hadoop.txt

本地pod删除文件

hdfs dfs -rm -r /output2

YARN

查看

yarn application -list

写入

yarn jar /root/Test02/Hadoop/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.2.4-tests.jar TestDFSIO -write -nrFiles 10 -fileSize 1000

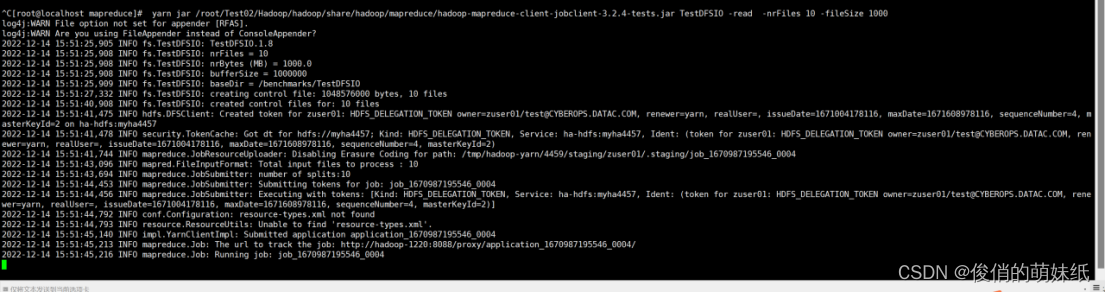

读取read

yarn jar /root/Test02/Hadoop/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.2.4-tests.jar TestDFSIO -read -nrFiles 10 -fileSize 1000

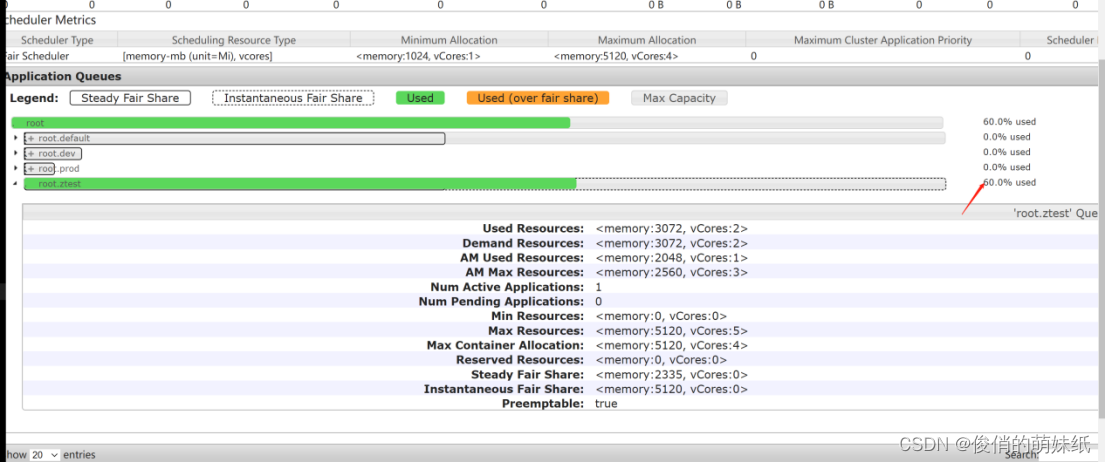

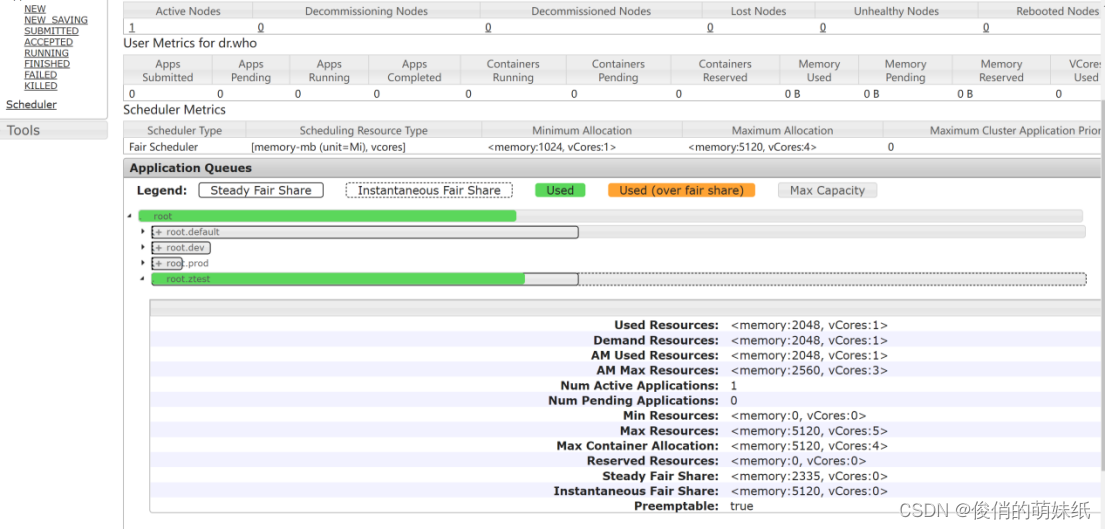

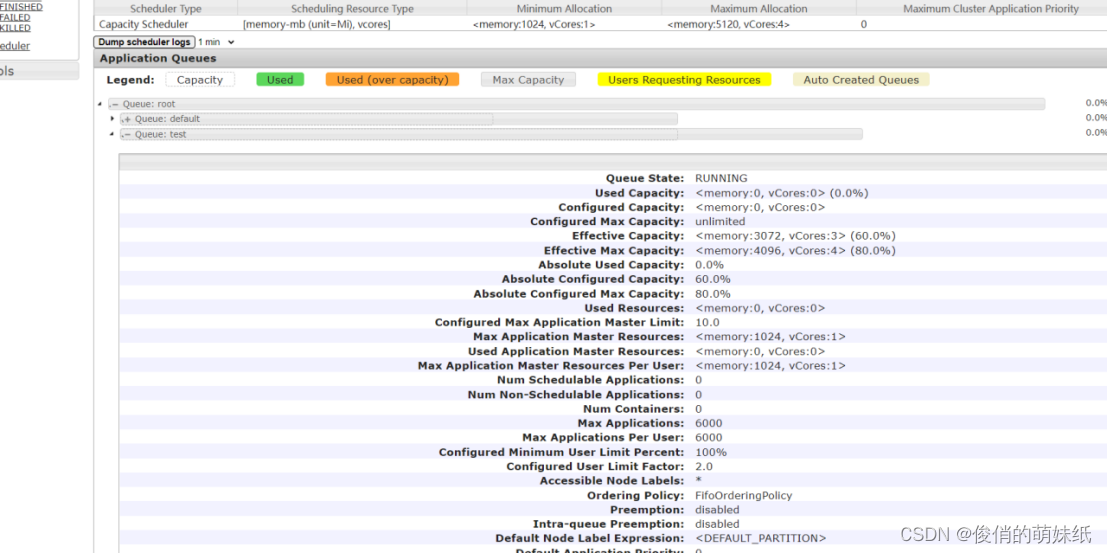

YARN资源池

进入yarn pod里面找到调度器配置

cd /opt/hadoop/etc/hadoop

查看默认队列信息

yarn queue -status default

创建文件并放入hdfs目录下

echo “hello yarn”>>yarnSche.txt

hdfs dfs -mkdir /yarnScheduler

hdfs dfs -put yarnSche.txt /yarnScheduler

FIFO策略不指定队列提交任务

yarn jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount /yarnScheduler/yarnSche.txt /output

任务执行成功,会在root.default中展示

FIFO策略指定队列提交任务

yarn jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount -D mapreduce.job.queuename=root.ztest /yarnScheduler/yarnSche.txt /output

更新下载 apt-get update

安装vim :yum -y install vim

修改配置文件的命令,不通过组件配置页面修改,通过xshell外部命令进行修改

docker inspect fe1

cat /etc/cyber-ops/YARN/3.2.4/ResourceManager/25020/capacity-scheduler.xml

Fair策略

不指定队列

yarn jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount /yarnScheduler/yarnSche.txt /outpu12

指定队列

yarn jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount -D mapreduce.job.queuename=root.ztest.eng /yarnScheduler/yarnSche.txt /outpu12

Drf策略

不指定队列

yarn jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount /yarnScheduler/yarnSche.txt /outpu10

指定队列

yarn jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount -D mapreduce.job.queuename=root.ztest /yarnScheduler/yarnSche.txt /outpu12

查看正在执行的队列

yarn application –list

删除队列

yarn application -kill application_1676515216453_0002

Capctity

不指定队列提交

yarn jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount /yarnScheduler/yarnSche.txt /outpu10

指定队列提交

yarn jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount -D mapreduce.job.queuename=root.test /yarnScheduler/yarnSche.txt /outpu12

HBase

apt-get update -y && apt-get install -y openssh-client 安装scp

连接bin/hbase shell

查看

list

创建表

create ‘zrtest’, ‘test’

插入

put ‘zrtest’,’1’,’test’,’zs’

查询

get ‘zrtest’,’1’

删除

delete ‘zrtest’,’1’,’test’

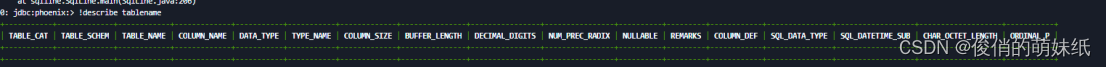

Hbase集成Phonenix

进入Hbase的终端bin下,操作phonenix

sqlline.py

查询表

!tables

!describe tablename可以查看表字段信息

创建表

create table “test”(

empid varchar primary key,

“name”.”firstname” varchar,

“name”.”lastname” varchar,

“company”.”name” varchar,

“company”.”address” varchar

);

查询表

select * from “test”;

查看表信息

!table “test”

插入数据

UPSERT INTO “test”(“EMPID”,”firstname”,”lastname”,”name”,”addres”) VALUES(‘1’,’foo’,’zr’,’zrgg’,’123hao’);

更新数据

UPSERT INTO “test”(“EMPID”,”firstname”,”lastname”,”name”,”addres”) VALUES(‘1’,’fee’,’zr’,’zrgg’,’123hao’);

翻页查询

select * from “test” order by EMPID desc limit 1 offset 0;

删除表信息

delete from “test” where “EMPID”=’1’;

在Hbase中查看Phoenix的表信息

List

scan ‘test’

删除表

drop table “test”;

在Hbase中创建表

create ‘phoenix’,’info’

插入数据

put ‘phoenix’, ‘row001’,’info:name’,’phoenix’

put ‘phoenix’, ‘row002’,’info:name’,’hbase’

phoenix下创建视图映射HBase表

create view “phoenix” (

pk VARCHAR primary key,

“info”.”name” VARCHAR

);

查询,数据已可查到

select * from “phoenix”;

Hive

安装远程客户端

wget https://dlcdn.apache.org/hive/hive-3.1.2/apache-hive-3.1.2-bin.tar.gz

解压

tar -zxvf apache-hive-3.1.2-bin_(1).tar.gz

beenline连接时,根据hive-site中的principal进行连接

beeline -u “jdbc:hive2://172.18.1.1:30862/;24695@CYBEROPS.DATAC.COM" rel="nofollow"">principal=hive/haproxy-5487-24695@CYBEROPS.DATAC.COM“

查看

show databases;

创表

create table zhvie(id int ,name string);

查表

select * from zhvie;

插入表

insert into zhvie values(1,’zhangsan’);

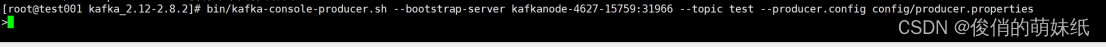

Kafka

下载kafka客户端

wget https://archive.apache.org/dist/kafka/2.8.2/kafka_2.12-2.8.2.tgz

安装客户端

tar -zxvf kafka_2.12-2.8.2.tgz

查看list

bin/kafka-topics.sh –list –bootstrap-server kafkanode-4627-15759:31966 –command-config config/consumer.properties

创建

bin/kafka-topics.sh –bootstrap-server kafkanode-4627-15759:31966 –create –topic first –partitions 2 replication-factor 3 –command-config config/producer.properties

删除topic 单个

bin/kafka-topics.sh –bootstrap-server kafkanode-4627-15759:31966 –delete –topic zutesttp –command-config config/consumer.properties

删除多个

bin/kafka-topics.sh –bootstrap-server kafkanode-4627-15759:31966 –delete –topic zutes,hkaft –command-config config/consumer.properties

修改

bin/kafka-topics.sh –bootstrap-server kafkanode-4627-15759:31966 –alter –topic first –partitions 1 replication-factor 2 –command-config config/producer.properties

查看每一个topic详情

bin/kafka-topics.sh –bootstrap-server kafkanode-4627-15759:31966 –describe –topic first –command-config config/producer.properties

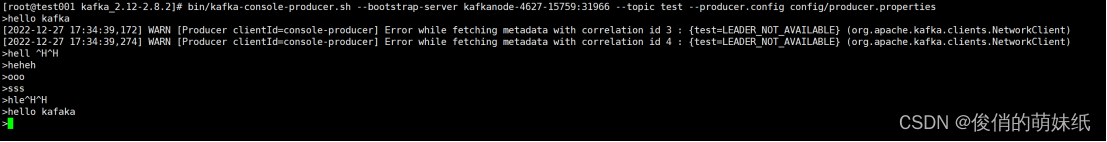

生产消息

bin/kafka-console-producer.sh –bootstrap-server kafkanode-4627-15759:31966 –topic zuser01 –producer.config config/producer.properties

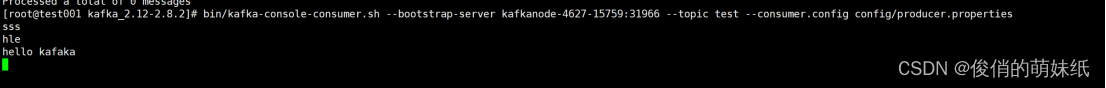

当生产者填写数据后,消费者可看到发送的消息

消费消息

bin/kafka-console-consumer.sh –bootstrap-server kafkanode-4627-15759:31966 –topic zuser01 –consumer.config config/producer.properties

查看之前发送的所有消息

bin/kafka-console-consumer.sh –bootstrap-server kafkanode-4627-15759:31966 –topic zuser01 –from-beginning –consumer.config config/producer.properties

Spark

下载客户端

wget https://archive.apache.org/dist/spark/spark-3.2.2/spark-3.2.2-bin-hadoop3.2.tgz

解压

tar -zxvf spark-3.2.2-bin-hadoop3.2.tgz

spark提交任务,任务从hdfs中获取jar包文件,然后执行jar文件

spark-submit -v –deploy-mode cluster –class org.apache.spark.examples.SparkPi –master yarn hdfs:///spark-examples_2.12-3.2.2.jar 1

Flink

下载客户端

wget https://archive.apache.org/dist/flink/flink-1.13.6/flink-1.13.6-bin-scala_2.12.tgz

解压

tar -zxvf flink-1.13.6-bin-scala_2.12.tgz

安装scp插件

升级版本apt update && apt install -y libtinfo5 –allow-remove-essential

apt-get update -y && apt-get install -y openssh-client 安装scp

在本地pod中执行任务

flink run examples/batch/WordCount.jar

停止yarn session

echo “stop” | yarn-session.sh -id application_1678335961951_0003

强制杀死yarn session

yarn application -kill application_1678335961951_0003

向指定yarn session提交任务:

flink run -t yarn-session -Dyarn.application.id=application_1678335961951_0003 examples/batch/WordCount.jar

flink run examples/batch/DistCp.jar –input hdfs:///LICENSE –output hdfs:///ddd

Docker和K8s操作命令

docker命令相关————————-

docker ps【列出docker下的容器列表】

yum -y remove docker-ce 【卸载docker】

docker ps

ps -ef | grep agent

docker ps【列出docker下的容器列表】

cd .ssh/【进入到.ssh文件下 目录 /root/.ssh】

ll【查看数据信息】

cat authorized_keys【查看公钥】

ssh root@172.1.1.1

ctrl+d 登出

pwd【查看目录信息】

hostname【查看主机名称】

docker logs –tail=500 -f 21d6bb5052e2【查看日志信息 21d6bb5052e2是CONTAINER ID的标识】

ctrl +c 【退出查看日志】

docker exec -it 21d6bb5052e2 bash 【进入到组件的终端 21d6bb5052e2是CONTAINER ID的标识】

docker stats 【查看资源使用情况】

docker search centos 【查看下载stars最多的镜像】

yum install -y lrzsz 【安装插件】

docker命令相关————————-结束———————

k8s命令相关——————-开始—————————

-n 后跟k8s命名空间信息

kubectl -h 【查看具体操作参数】

kubectl get nodes 【获取节点信息】

kubectl get pods【获取节点信息】

kubectl cluster-info【查看集群信息】

kubectl get pods -n cyberops-l8nc 【查看各组件信息 cyberops-l8nc 是K8s命名空间】

kubectl get pods -o wide 【查看pods所在的运行节点】

kubectl get pods -o yaml【查看pods定义的详细信息】

kubectl exec pod-hs-2853-13904 env -n cyberops-l8nc 【查看pods环境变量】

kubectl exec pod-hs-2853-13904 env -n cyberops-l8nc | grep HADOOP 【查看hadoop信息】

kubectl describe pod pod-hs-2853-13904 -n cyberops-l8nc 【查看pod应用信息】

kubectl describe node master-01 【查看node节点日志信息】

kubectl logs –tail 200 -f pod-hs-2853-13904 -n cyberops-l8nc 【查看日志信息】

kubectl logs –since=1h pod-hs-2853-13904 -n cyberops-l8nc【查看pod近一个小时的日志信息】

kubectl exec -it pod-hs-2853-13904 bash -n cyberops-l8nc 【进入到组件的终端】

kubectl get service【查看命名空间】

kubectl get pods -n cyber-ops【查看ops下服务】

kubectl exec -it cyberops-web-5f546758b5-lmsdm bash -n cyber-ops 【免密进入ops-web服务】

kubectl get pods -A 【查看所有在k8s运行的集群】或者 kubectl get all

kubectl get pods -A -owide 【查看详细信息】

kubectl get ns 【查看所有的命名空间】或者 kubectl get namespaces

kubectl get pod –show-labels 【查看标签信息】

kubectl get node、kubectl get nodes【查看节点信息】

kubectl get pods -o wide 【查看pod运行的ip地址】

kubectl get pod –all-namespaces【查看所有pod的所属命名空间】

kubectl get pod –all-namespaces -o wide 【查看命名空间和运行节点】

kubectl get rs 【查看副本pod节点】

kubectl get ev | tail -n 10 【查看事件】

kubectl explain rs【查看资源文档信息】

kubectl top nodes【查看node资源使用情况】

kubectl –help【查看帮助文档】

kubectl version【查看版本号,详细】或者 kubectl version –short 【简约】

ls -a 【查看隐藏文件】

kubectl logs –tail 500 -f cyberops-web-7fc98fddcb-hk7h7 -n cyber-ops 【查看ops项目下的日志信息】

kubectl get pods -n 【k8s空间名】 -w【监控组件安装】

kubectl get events -n cyberops-s97d 【查看k8s下的组件安装信息】

kubectl get pods,svc -n cyberops-s97d 【查看端口信息】

版权归原作者 俊俏的萌妹纸 所有, 如有侵权,请联系我们删除。