问题:进行相关配置后,发现集群DataNode无法启动

解决步骤:

- 查看日志文件,显示报错:

java.io.IOException: All specified directories have failed to load.

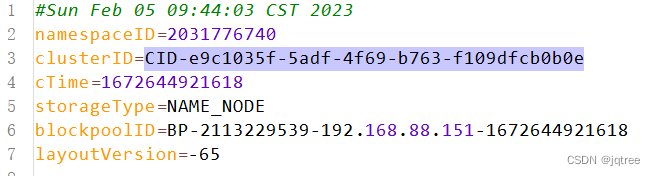

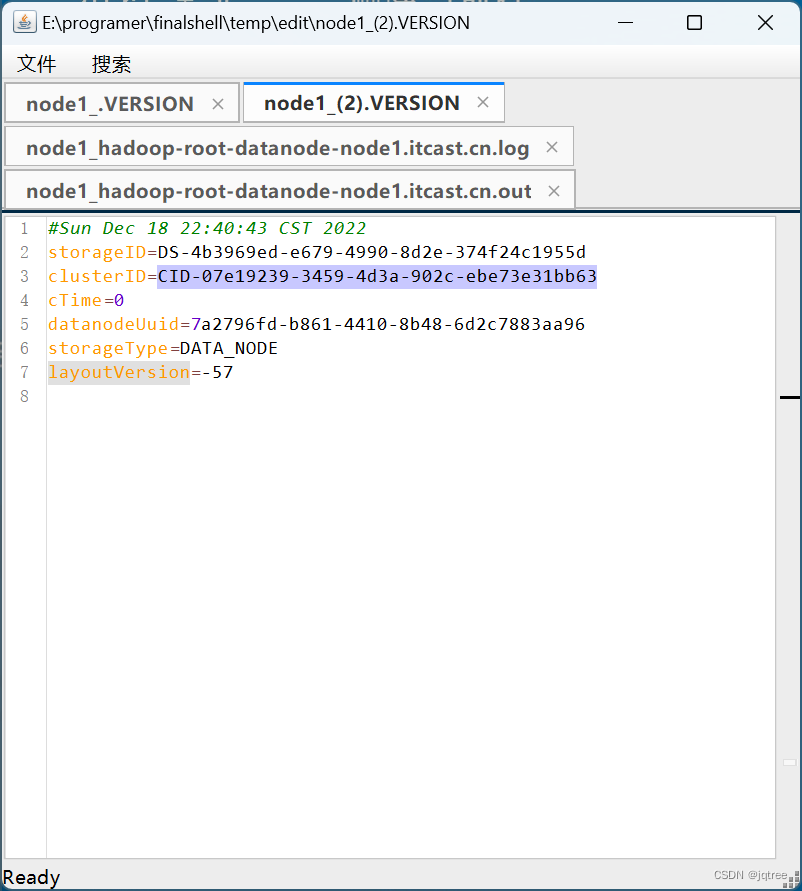

- 错误原因:datanode和namenode的clusterID不同,导致无法启动datanode。通常是多次格式化导致的这个问题. 注:找到datanode和namenode数据存储文件中current文件夹,查看VERSION文件,可以发现他们的clusterID不同(数据存储路径可在hdfs-site.xml文件中查看,以个人实际为准)。

- 将datanode中clusterID替换为namenode中clusterID,注意所有主机都需要替换。

- 替换成功后,即可正常启动datanode,亲测。

这只是解决方法之一,另外一个解决方法是,删除hadoop配置文件core-site.xml中指定的缓存数据路径文件夹,然后进行格式化操作,格式化之前请保留数据备份,谨防丢失。这个方法本人没有实践,感兴趣的读者可搜索相关文章尝试解决。

格式化命令:

hdfs namenode -format

格式化操作需谨慎,运行指令前请三思!

本文转载自: https://blog.csdn.net/help_child/article/details/128889022

版权归原作者 jqtree 所有, 如有侵权,请联系我们删除。

版权归原作者 jqtree 所有, 如有侵权,请联系我们删除。