(一)HDFS命令操作实战

1、启动Hadoop集群

2、创建单层目录,执行命令:hdfs dfs -mkdir /ied

使用Hadoop WebUI查看创建的单层目录

3、创建多层目录

执行命令:**

hdfs dfs -mkdir -p /luzhou/lzy

**

使用Hadoop WebUI查看创建的多层目录

4、查看目录

执行命令:**

hdfs dfs -ls /

**,查看根目录

执行命令:**

hdfs dfs -ls /luzhou

**

如果我们要查看根目录里全部的资源,那么要用到地柜参数

**-R**,

执行命令:**

hdfs dfs -ls -R /

**,递归查看

/

目录

5、下载HDFS文件到本地

先删除本地的test.txt文件

执行命令:**

hdfs dfs -get /ied/test.txt

**

查看文件是否下载成功

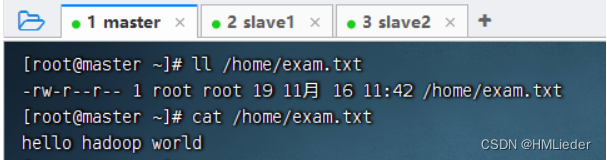

可以将HDFS上的文件下载到本地指定位置,并且可以更改文件名

执行命令:**

hdfs dfs -get /ied/test.txt /home/exam.txt

**

检查文件是否下载成功

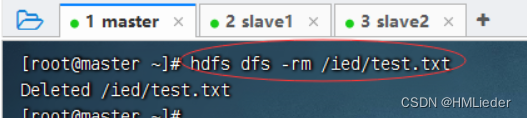

6、删除HDFS文件

执行命令:**

hdfs dfs -rm /ied/test.txt

**

检查是否删除成功

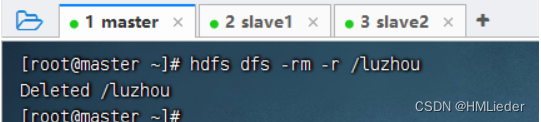

7、删除HDFS目录

执行命令:**

hdfs dfs -rmdir /luzhou

,但是提示

-rmdir

**命令删除不了非空目录。

所以要递归删除才能删除非空目录:**

hdfs dfs -rm -r /luzhou

**(-r:recursive)

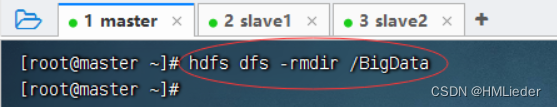

删除空目录**

/BigData

,执行命令:

hdfs dfs -rmdir /BigData

**

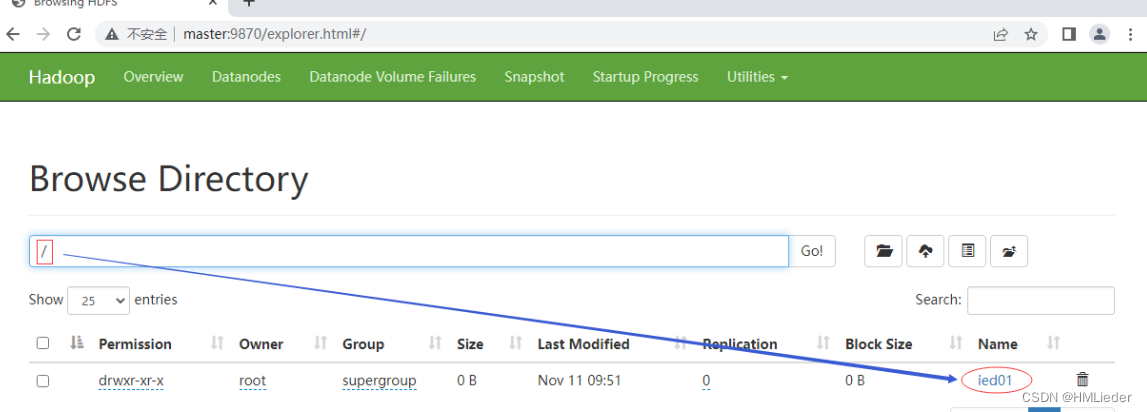

8、移动目录或文件夹

将**

/ied

目录更名为

/ied01

,执行命令:

hdfs dfs -mv /ied /ied01

**

利用Hadoop WebUI查看是否更名成功

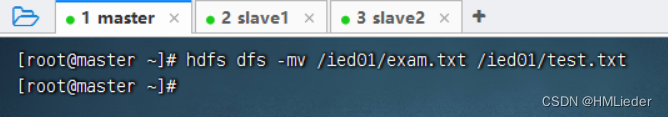

将**

/ied01/exam.txt

更名为

/ied/test.txt

**,执行命令:

**hdfs dfs -mv /ied01/exam.txt****/ied01/test.txt**

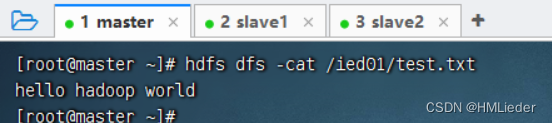

查看改名后的**

test.txt

**文件内容

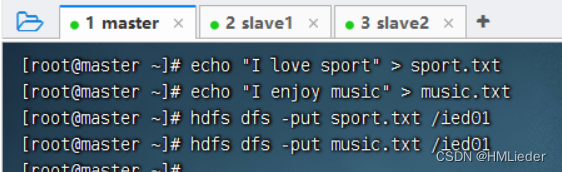

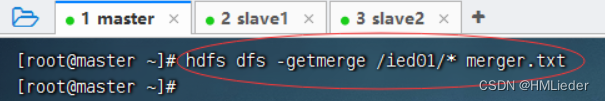

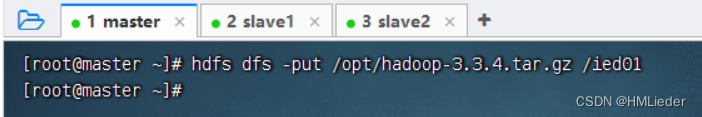

9、文件合并下载

现在**

/ied01

里有一个

test.txt

,创建

sport.txt

和

music.txt

**并上传

合并**

/ied01

目录的文件下载到本地当前目录的

merger.txt

,执行命令:

hdfs dfs -getmerge /ied01/* merger.txt

**

查看本地的**

merger.txt

**,看是不是三个文件合并后的内容

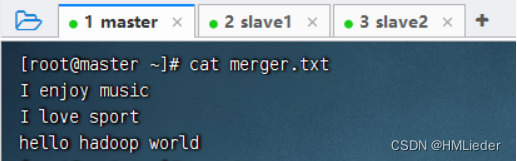

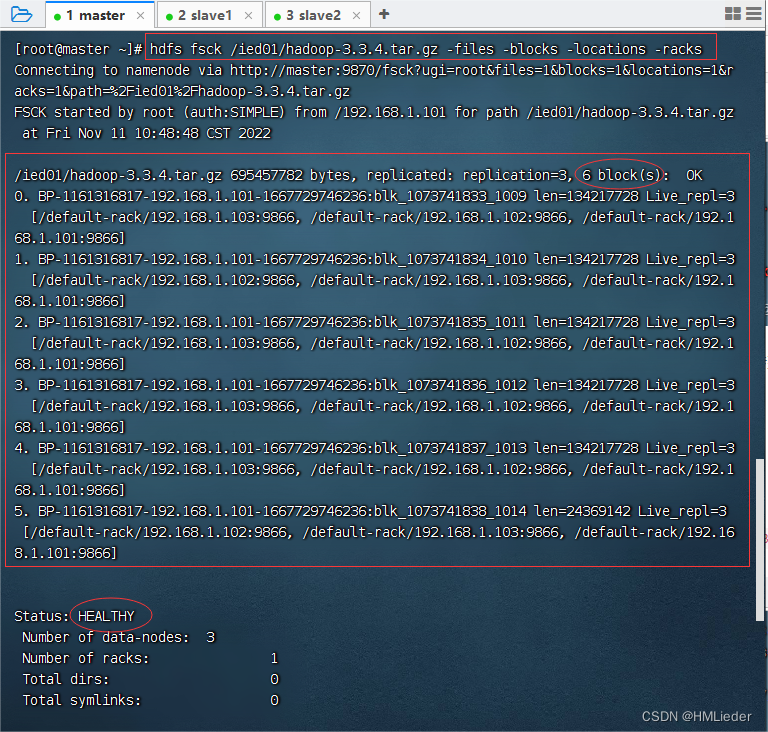

10、检查文件信息

检查**

test.txt

文件,执行命令:

hdfs fsck /ied01/test.txt -files -blocks -locations -racks

**

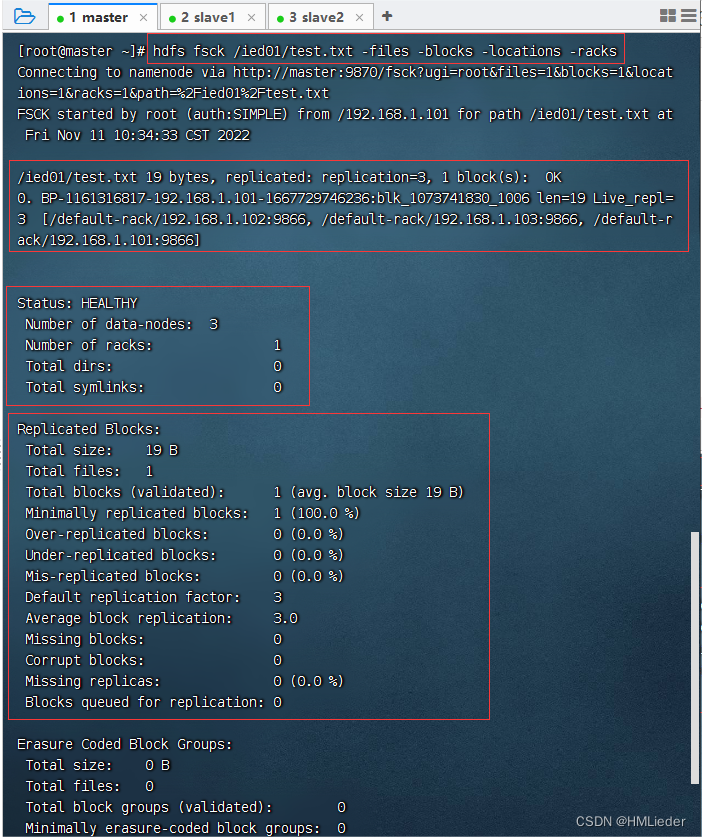

执行命令:**

hdfs dfs -put /opt/hadoop-3.3.4.tar.gz /ied01

,将hadoop压缩包上传到HDFS的

/ied01

**目录

查看HDFS上**

hadoop-3.3.4.tar.gz

文件信息,执行命令:

hdfs fsck /ied01/hadoop-3.3.4.tar.gz -files -locations -racks

**

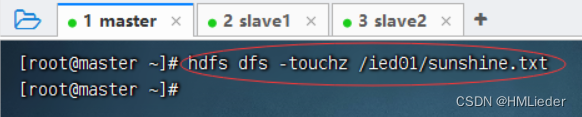

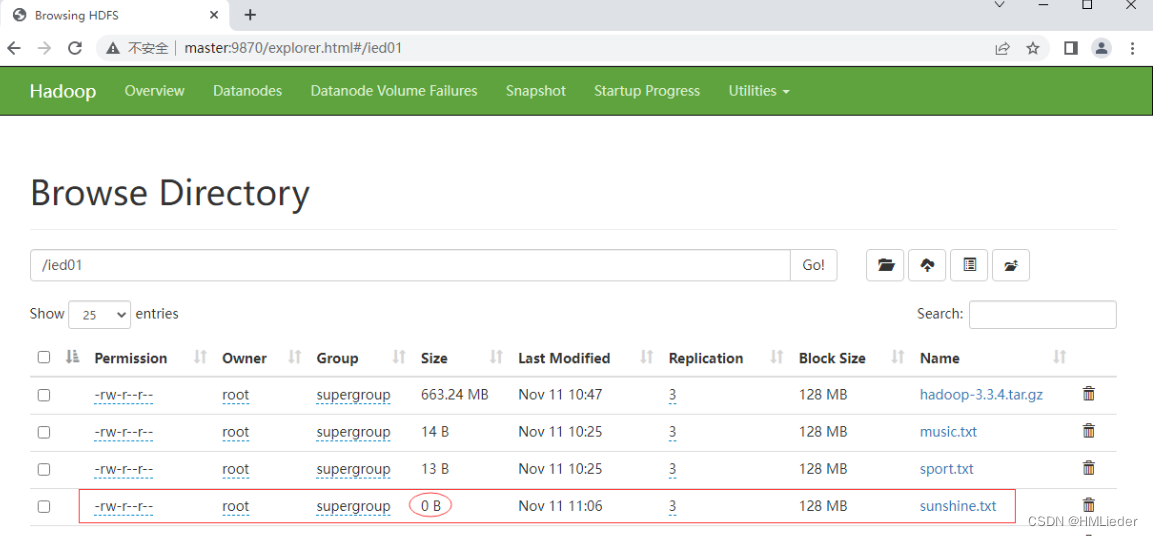

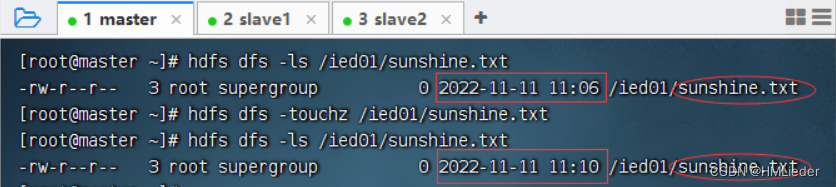

11、创建时间戳文件

创建的是一个空文件,大小为

0

字节

这种空文件,一般用作标识文件,也可叫做时间戳文件,再次在**

/ied01

目录下创建

sunshine.txt

**同名文件

12、复制文件或目录

准备工作:创建**

/ied02

**目录

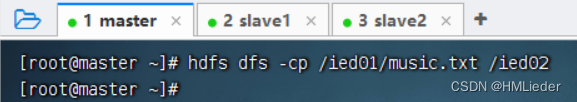

1、同名复制文件

将**

/ied01/music.txt

复制到

/ied02

里,执行命令:

hdfs dfs -cp /ied01/music.txt /ied02

**

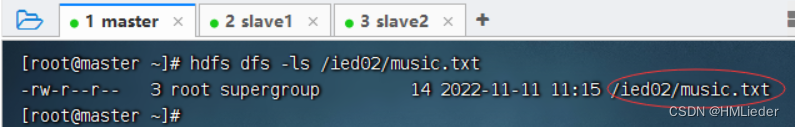

查看拷贝生成的文件

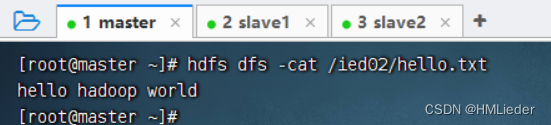

2、改名复制文件

将**

/ied01/test.txt

复制到

/ied02

目录,改名为

hello.txt

,执行命令:

hdfs dfs -cp /ied01/exam.txt /ied02/hello.txt

**

查看拷贝后的文件内容

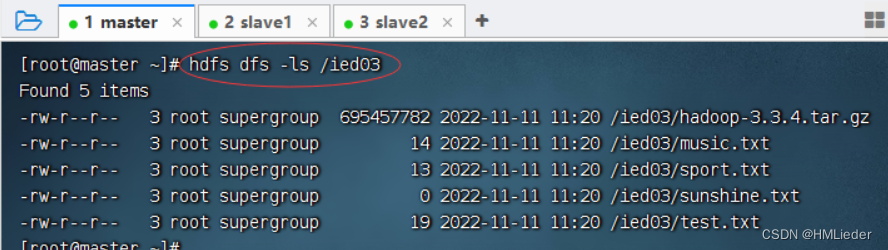

3、复制目录

将**

/ied01

目录复制到

/ied03

目录,执行命令:

hdfs dfs -cp /ied01 /ied03

**

查看拷贝后的目录

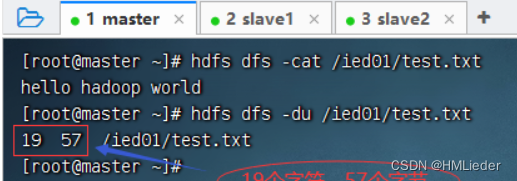

13、查看文件大小

- 执行命令:**

hdfs dfs -du /ied01/test.txt**

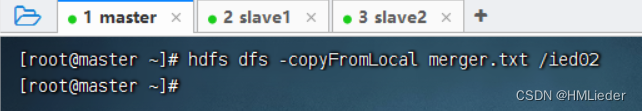

14、上传文件

**

-copyFromLocal

类似于

-put

,执行命令:

hdfs dfs -copyFromLocal merger.txt /ied02

**

查看是否上传成功

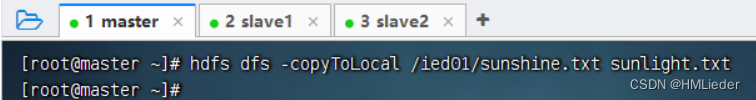

15、下载文件

**

-copyToLocal

类似于

-get

,执行命令:

hdfs dfs -copyToLocal /ied01/sunshine.txt sunlight.txt

**

检查文件是否下载成功

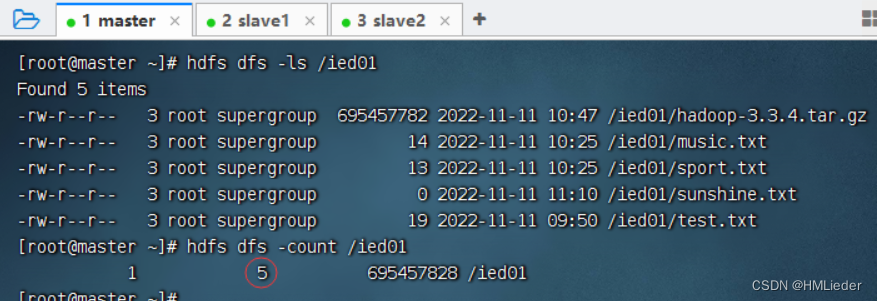

16、查看某目录下文件个数

执行命令:**

hdfs dfs -count /ied01

**

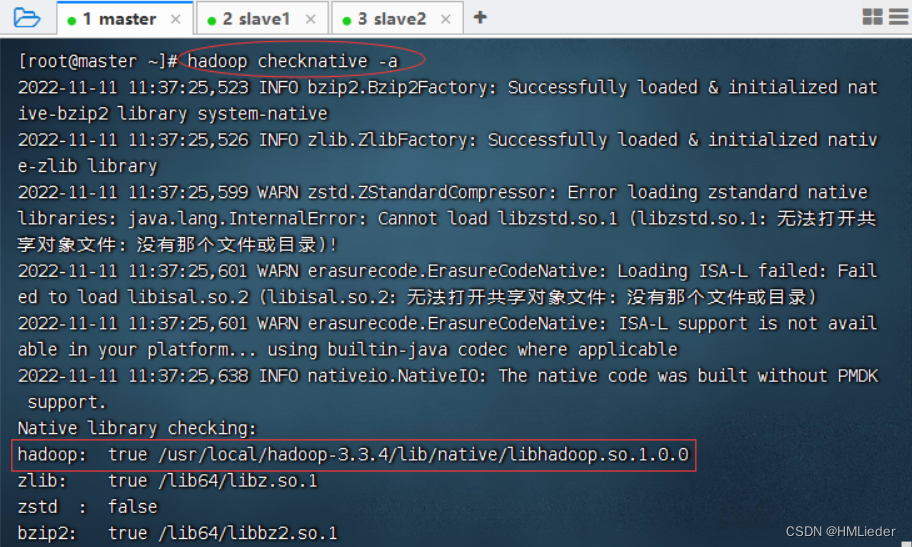

17、检查Hadoop本地库

-执行命令:**

hdfs checknative -a

**

查看hadoop本地库文件

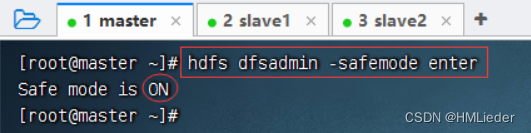

18、进入和退出安全模式

1、进入安全模式

执行命令:**

hdfs dfsadmin -safemode enter

**, 注意:进入安全模式之后,只能读不能写

2、退出安全模式

版权归原作者 HMLieder 所有, 如有侵权,请联系我们删除。