百度ERNIE(支持requests接口)

ERNIE Speed、ERNIE Lite免费

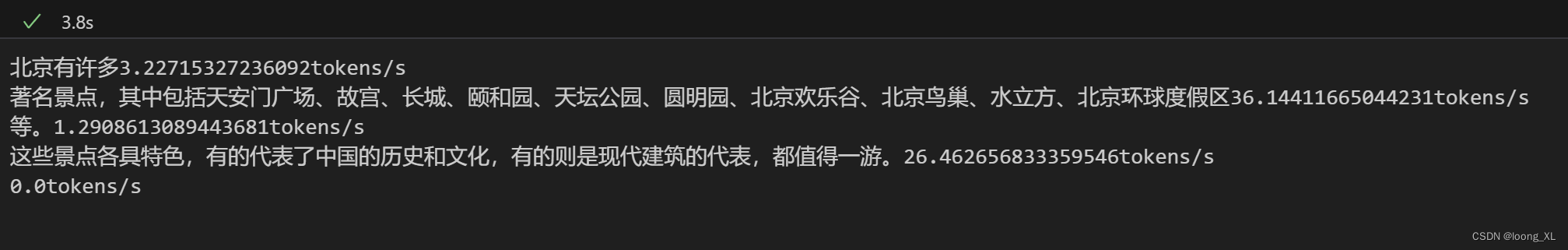

免费测试下来模型ernie_speed输出吞吐量计算20-30来个,“{length/cost} tokens/s” 输出总长度/耗时

https://qianfan.cloud.baidu.com/

文档:

https://cloud.baidu.com/doc/WENXINWORKSHOP/s/dltgsna1o

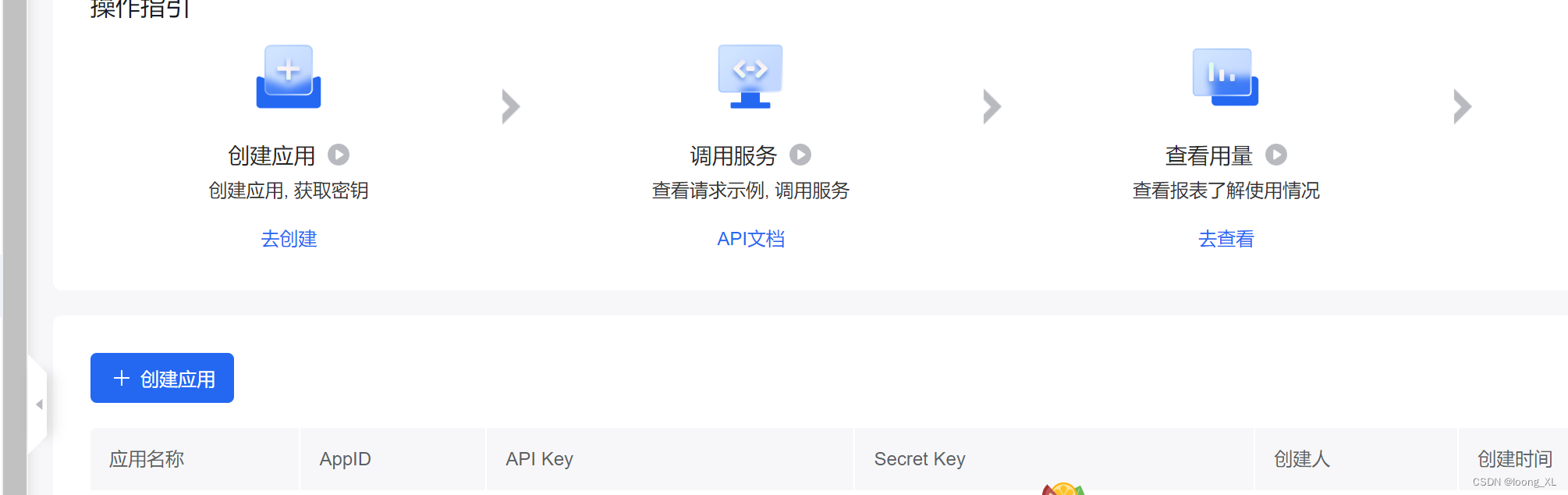

apikey获取:

https://console.bce.baidu.com/qianfan/ais/console/applicationConsole/application

创建应用即可获取key

代码:

json.loads 报错:json loads raise JSONDecodeError(

版权归原作者 loong_XL 所有, 如有侵权,请联系我们删除。