文章目录

集群其它生态安装与配置:

- Hadoop 完全分布式搭建(超详细)

- Hive 搭建(将 MySQL 作为元数据库)

- Spark 集群搭建(多种方式)

- Hudi 0.12.0 搭建——集成 Hive3.1 与 Spark3.2

1.下载

Sqoop 安装包下载地址:Sqoop 官网

选择自己集群合适的版本。

2.解压

tar-zxvf sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz -C /opt/module/

改个名称:

cd /opt/module

mv sqoop-1.4.7.bin__hadoop-2.6.0/ sqoop-1.4.7

3.添加环境变量

vi /etc/profile

# 在文件末尾添加#SQOOP_HOMEexportSQOOP_HOME=/opt/module/sqoop-1.4.7

exportPATH=$PATH:$SQOOP_HOME/bin

保存退出,使环境变量立即生效

source /etc/profile

。

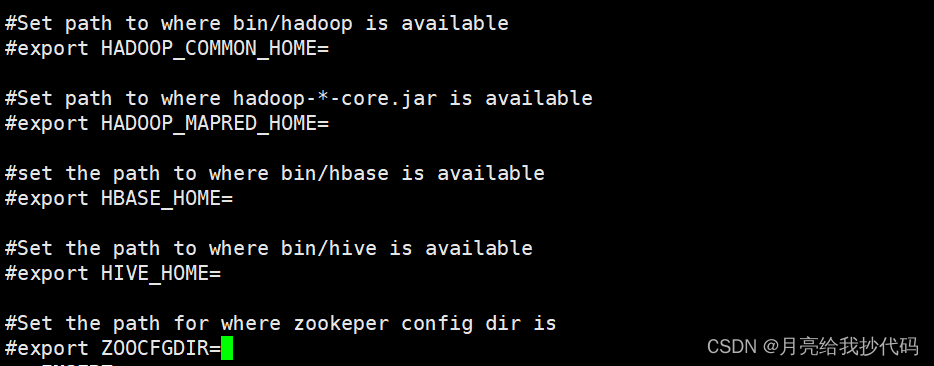

4.配置 Sqoop 环境变量文件

1.切换到 Sqoop 配置文件目录

cd$SQOOP_HOME/conf

2.复制 Sqoop 环境变量模板文件

cp sqoop-env-template.sh sqoop-env.sh

3.编辑文件,指定相关路径

vi sqoop-env.sh

配置如下,根据自己的集群情况来看。

我没有装 HBase 和 Zookeper,所以只指定了 HADOOP 和 Hive 的路径,注意删掉前面的符号

#

,否则会被认为是一行注释。

5. MySQL 驱动

拷贝 MySQL 驱动到 Sqoop 中的

lib

目录中。

cp /opt/software/mysql-connector-java-5.1.37-bin.jar $SQOOP_HOME/lib

6. 拷贝 Hive 文件

为了后续方便操作 Hive,我们需要将 Hive 的驱动放入 Sqoop 的

lib

目录中。

cp hive-3.1.2/lib/hive-common-3.1.2.jar sqoop-1.4.7/lib/

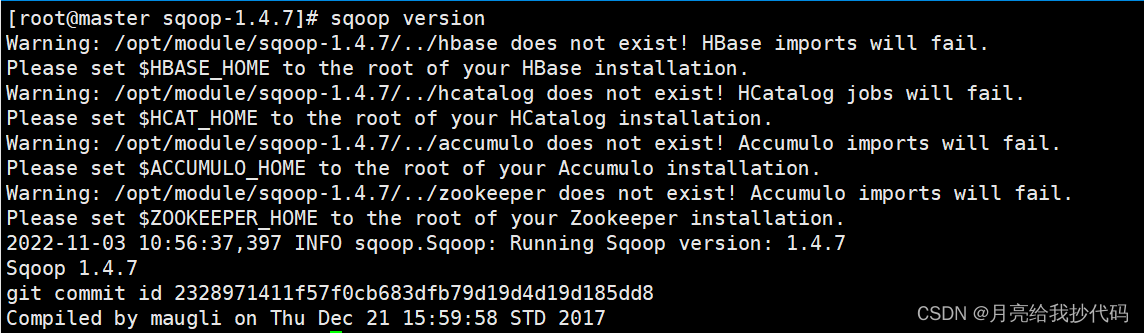

7.验证

输入

sqoop version

,出现如下版本信息表示安装成功。

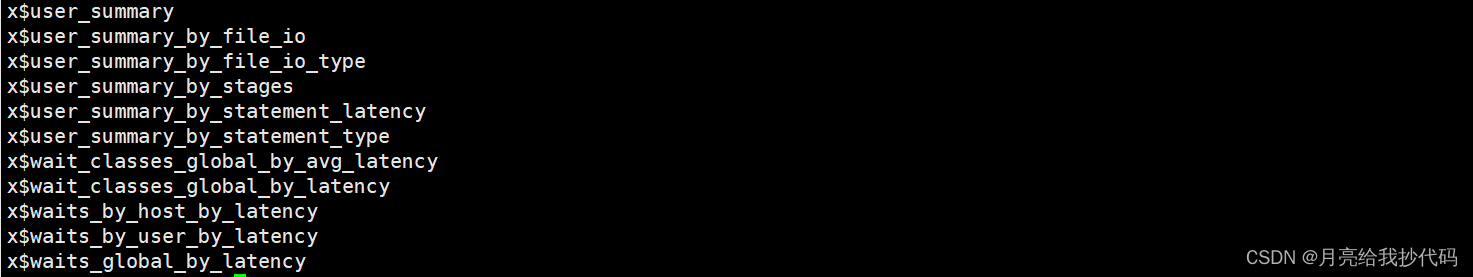

现在来测试功能是否可以正常使用:

展示 MySQL 中

sys

库下的所有表。

sqoop list-tables \--connect jdbc:mysql://localhost:3306/sys \--username root \--password 000000

注意改成你自己的数据库连接信息。

能查出表数据并且无报错则正常。

至此,我们的 Sqoop 就已经安装完成啦。

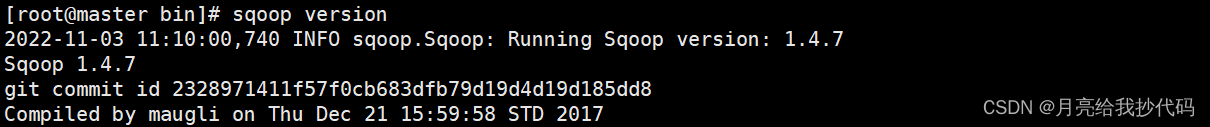

8.去除警告信息

使用 Sqoop 时的一些警告信息真令人头大,我们可以手动去关闭掉这些警告信息。

# 切换到 Sqoop 目录cd$SQOOP_HOME/bin

# 编辑文件vi configure-sqoop

注释如下内容:

再次输入

sqoop version

查看:

瞬间就舒服多了,哈哈哈。

9. Sqoop 学习

推荐看这位大佬总结的,个人觉得很详细:Sqoop基本原理及常用方法。

版权归原作者 月亮给我抄代码 所有, 如有侵权,请联系我们删除。