一、前期准备

hadoop版本主机名ip安装路径hadoop-3.3.0hadooptest192.168.254.172

home/hadoop/software/hadoop-3.3.0

1. 关闭防火墙

(1) 临时关闭防火墙命令:service iptables stop

(2)永久关闭防火墙命令:chkconfig iptables off

2. 安装好JDK

如果jdk没有安装好的可以参考这篇文章

https://editor.csdn.net/md/?articleId=126587725

3. 准备hadoop安装包

hadoop-3-3.0下载地址

http://链接:https://pan.baidu.com/s/1YClfndoOCRdr_yRIxPrj_A?pwd=v8i1

注:下载好hadoop压缩包之后,将压缩包上传至虚拟机(此处上传的路径为home/hadoop/software/)

二、安装hadoop伪分布模式

1. 在home/hadoop/software/路径下创建hadooptmp目录

mkdir /hone/hadoop/software/hadooptmp

注意:这里的/hone/hadoop/software/是我存放hadoop压缩包的路径,对应改成自己的即可

2. 解压hadoop-3.3.0.tar.gz

**tar -zxvf hadoop-3.3.0.tar.gz **

3. 进入hadoop-3.3.0/etc/hadoop

cd home/software//hadoop-3.3.0/etc/hadoop

注意:这里是解压过后的hadoop-3.3.0/etc/hadoop 而不是直接cd hadoop

4. 编辑hadoop运行是的环境

vi hadoop-env.sh

进入文件之后,添加jdk的环境变量,如下:

export JAVA_HOME=/home/hadoop/software/jdk1.8.0_171

添加好之后保存退出

注意这里/home/hadoop/software/是我存放jdk的路径,自己对应改成自己的即可

5. 配置NameNode所在的主机或者通讯地址及NameNode格式化后的目录的路径

vi core-site.xml

进入文件之后,滑到文件最下边,在<configuration></configuration>中添加如下内容

**<property> **

**<name>fs.defaultFS</name> **

**<value>hdfs://hadooptest:9000</value> **

**</property> **

**<property> **

**<name>hadoop.tmp.dir</name> **

**<value>/home/hadoop/software/hadooptmp</value> **

</property>

添加好之后保存退出

注意:这里的hadooptest是我的主机名,对应改成自己的主机名

这里的/home/hadoop/software/hadooptmp是第一步创建Hadooptmp的路径

6. 配置DataNode的数据块冗余度

vi hafs-site.xml

进入文件之后,滑到文件最下边,在<configuration></configuration>中添加如下内容

**<property> **

**<name>dfs.replication</name> **

<value>1</value>

</property>

添加好之后保存退出

7. 配置MapReduce运行框架的yarn容器

** vi mapred-site.xml**

进入文件之后,滑到文件最下边,在<configuration></configuration>中添加如下内容

** <property>**

** <name>mapreduce.framework.name</name> **

** <value>yarn</value>**

** </property>**

添加好之后保存退出

8. 配置ResourceManager所在的主机及MapReduce的shuffer方式

** vi yarn-site.xml**

进入文件之后,滑到文件最下边,在<configuration></configuration>中添加如下内容

<property>

<name>yarn.nodemanger.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

添加好之后保存退出

9. 配置hadoop环境变量

** vi ~/.bash_profile**

在文件中添加如下内容

export HADOOP_HOME=/home/hadoop/software/hadoop-3.3.0

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

注意:这里的/home/hadoop/software/hadoop-3.3.0是hadoop存放的路径,对应改成自己存放hadoop的路径即可

10 . 更新bash_profile 文件内容

source ~/.bash_profile

11. 格式NameNode

** hadoop namenode -format**

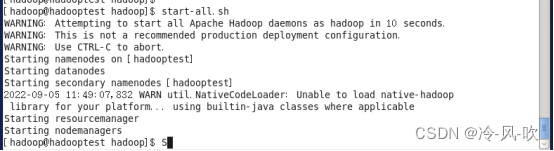

12. 启动hadoop相关进程

**start-all.sh **

出现下图内容则启动完成

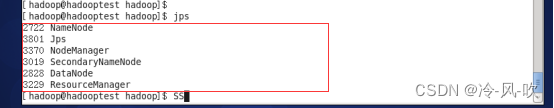

13. 查看进程

jps

之后会显示如下内容

到这里hadoop伪分布集群我们就搭建好啦,第一次搭建的话可能会遇到一些问题,有问题的可以评论,或者私聊我。

版权归原作者 小-枝-丫 所有, 如有侵权,请联系我们删除。