文章目录

安全模式相关命令

# 查看安全模式状态

hdfs dfsadmin -safemode get

# 进入安全模式

hdfs dfsadmin -safemode enter

# 离开安全模式

hdfs dfsadmin -safemode leave

# 强制退出安全模式

hdfs dfsadmin -safemode forceExit

# 等待安全模式

hdfs dfsadmin -safemodewait

等待安全模式,通常情况下在脚本中使用,当集群退出安全模式后,立马执行相关操作。

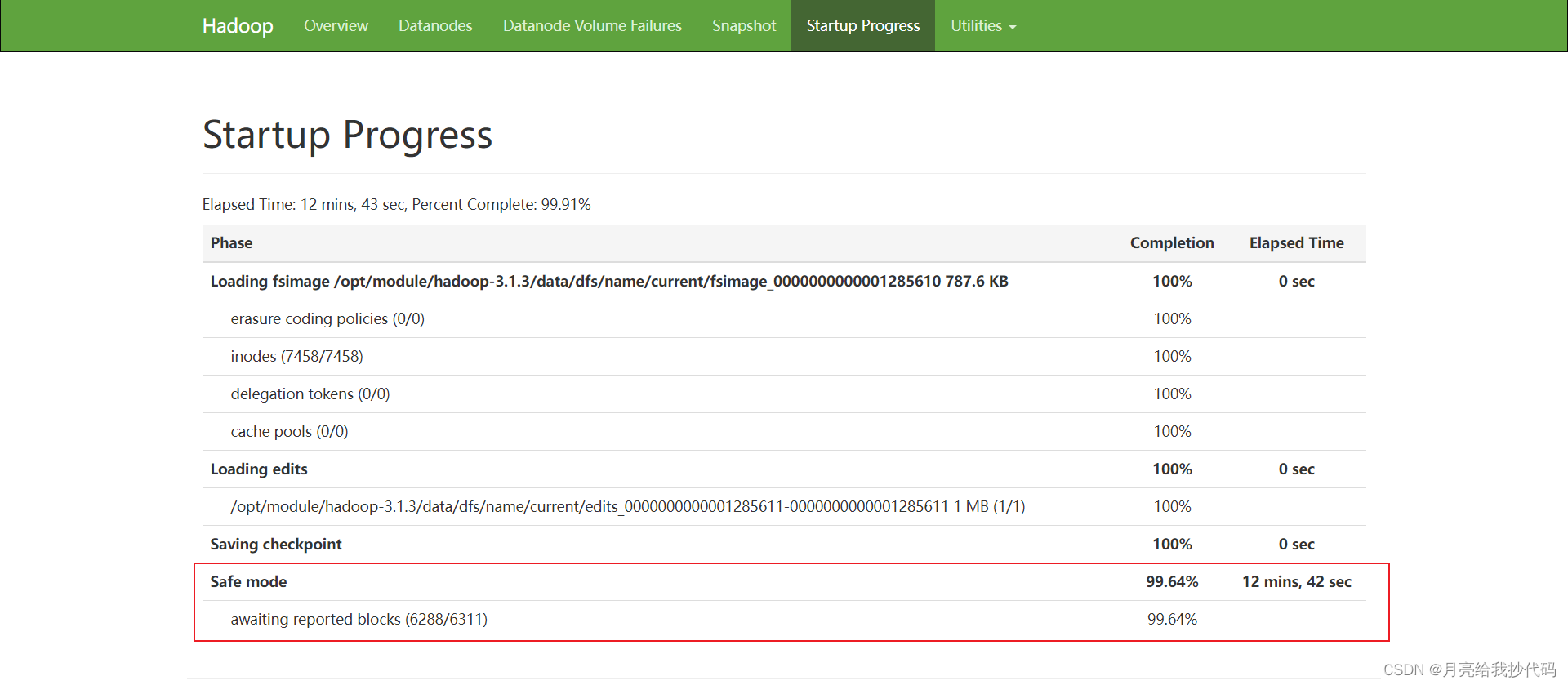

分析集群为什么一直处于安全模式

集群启动后,发现一直处于安全模式中,进入 WEB 界面查看,还有一大段提示,如下:

系统报告称,共有

6288

个数据块,还需要额外的

16

个数据块才能达到总共

6311

个数据块的阈值

0.999

。

通俗来说就是,当前系统中元数据与记录数据块前后不一致,而 Hadoop 默认要求最大的误差阀值为

0.001

,如果超过这个值,就会导致 Hadoop 一直处于安全模式。

也就是说,我们其实已经实际删除了某些数据块,但是记录的元数据因为一些故障导致没有进行同步,就会出现这种情况。

解决方法

首先强制退出安全模式:

hdfs dfsadmin -safemode forceExit

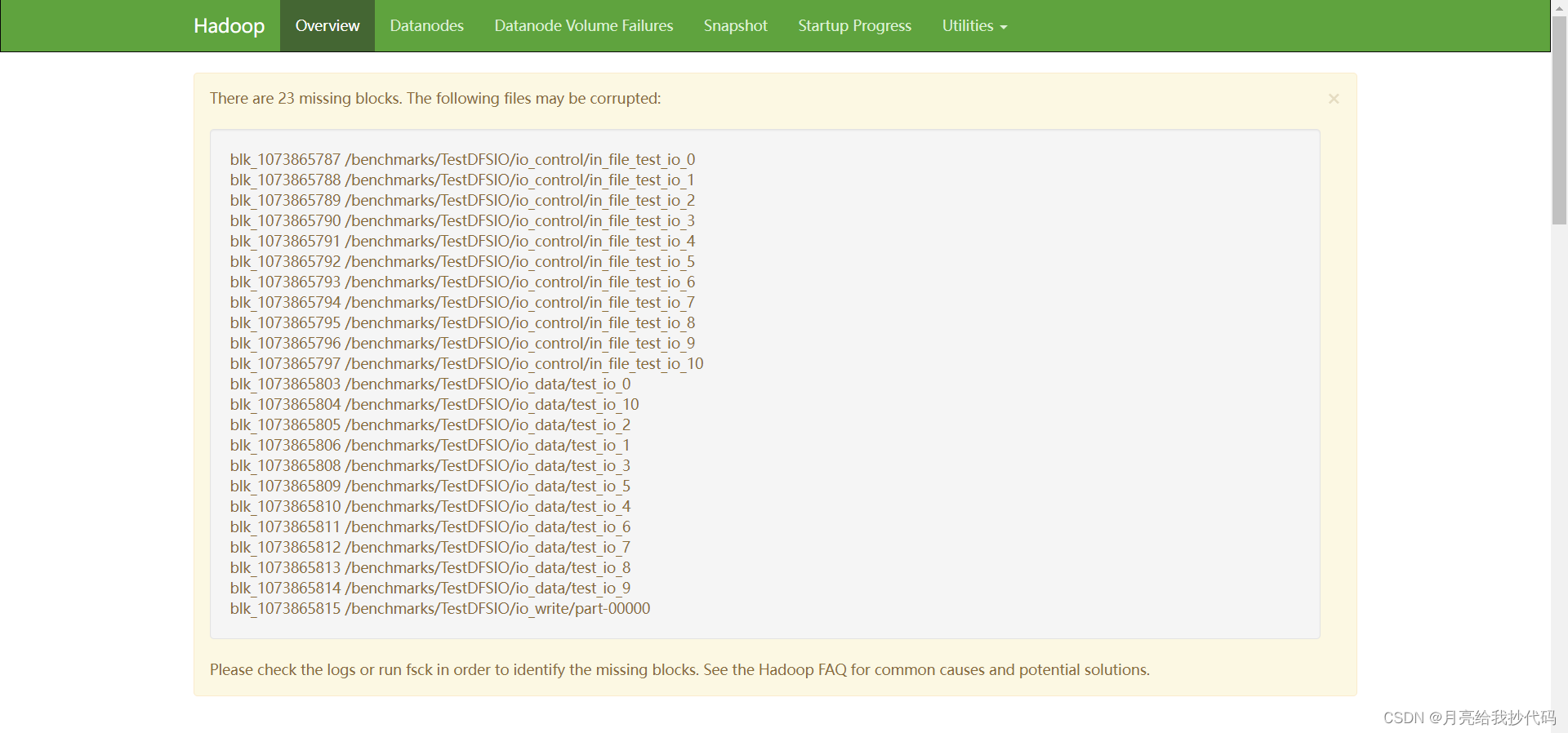

接着,我们进入 WEB 管理界面,刷新一下。

此时,我们就会发现那些数据块丢失的文件,将这些文件按照路径在 HDFS 中全部删除即可。

如果你想要对文件进行恢复,那么则需要请教相关专业人士,使用磁盘修复工具进行处理。

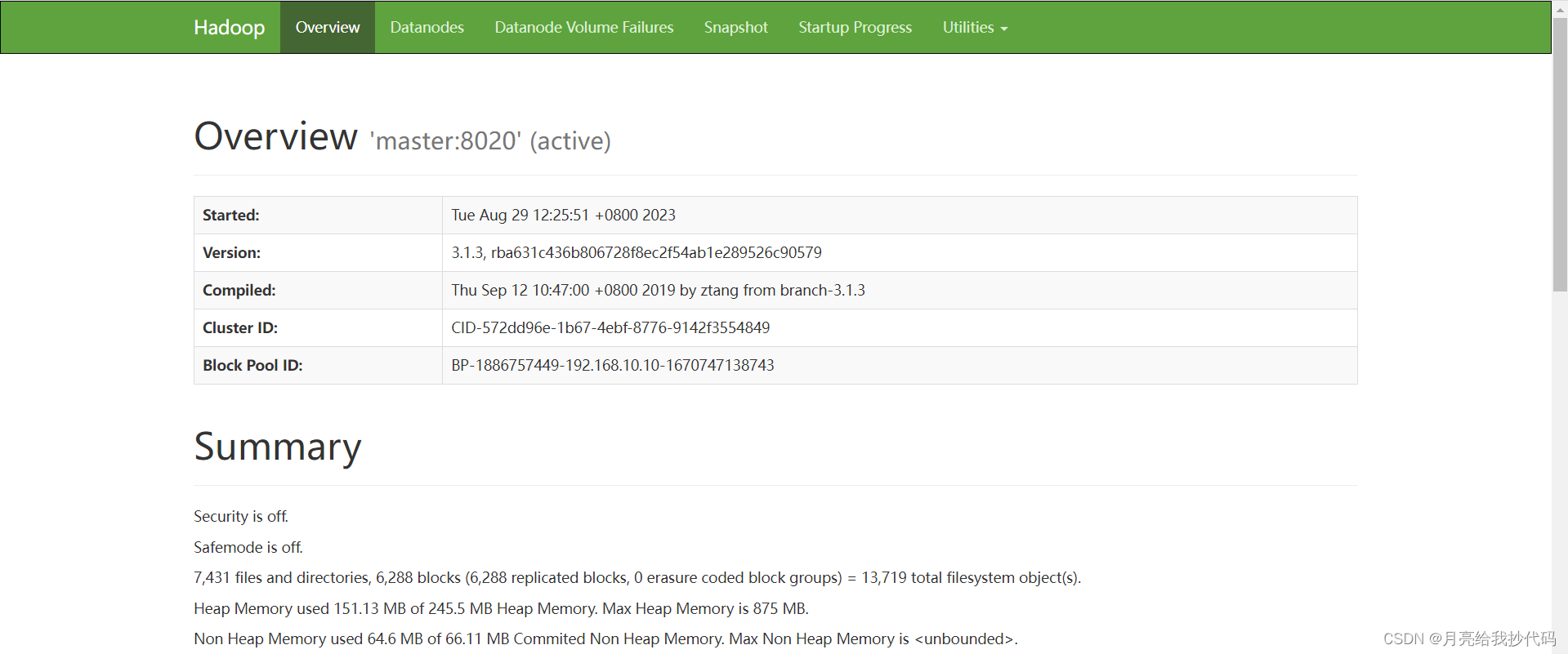

删除完成后,我们重启集群,进入 WEB 界面查看是否正常:

如果删除过程中遇到报错,如下所示:

Permission denied: user=master, access=WRITE, inode=“/benchmarks/TestDFSIO”:root:supergroup:drwxr-xr-x

权限不足,无法进行写操作。

我们需要先使用

root

账号对操作目录授权,或者直接关闭 HDFS 权限验证。

方法一

# 使用 `root` 账号对操作目录授权

hdfs dfs -chmod-R777 /benchmarks/TestDFSIO

方法二

不建议,会影响集群安全。

# 直接关闭 HDFS 权限验证,在 hdfs-site.xml 文件中添加如下配置:<property><name>dfs.permissions</name><value>false</value></property>

添加完成后,分发同步该文件,重启集群后生效。

版权归原作者 月亮给我抄代码 所有, 如有侵权,请联系我们删除。