文章目录

前言

在大数据开发领域中,不得不说说传统经典的hadoop基础计算框架。一般我们都会将hadoop集群部署在服务器上,但是作为一个资深搬砖人,我们本地环境也需要一个开发hadoop的开发环境。那么,今天就安排一个在windows上搭建一个hadoop环境。

docker部署hadoop请移步

基础环境

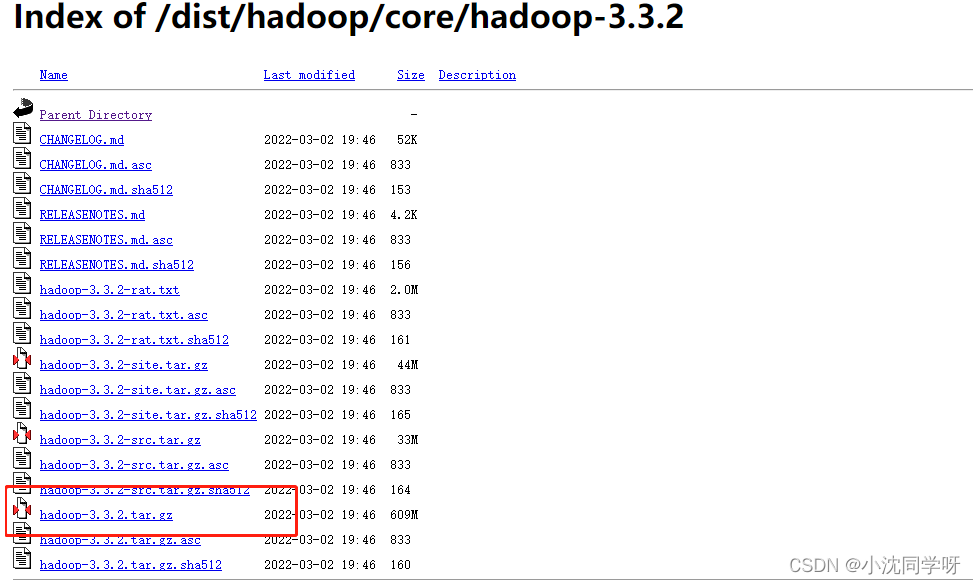

下载hadoop安装包

http://archive.apache.org/dist/hadoop/core/hadoop-3.3.2/

解压。

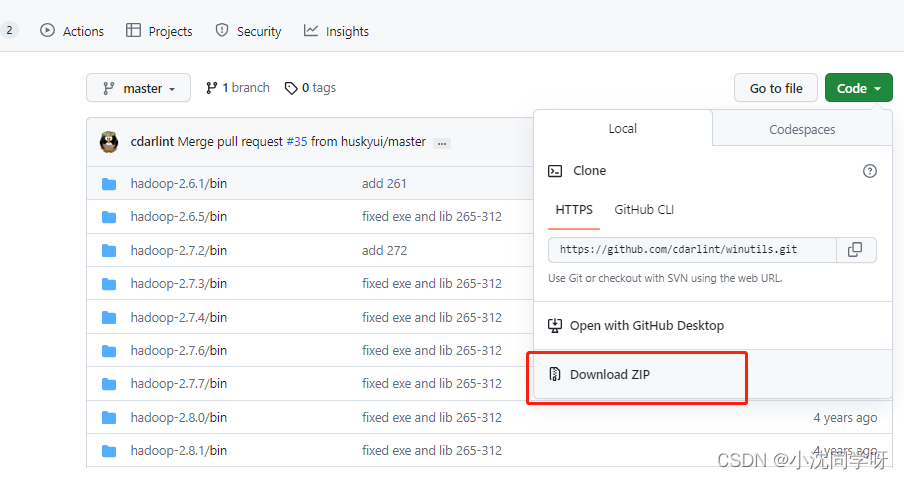

下载hadoop在windows中的依赖

https://github.com/cdarlint/winutils

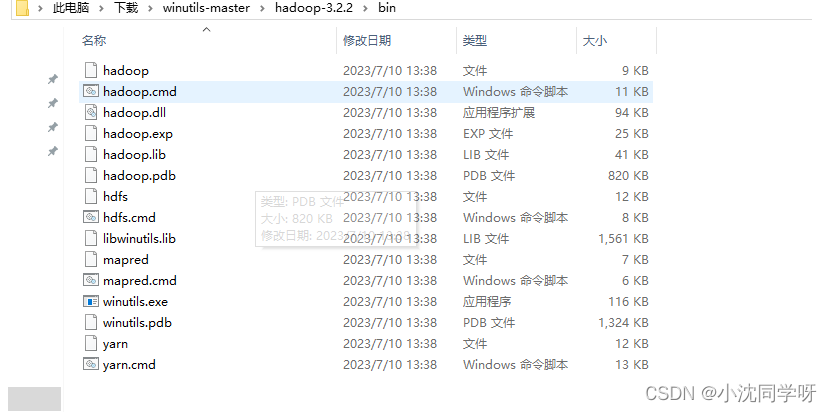

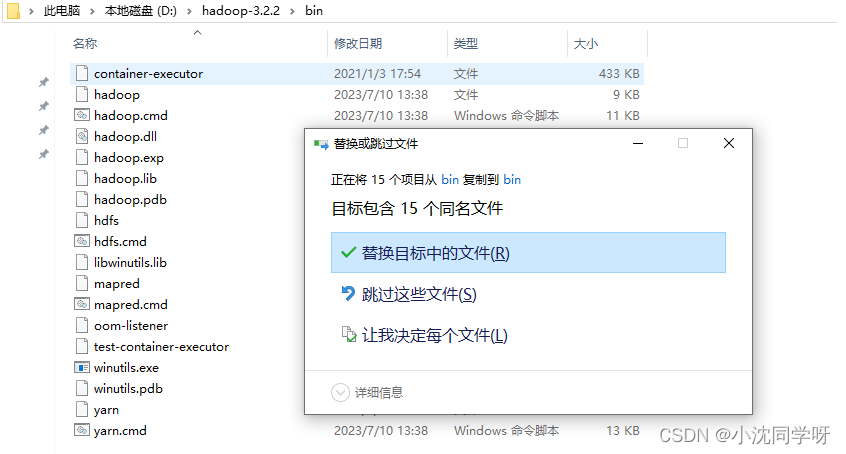

下载完成之后,解压,将3.2.2目录下的所有文件替换hadoop的bin目录下的文件:

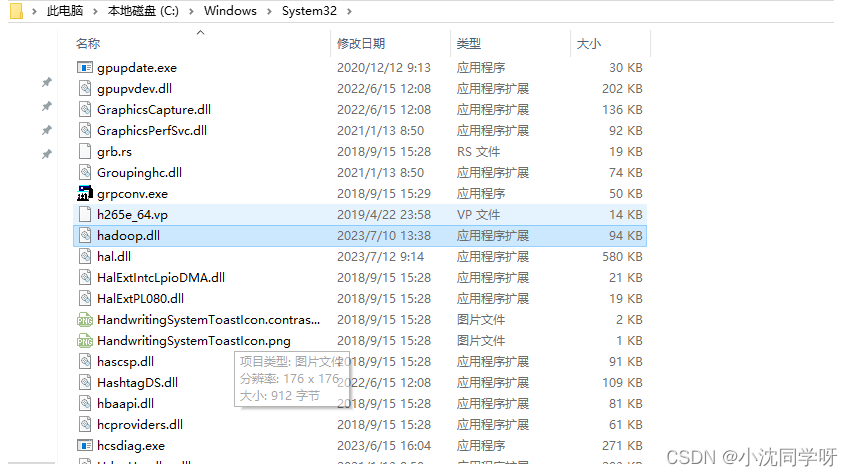

并将hadoop.dll 文件复制到C:\Windows\System32 目录:

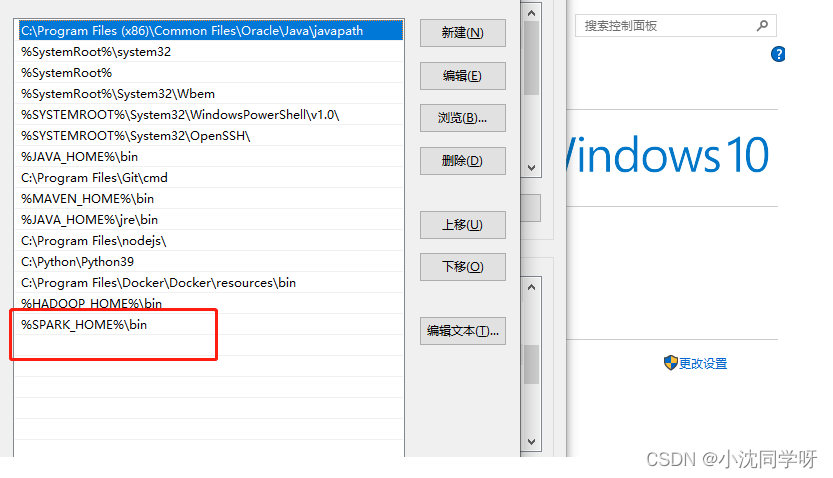

配置环境变量

HADOOP_HOME= D:\hadoop-3.2.2

Path中添加 %HADOOP_HOME%\bin

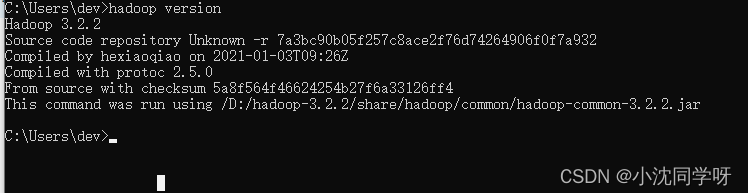

cmd输入 hadoop version

表示基础环境配置成功。

如果需要部署本地hadoop环境(HDFS)需要继续往下操作。

Hadoop hdfs搭建

创建hadfs数据目录

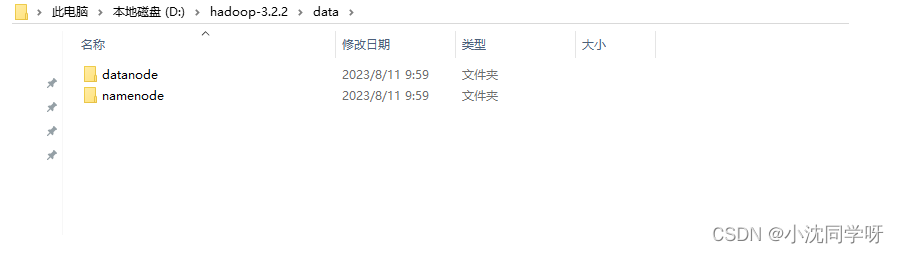

在hadoop-3.2.2目录下创建data目录

data目录下创建namenode和datanode存储目录

data\namenode

data\datanode

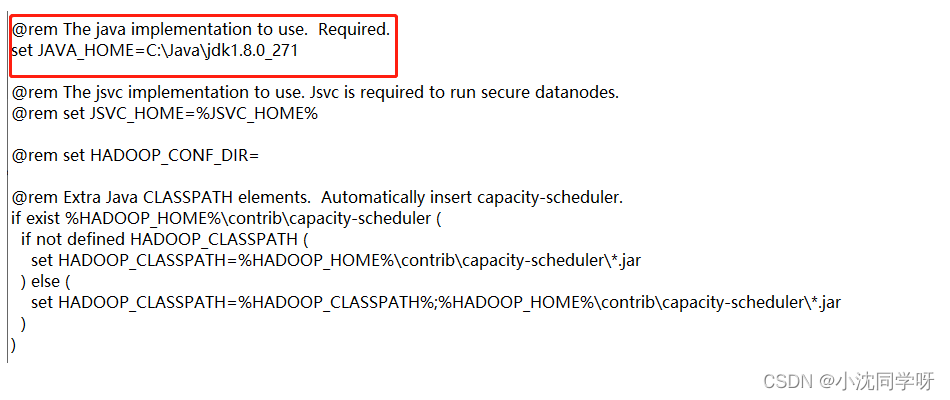

修改JAVA依赖

进入目录 etc\hadoop

修改hadoop-env.cmd

set JAVA_HOME=C:\Java\jdk1.8.0_271

修改配置文件

1、etc\hadoop目录,修改hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>D:\\hadoop-3.2.2\\data\\namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>D:\\hadoop-3.2.2\\data\\datanode</value>

</property>

</configuration>

2、etc\hadoop目录,修改core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

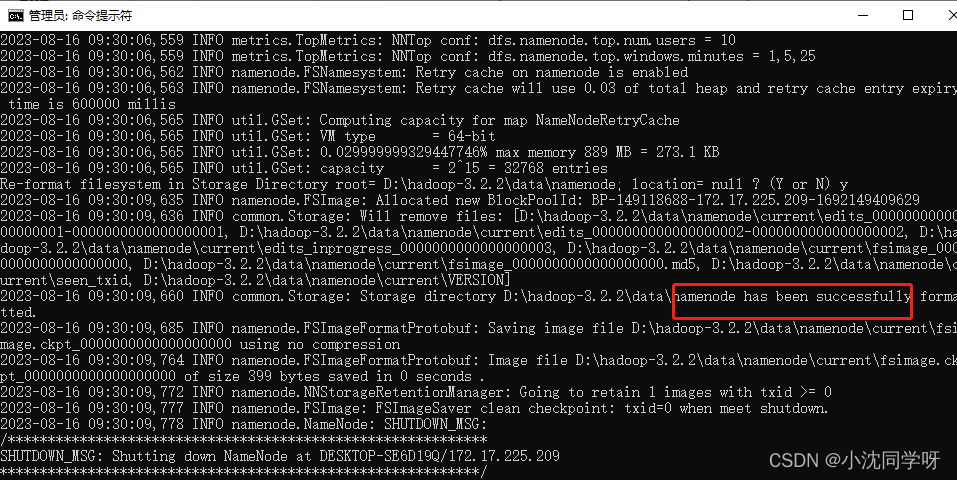

初始化hdfs namenode

进入hadoop-3.2.2\bin目录,以管理员身份打开“命令提示符“

输入 hdfs namenode -format

看到seccessfully就说明format成功。如下图所示:

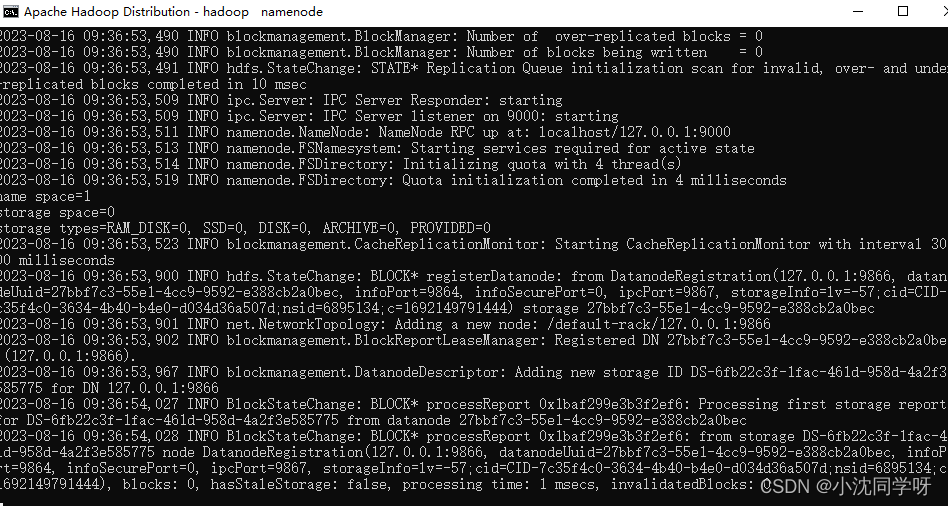

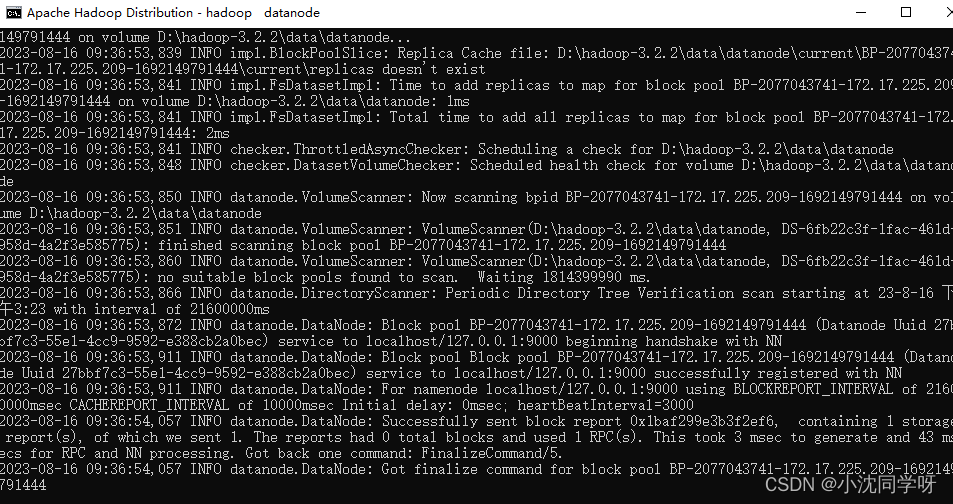

启动hdfs

进入hadoop-3.2.2\sbin目录

输入start-dfs.cmd,启动hdfs。

出现以下namenode和datanode窗口

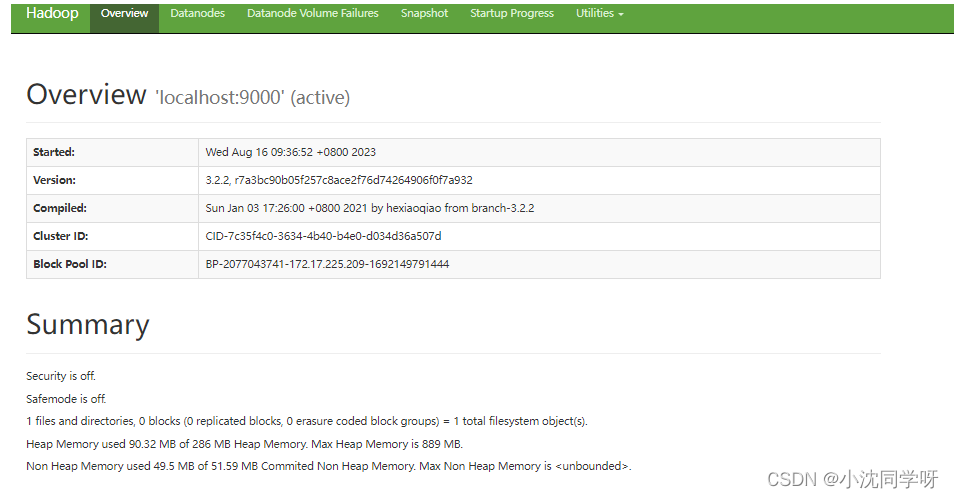

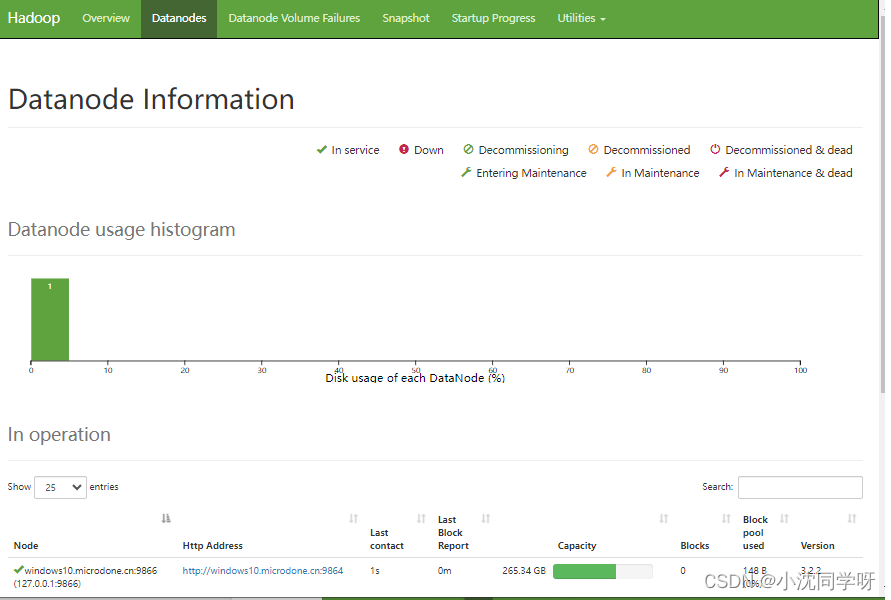

浏览器访问:http://127.0.0.1:9870/

至此,windows上的hadoop环境搭建完成,包含基础环境变量和HDFS。

版权归原作者 小沈同学呀 所有, 如有侵权,请联系我们删除。