(一)写入文件

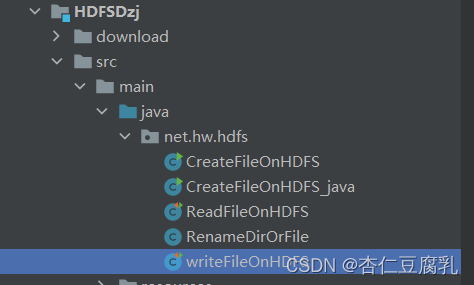

在net.hw.hdfs包中创建writeFileOnHDFS类

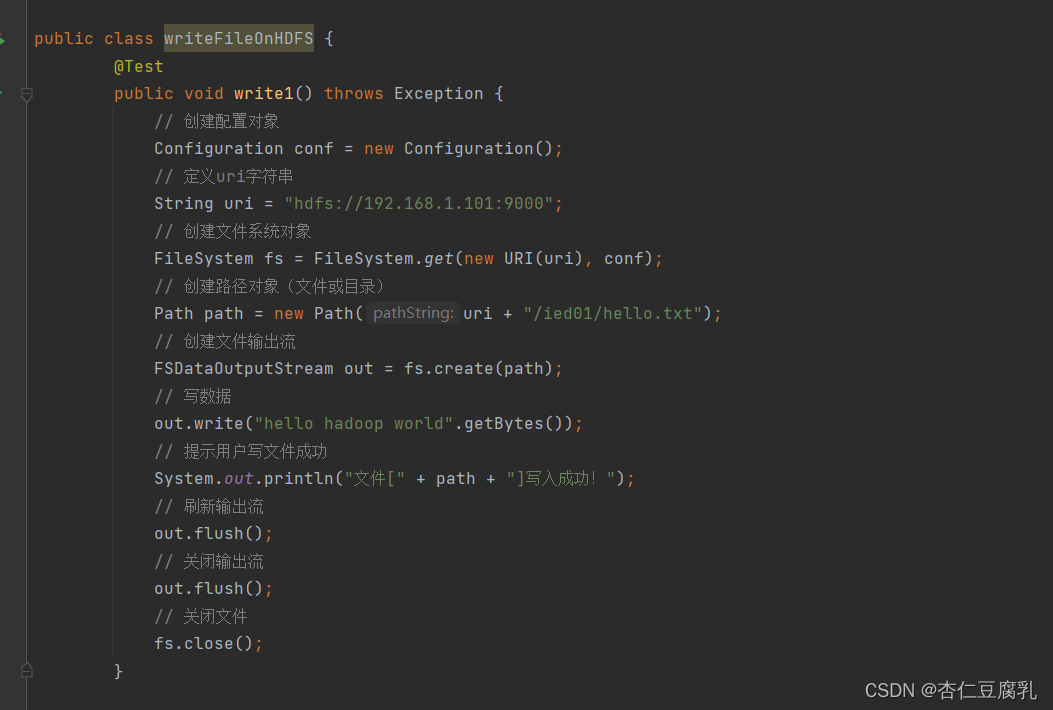

1、将数据直接写入HDFS文件 【在/ied01目录中创建hello.txt文件,创建write1()方法】

** 注:**

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class WriteFileOnHDFS {

@Test

public void write1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/hello.txt");

// 创建文件系统数据字节输出流(出水管:数据从程序到文件)

FSDataOutputStream out = fs.create(path);

// 通过字节输出流向文件写数据

out.write("Hello Hadoop World".getBytes());

// 关闭文件系统数据字节输出流

out.close();

// 关闭文件系统对象

fs.close();

// 提示用户写文件成功

System.out.println("文件[" + path + "]写入成功!");

}

}

运行write1方法,查看结果 【报错,将是没有数据节点可以写入数据】

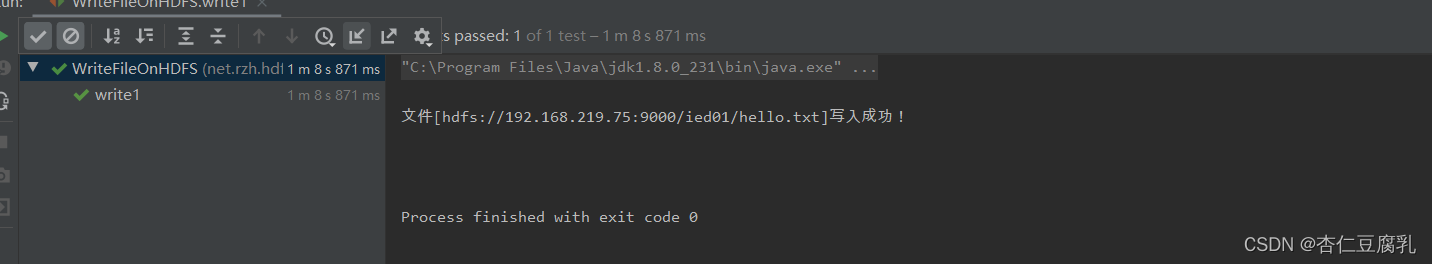

运行程序,查看结果

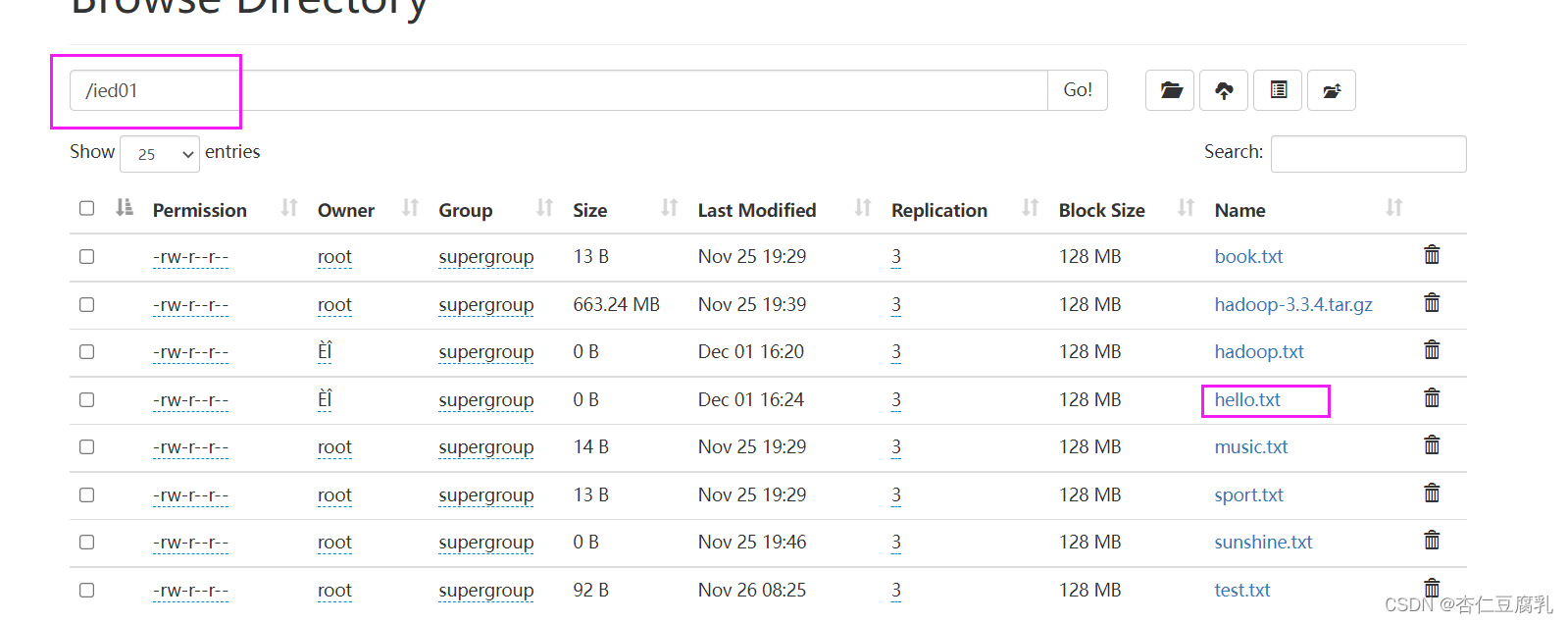

利用Hadoop WebUI 界面查看hello.txt文件

将本地文件写入HDFS文件

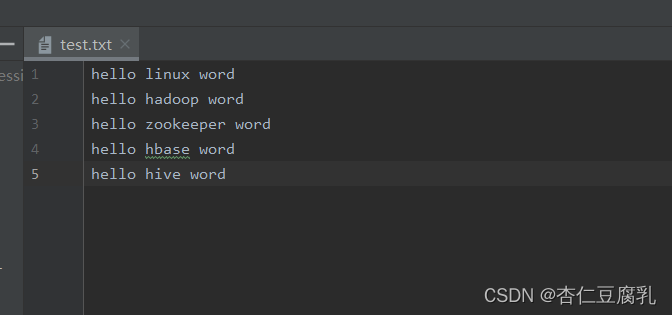

在姓名根目录创建一个文本文件test.txt

** 注:可以再往下空一格**

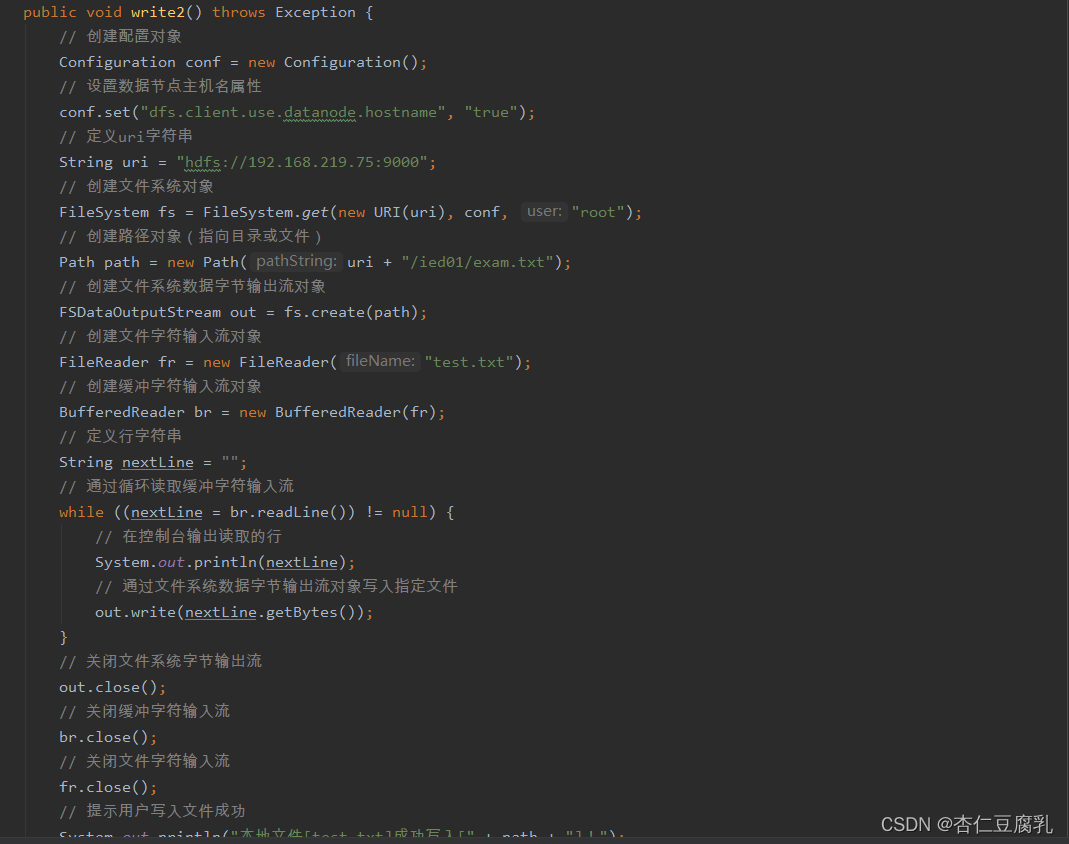

创建write2方法

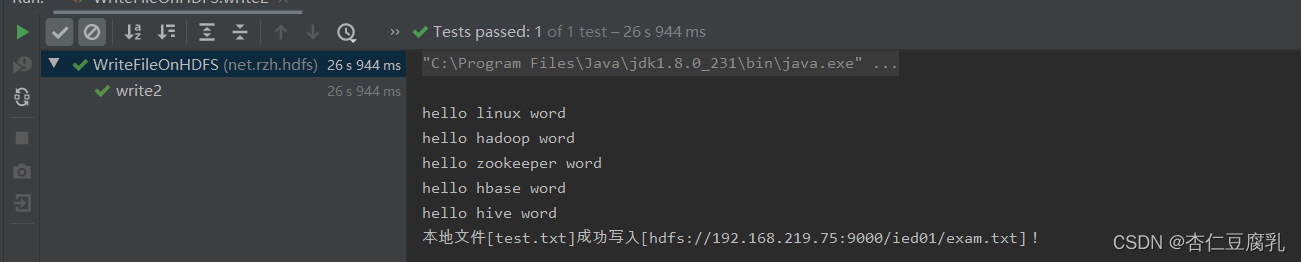

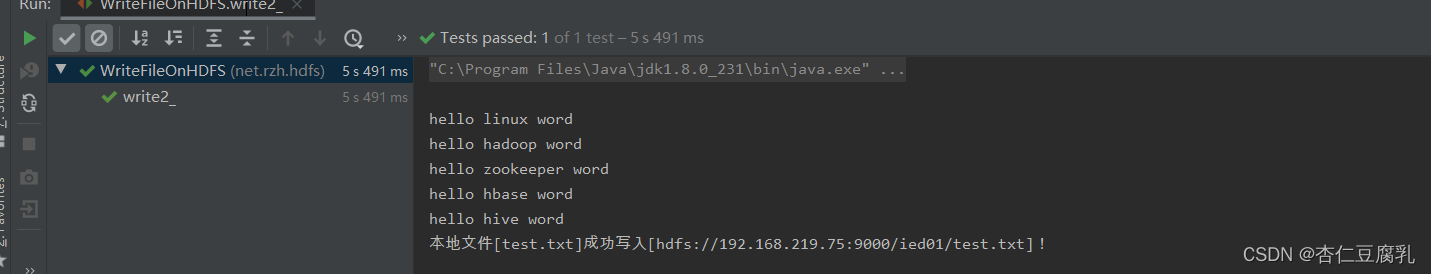

运行write2方法,查看结果

注:将本地文件复制或上传到HDFS

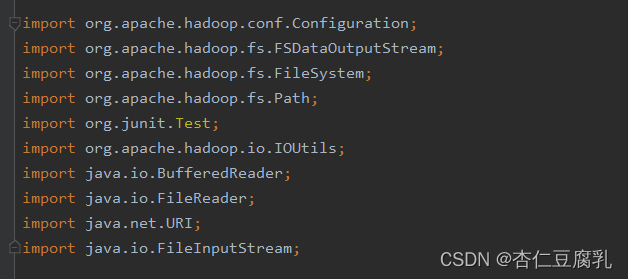

编写write2方法 【注:导包问题】

查看write2方法,查看结果

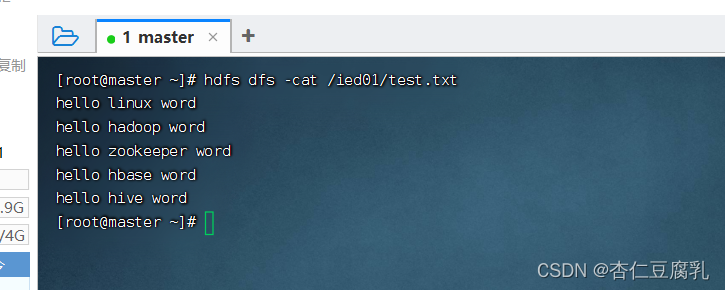

shell上面查看/ied01/test.txt内容

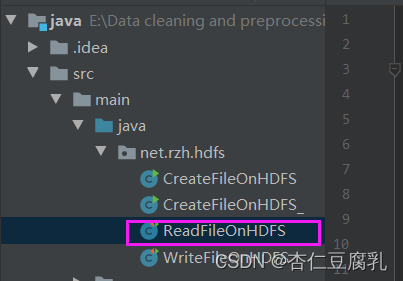

(二)、读取HDFS文件

两个命令:hdfs dfs -cat 和 hdfs dfs -get

在net.hw.hdfs包中创建ReadFileOnHDFS类

1、读取HDFS在控制台显示 【读取hdfs://master:9000/ied01/test.txt文件】

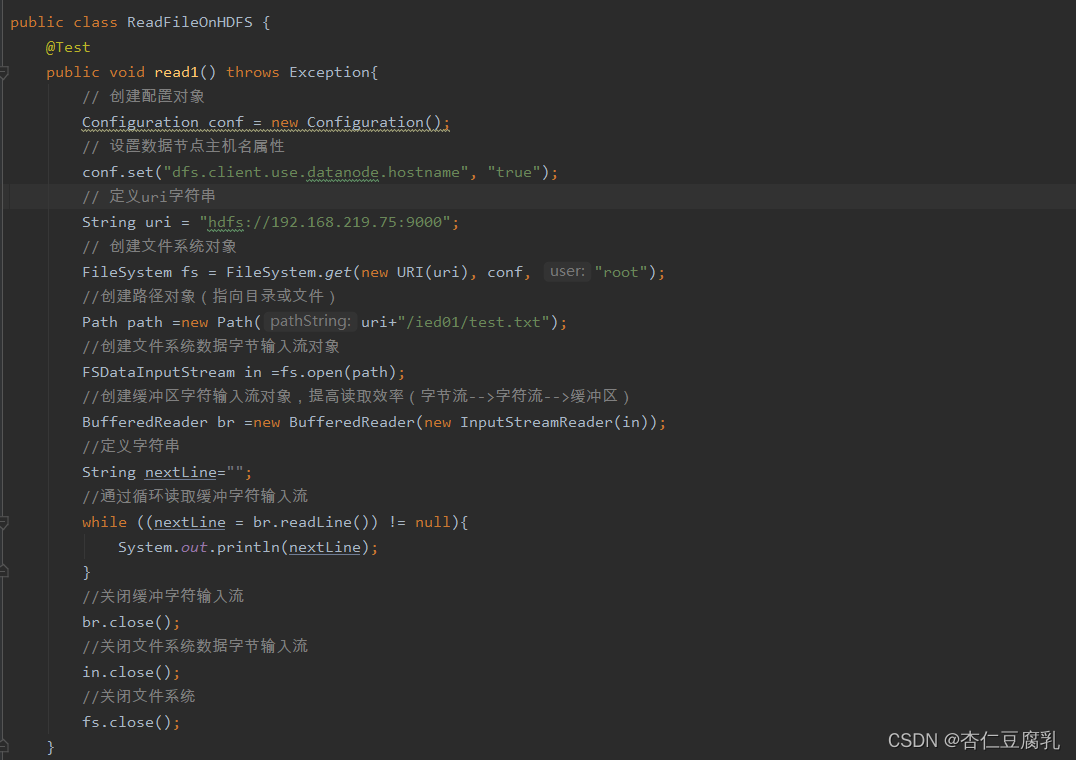

编写read1方法

注:

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.io.BufferedReader;

import java.io.InputStreamReader;

import java.net.URI;

public class ReadFileOnHDFS {

@Test

public void read1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向目录或文件)

Path path = new Path(uri + "/ied01/test.txt");

// 创建文件系统数据字节输入流对象

FSDataInputStream in = fs.open(path);

// 创建缓冲字符输入流对象,提高读取效率(字节流-->字符流-->缓冲流)

BufferedReader br = new BufferedReader(new InputStreamReader(in));

// 定义行字符串

String nextLine = "";

// 通过循环读取缓冲字符输入流

while ((nextLine = br.readLine()) != null) {

// 在控制台输出读取的行内容

System.out.println(nextLine);

}

// 关闭缓冲字符输入流

br.close();

// 关闭文件系统数据字节输入流

in.close();

// 关闭文件系统

fs.close();

}

}

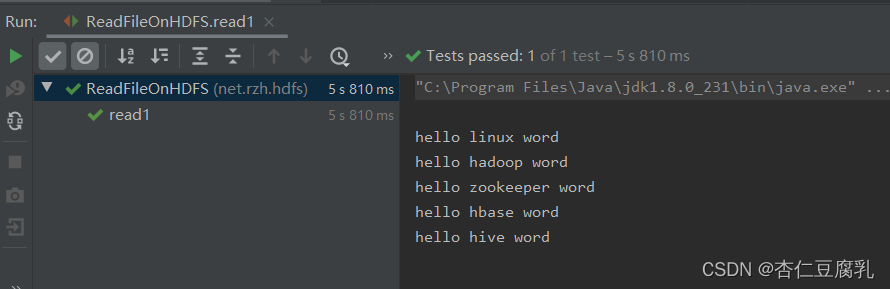

运行read1测试方法,查看结果

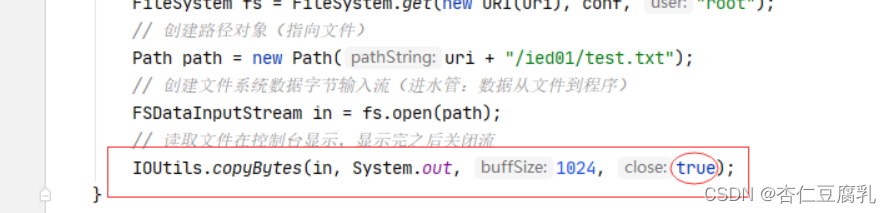

使用IOUtils类来简化代码,创建read1测试方法

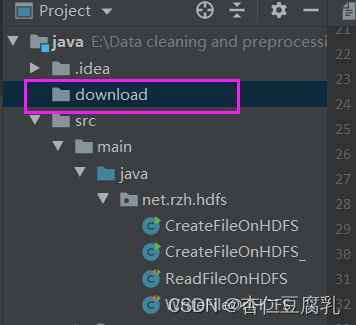

2、读取HDFS文件,保存为本地文件 【将/ied01/test.txt下载到项目download目录里】

创建download目录

创建read2方法

(三)重命名目录或者文件 【执行:hdfs dfs -mv】

在net.hw.hdfs包中创建RenameDirOrFile类

1、重命名目录 【将/ied01目录更名为/lzy01】

编写renameDir方法

注:

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class RenameDirOrFile {

@Test

public void renameDir() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建源路径对象

Path sourcePath = new Path("/ied01");

// 创建目标路径对象

Path targetPath = new Path("/lzy01");

// 利用文件系统对象重命名目录

fs.rename(sourcePath, targetPath);

// 关闭文件系统

fs.close();

// 提示用户目录更名成功

System.out.println("目录[" + sourcePath.getName() + "]更名为目录[" + targetPath.getName() + "]!");

}

}

查看renameDir方法,查看结果

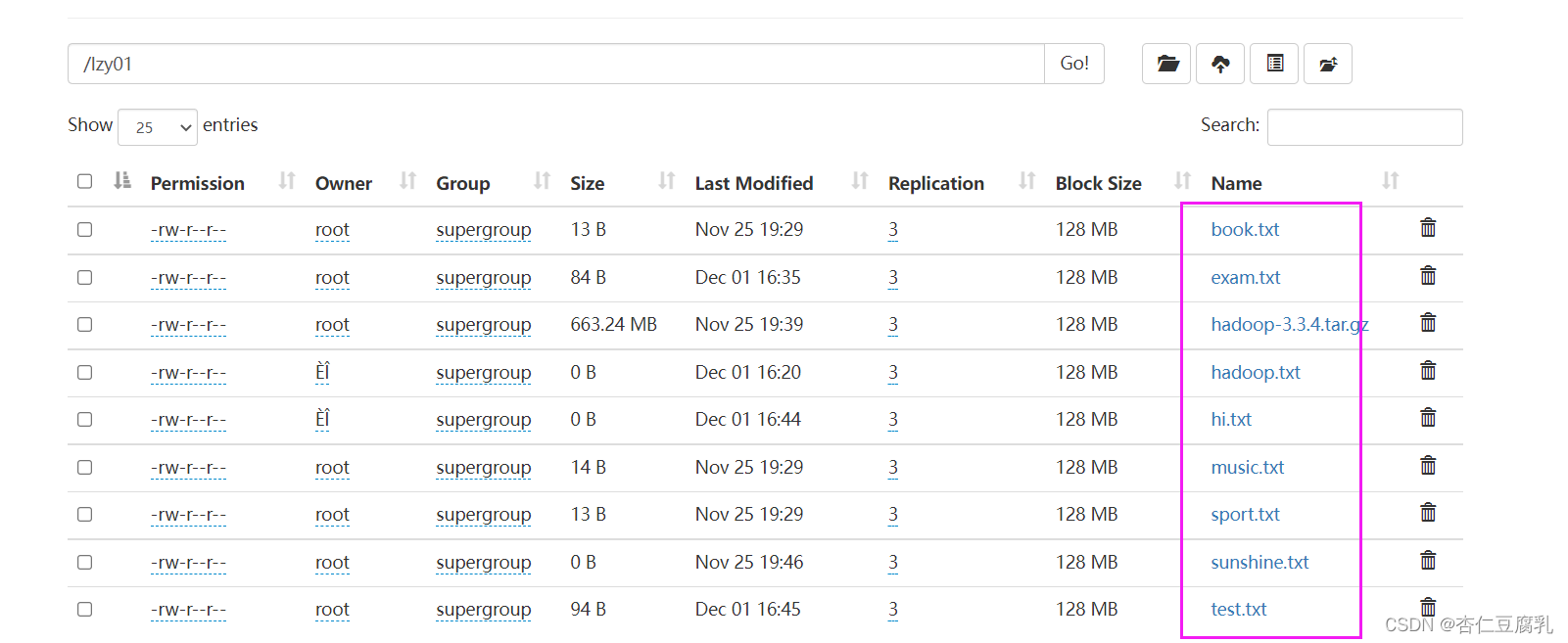

WebUI界面进行查看

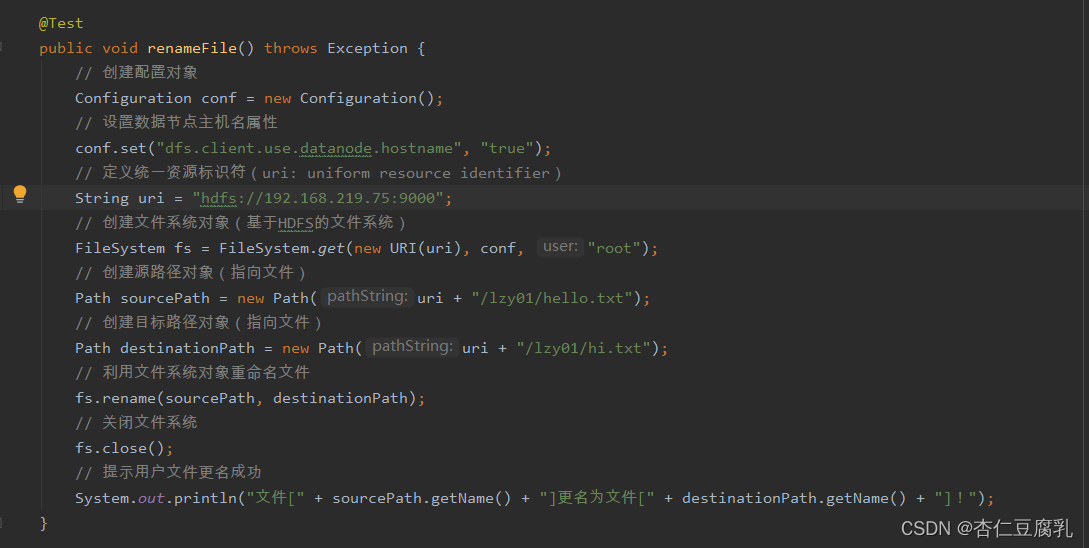

2、重命名文件 【 将lzy01目录下的hello.txt重名为hi.txt】

编写renameFile方法

注:

@Test

public void renameFile() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建源路径对象(指向文件)

Path sourcePath = new Path("/lzy01/hello.txt");

// 创建目标路径对象(指向文件)

Path targetPath = new Path("/lzy01/hi.txt");

// 利用文件系统对象重命名文件

fs.rename(sourcePath, targetPath);

// 关闭文件系统

fs.close();

// 提示用户文件更名成功

System.out.println("文件[" + sourcePath.getName() + "]更名为文件[" + targetPath.getName() + "]!");

}

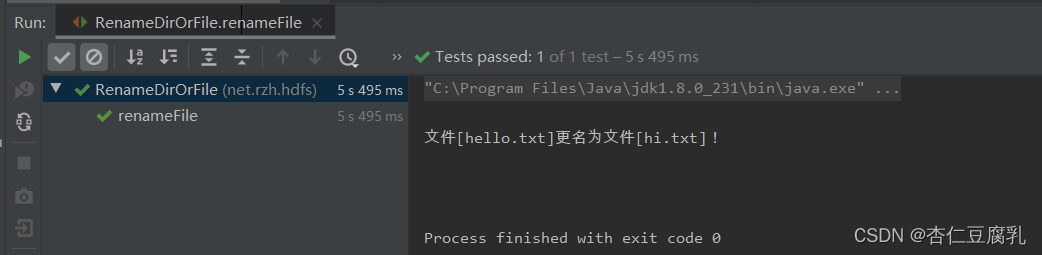

运行测试,查看结果

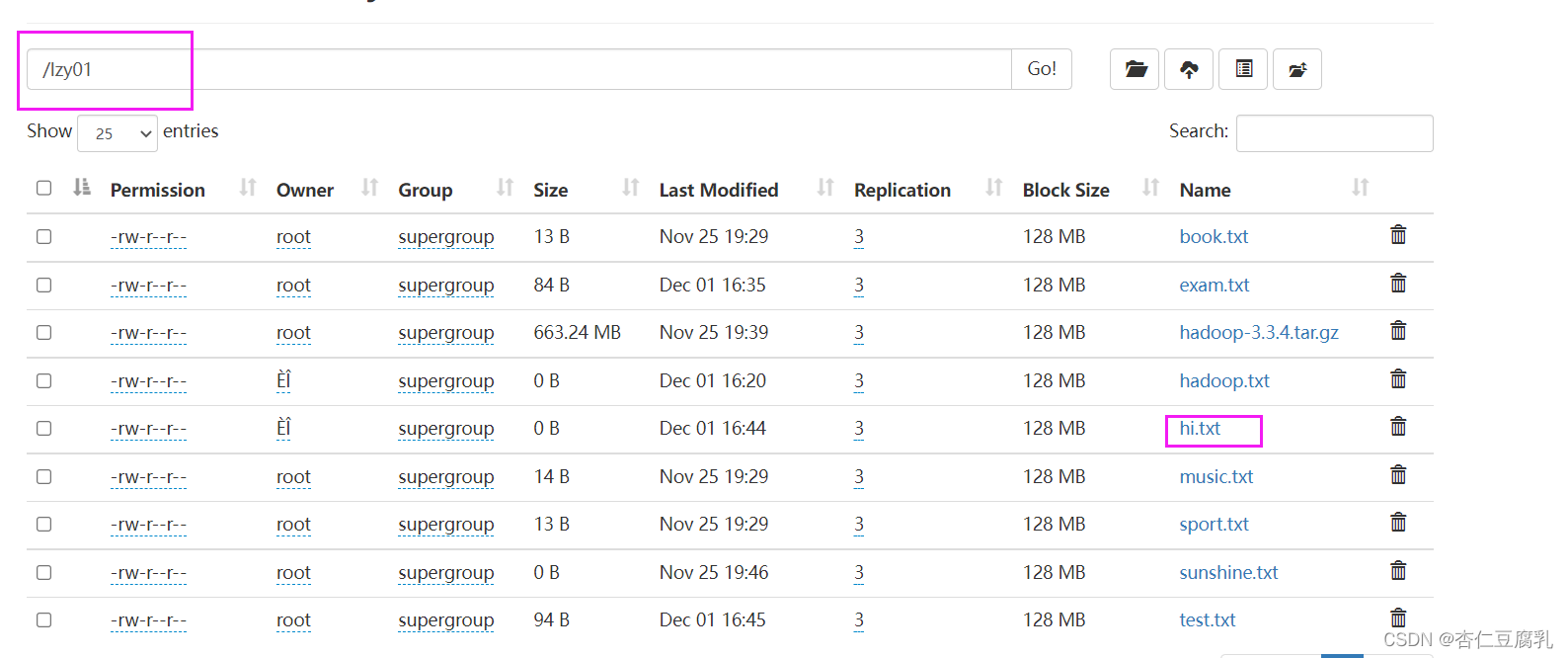

利用WeUI界面进行查看

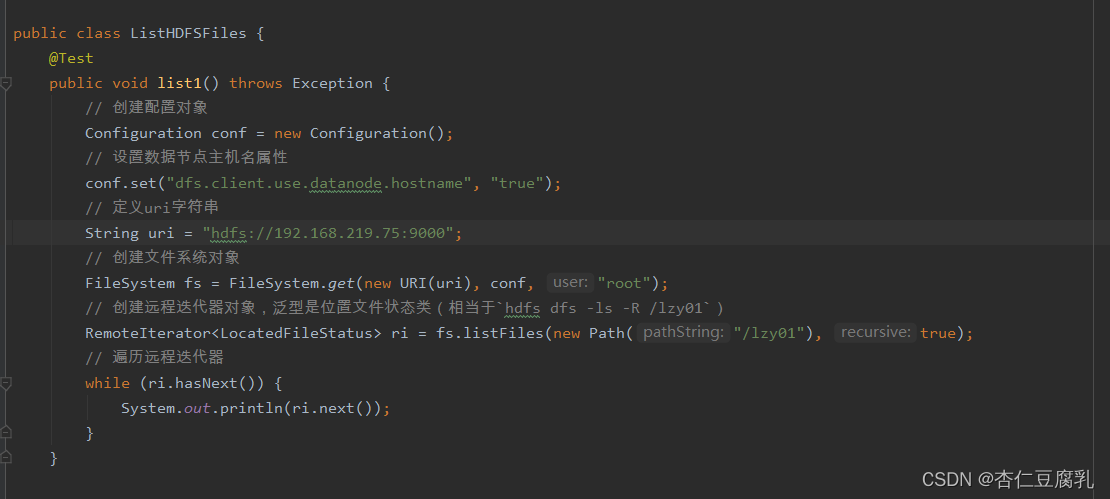

(四)、显示文件列表

在net.hw.hdfs包中创建ListHDFS类

1、显示/lzy01目录下的文件列表 【显示/lzy01目录下的文件列表】

编写list1方法

注:

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.LocatedFileStatus;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.fs.RemoteIterator;

import org.junit.Test;

import java.net.URI;

public class ListHDFSFiles {

@Test

public void list1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建远程迭代器对象,泛型是位置文件状态类(相当于hdfs dfs -ls -R /lzy01)

RemoteIterator<LocatedFileStatus> ri = fs.listFiles(new Path("/lzy01"), true);

// 遍历远程迭代器

while (ri.hasNext()) {

System.out.println(ri.next());

}

}

}

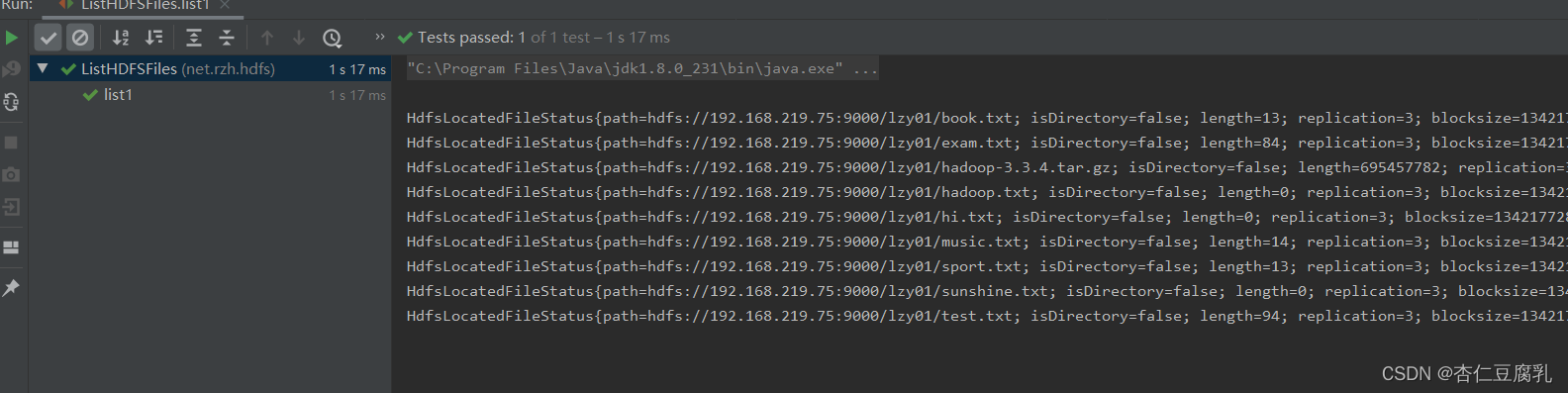

运行list1测试方法,查看结果

注:

上述文件状态对象封装的有关信息,可以通过相应的方法来获取,比如

getPath()

方法就可以获取路径信息,

getLen()

方法就可以获取文件长度信息……

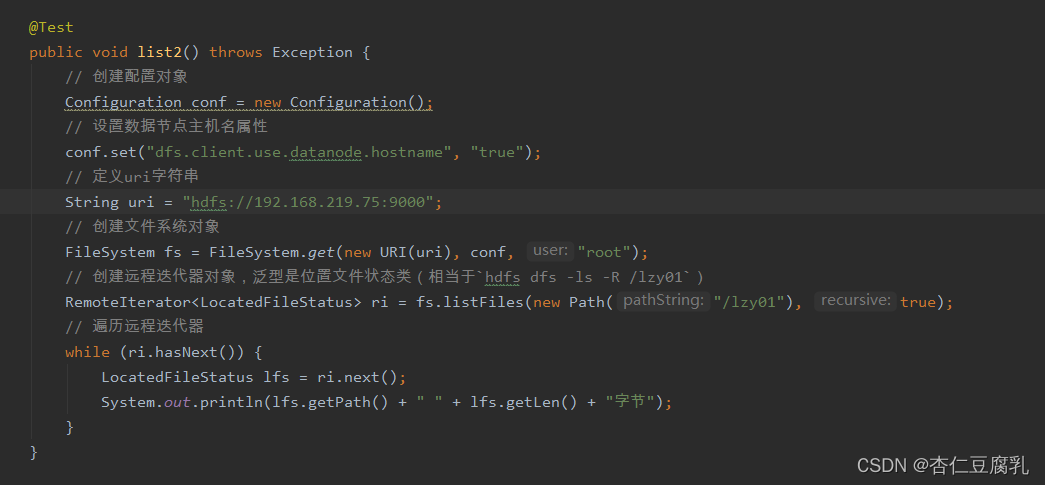

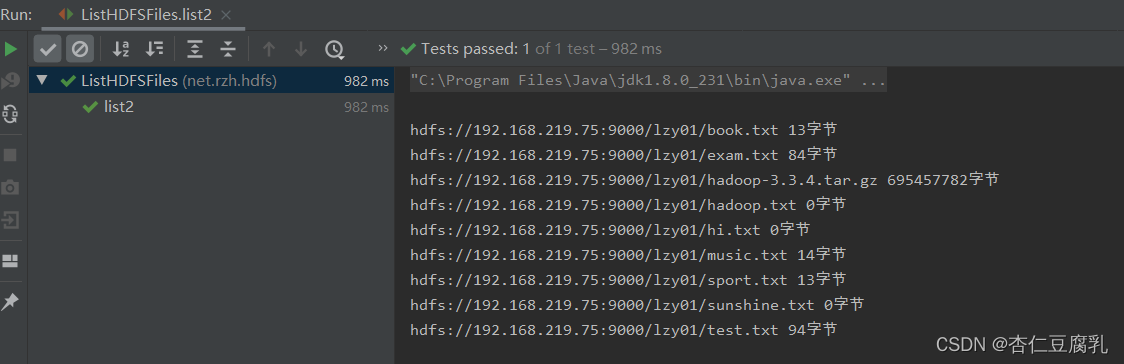

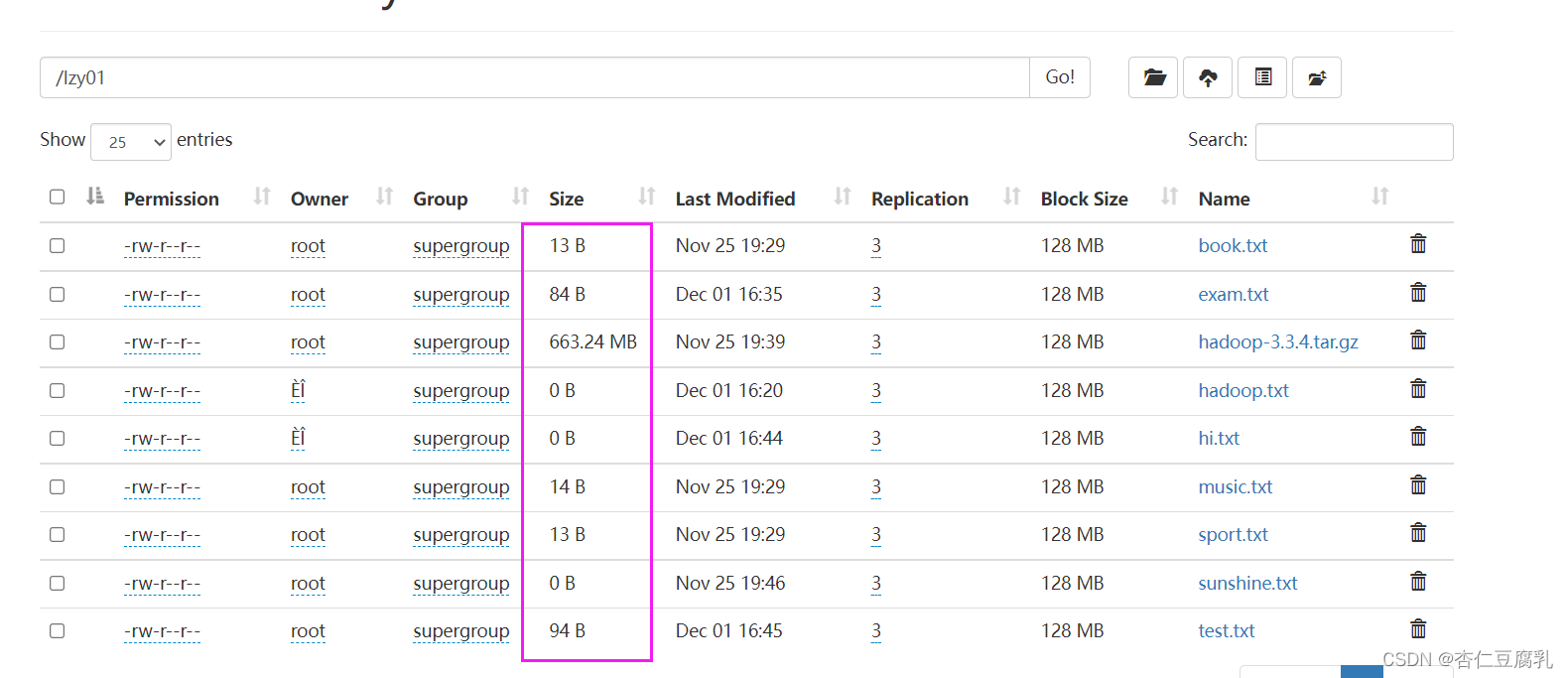

2、显示指定目录下文件路径和长度信息 【编写list2方法】

注:

@Test

public void list2() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建远程迭代器对象,泛型是位置文件状态类(相当于hdfs dfs -ls -R /lzy01)

RemoteIterator<LocatedFileStatus> ri = fs.listFiles(new Path("/lzy01"), true);

// 遍历远程迭代器

while (ri.hasNext()) {

LocatedFileStatus lfs = ri.next();

System.out.println(lfs.getPath() + " " + lfs.getLen() + "字节");

}

}

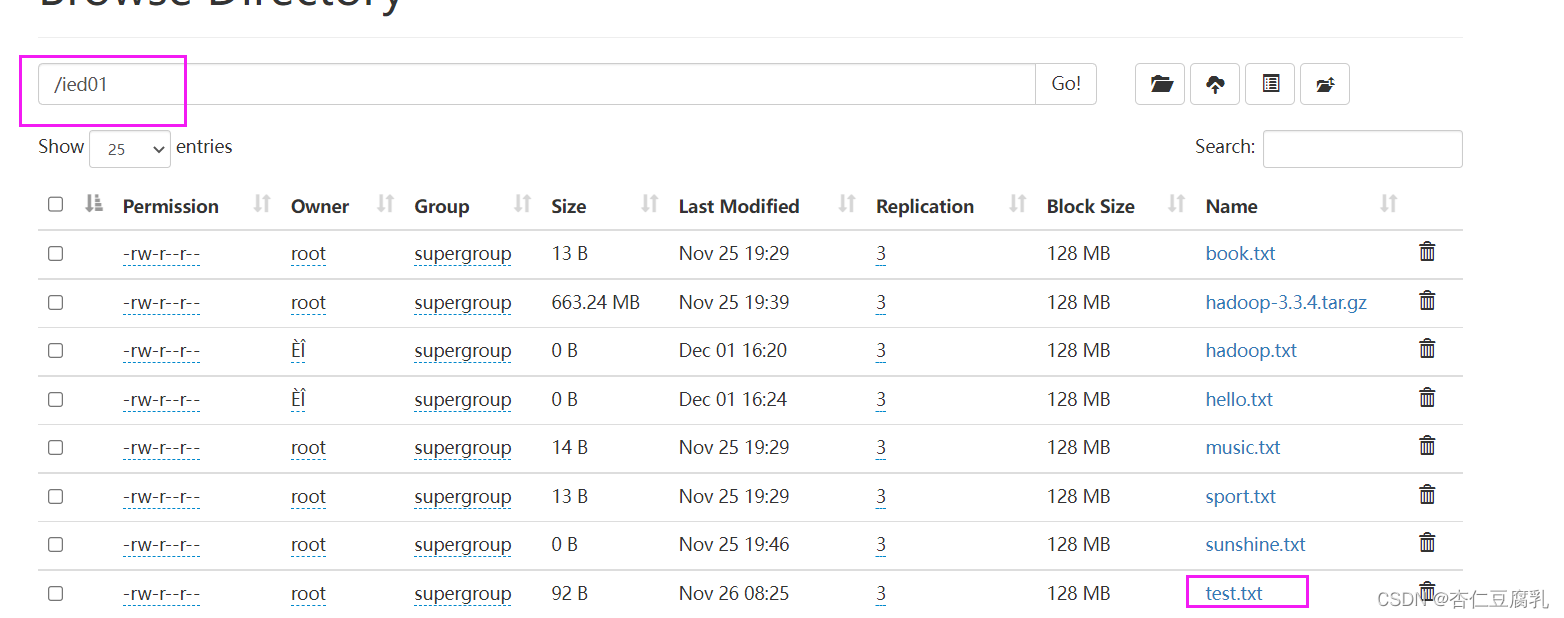

运行list2测试方法,查看结果

对照WebUI上给出文件信息

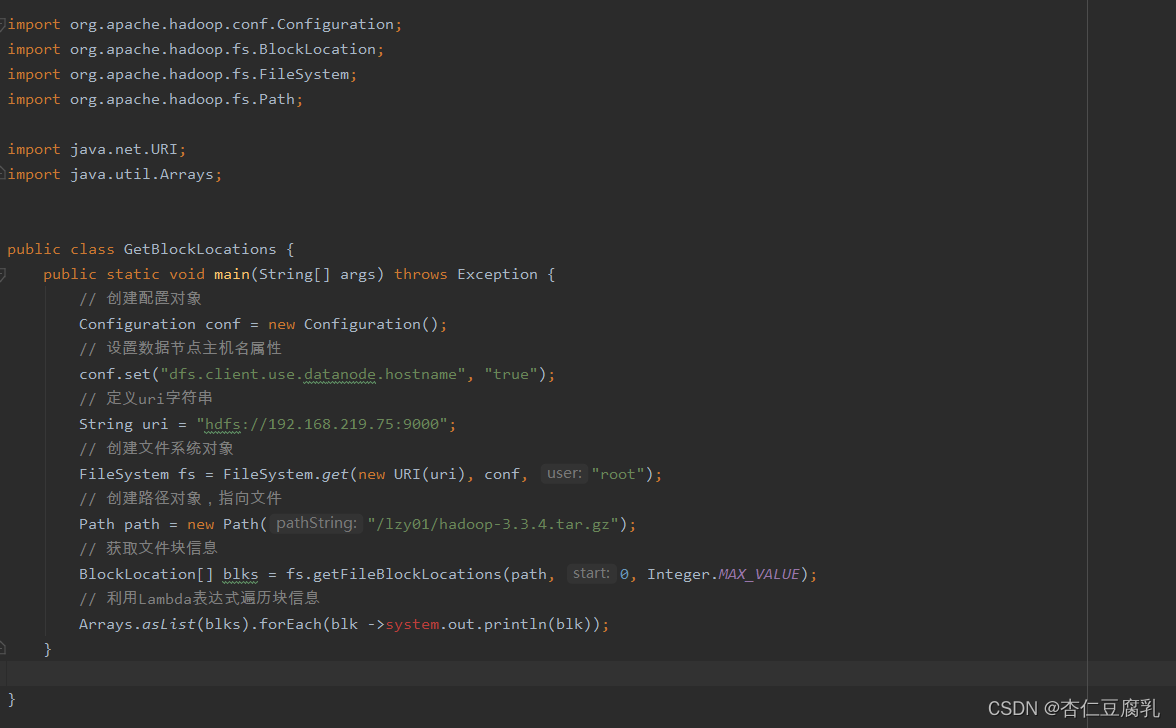

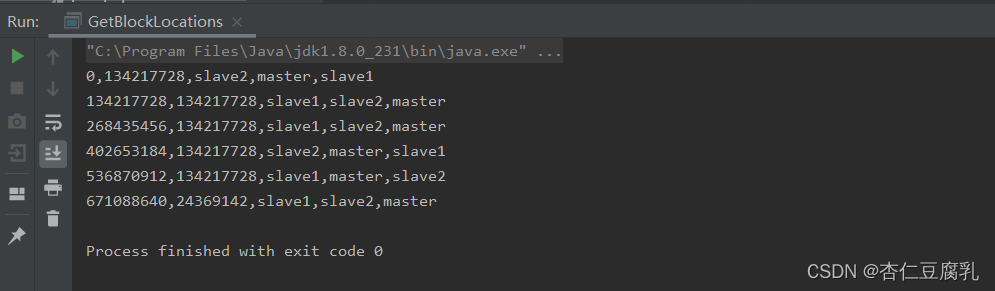

(五)、获取文件块信息

【获取lzy01/hadoop-3.3.4.tar.gz文件块信息】

hadoop压缩包分割成6个文件块

net.hw.hdfs包中创建GetBlockLocations类

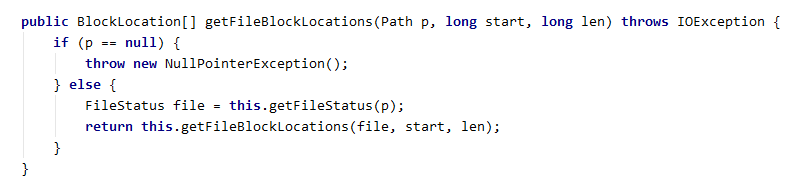

用getFileBlocakLocations方法来获取物理切块信息

获取文件信息:

运行程序,查看结果(切点位置、块大小,块存在位置)

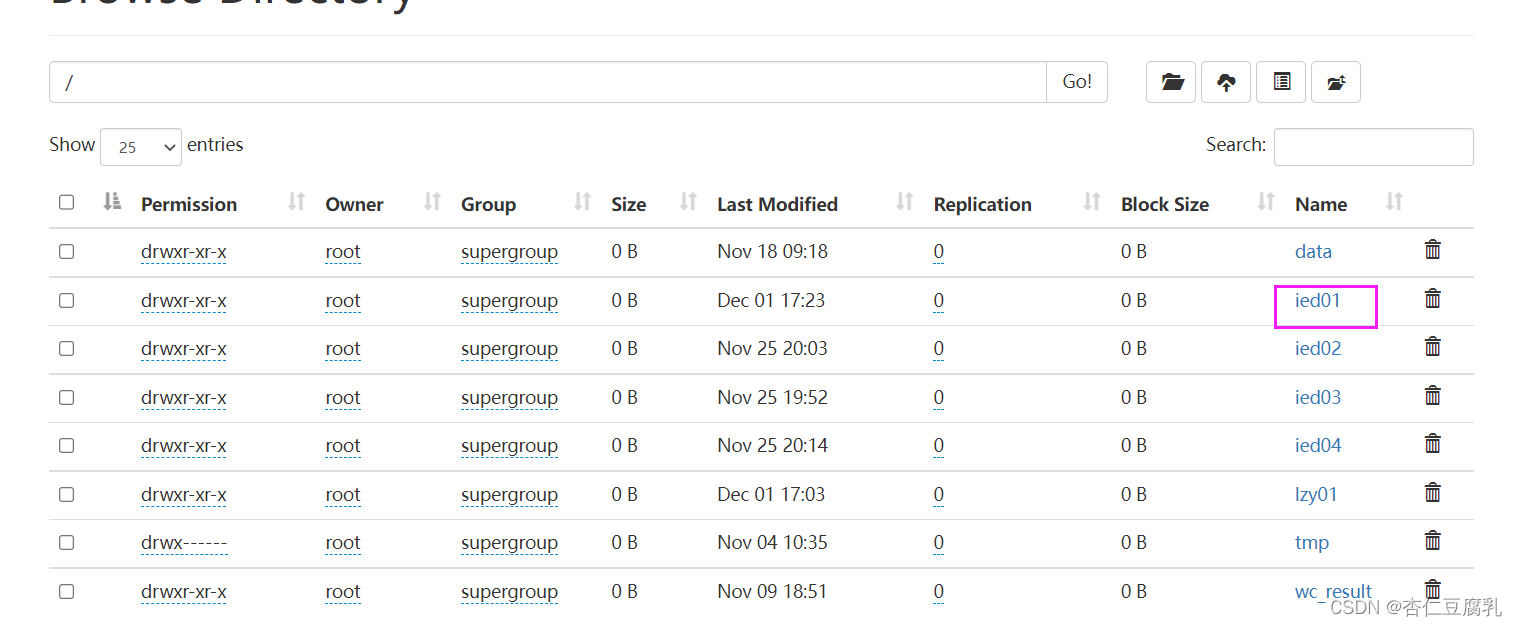

(六):创建目录 【HDFS上创建/ied01目录】

net.hw.hdfs包中创建MakeDirOnHDFS类

运行程序,查看结果

WebUI界面进行查看

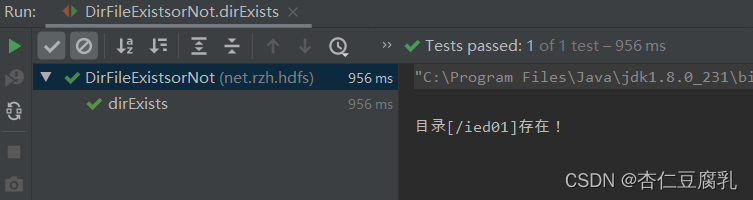

(七)、判断目录或文件是否存在 【判断HDFS上/ied01目录是否存在,判断/ied/hadoop.txt文件是否存在】

net.hw.hdfs包中创建DirFileExistsOrNot类

编写dirExists方法

运行程序,查看结果

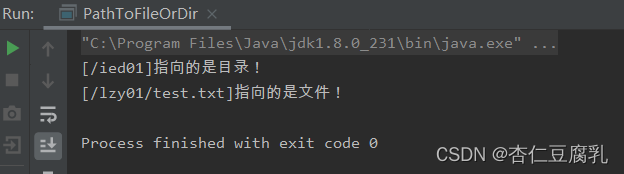

(八)、判断Path指向目录还是文件

在net.hw.hdfs包中创建PathToFileOrDir类

运行程序,查看结果

(九)、删除目录或者文件

在net.hw.hdfs包中创建DeleterFileOrDir类

1、删除文件,删除/lzy01/test2.txt文件

编写deleterFile方法

运行deleterFile测试方法,查看结果

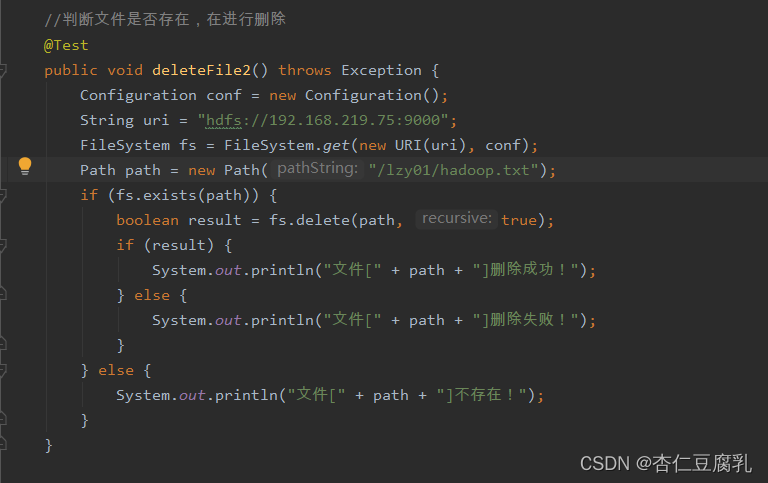

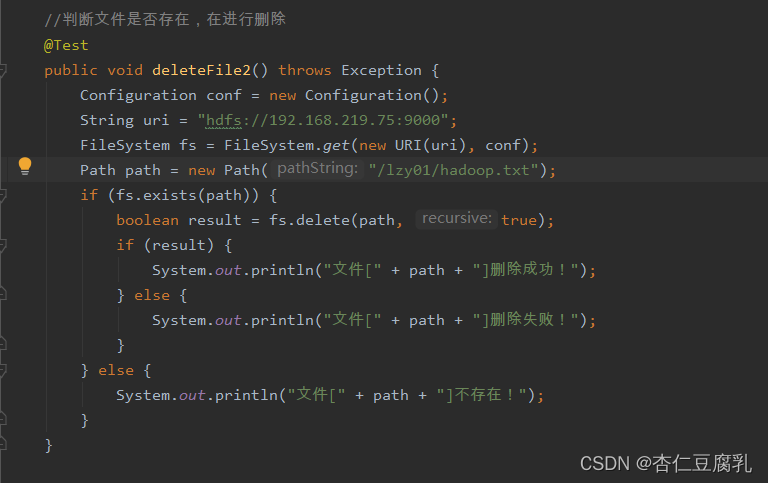

删除文件之前,判断文件是否存在,需要修改代码

注:

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class DeleteFileOrDir {

@Test

public void deleteFile() throws Exception {

Configuration conf = new Configuration();

String uri = "hdfs://master:9000";

FileSystem fs = FileSystem.get(new URI(uri), conf);

Path path = new Path("/lzy01/test2.txt");

boolean result = fs.delete(path, true);

if (result) {

System.out.println("文件[" + path + "]删除成功!");

} else {

System.out.println("文件[" + path + "]删除失败!");

} else {

System.out.println("文件[" + path + "]不存在!");

}

}

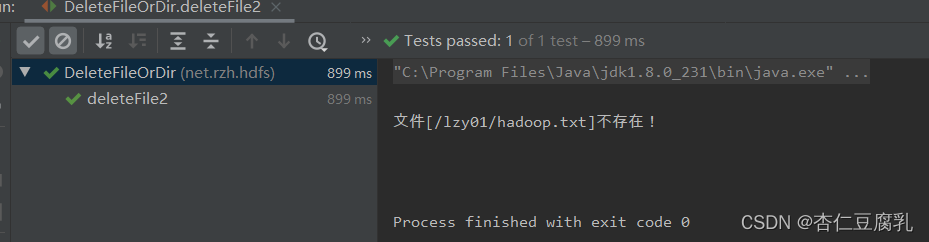

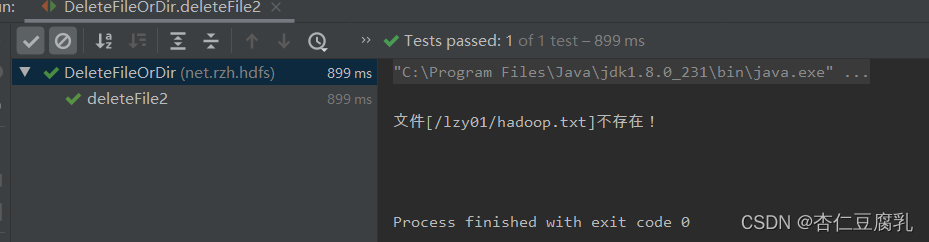

运行deleterFile测试方法,查看结果

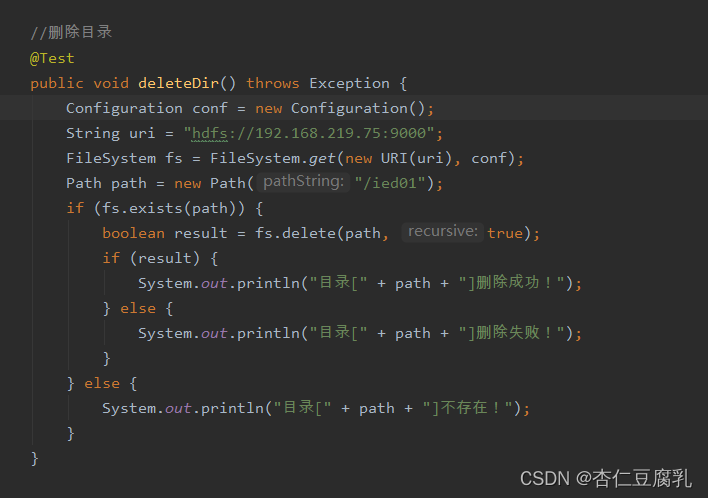

2、删除目录 【删除/ied01目录 编写deleterDir方法】

编写deleDir方法

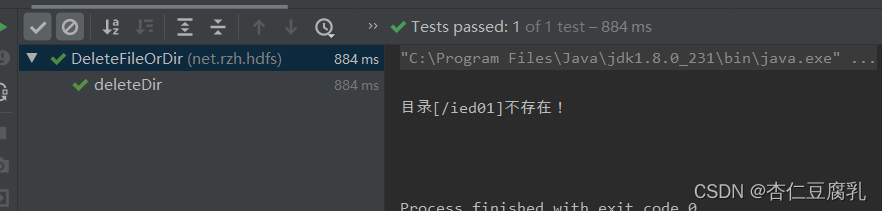

再运行deleterDir方法,查看结果

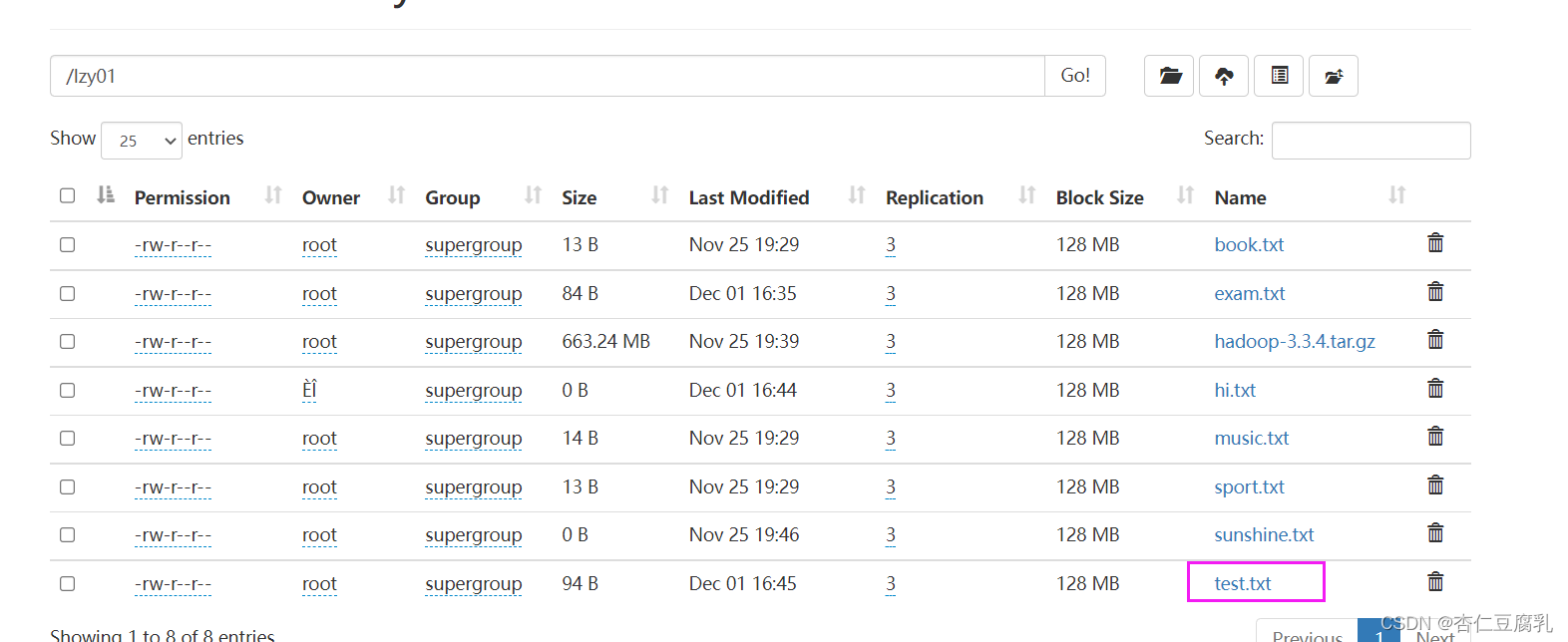

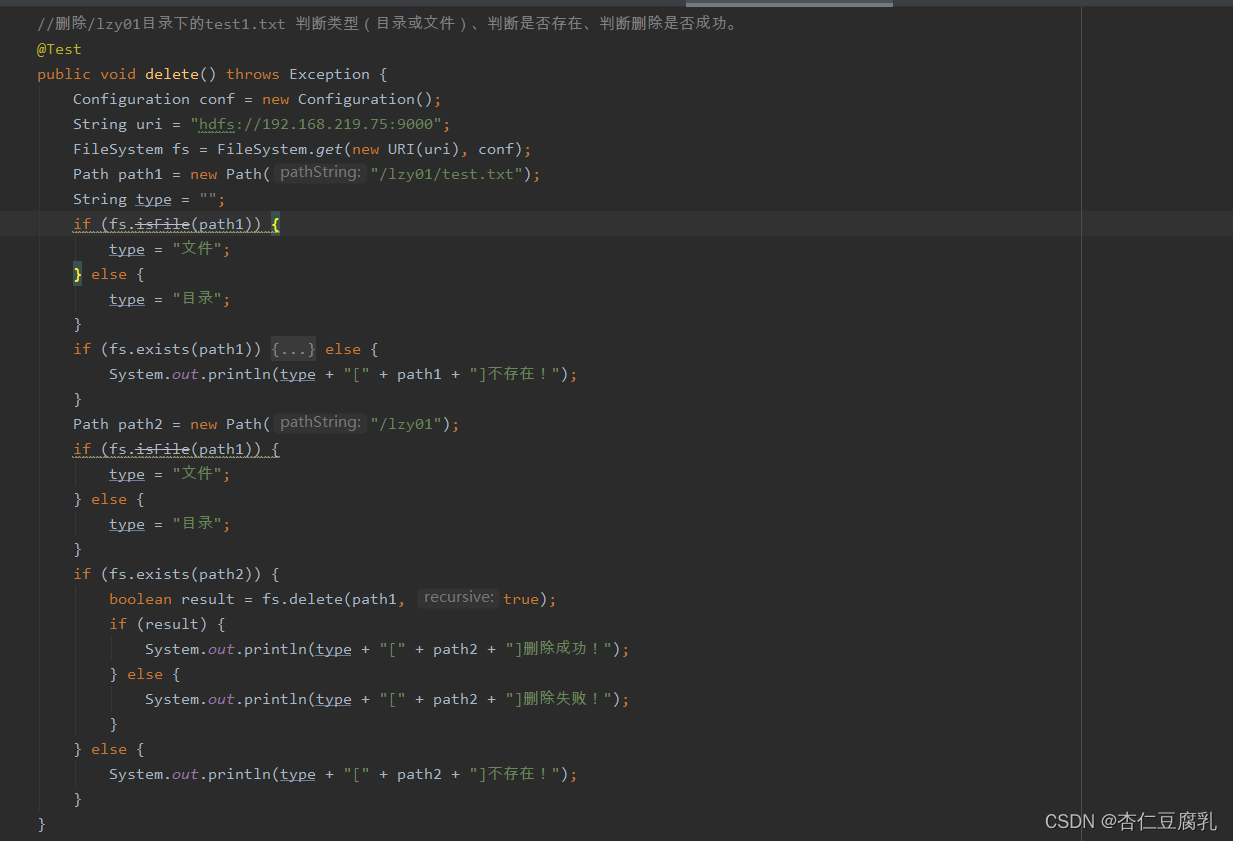

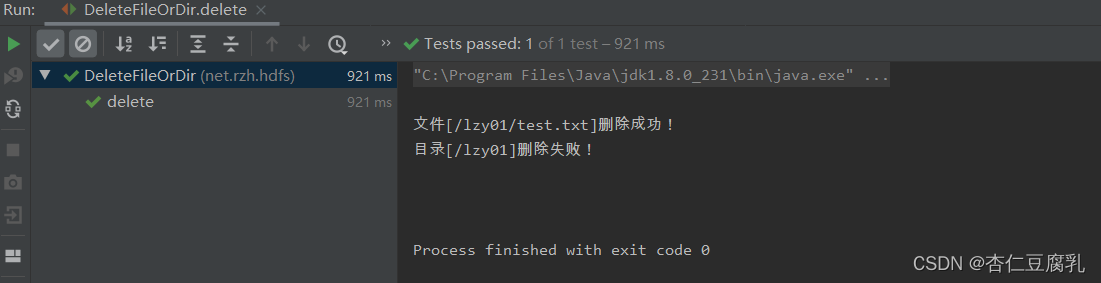

3、删除目录或文件 【进行三个层面的判断:判断类型(目录或者文件)、判度胺是否存在、判断删除是否成功】

删除/lzy01目录下的test1.txt

编写delete方法

运行delete方法,查看结果

版权归原作者 杏仁豆腐乳 所有, 如有侵权,请联系我们删除。